可以搞自己的本地推理模型了家人们,太强了

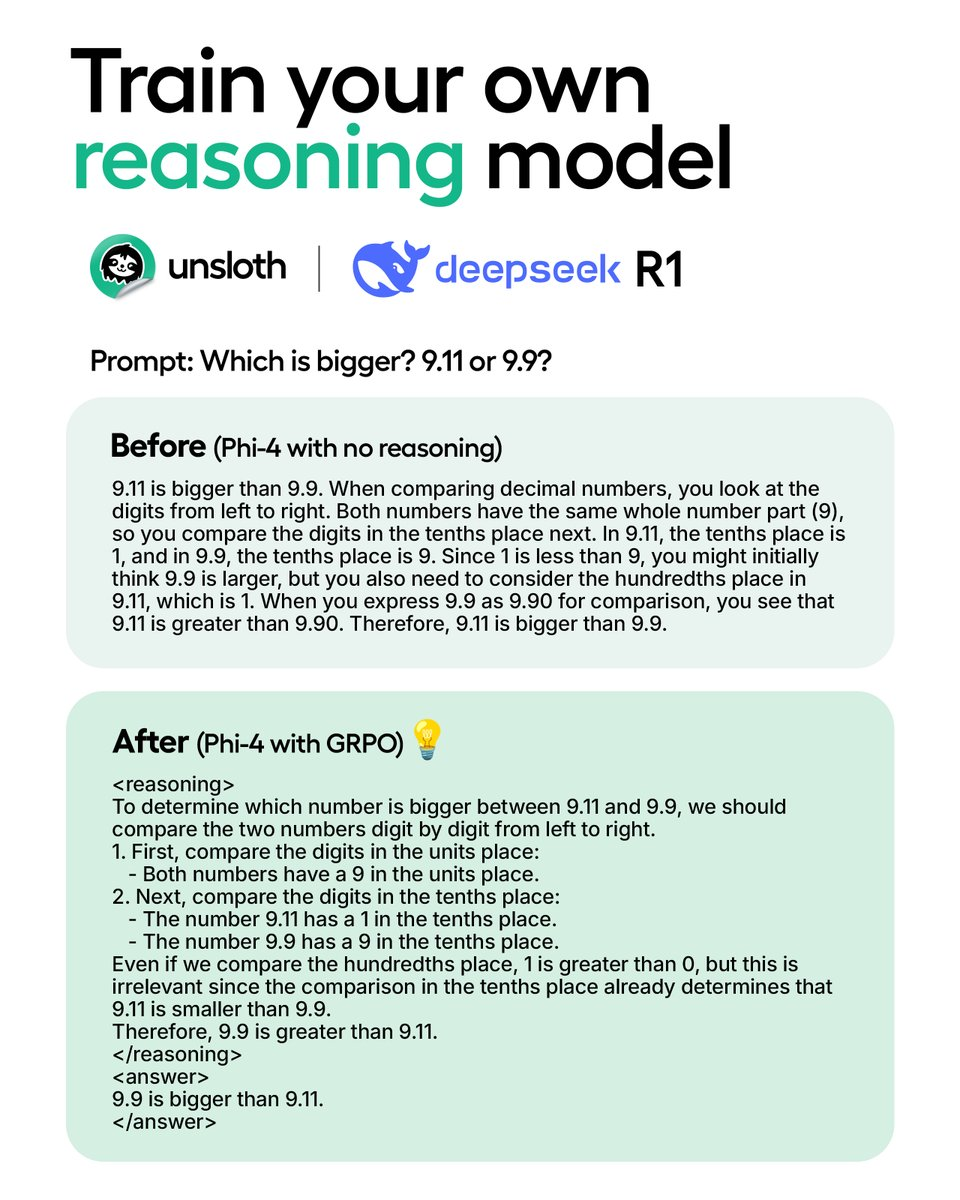

Unsloth AI 优化了 R1 核心算法 GRPO

只需要 15G 显存就能在本地将 15B 的模型训练为推理模型,极限情况下 7G 显卡也可以

前几天即使是为 Qwen2.5(1.5B)实现推理也需要 160G 显存

而且不是对 R1 蒸馏模型微调,而是将标准模型转化为完整的推理模型

核心技术创新:GRPO算法优化1 Unsloth团队通过Group Relative Policy Optimization(GRPO)算法实现了两大突破:

资源效率革命:将训练VRAM需求从160GB(A100x2)降至7GB(T4单卡)

自主推理涌现:模型无需标注思维链数据,通过强化学习自主生成推理过程

技术实现路径

1. 组间竞争机制

模型批量生成多组响应

通过自定义奖励函数评分(如答案正确性、拼写准确性)

组内相对评分取代绝对分值

强化高分响应模式

2. 动态量化支持

4bit/16bit混合量化策略

vLLM引擎深度整合

单卡支持70B参数模型训练

推理速度达4000 tokens/s (A100)

开发者生态转变

训练成本:从$3000+/天的云服务降至本地T4可训

工具链整合:支持QLoRA/LoRA适配,兼容Hugging Face生态

开源协作:集成TRL/vLLM等技术栈,验证周期缩短70%

详细介绍:https://unsloth.ai/blog/r1-reasoning