index_new5.html

../../../zaker_core/zaker_tpl_static/wap/tpl_guoji1.html

![]()

文章围绕LLM推理中的CoT展开,探讨其作用、优势及存在的问题,涉及多个学者的观点和研究成果。

🎯CoT助力LLM实现通用复杂推理能力,在数学、符号推理及类人情感方面表现出色,如OpenAI的o1模型。

💡LLM推理中加入中间步骤很重要,如DeepMind用自然语言原理解决数学问题,OpenAI利用数据集微调GPT - 3等。

⚠️CoT并非万能,存在易受无关上下文干扰、自我纠正能力不健全等问题,LLM推理与人类存在本质差异。

🔍定义问题是解决LLM推理缺陷的关键,如Denny Zhou指出应从第一性原理出发解决问题。

随着OpenAI o1的爆火,最近CoT也成了圈内热议的高频词。靠着CoT的强力加持,o1直接在LLM领域首次实现了通用复杂推理能力,俨然是AI发展新范式的开端。而且,o1这种慢思考模式不仅帮助LLM做数学和符号推理,甚至,还让LLM发展出了类人情感!最近,斯坦福等机构学者发文证实:LLM在情感方面表现出的认知和推理比人类还像人类,背后最大贡献者竟然就是CoT。就在这几天,风口浪尖上的CoT,又让AI社区掀起了一场风波。谷歌DeepMind首席科学家称LLM推理无极限,LeCun田渊栋回怼

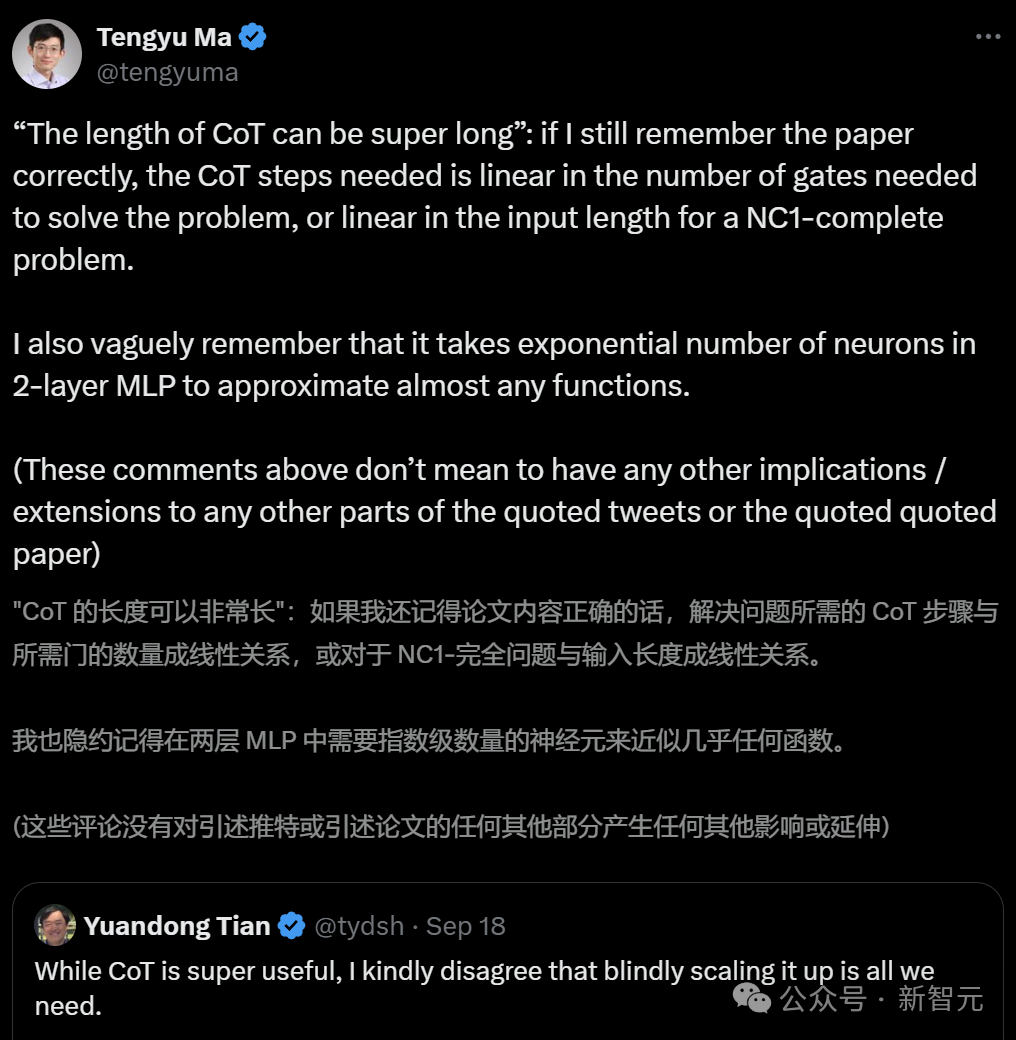

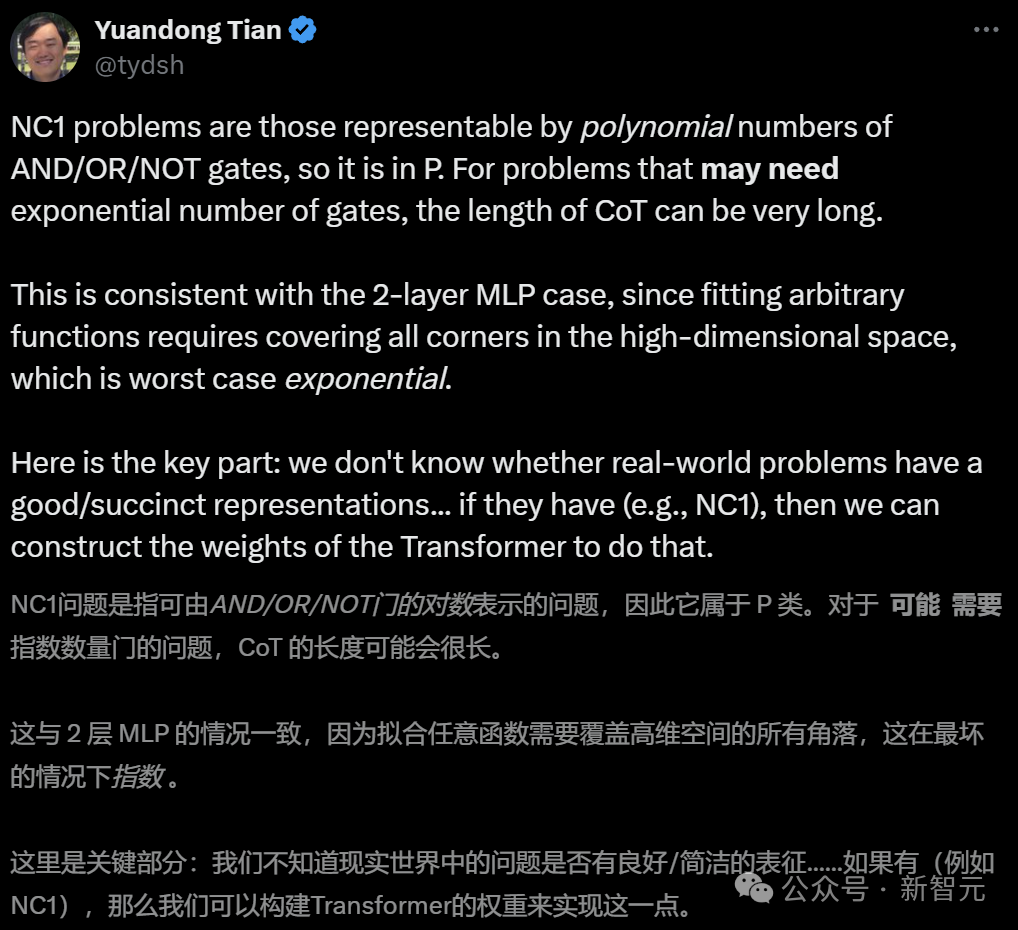

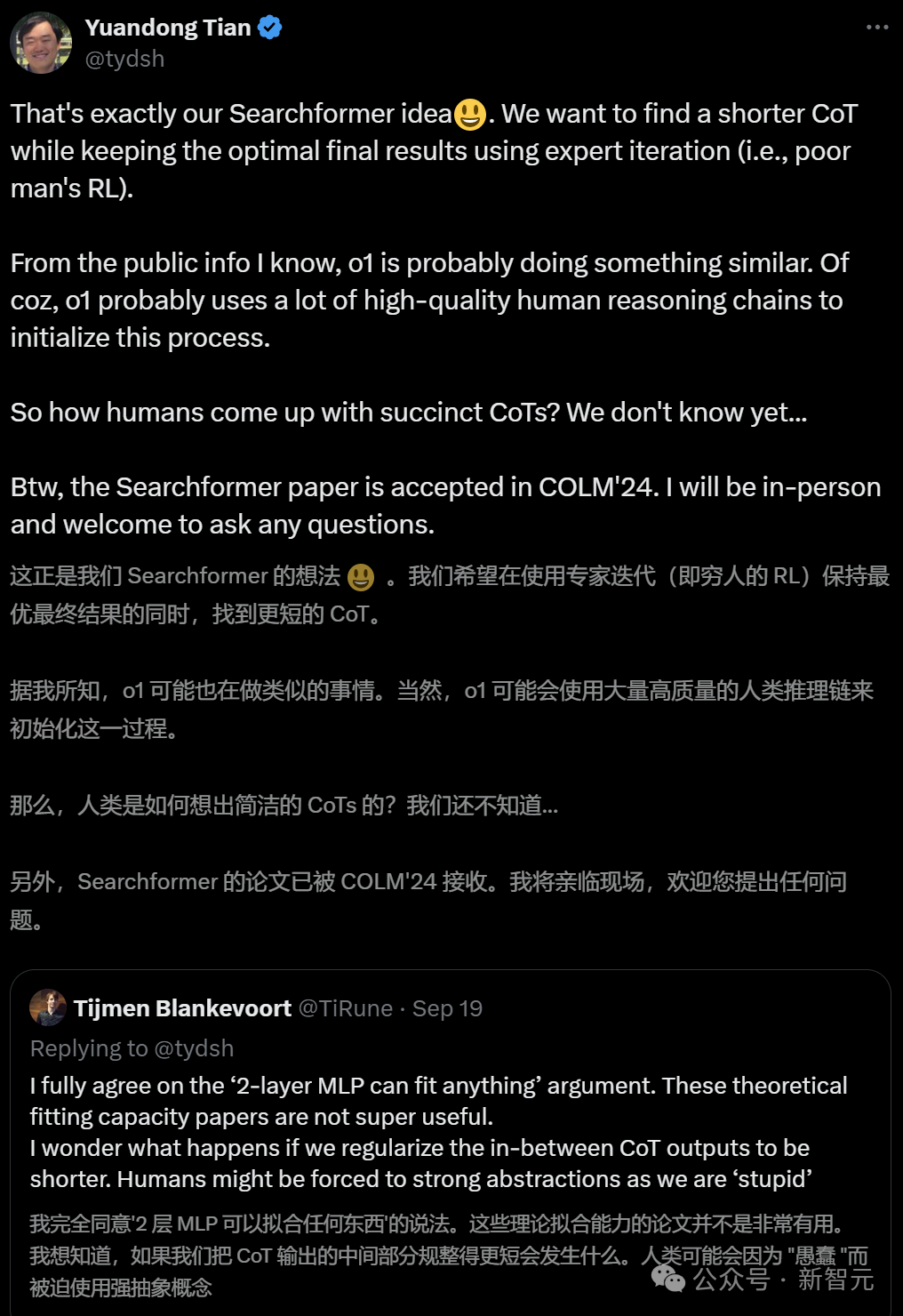

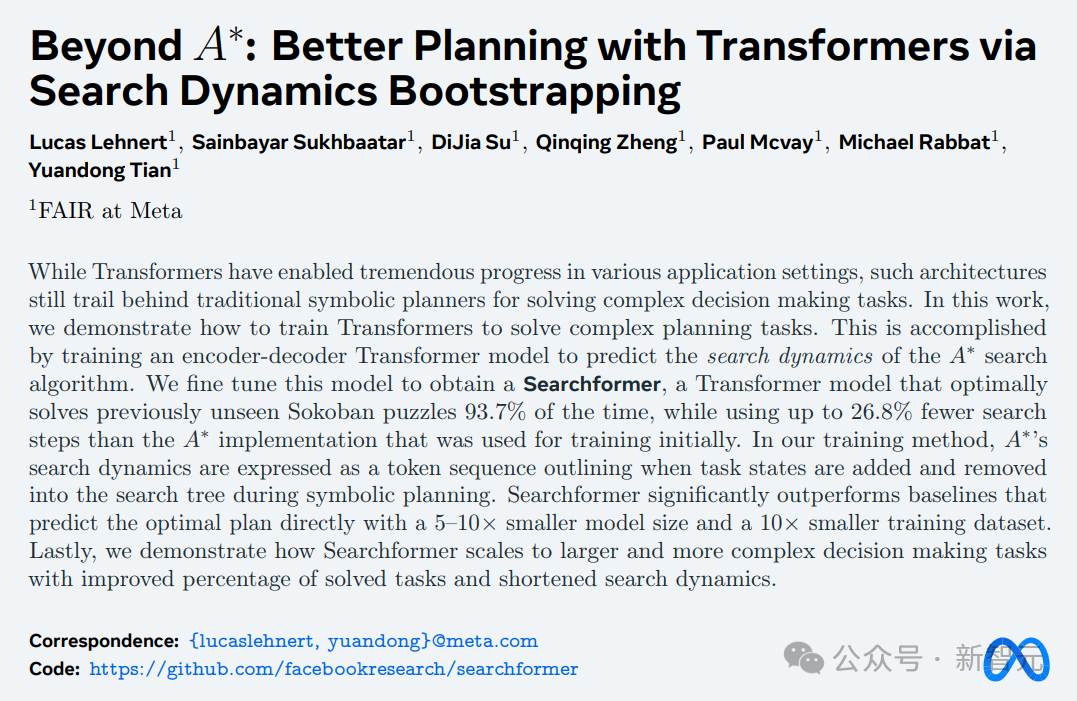

最终,田渊栋也承认,谷歌这篇论文的思路的确有可取之处。然而由于涉及到不同的数据分布、模型架构、学习算法、后处理等等,问题还要更复杂。正如Evolutionary Scale联创Zeming Lin所言:我们需要像乔姆斯基层次结构这样的机器学习模型。就像ML模型有NP、P、O(n^2) 等概念一样,Transformer或Mamba属于哪里呢?而在田渊栋发帖的第二天,谷歌论文主要作者马腾宇也上线评论说:CoT的长度是可以超长的。2层MLP中的神经元数量呈指数级,才能逼近几乎任何函数。田渊栋回复他说:对那些可能需要指数数量的门的问题,CoT的长度可以很长。这和2层MLP情况是一致的,因为无论拟合任意函数,都需要覆盖高维空间中的所有角,这是最坏的情况。然而,现实世界的问题,是否有如此良好/简洁的表征呢?如果它们都像NC1一样,属于P问题,那么当然可以通过构建Transformer的权重来做到。在最近一条X帖子中,田渊栋表示,自己的想法是,能够找到更短的CoT,同时使用专家迭代(穷人的RL)来保持最佳结果。从公开信息来看,他推断o1也是在做类似的事情。至于初始化过程,可能是使用了大量高质量的人类推理链。趁此机会,他还宣传了一下自己团队Searchformer的论文。

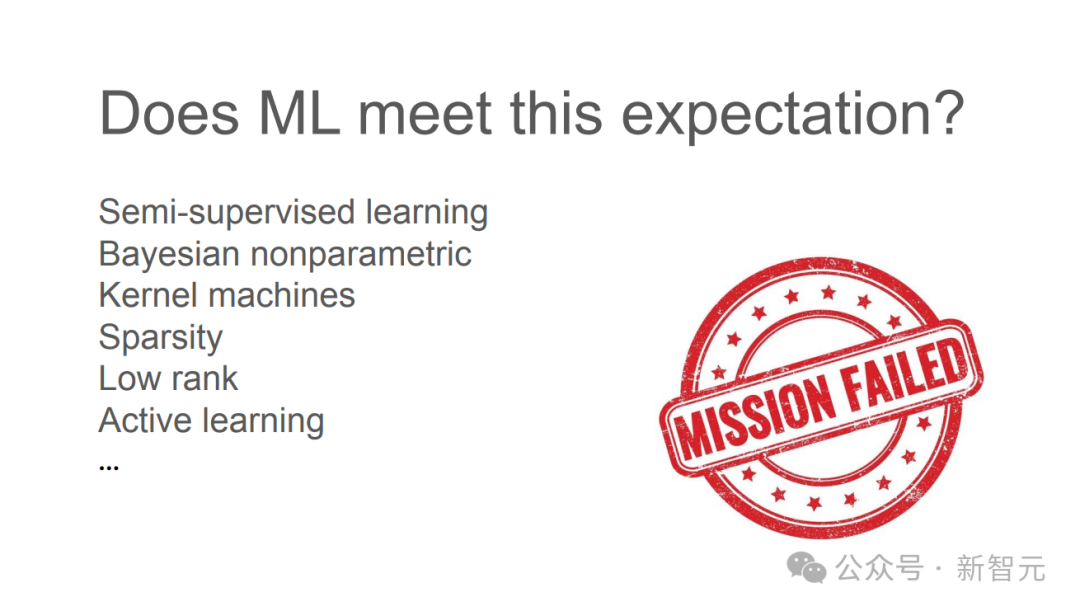

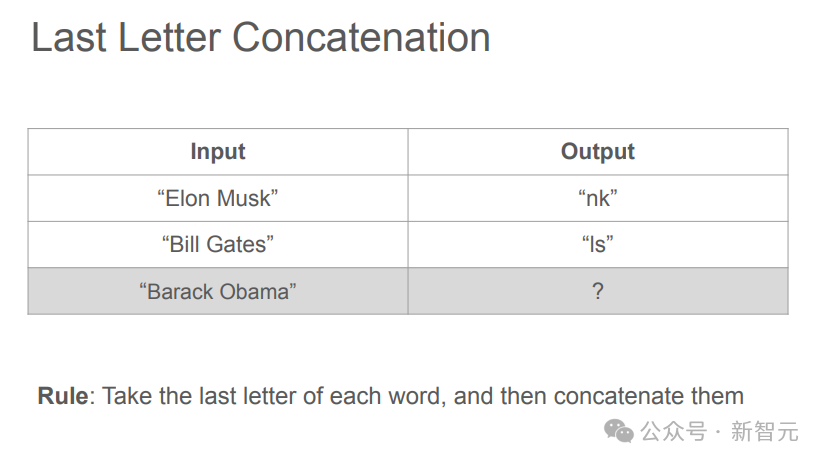

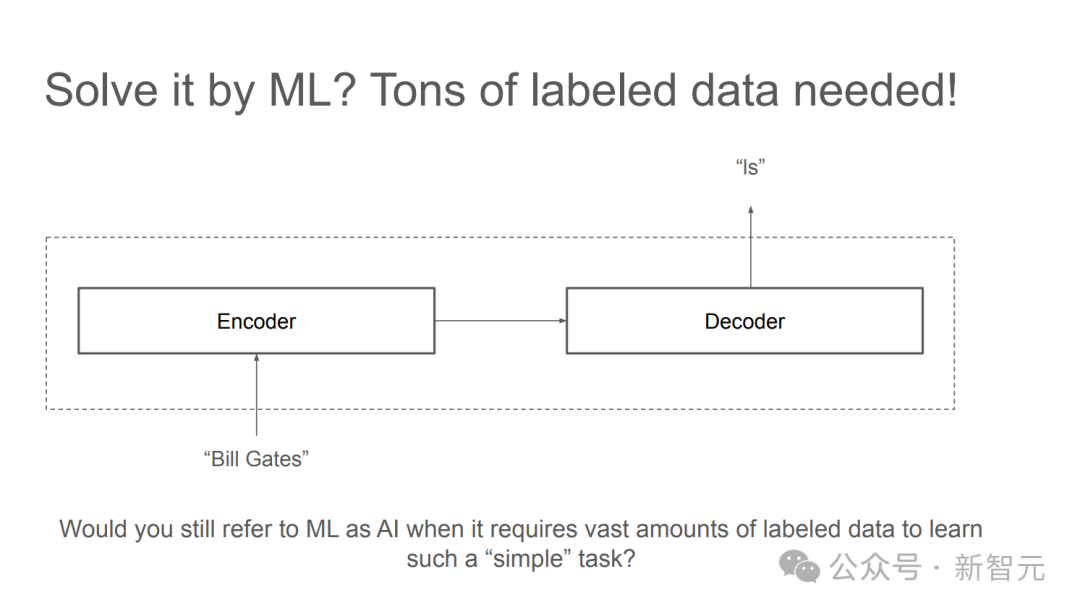

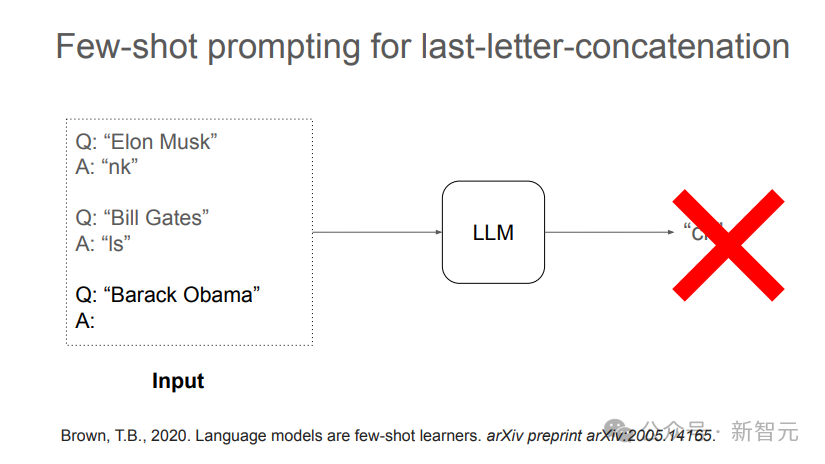

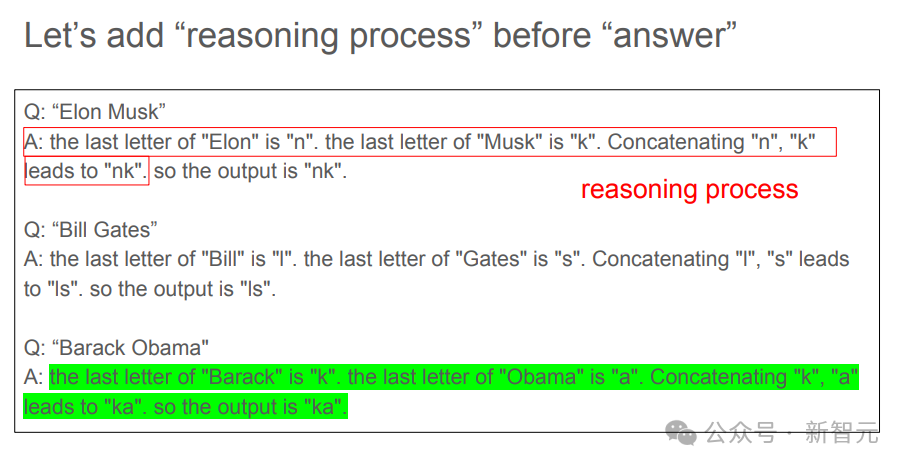

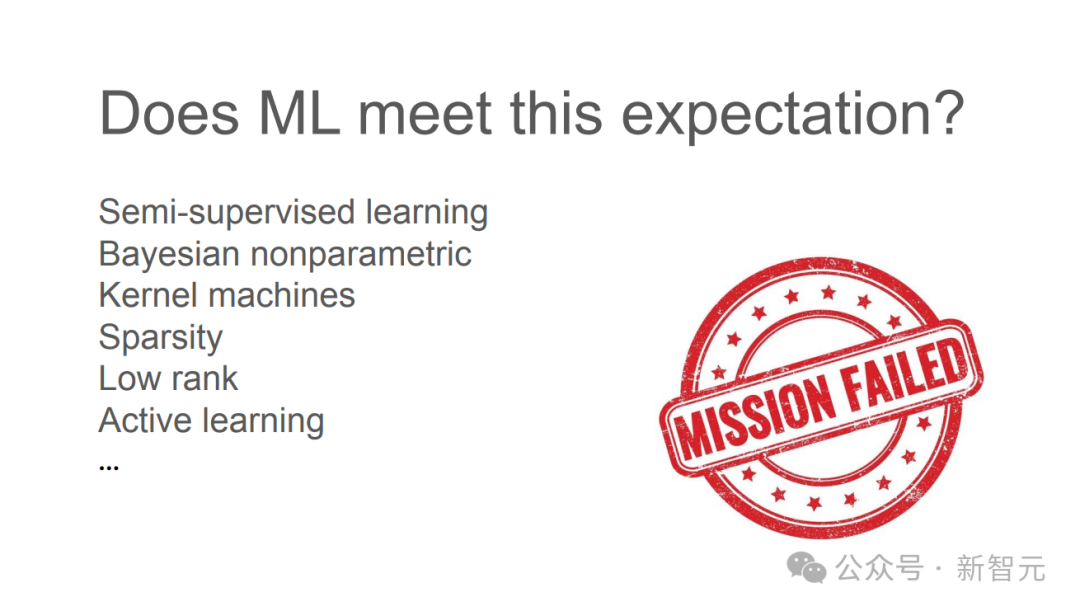

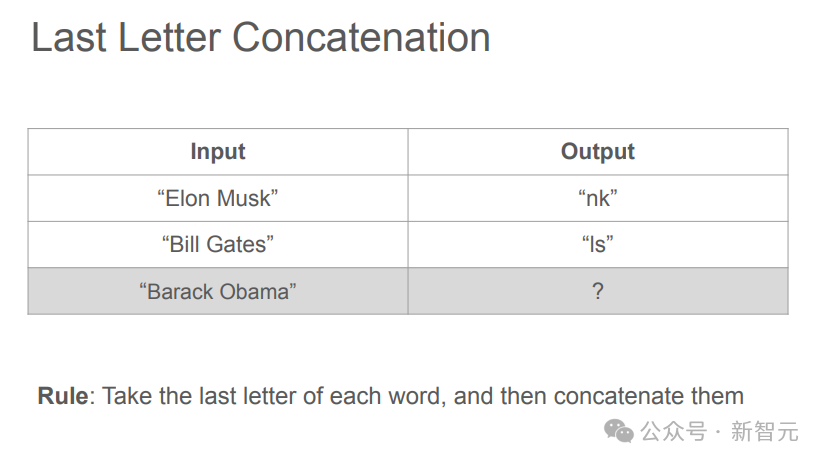

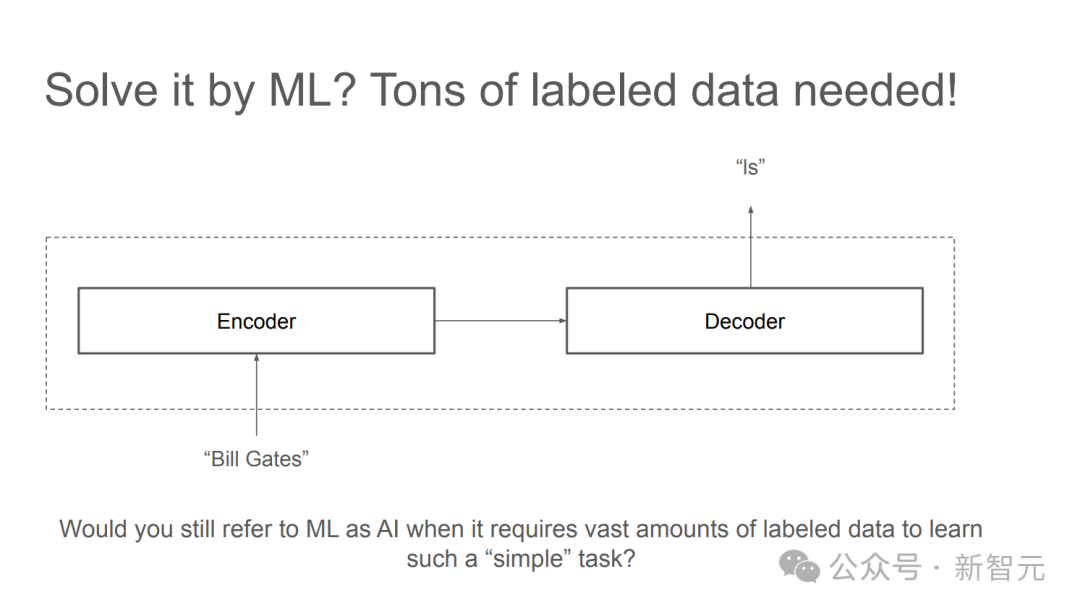

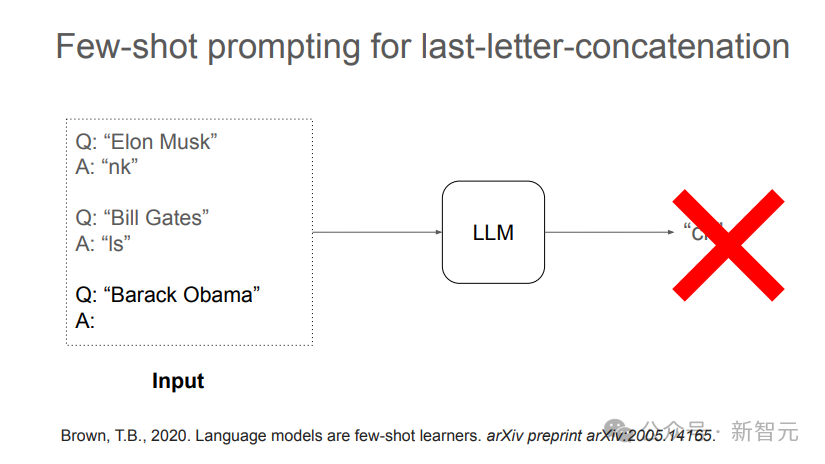

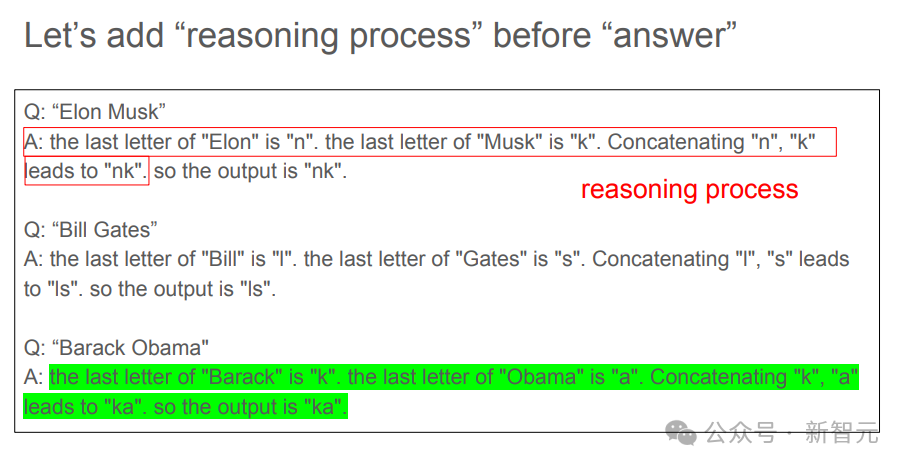

论文地址:https://arxiv.org/abs/2402.14083总之,虽然我们还不知道如何拓展2层神经网络,但OpenAI似乎确信自己已经掌握了拓展CoT的秘诀。而关于LLM推理,Denny Zhou最近在UC伯克利也进行了一场类似主题的讲座。他表示,自己对AI的期待是可以像人类一样从较少的示例中进行学习。但曾经尝试的种种机器学习方法之所以都不成功,是因为模型缺失了一种重要能力——推理。人类之所以能从较少的示例中学习到抽象的规律和原理,就是因为推理能力。正如爱因斯坦所说的,「Make things as simple as possible but not simpler」。(一切都应该尽可能简单,但不能过于简单)但如果在数据中加入「推理过程」,LLM就很容易有样学样,学习到少量样本示例中展现出的规律,并给出正确答案。通过这个简单的例子,Denny Zhou指出,关键想法是在数据中包含中间步骤,或者是解释原理(rationale),同时让模型写出推导过程。

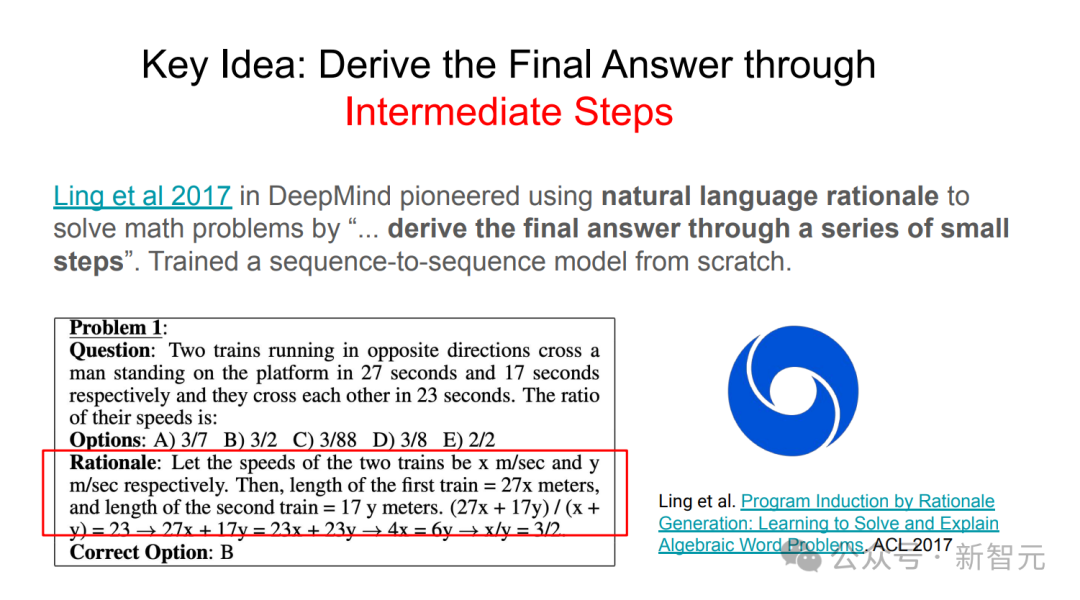

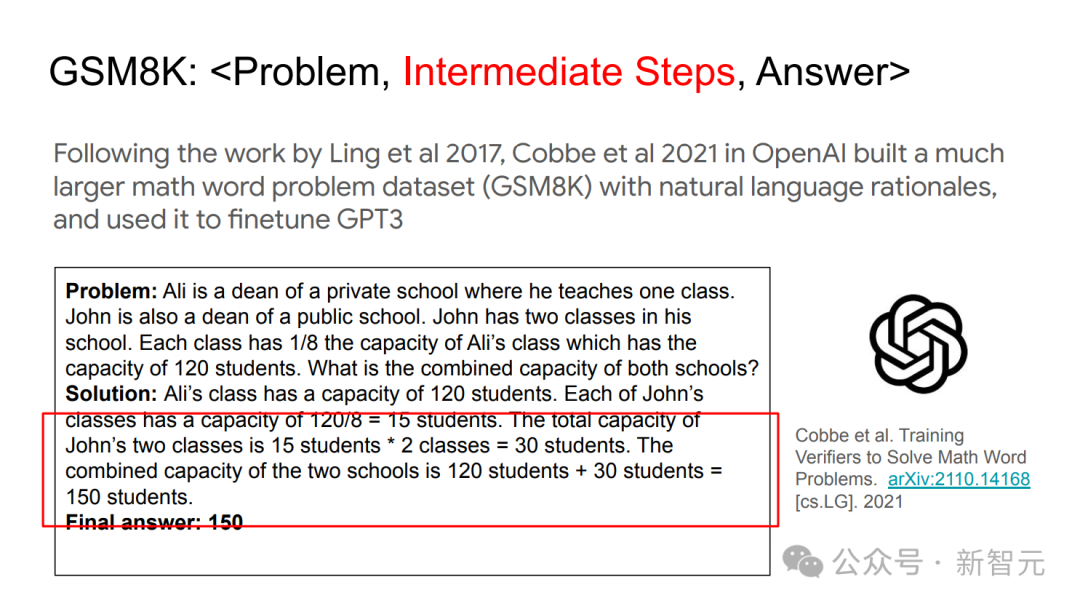

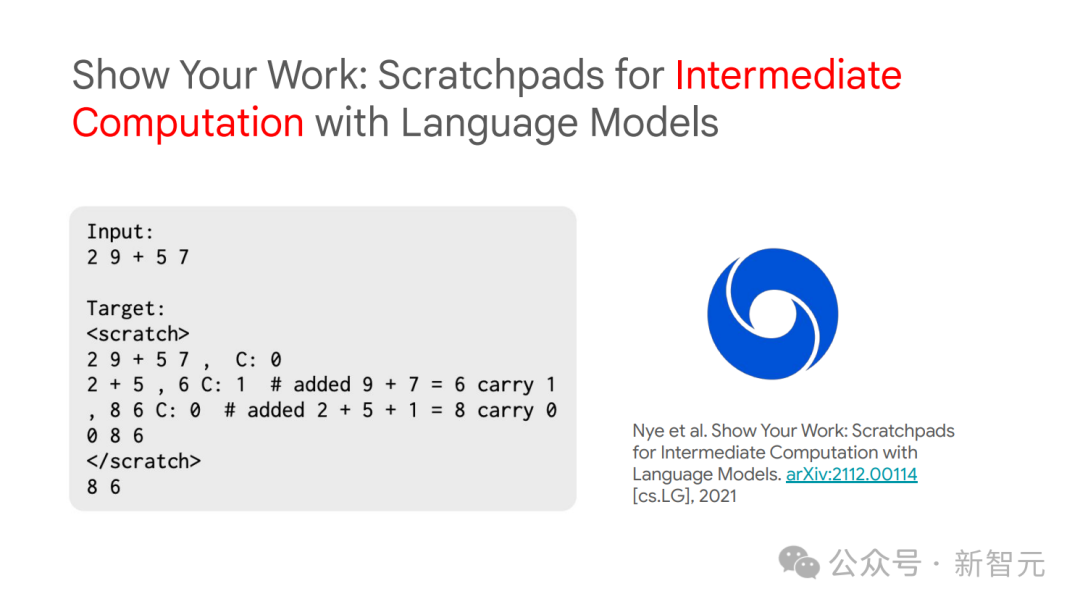

「中间步骤」,为何如此重要

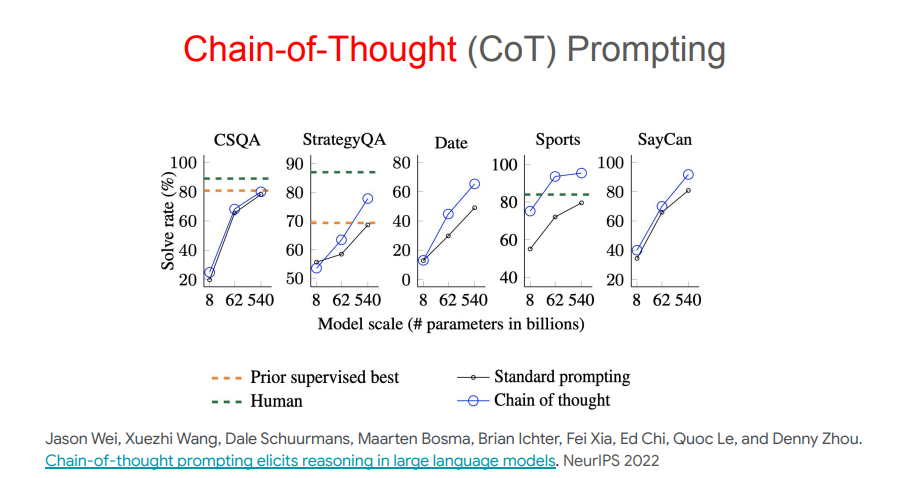

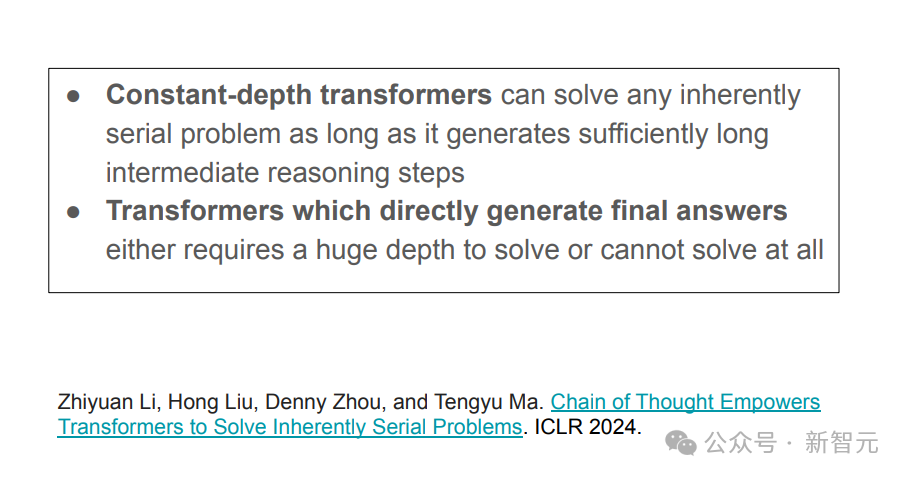

DeepMind的研究者们,率先使用自然语言原理去解决数学问题。关键就在于从头开始训练了一个序列到序列模型,从而通过一系列小步骤得出最终答案。继这项工作后,OpenAI的研究者们建立了一个更大的数学单词问题数据集(GSM8K),其中包含自然语言基本原理,并利用它对GPT-3进行了微调。o1模型的奠基性贡献者之一Jason Wei在谷歌大脑工作时曾和Denny Zhou发表了一篇论文,指出CoT提示可以引导出LLM的推理能力。Denny Zhou甚至更直白地指出样本「中间步骤」的重要性:无论是训练、微调还是提示,都需要给出中间步骤,才能让LLM在响应中也包含中间步骤。实际上,这也是Denny Zhou、马腾宇最近论文的核心观点。如果能生成足够长的中间推理步骤,常数深度的Transformer模型也能解决任何串行问题。CoT并不是一切

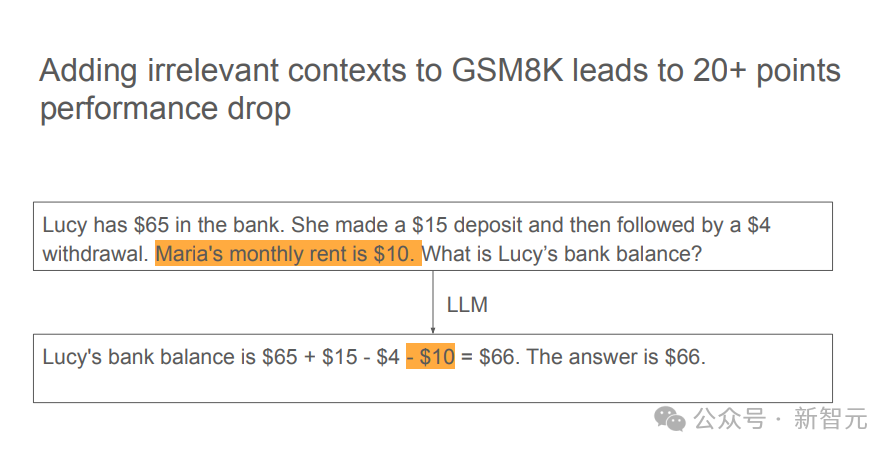

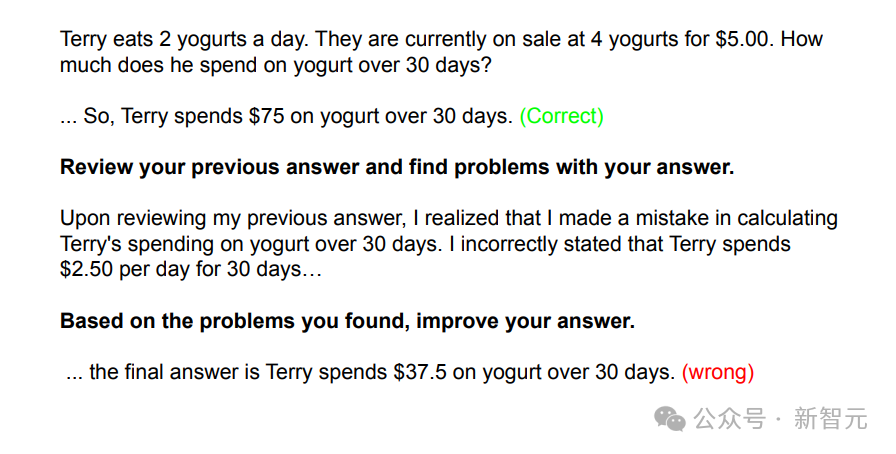

但是,这也并不意味着CoT可以包打一切,解决LLM推理的所有缺陷。比如,模型很容易被无关的上下文干扰,这一点和人类思维也很类似。实验中发现,在GSM8K数据集中添加无关上下文,可以导致模型性能出现高达20+百分点的损失。虽然有些模型在反思后可以成功修改错误答案,但也存在另一种风险——可能反而把正确答案改错。Denny Zhou指出,虽然我们已经知道了模型推理有哪些缺陷和不足,但最重要的还是定义好问题,再从第一性原理出发去解决。此处,再引用一句爱因斯坦的话:「如果有1小时用来拯救星球,我会花59分钟来定义问题,然后用1分钟解决它。」一些质疑

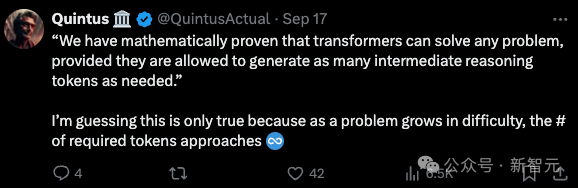

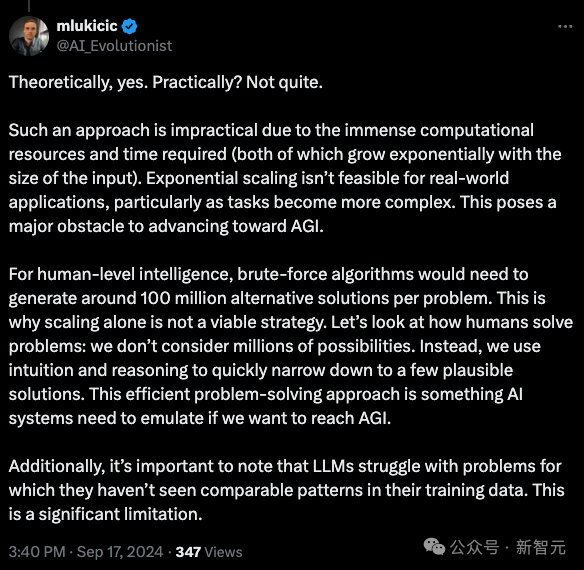

虽然Denny Zhou的演讲内容相当详实,但「CoT实现推理无极限」的论断确实相当大胆,因此也引起了网友的反驳。比如有人指出,前提中所谓的「无限多token」只是在理论上可行,在实践中未必如此。token数量很有可能随输入增加呈现指数增长,问题变得越来越复杂时,token数量逼近无限,你要怎么处理?而且,LLM推理和人类还存在本质差异。AI目前只能进行暴力搜索(brute-force),但人类有所谓的「启发式」思考,「直觉」让我们能将数百万种可能性快速缩减至几种可行的解决方案。如果想达到AGI,AI系统就需要模拟出这种高效的问题解决路径。https://x.com/ylecun/status/1836308172123807986https://x.com/denny_zhou/status/1836482177959399714https://x.com/tydsh/status/1836103159162495361