index_new5.html

../../../zaker_core/zaker_tpl_static/wap/tpl_guoji1.html

![]()

NeurIPS 2024论文评审结果出炉后引发诸多争议,包括评审人贬低论文贡献、评审标准不合理、存在不诚实评审、论文质量被质疑、大模型参与评审出现问题等。

🎯评审人被指严重贬低论文贡献,用不合理标准评判,甚至忽视论文实际改进,可能存在不诚实评审,如竞品作者所为。

📄论文质量受到质疑,有人认为评审员变得严格,也有人认为论文质量下降,还出现了‘回收利用’的论文。

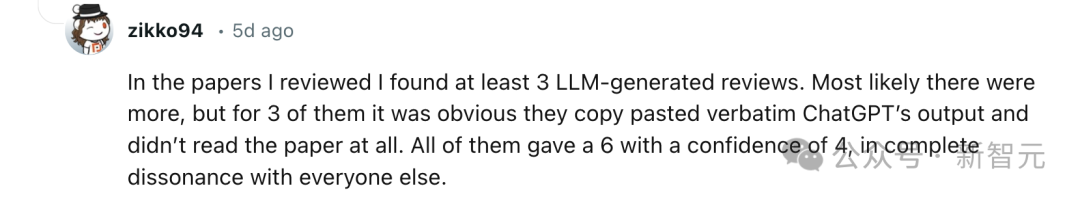

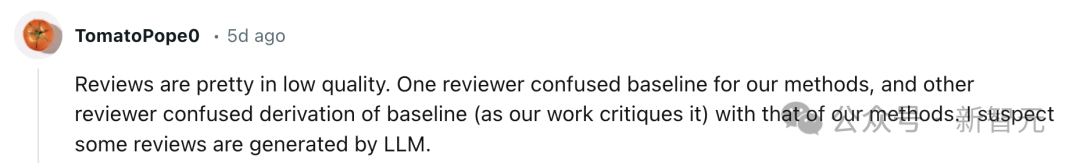

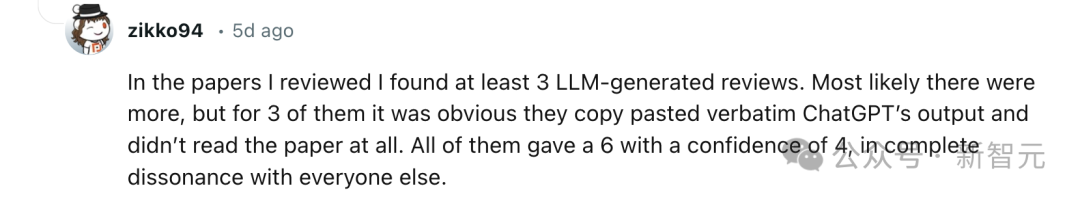

🤖大模型被用于论文评审,出现评审意见质量低、复制粘贴等问题,如至少有3篇明显是直接复制ChatGPT输出。

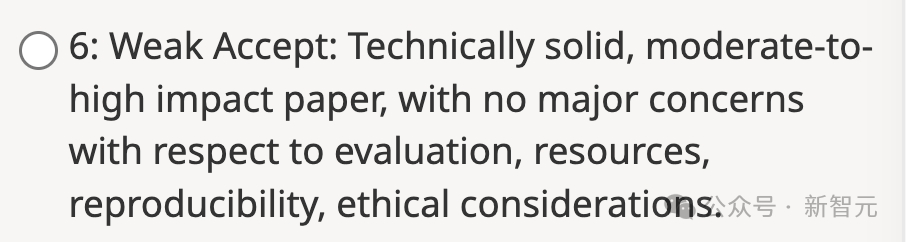

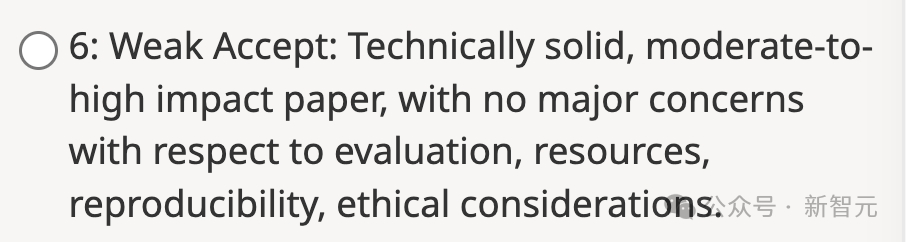

📊NeurIPS评分规则中,6分的描述存在问题,导致新评审员给出低分,且评审员构成多样,包括博士生、硕士生、本科生等。

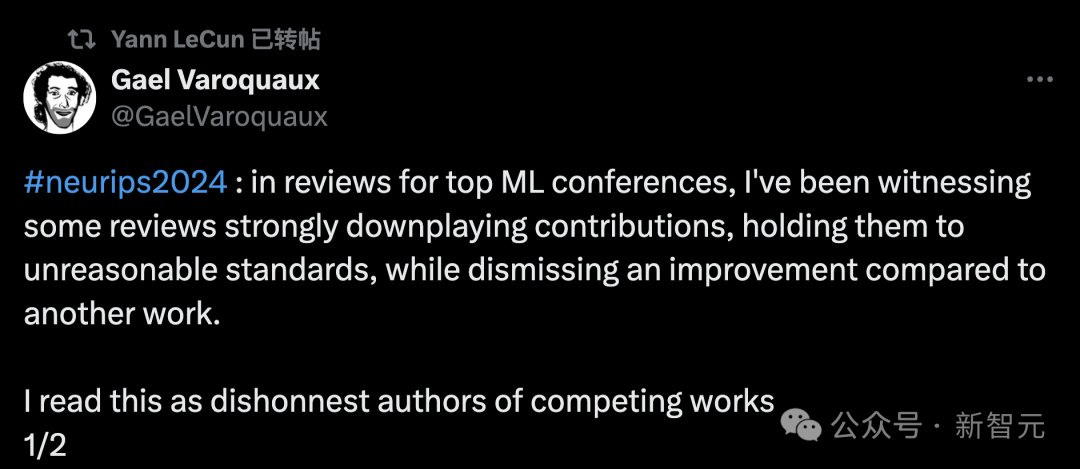

前段时间,NeurIPS 2024论文评审结果终于出炉了,网友们开始「拉群」吵成了一片。「一些评审人严重贬低论文贡献,用不合理的标准评判,甚至忽视论文相对于其他工作的实际改进」。

他认为,这可能是竞品的作者,发现后做出不诚实的评审。作为领域主席,我告诉作者:如果你遇到了这种情况,请联系领域主席(AC)。作为一个作者,我想问:如何恰当地指出这种行为,并在合法批评和过度把关之间找到平衡点?

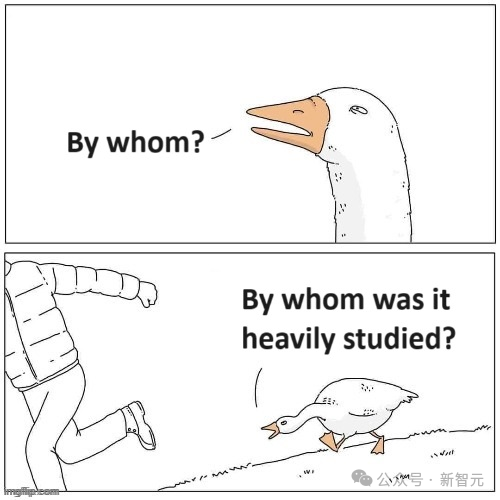

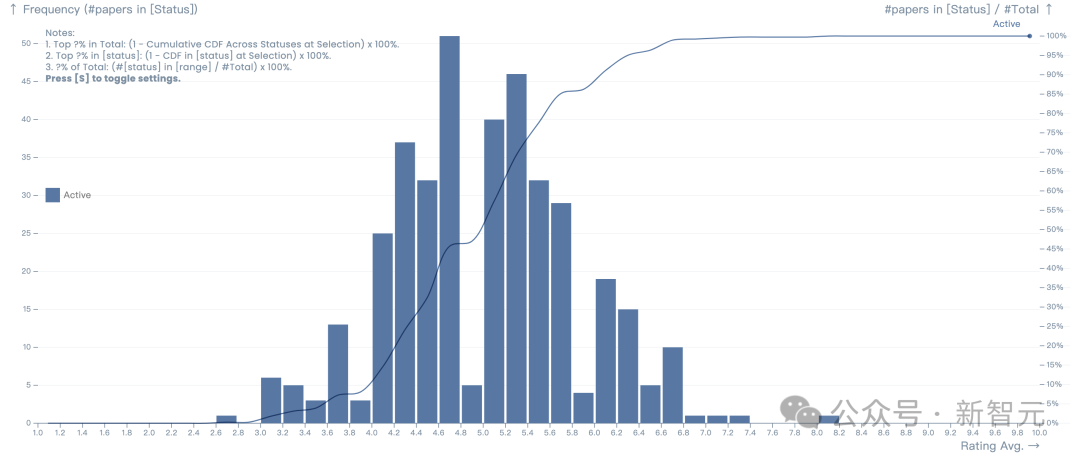

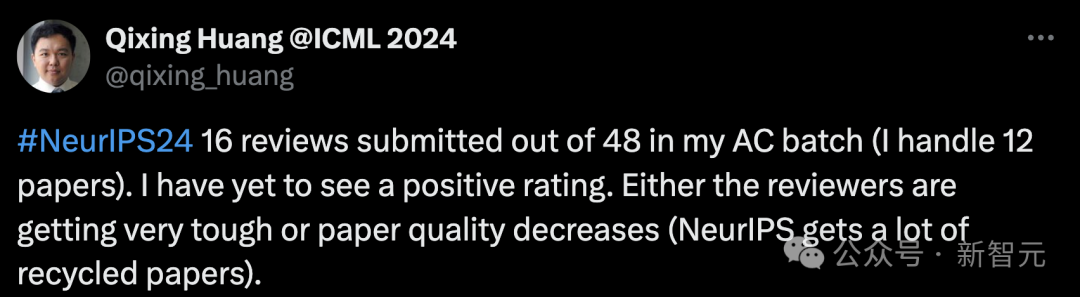

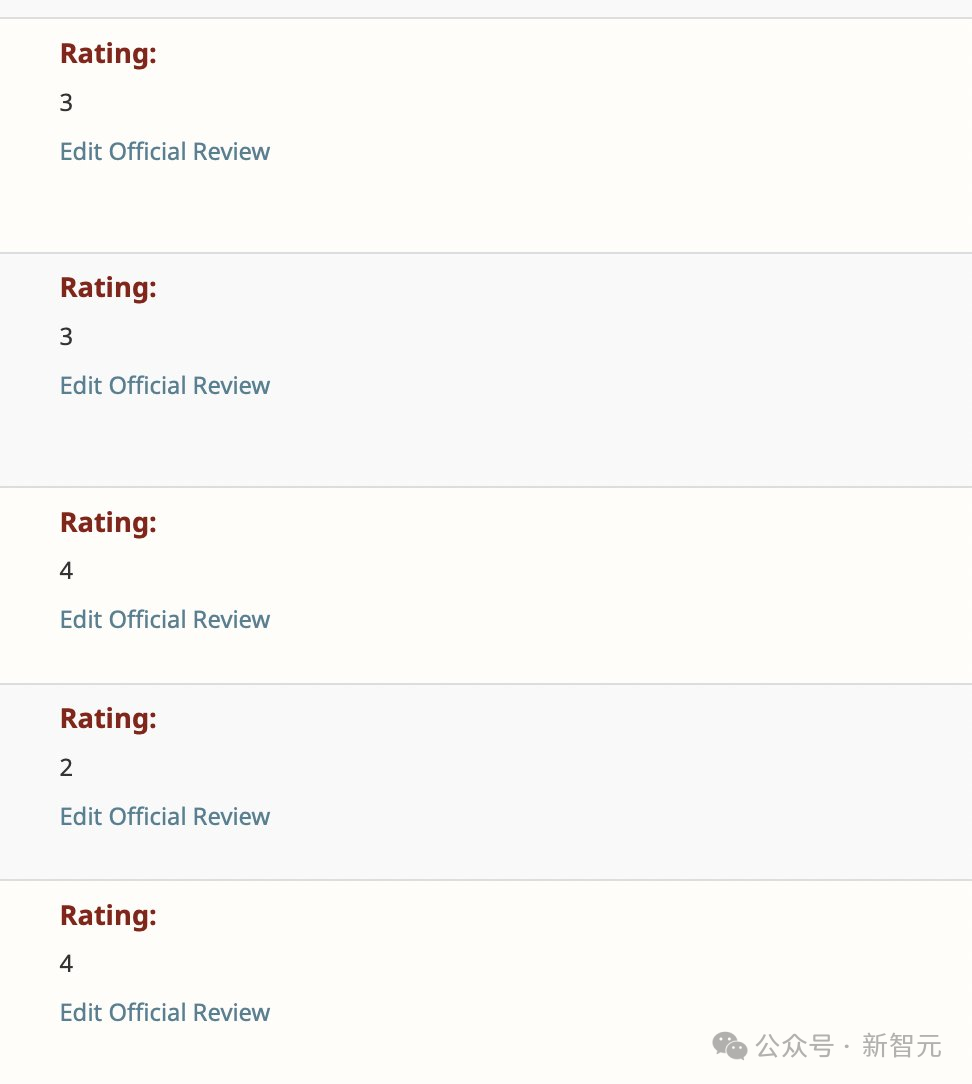

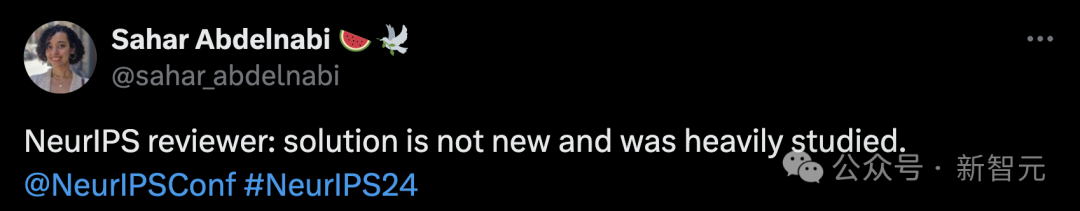

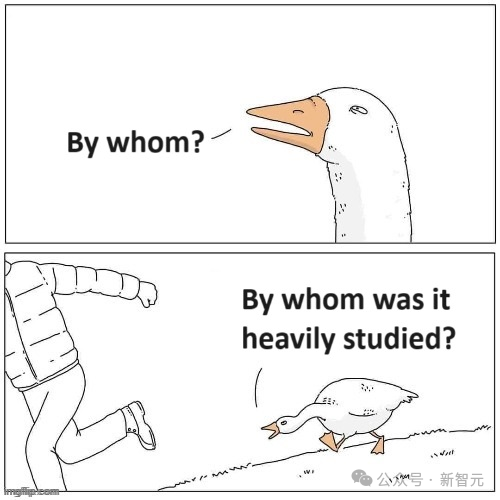

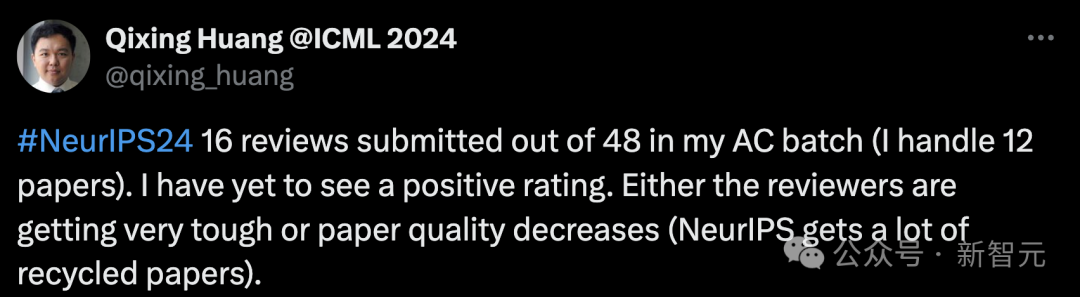

另有网友放出NeurIPS评审员经典评论:这个解决方案不是新的,并且已经被大量研究过了。今年,是NeurIPS第38届年会,将于12月9日-15日在温哥华召开。根据Paper Copilot收集的数据统计,截至目前,得分平均分布均在3-6分之间居多。一位来自UT Austin的副教授,也是NeurIPS这届顶会的领域主席(AC)之一,阐述了自己所看到的现象。他表示,在自己负责的一批论文中,已提交了48篇中的16篇评审。到目前为止,我还没有看到一个正面评价,要么是评审员变得非常严格,要么是论文质量下降了?

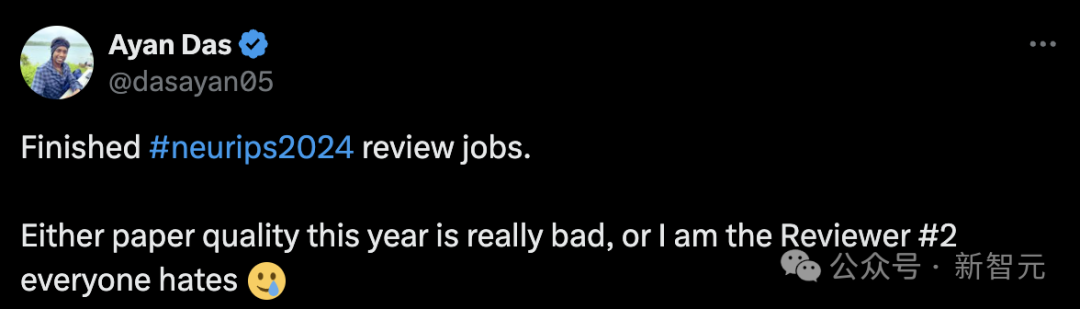

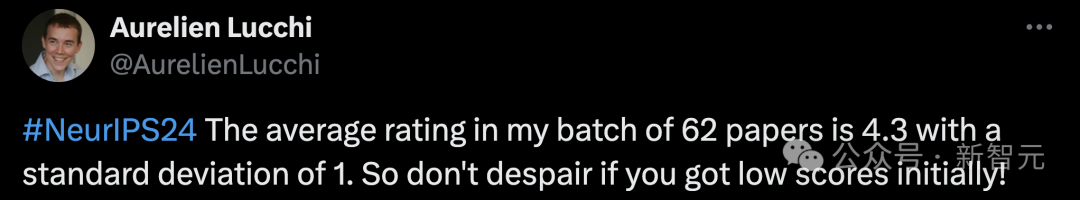

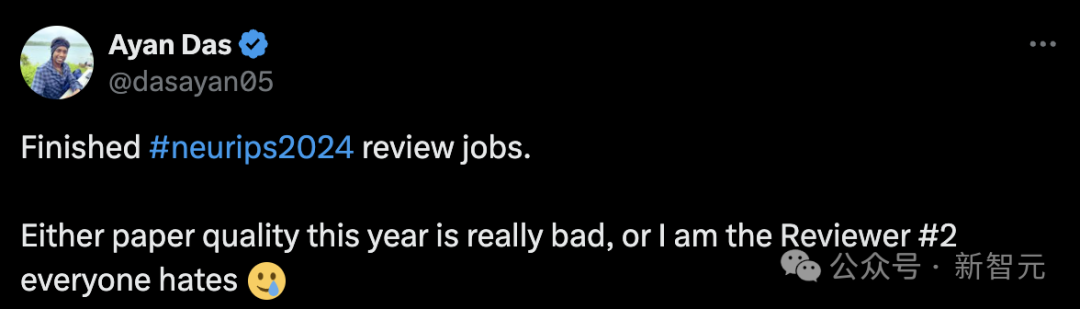

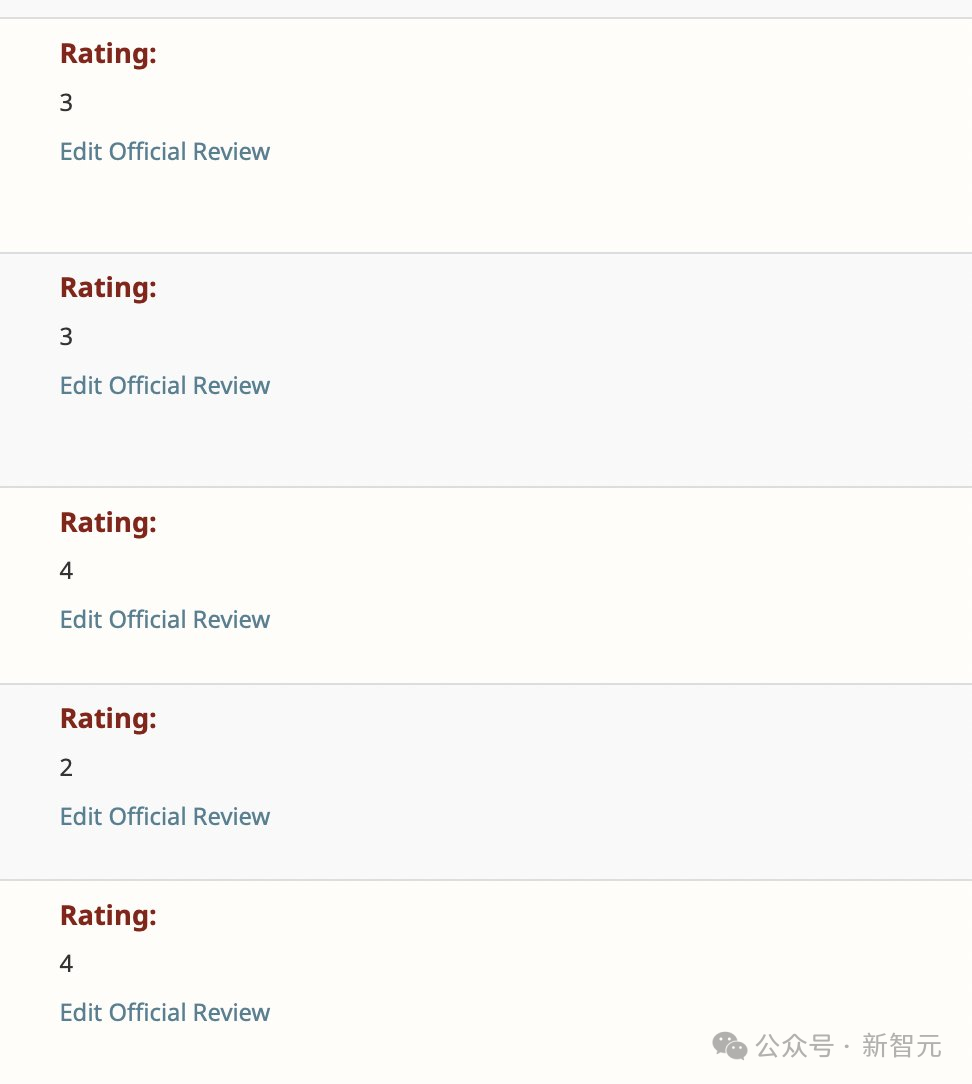

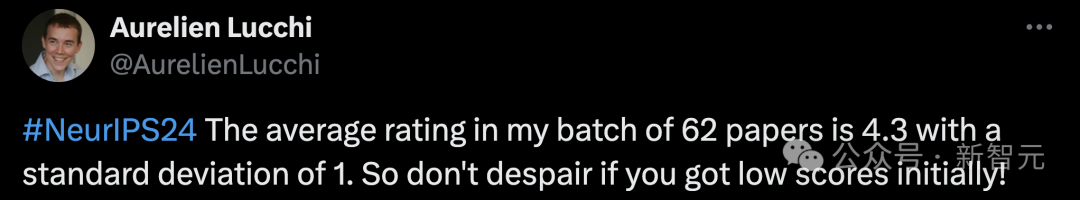

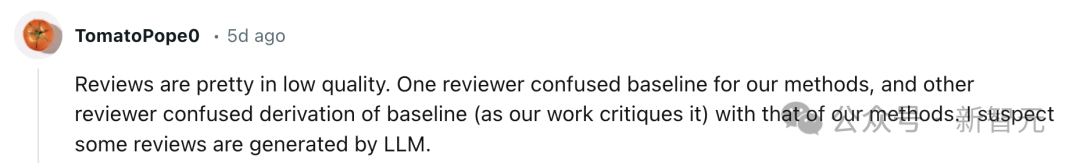

今年,NeurIPS收到了很多「回收利用」的论文。另一位AI研究员同样表示,要么就是论文质量下降,要么我就是大家口中讨厌的2号评审员。另有评审员表示,「在我负责的这批62篇论文中,平均评分是4.3分,标准差为1。所以如果你最初得到低分,也不要灰心」!可见,这次NeurIPS顶会论文作者都挺不好受,想要获取高分并不容易。Reddit网友评论道,自己用一个月的时间审核6篇论文,当看到自己得到的是LLM的评价,真的很受伤。还有人指出,在自己审阅的论文中,至少发现了3篇由大模型生成的评审意见,很可能还有更多,其中3篇明显是直接复制粘贴了ChatGPT输出,完全没有阅读论文。这些评审都给了6分,Confidence为4,与其他所有人的评价完全不一致。一个评审者混淆了我们方法的基线,另一个评审者混淆了基线的派生(正如我们的工作所批评的那样)和我们方法的派生。我怀疑一些评论是由LLM产生的。对于NeurIPS的评审,6分的描述完全、彻底、奇怪地错误。通常情况下,给6分就意味着拒稿。但它却被描述为一篇有中等到高影响力,且没有问题的论文?

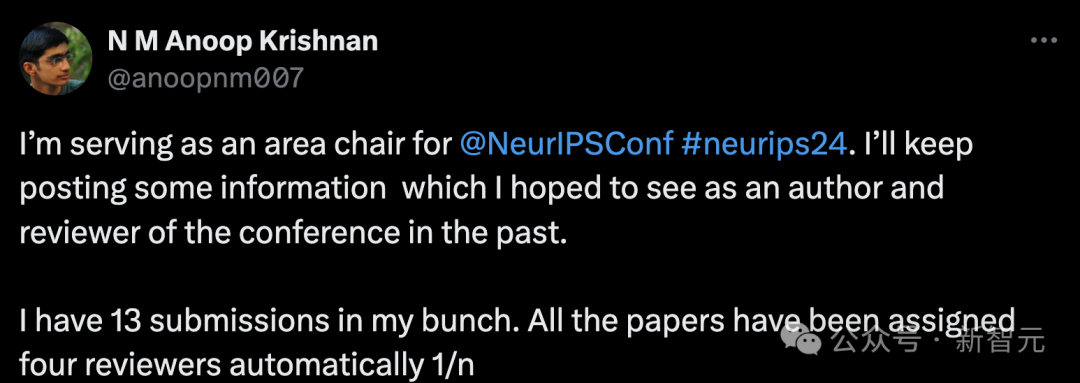

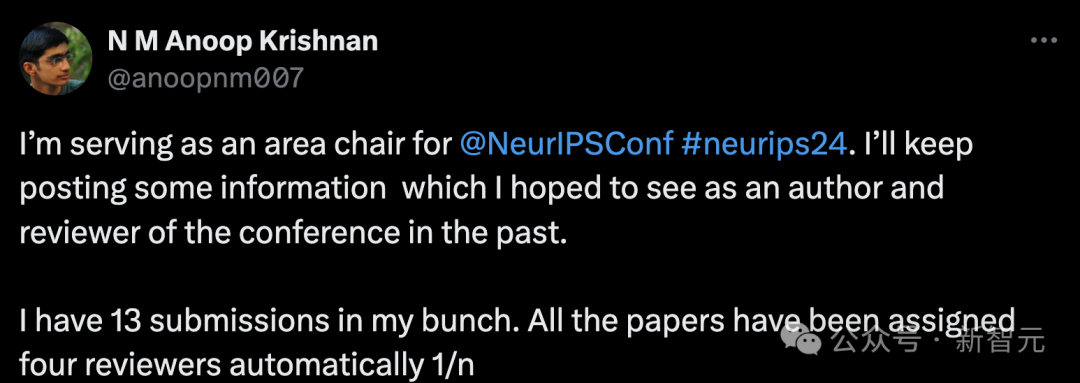

在NeurIPS评分规则中,给6分的介绍——Weak Accept。技术上扎实,具有中等到高影响力的论文,在评估、资源、可重复性、伦理考虑方面没有重大问题。今年6月,NeurIPS一位AC分享了很多关于顶会评审的更多信息:他负责的一批共有13篇投稿,所有论文都已自动分配了四位评审员。有趣的是,50%的评审员是博士生,还有几位硕士生和本科生也是评审员。13篇论文中有5篇的评审员中,没有任何一位的职位高于博士生。在这位AC负责的所有评审员中,有3位正教授,1位副教授,4位助理教授,9位业界专业人士,以及2位来自国家实验室的人员。其余的是博士后/研究科学家、博士生、硕士生和本科生。https://x.com/papercopilot/status/1818392051995791556https://x.com/GaelVaroquaux/status/1818953424357970097https://x.com/sahar_abdelnabi/status/1819082177881297144https://x.com/qixing_huang/status/1811231112166785414https://x.com/AurelienLucchi/status/1818625639865327945https://www.reddit.com/r/MachineLearning/comments/1efscr2/d_neurips_2024_paper_reviews/