今天,ICLR 2025的discussion phase的ddl已经截止。回看过去14天的讨论过程,可太精彩了!

各大平台上随手一翻就是作者们的吐槽大会,都在无语这届ICLR评审的各种奇葩乱象。

譬如UCSB博士生@JiachenLi11 就在推特上非常之无奈:

我收到的评审内容,低到令人担忧——其中一条评审甚至话都没说完。难道审稿人的tokens用完了吗???

△图源推友@JiachenLi11

△图源推友@JiachenLi11

你还真别说,他这个“tokens用完”的吐槽并不是空穴来风——

ICLR 2025的论文提交数前所未有地高,约有11000篇。

为了提升审稿速度和质量,ICLR今年引入了AI参与审稿工作。

当然了,倒也不是单一AI,是多个AI大模型组成的Agent。

然而,你以为审稿人话不写完评审内容就点发送,就是ICLR 2025的全部槽点了吗?

ICLR吐槽大赏

要细数今年ICLR 2025的神奇事件,咱们先从最广为人知的一件说起:

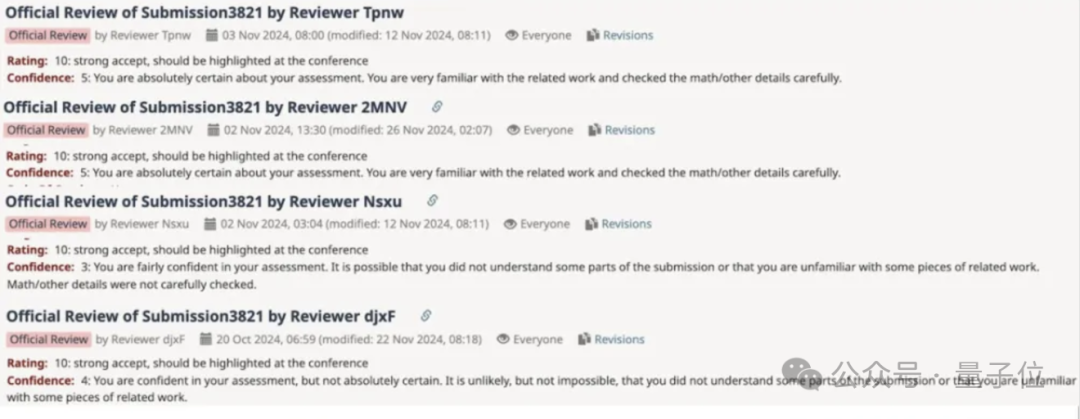

[10,10,10,10]和3个poor得分并存

今年的ICLR出现了一篇4个审稿人同时打出了10分的论文。

假如这个分数能保持到中稿通知,这将是近5年来,ICLR的唯一一篇满分作文。

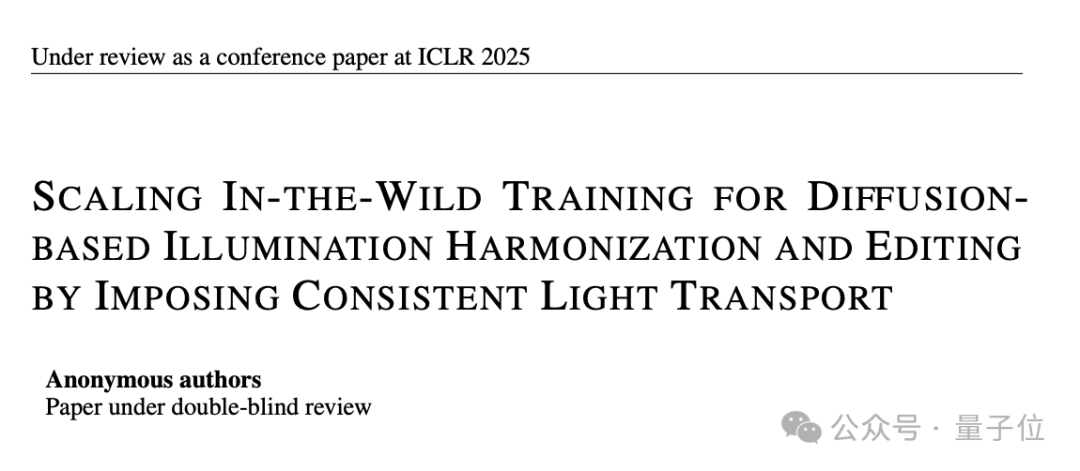

论文题目如下图,是一个叫IC-Light(全称Imposing Consistent Light)项目,是关于控制图像照明的。

作者张吕敏,也是大名鼎鼎的ControlNet的作者。

他在苏州大学拿到学士学位后,去往斯坦福读博。

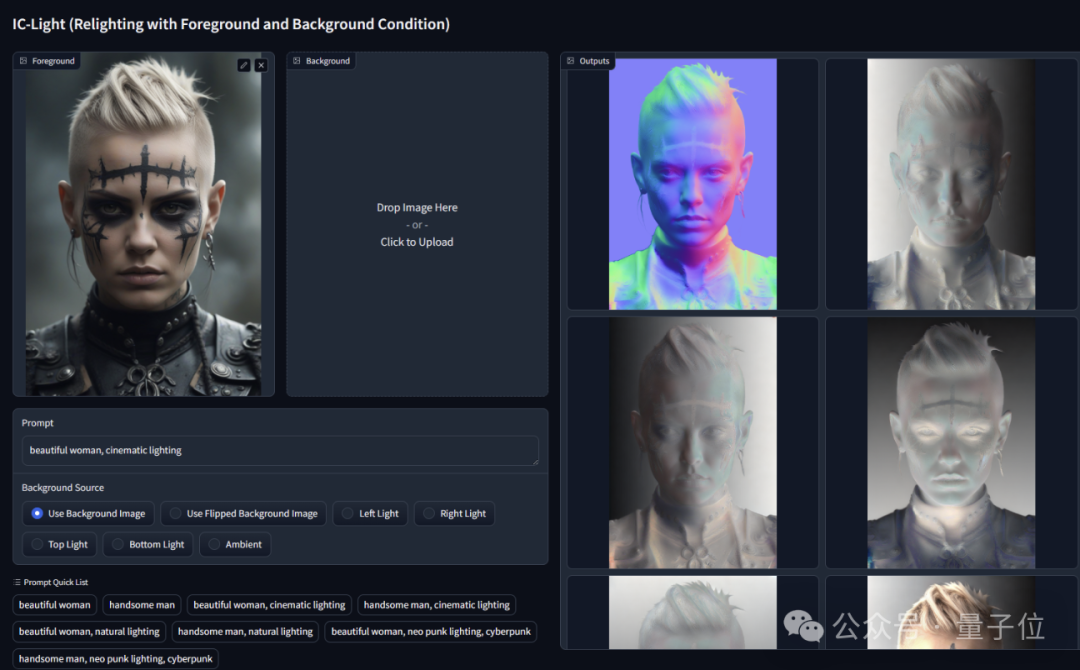

IC-Light可以随意控制照片主体的光源和背景,将主体、光源、背景三者迅速地融合在一张图片里。

半年前,IC-Light就在GitHub上开源,现在共6.5k星。

与此同时,ICLR 2025还出现了几篇,某一审稿人给某篇论文全打1分的论文。

这里我们打断一下,了解一下ICLR的评分体系:

1分:太差了

3分:拒绝

5分:婉拒了哈

6分:接……吧

8分:接收

10分:强接收

就拿其中一篇来说吧,看到这个结果给作者气的,写了一篇十几页的strong rebuttal。

那审稿人为什么给人家Soundness、Presentation、Contributions都给了1分?

审稿人言辞非常犀利,直呼Paper Writing is quite bad,然后还毫不客气地提问:“Is there a human author on this paper?”

审稿人还表示,(这也是全部最低分的最重要一点),我们是可以判断一篇论文是人写的还是AI写的,“也许您在生成文本时没有进行基本的连贯性检查”。

作者继续输出长篇大论rebuttal,并回击“我可真钦佩你识别AI的能力”。

作者5页回应,审稿人在ddl突然否定领域

一位在北大CS读博的小某书网友@Kevin 对审稿人的神操作大吐苦水。

事情是这样的,ICLR不是共14天用来discussion phase嘛。

这14天里,有一位审稿人5,一共对他所在团队提交的paper提出了10个问题。

团队认真回复了整整五页,审稿人5已读不回。

团队多次希望与其讨论,审稿人5已读不回。

总之就是一整个石沉大海。

到了昨天,也就是discussion phase的最后一天,“审稿人5突然否定这个领域,并将5分改为3分”。

@Kevin非常不理解为什么审稿人这样做的意图。

真的就,令人心碎的discussion phase。

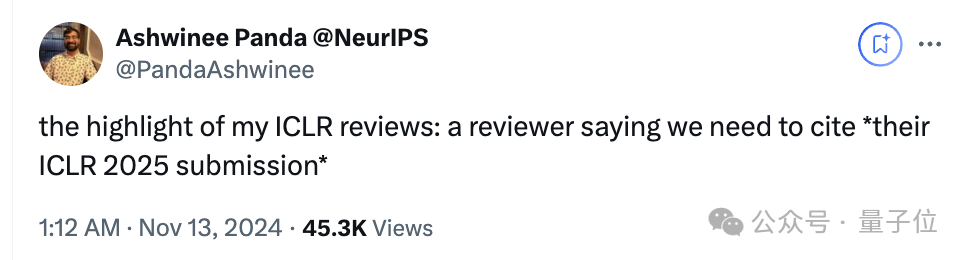

“你需要引用另一篇ICLR 2025投稿”

推友@PandaAshwinee(普林斯顿博士毕业,现在在Trails.ai从事博后工作)给看热闹的网友们画了个自己接收到的评审内容的亮点:

你需要引用另一篇ICLR 2025的投稿。

展开说说,就是审稿人链接了ICLR 2025 openreview的另外一篇论文,表示两个项目高度相关,所以小哥应该引用。

但是哭啊,小哥查过了,要求被引的论文根本不在arXiv上。

而且这不是他第一次感觉“天塌了”——他在评论区补充,之前他的项目在ICML 2024被拒,主要原因也是“与另一篇ICML 2024投稿高度相似”。

不过ICLR很快在小哥推文下面回复了,表达程序主席开始调查这个事儿。

“乞讨式”ICLR

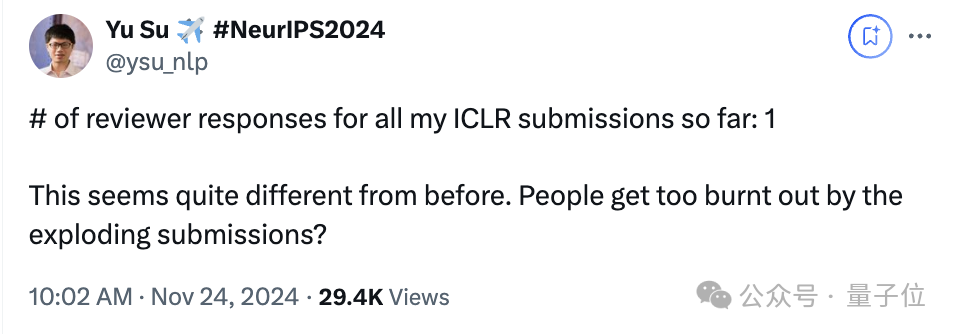

前面提到的都是审稿人和作者有来有回(哪怕回得慢)的激情battle,更有意思的事是,无论国内还是国外,很多人都把这届称为“乞讨式”ICLR。

简而言之,就是审稿人一直不给评审不给分。

有人上个月下旬的时候,就开始给所有AC(区域主席)发了邮件,要求他们提醒审稿人回复作者。

或者至少确认审稿人们知道自己还得干这活。

当时就有网友提醒“最坏的打算”,有的审稿人会拖到最后一刻,因为他们也在为自己措辞……

果不其然,单看国内,昨天开始24h内倒计时了,很多作者还在恳求审稿人快快评审,快快给分。

哎。

对作者的奇怪请求

在Google DeepMind工作的Ahmad Beirami(@abeirami)分享了一则讯息:

发到推特上后,有ICLR作者表示出了疑惑:

如果作者们写了这玩意儿,是否真的对审稿有帮助?

他觉得这“可能是在浪费时间”,因为审稿人完全可能看都不看,直接去看paper原文。一切都是徒劳的。

不过Ahmad很快回复了这位作者:

Yes!

作为一名AC,我想确保我没有从作者的角度遗漏任何内容。可能会有很多变化、新结果等。我想确保我知道在哪里找到它们,以便能够形成观点,判断一些原始评论/关注是否适用。

得到这个答复后,作者小哥很愉快地去添加注释去了。

ICLR 2025为何这样

以上种种,只是大家或身在其中/或围观看热闹的ICLR 2025的一点点故事而已。

但,身为权威顶会,为什么会这样?

有的人认为和今年的稿件数量有关。

官方数据显示,ICLR 2025的论文提交数量达到了11,000多篇,同比增长61%。

而去年ICLR 2024组委会收到的投稿总数为7,262篇——当然了,对那时候的ICLR来说也是不小的工作量,同比增长了47%。

今年,面对如此庞大的论文数量,审稿人数量高达15,000多名。

这还不够,官方还引入了多个AI大模型构成的Agent来参与审稿。但它的功用不是完全替代审稿人,它不会撰写审稿评论或直接编辑评论,而是提供建设性和可操作性的反馈,帮助审稿人提高审稿质量。

这个Agent针对审稿中可能存在的三类问题提供建议:

鼓励审稿人改写含糊的评论,使其对作者更具可操作性;

突出文章中可能已经回答了审稿人问题的部分;

发现并处理不专业、不恰当的言论。

但很多作者认为,稿件数量激增确实加大了工作量,Agent的辅助无可厚非,但绝不是ICLR变成被看热闹的“科研春晚”的原因。

一方面,Agent提出的建议,审稿人是可以选择接受或者忽略不管的。

另一方面,极速扩张的审稿人中,是否有人并不是适合评审工作?

再一方面,为了确保审稿质量,每位审稿人平均分配3篇论文,顶天了看4篇,工作量并不是超负荷状态。

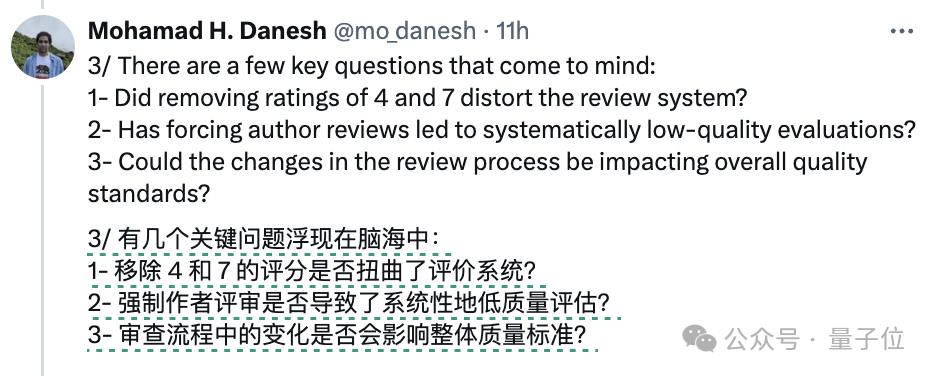

除了有点混乱以外,另一个被网友们激烈讨论的点,集中在这届ICLR的分数上。

一般来说,ICLR的传统接收率在30%左右,然后今年ICLR的排名前30%的论文,平均评分约为5.6。

前面我们介绍了,6分算是一个勉勉强强的分数,属于论文被接收的边缘门槛。

这就意味着“低于‘边缘接受’门槛的论文将被接收”。

网友谈道,“当会议接受变得如此随意时,我们正在破坏整个科学评估系统——这影响到AI研究整体的完整性。”

在此基础上,他提出了三点自己的思考,希望ICLR应有更严格和公平的程序。

当然,也有另一种声音:

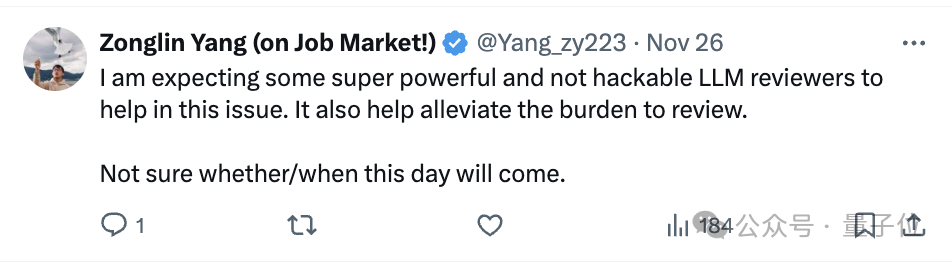

期待一些超级强大到无懈可击的大模型出现,让它们充当审稿人,解决上述所有问题,以此帮助减轻审稿的负担。

只是不知道这一天什么时候会到来了。

参考链接:

[1]https://x.com/mo_danesh/status/1863964693687107823

[2]https://x.com/JiachenLi11/status/1856472250636964350

[3]https://x.com/Yuchenj_UW/status/1862541099136651536

[4]https://x.com/abeirami/status/1863629237741064608

[5]https://x.com/PandaAshwinee/status/1856384624873570749

[6]https://x.com/ysu_nlp/status/1860504185583648863

[7]https://openreview.net/group?id=ICLR.cc/2025/Workshop_Proposals#tab-accept

— 完 —

12月11日

「MEET2025智能未来大会」报名啦

? 李开复博士、周志华教授、智源研究院王仲远院长都来量子位MEET2025智能未来大会探讨行业破局之道了!

? 最新嘉宾阵容在此,点击报名参会欢迎来到MEET智能未来大会,期待与您一起预见智能科技新未来!

左右滑动查看最新嘉宾阵容

点这里?关注我,记得标星哦~

一键三连「点赞」、「分享」和「在看」

科技前沿进展日日相见 ~