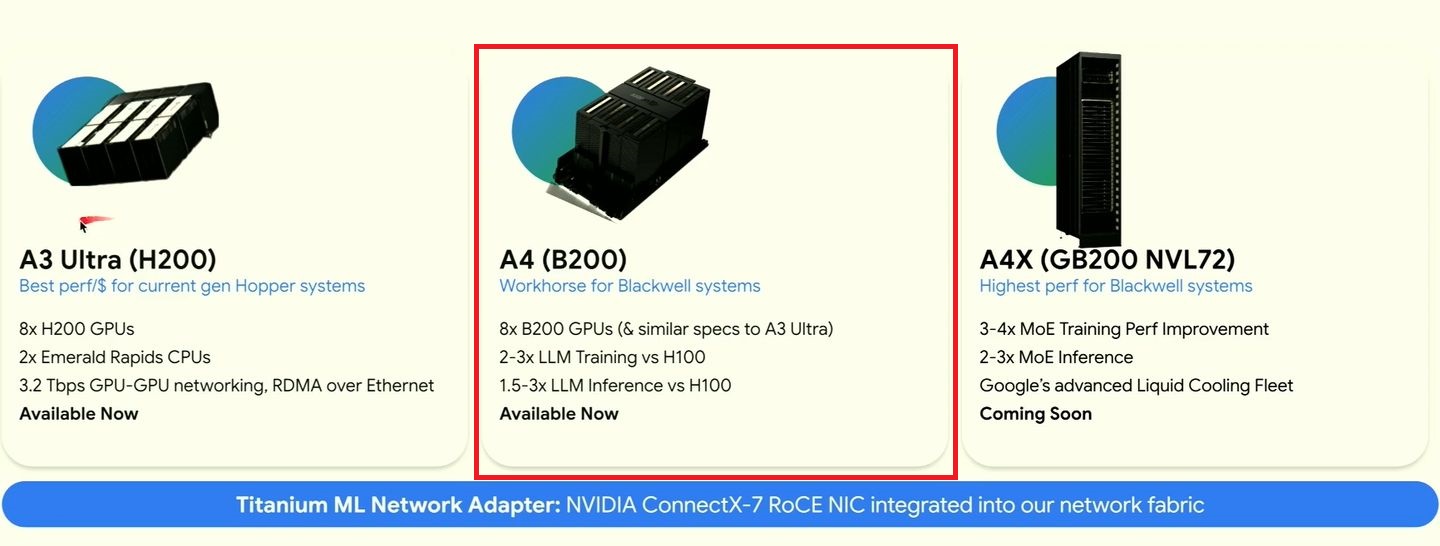

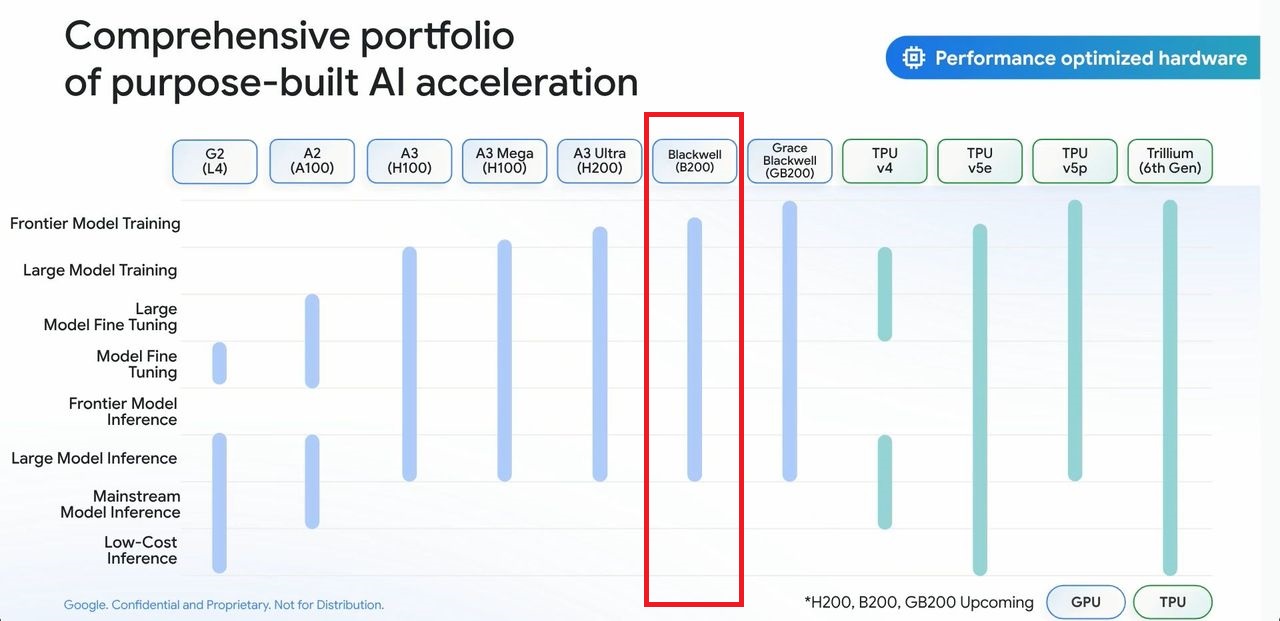

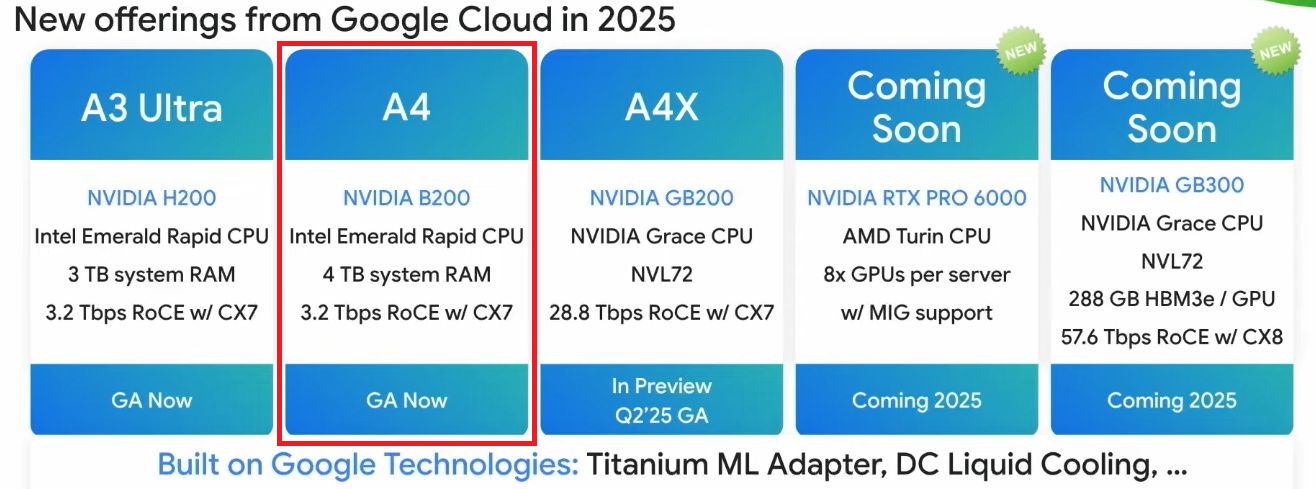

輝達資料中心GPU炙手可熱,這幾年以來,三大公有雲業者持續擴充GPU運算服務陣容,以Google Cloud而言,2023年推出基於Nvidia L4(Ada Lovelace架構)的G2,以及基於Nvidia H100(Hopper架構)的A3,2024年6月增設網路頻寬加倍的A3 Mega,10月推出可配置1、2、4、8個H100的A3 High,以及網路頻寬達800 Gbps的A3 Edge,並且發表基於Nvidia H200(Hopper架構)的A3 Ultra,年底A3 Ultra上市。

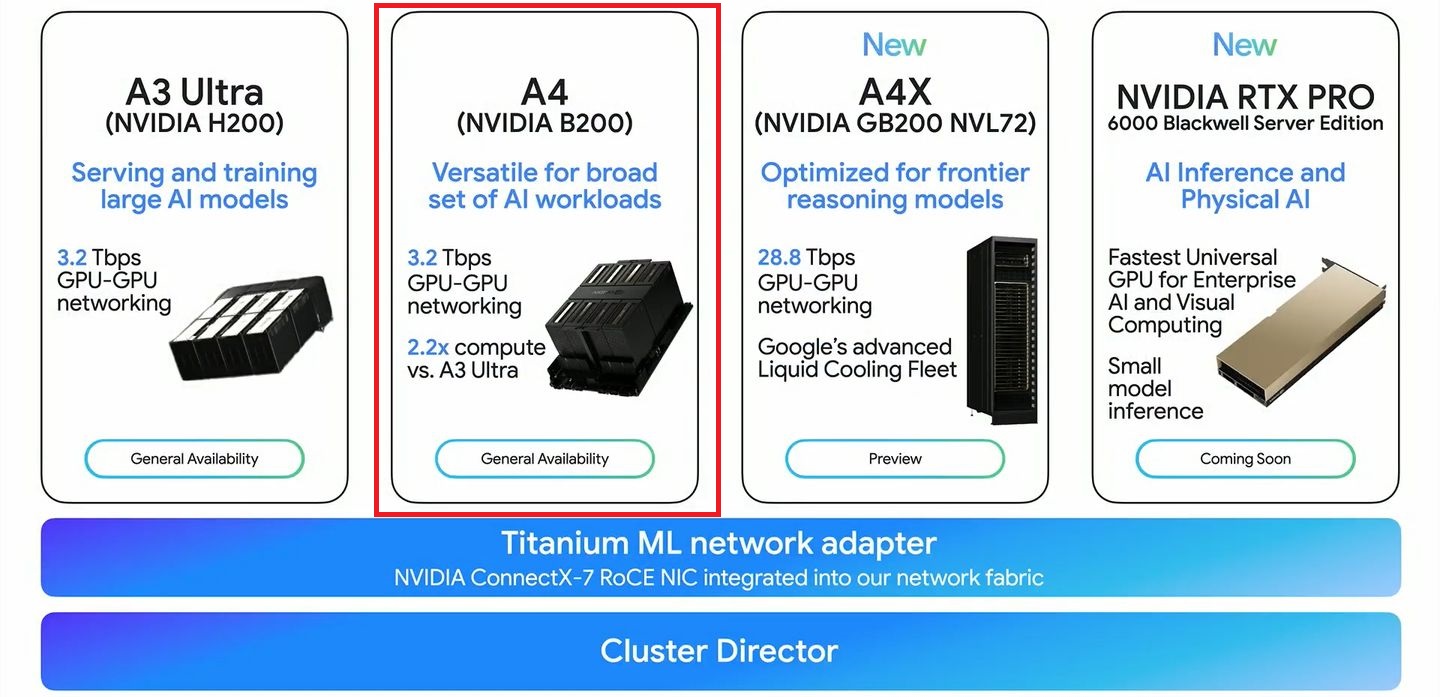

到了今年,Google Cloud在2月釋出基於Nvidia B200(Blackwell架構)的A4預覽版本,3月Nvidia GTC大會期間,A4正式上線,Google Cloud也釋出基於Nvidia GB200 NVL72(Blackwell架構)的A4X預覽版本,隨後於5月底A4X也正式上線,

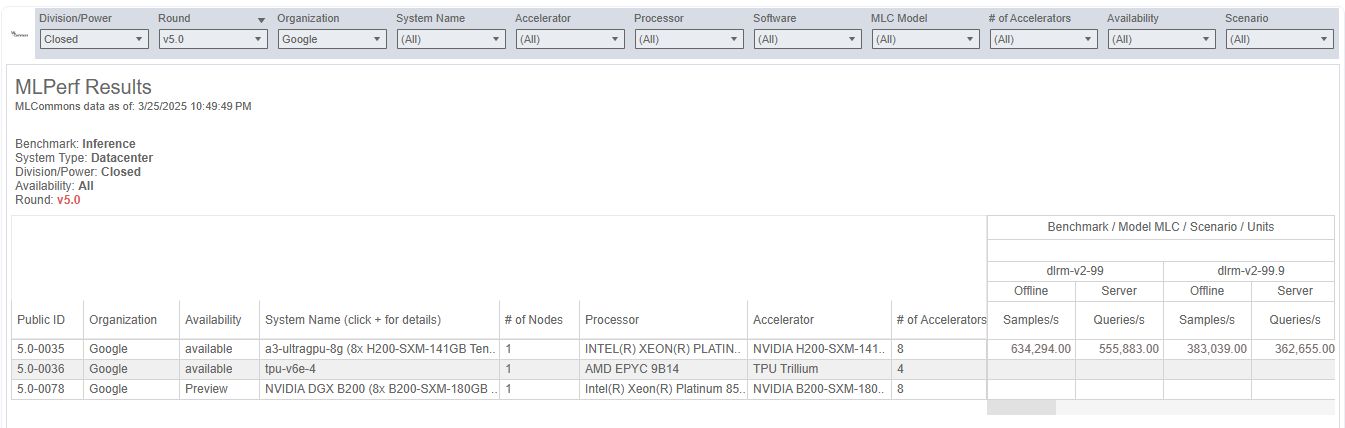

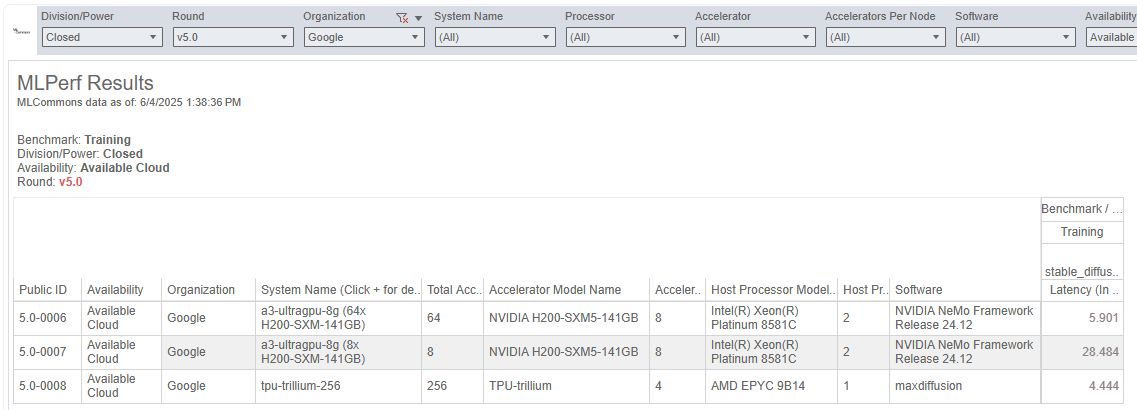

關於運算效能測試數據的公開揭露,MLCommon在4月與5月陸續發布的MLPerf Inference v5.0、MLPerf Training v5.0,Google Cloud針對Nvidia GPU的雲端運算服務,僅提交A3 Ultra的結果。

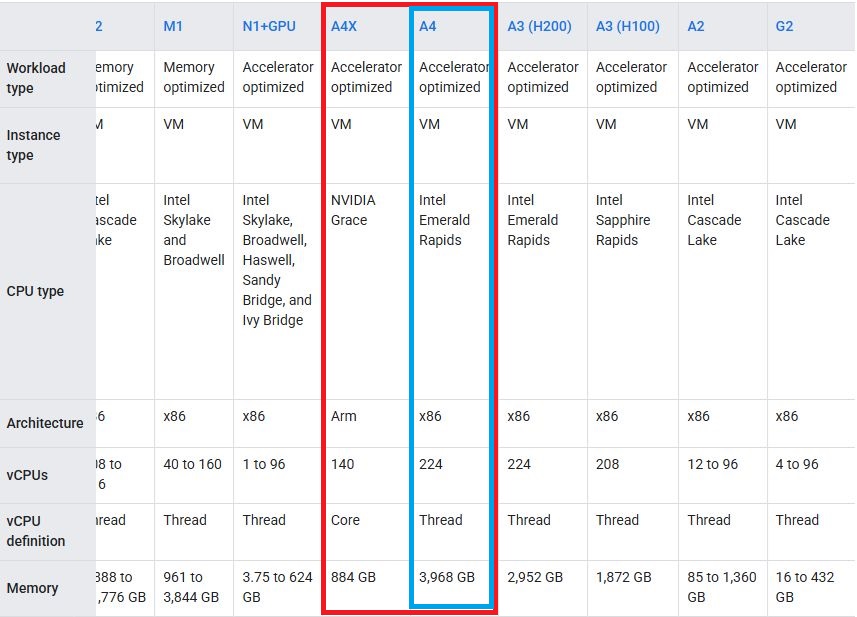

根據Google Cloud在2月發布的部落格文章,A4採用Nvidia HGX B200平臺,當中配置8個Blackwell架構GPU,並以第五代NVLink介面互連,就尖峰運算效能而言,新一代GPU領先幅度可達2.5倍,配備的HBM記憶體容量也增至2.25倍,能廣泛用於各種AI模型架構的訓練與微調。至於A4採用的處理器平臺,則是英特爾第五代Xeon Scalable系列的Xeon Platinum 8581C。

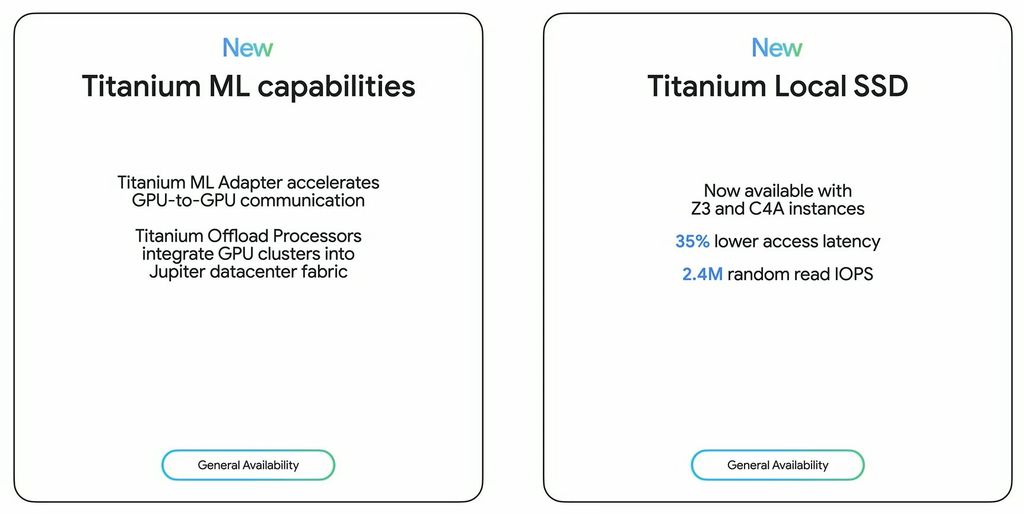

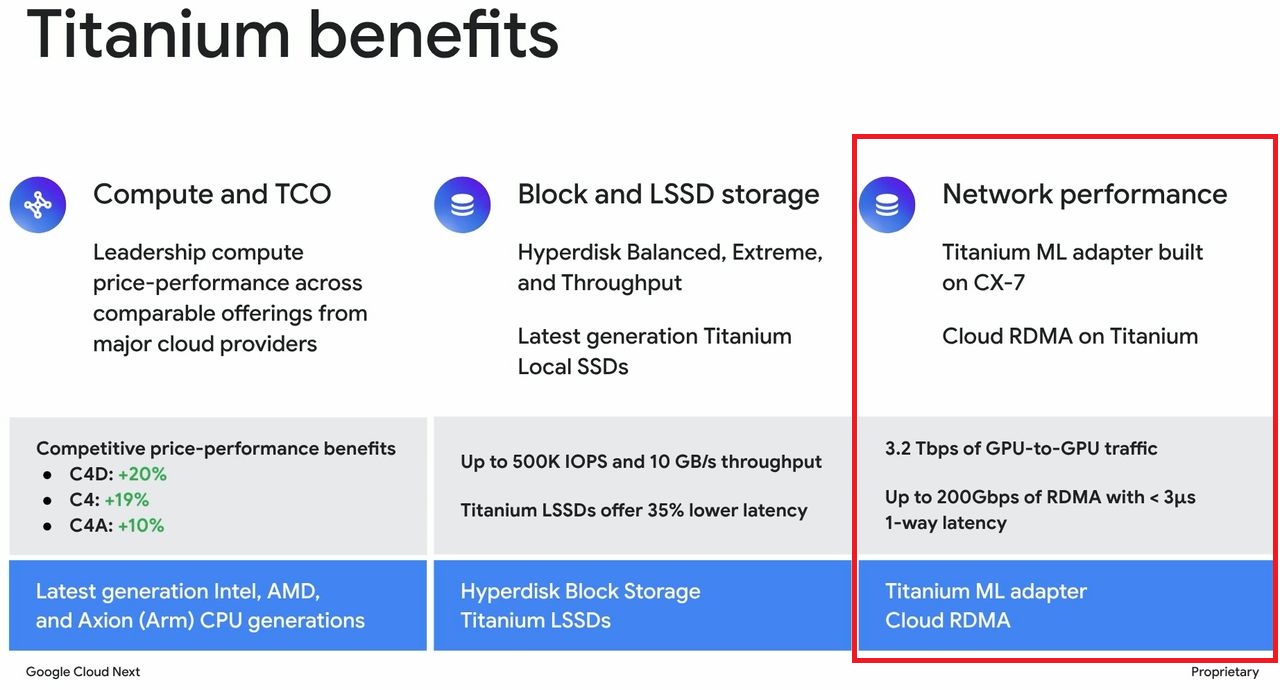

值得注意的是,用來建構A4與A3 Ultra的伺服器,也配備Google Cloud新設計的Titanium ML網路卡,而這個網路介面其實是基於Nvidia ConnectX-7網路卡而成。Google Cloud表示,經過調校之後,Titanium ML網路卡可針對AI工作負載提供安全、高效能的雲端服務使用體驗。

在網路基礎架構的配置上,A4與A3 Ultra結合遍及整個資料中心的4通道邏輯線路群組網路(4-way rail-aligned network),能藉由RoCE(RDMA over Converged Ethernet)技術,進而提供3.2 Tbps的GPU互連網路傳輸頻寬。若要擴充雲端服務的加速運算規模,Google Cloud用戶能夠將GPU數量設置到數萬個,關鍵在於:底層的資料中心交織網路,採用他們發展的Jupiter第五代技術架構,可提供13 Pbps的網路對分頻寬。

而在3月A4正式上線的消息當中,Google Cloud表明A4的具體成效,例如,FP8運算效能可達到72 PFLOPS,AI訓練效能比起稍早推出的A3 Mega,增長2.2倍。

產品資訊

Google Cloud A4

●原廠:Google Cloud

●建議售價:美國愛荷華州資料中心(us-central1),承諾使用1年每小時88.9272美元

●處理器:英特爾第五代Xeon Scalable(Xeon Platinum 8581C)

●提供服務規模選擇與組態:a4-highgpu-8g,224顆虛擬處理器、3,968 GiB記憶體、本機儲存空間為12,000 GiB、8個Nvidia B200 GPU(1,440 HBM3e記憶體)、網路頻寬為3,600 Gbps

【註:規格與價格由廠商提供,因時有異動,正確資訊請洽廠商】