集成商老季操盘AI项目,因忽略存储瓶颈导致项目失败。客户虽采购了顶级GPU服务器,但利旧的存储系统无法满足大模型训推对海量数据处理的需求,导致模型训练卡死、推理延迟高。复盘会上,老季强调存储在大模型项目中的重要性,并介绍了曙光AI存储的三级智能物流系统架构,该架构针对大模型训推不同阶段的数据需求进行优化,最终客户追加预算采购曙光AI存储,项目得以成功上线。

💡大模型训推本质是海量数据处理,计算与存储高度耦合,是半计算半存储型任务。数据预处理、Checkpoint加载与保存、推理中的RAG环节都对存储提出了高要求,传统存储难以满足。

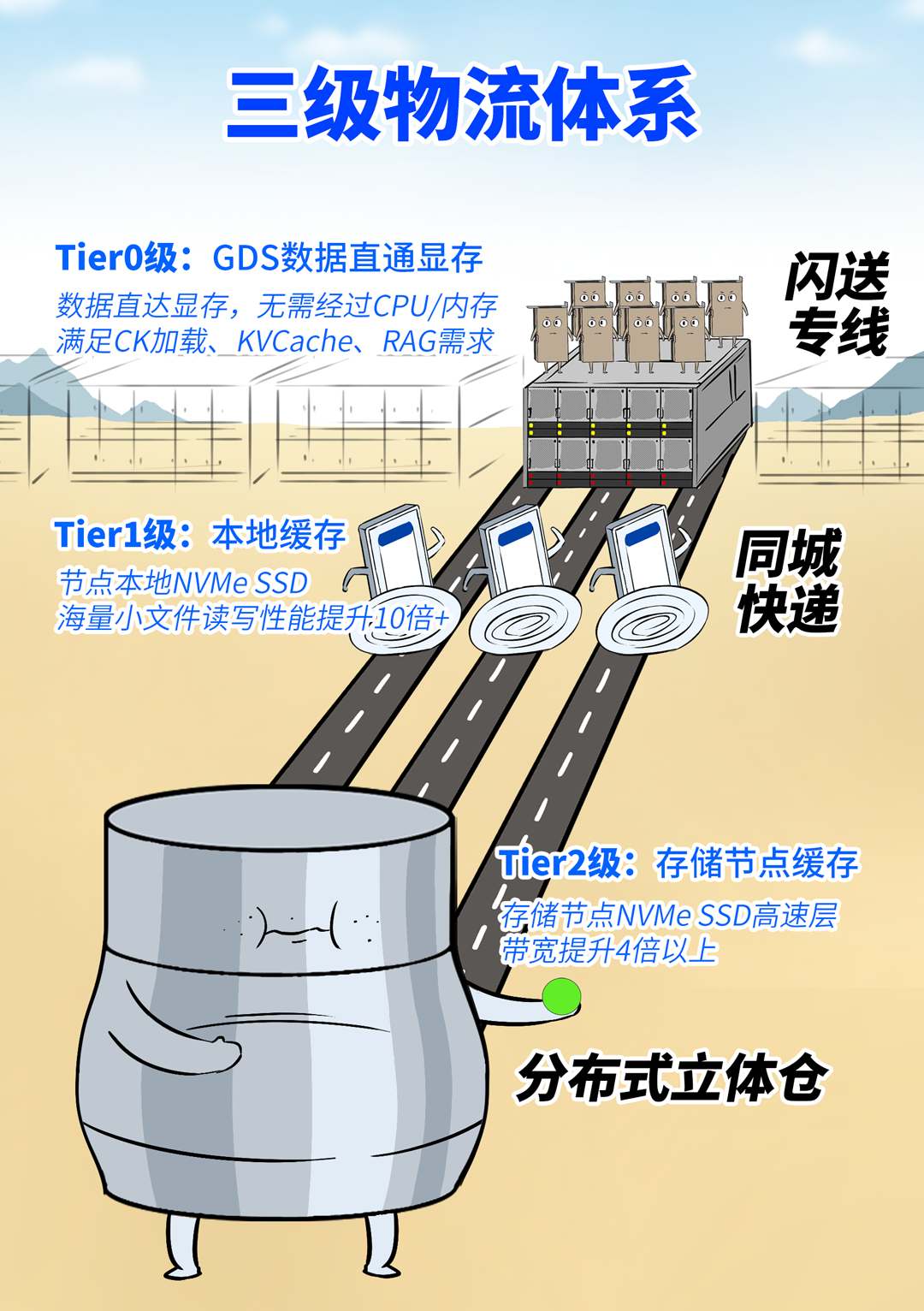

🚀曙光重塑的AI存储架构,采用“三层智能物流系统”,匹配大模型训推不同阶段的数据需求,实现数据分而治之。该架构保证每种操作都按照最优的快递路线进行,从而获得最好的投递结果。

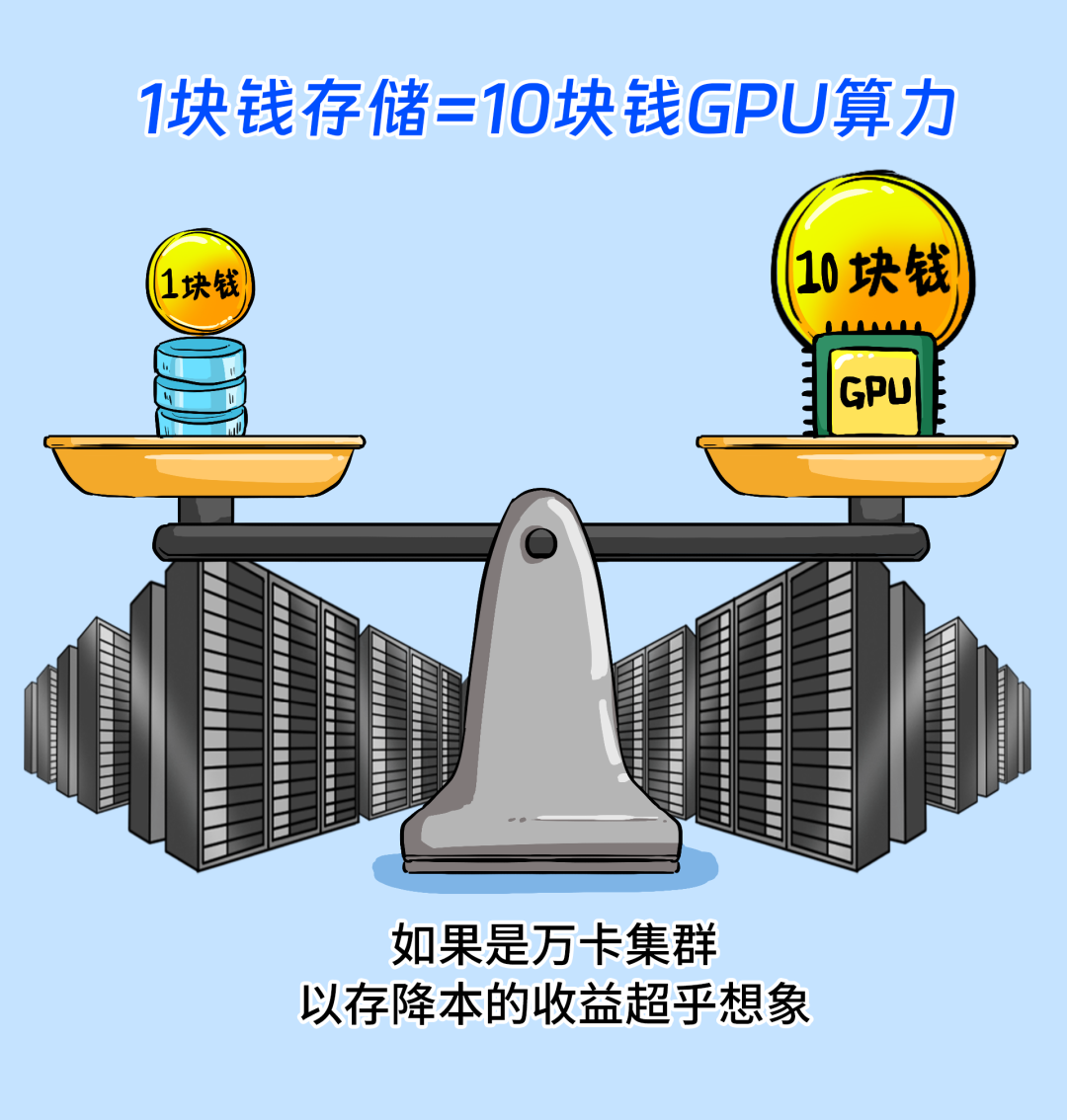

💰用户选择曙光AI存储的收益包括:以存提算,让GPU满负荷运转,利用率翻倍;以存代算,为GPU分担计算任务,提升推理速度;以存降本,通过提升GPU利用率,节省算力成本。

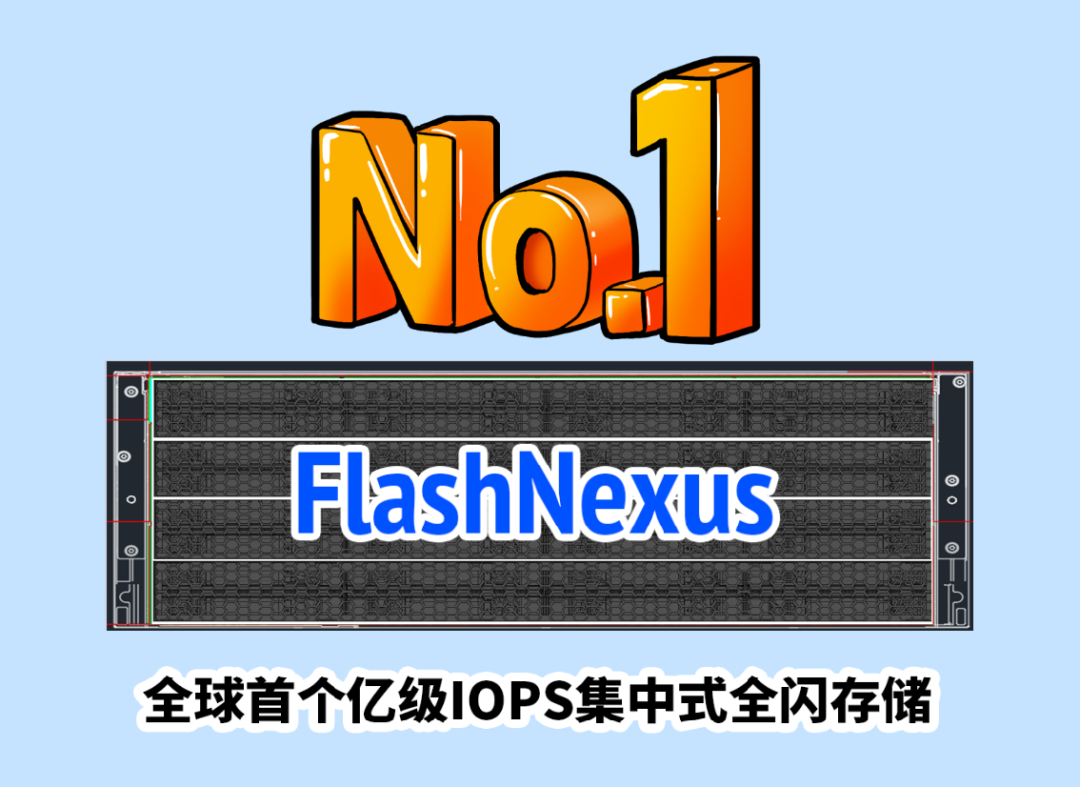

🥇曙光FlashNexus集中式全闪系列,在SPC-1 V3测试榜单上突破亿级IOPS,成为全球第一。它依托亿级IOPS和毫秒级低延时,可将token生成延迟降低高达80%,整体效率提升超过50%。

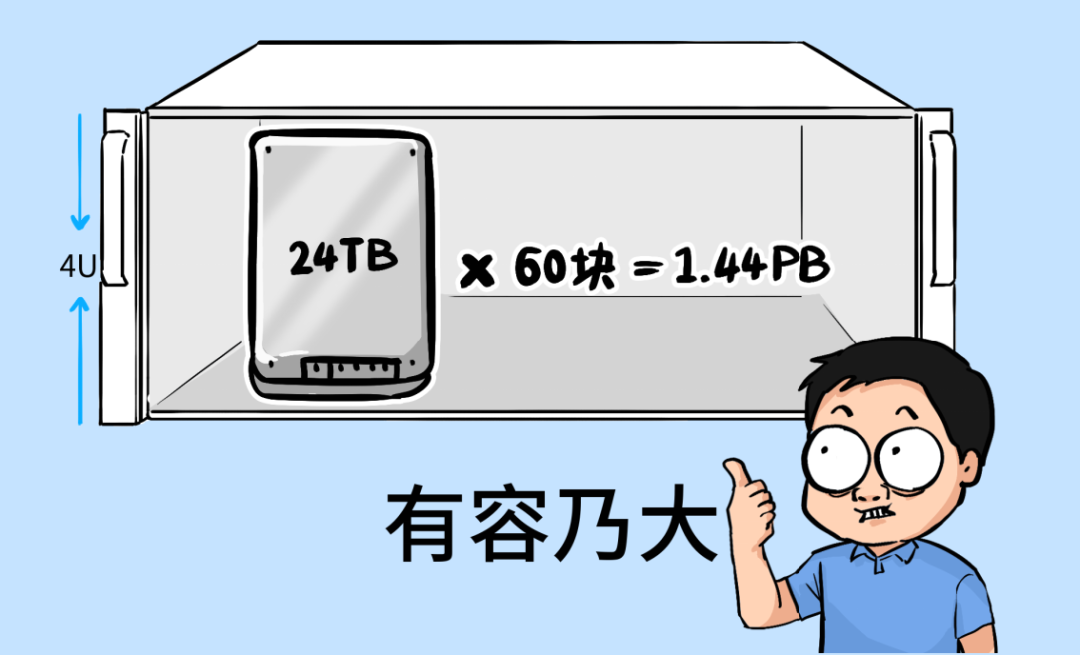

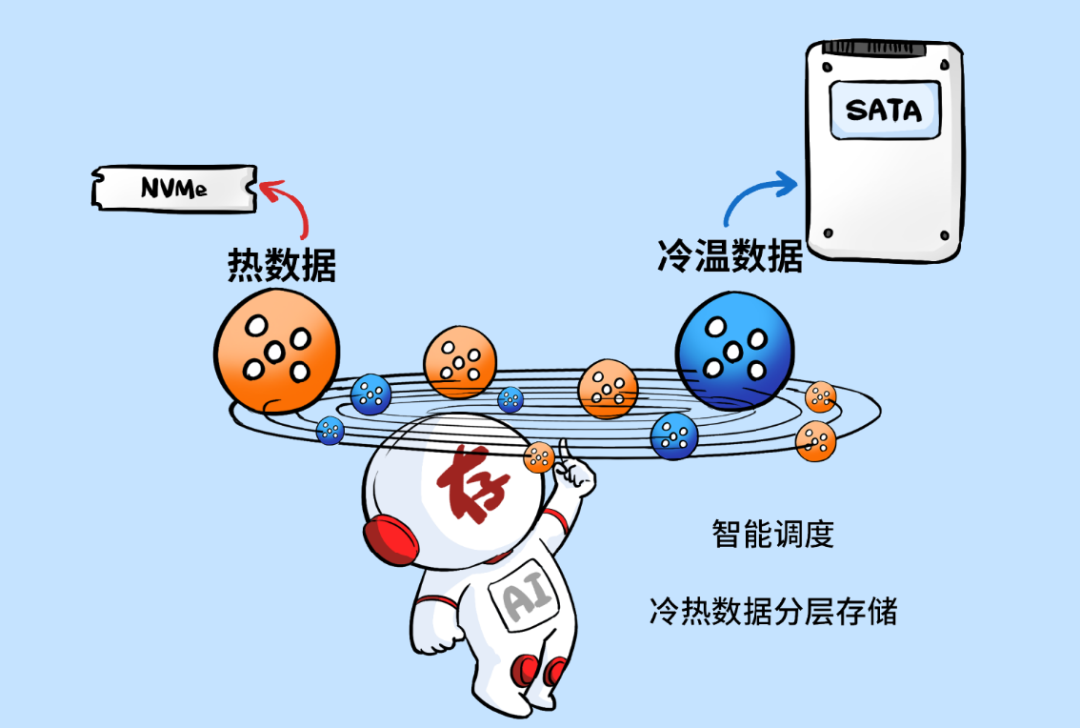

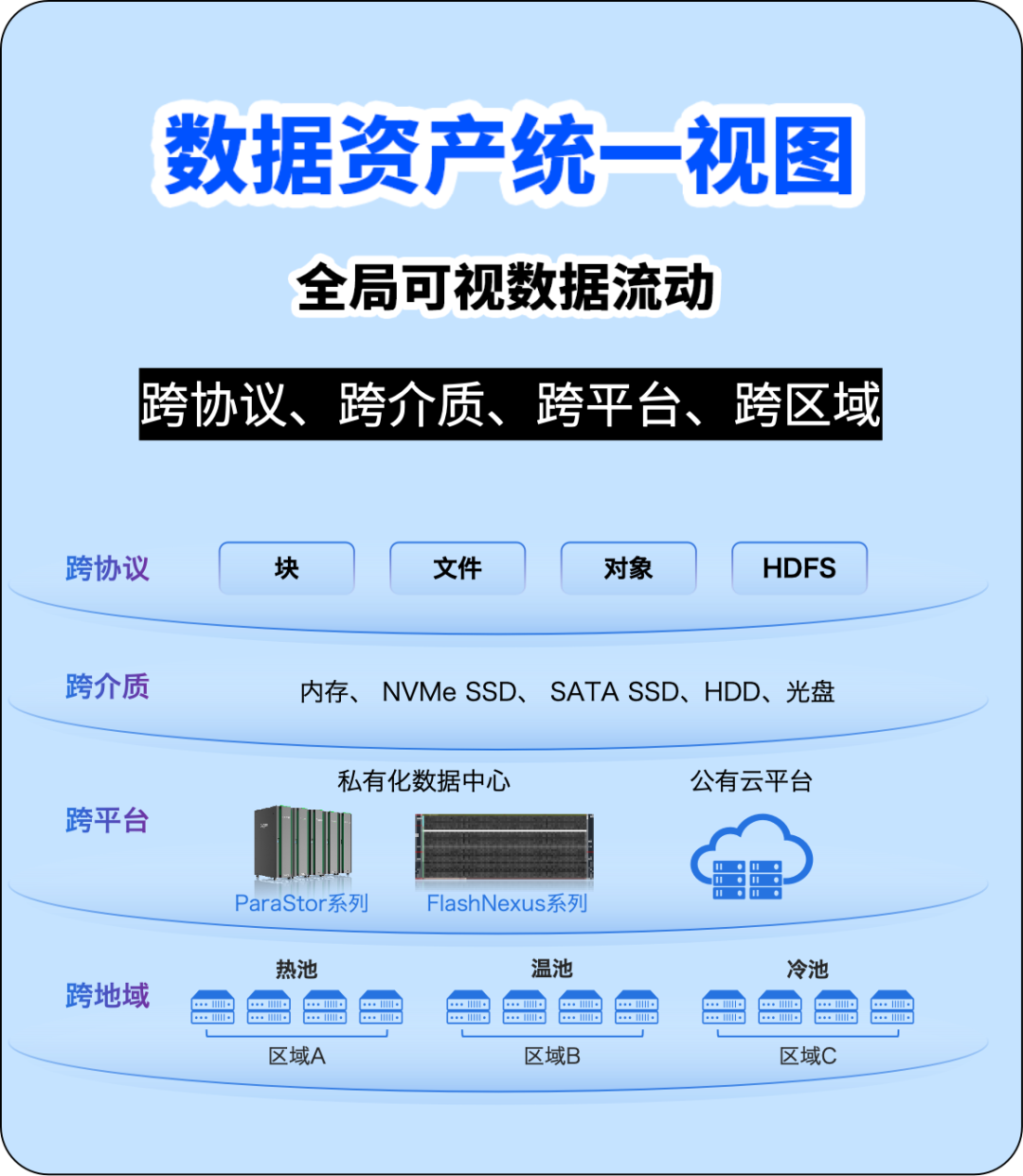

💾曙光ParaStor S6000系列,单柜支持1.44PB超大容量,采用冷热分层+智能调度,热数据自动放到NVMe,冷数据全进SATA/SAS,实现冷热数据无感流动,同时提供全局数据流动视图,方便数据管理。

原创 特大妹 2025-04-15 10:56 北京

.

最近,某集成商操盘手老季郁闷透顶。搞了个AI项目,尾款还没结,锅全被他身上。

老季在圈里号称季牛牛,搞项目从没失过手,可这一次,搞砸了。

一个老客户,某行业龙头,属于那种“混熟了”的类型,常年从老季公司采购服务器、存储、交换机啥的,处得还不错。

前阵子,他们内部决定搞行业私有大模型。

跟老季提了需求:之前的机房还在用,直接上一批GPU服务器就行,其他的都利旧。虽然客户说只买GPU服务器,但也算是一笔豪单,半年业绩有谱了。不过做方案的时候,公司技术总监给老季提了个醒:大模型项目特殊,其他设备利旧的话可能会有坑——

于是,老季去找客户加预算。

客户听了立马摆手:“你就别再忽悠我买设备了,把GPU服务器配好就行。”

老季想了想,客户说的也有道理。于是就没再坚持,按照客户的需求,继续推进。结果,设备到货,上线,一跑模型。

所有人都疯了!

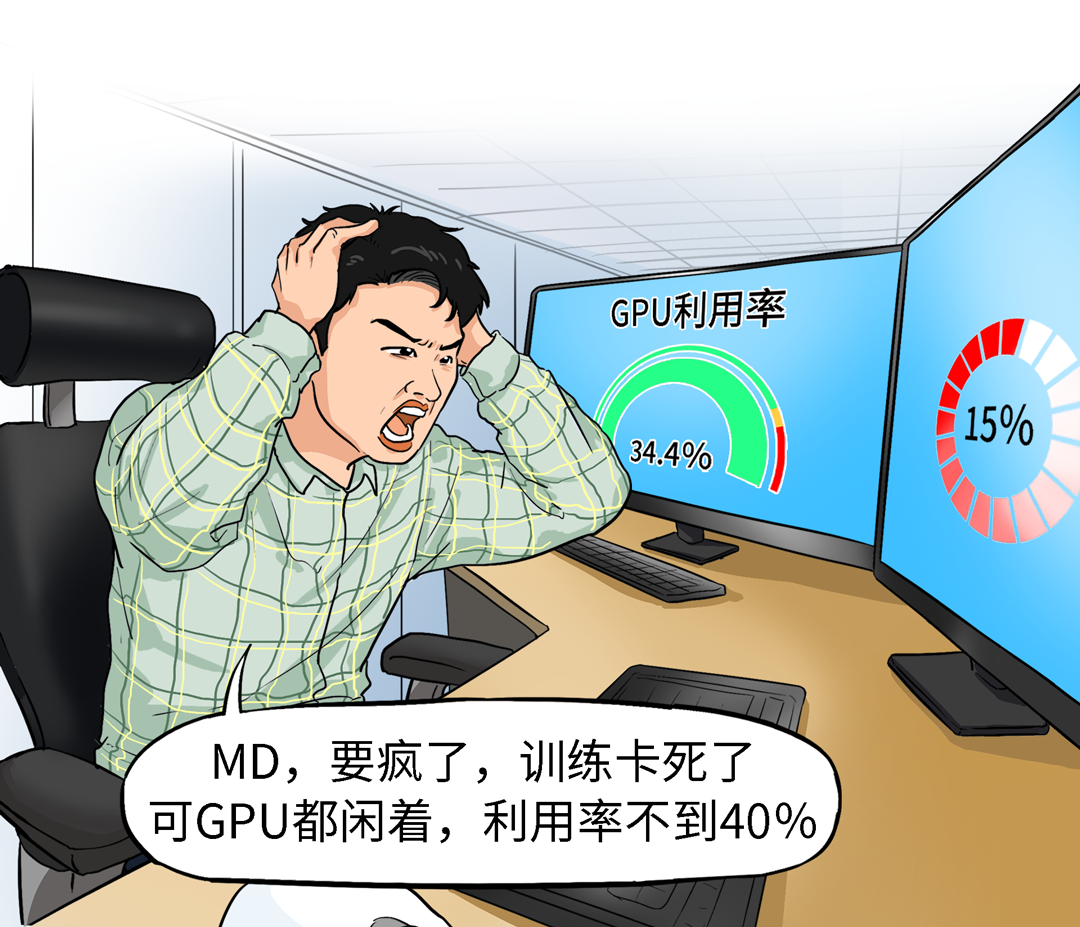

模型训练一跑就卡死,推理更别提了,延迟高得吓人,吞吐更不用说了,TPS竟然只有几百…

为什么数据加载这么慢,为什么训练总卡死,为什么Checkpoint保存要等半天?为什么推理延迟这么大?

双方技术查了几圈,查硬件、查软件、查框架…

最终跟技术总监担心的一样:存储拖了后腿。

客户脸都黑了,开始骂老季:“你们怎么不提醒我存储也可能是瓶颈?白瞎我这么好的GPU了?”

老季有苦难言,心说:领导,我提醒你了呀。

可是现在,这锅,只能自己背。

最后,公司老板出面协调,跟客户一起开个项目复盘会,大家一起来解决问题。

为了让老季长点记性,这个复盘会让他主讲。开会那天,老季PPT投上去,大大的一行字↓

一开场,老季就抛出了一个甲方最关注的点↓显然,不是!

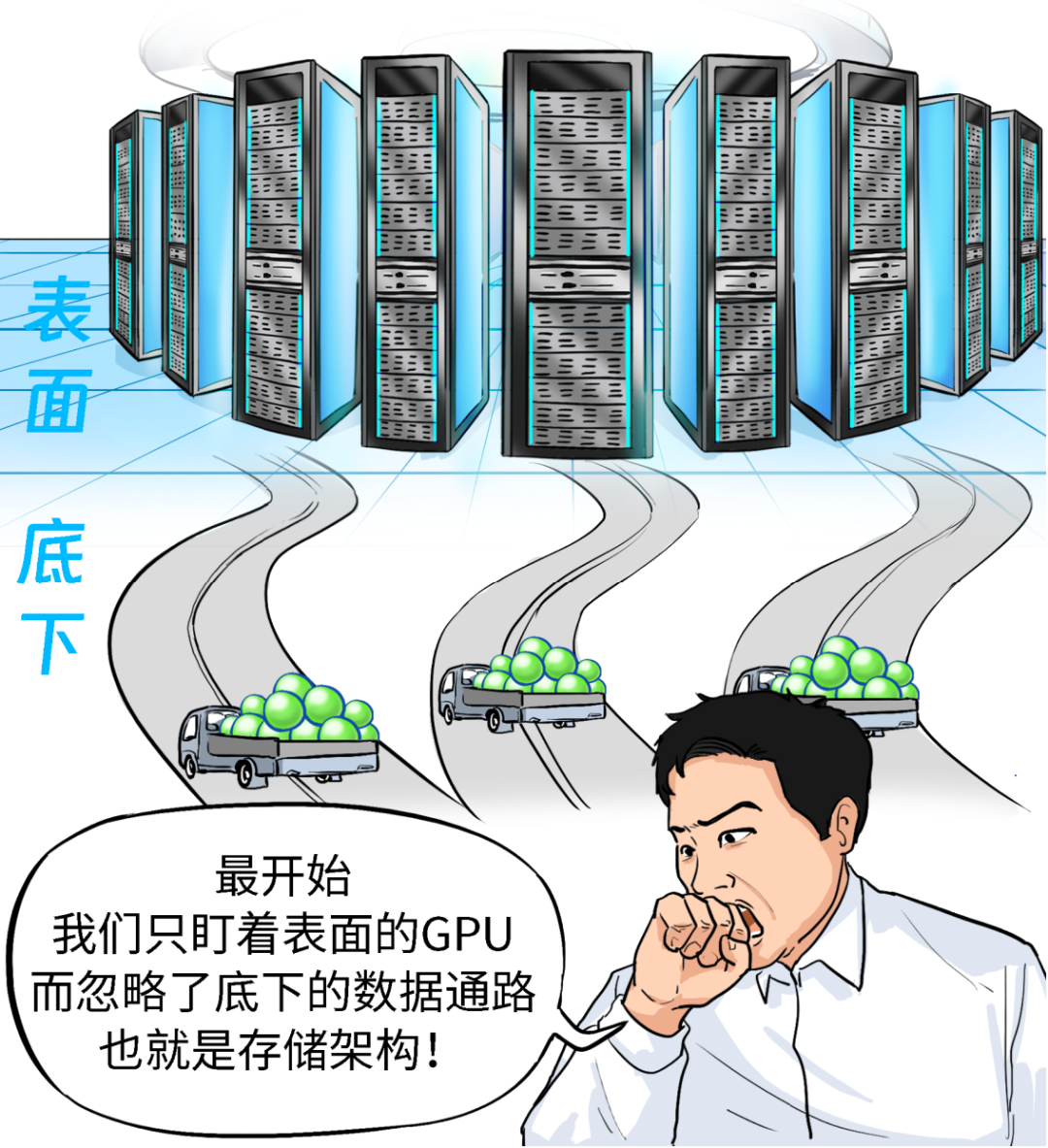

但当下很多大模型项目却把GPU当成充要条件,却忽略了另一大基础设施:存储。

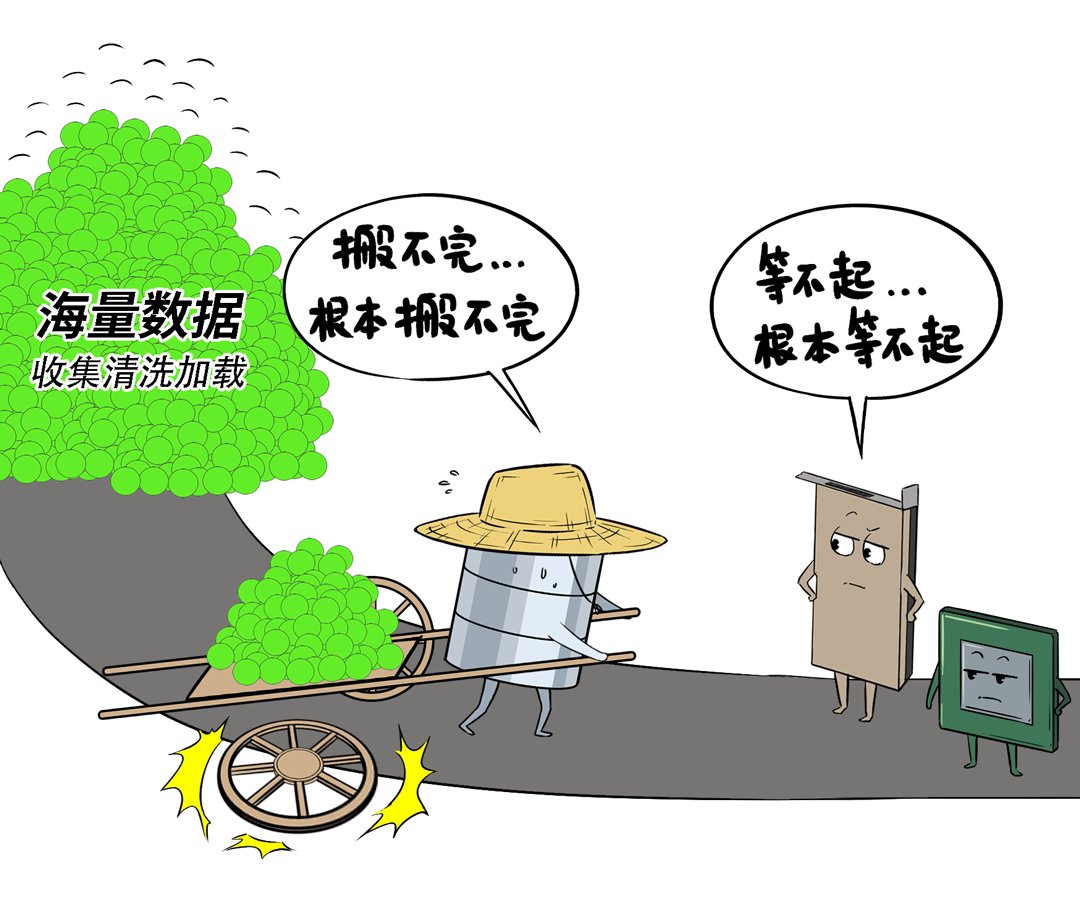

大模型的训练和推理,其实本质就是→海量数据处理的过程。我们先了解一下,大模型训推过程中,是如何处理数据的↓

这五个环节,是计算与存储高度耦合的过程,也被称为:半计算半存储型任务。比如,数据预处理和加载环节↓

原始数据采集量动不动就是PB级,要求存储高并发读取,一秒要加载几GB碎片小文件,还得边读边处理(ETL),传统存储跟不上节奏。

比如,Checkpoint加载与保存环节训练中断是家常便饭,关键是能基于Checkpoint快速恢复,不用从头再来。

此时,需要高速读写、近GPU存储、纳秒级延迟,而传统存储写入速度慢,导致断点恢复慢。

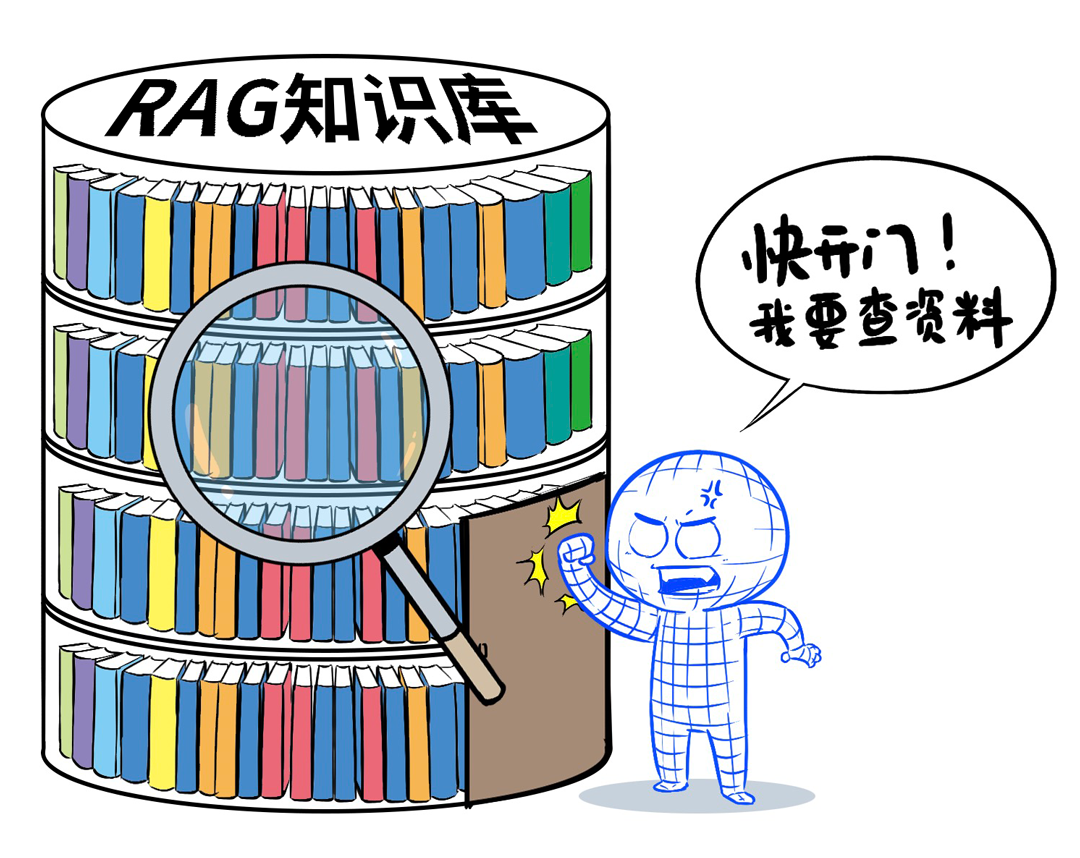

推理前需要快速对知识库完成向量或语义检索,查得慢,回答就会慢半拍。这需要低延迟向量检索、高QPS、小文件快速读取能力。而这一切,对于传统存储来讲,都太吃力了老季正讲着,甲方的技术人员举手提出了问题↓老季暗笑,正中下怀啊。

“大模型时代,存储不能只是‘仓库’,必须升级成一个——智慧物流系统,能调度、会加速、搬得快。AI场景讲究的是数据流动性,不是堆硬盘。”

看这听众们还一脸茫然,老季不再卖关子,开始亮剑——“以前我也走过弯路,被毒打了,现在终于知道怎么选了”。曙光重塑的AI存储架构,就好比“三层智能物流系统”。就是完全匹配大模型训推不同阶段对数据的不同要求,用三级架构分而治之,该海量的海量,该高速的高速,该直通的直通。大家看看大模型训练推理过程中不同数流转路线就秒懂了。这种架构设计,可以保证每种操作,都按照最优的快递路线,从而获得最好的投递结果。讲到这儿,气氛热了,甲方团队开始七嘴八舌的问问题。这是个好问题!但老季没立即回答,他顿了顿,看向甲方领导。

甲方领导眉头紧锁,清了清嗓子,问出了第一个问题↓

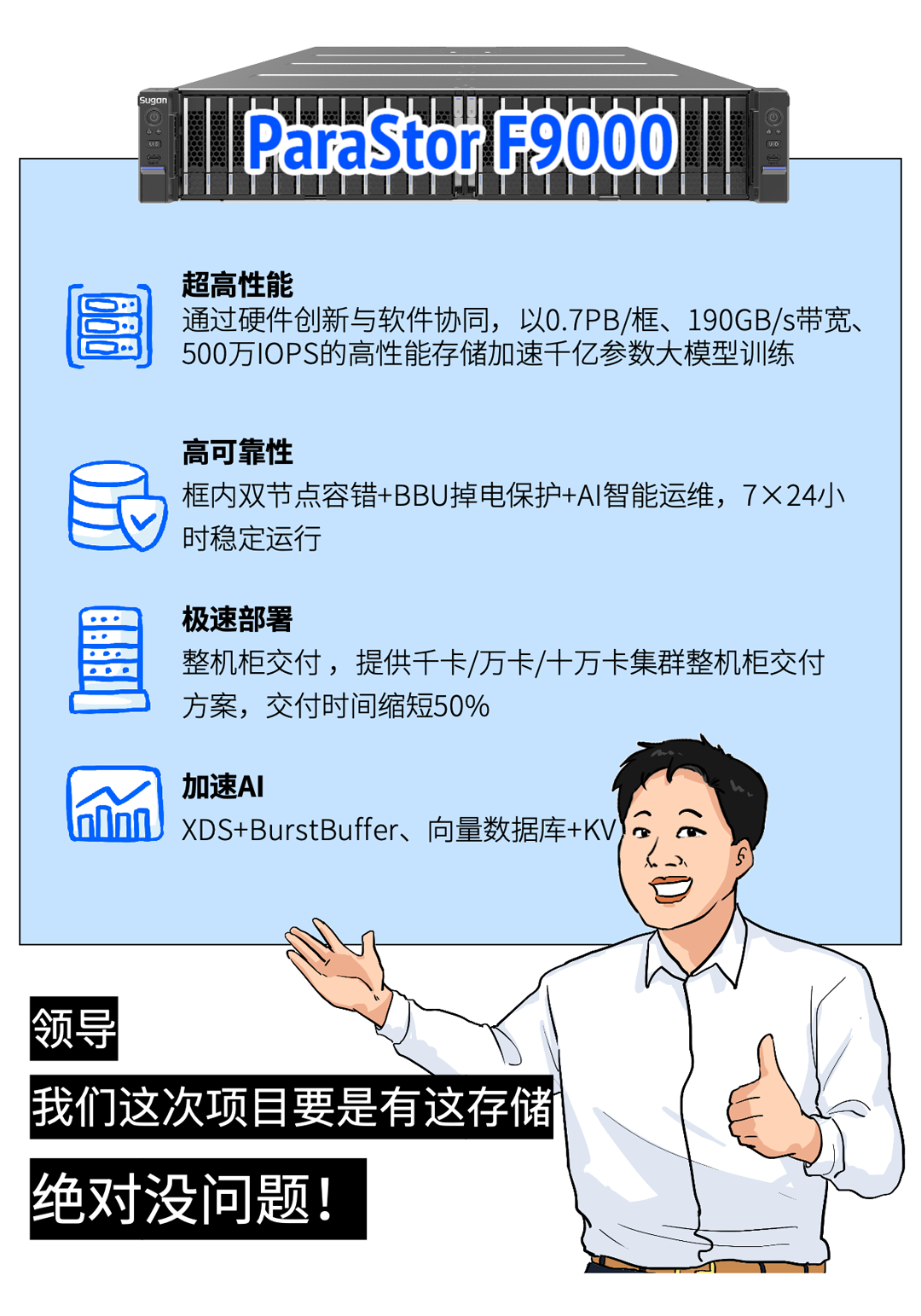

那必然选曙光ParaStor F9000系列!

这是一款干大活的AI存储,特别适合:大模型训练、高并发推理。

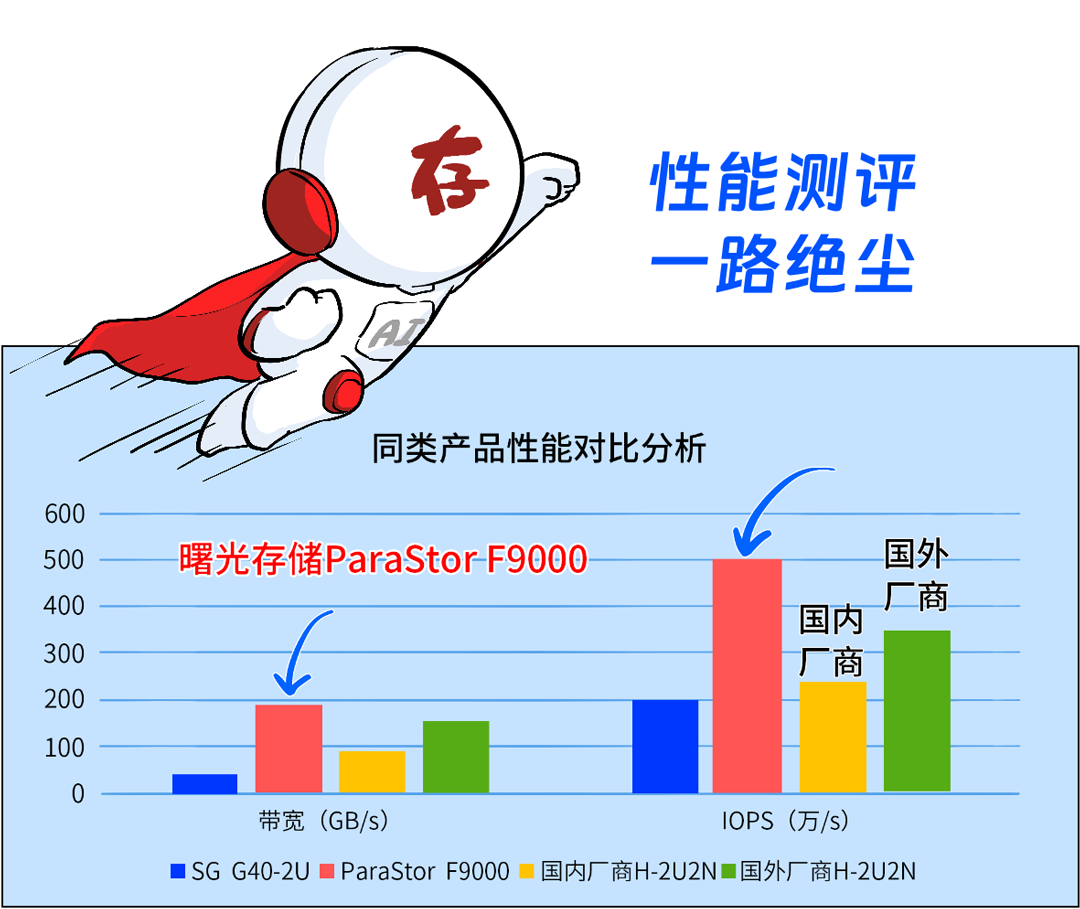

看性能参数,你就知道这是一款为大模型而生,真正扛AI重活的主力军。

ParaStor F9000性能实在太优秀了,直接卷哭国内外同行!为啥F9000这么猛?

核心就在于它不是拼某个指标,而是对真实AI场景进行过深度适配,搞了一个AI存储三级协同方案。

也就是说,F9000真正把前面所说的「三级物流体系」给落地了。

芯片级协同:网络(IB / RoCE)、CPU、内存和NVMe闪存做了全对称均衡设计,每条IO走的都是:最优路径。软硬件协同:首创“数据编排技术”,将内存、网络、NVMe按照CPU核均分,实现带宽/IOPS/时延按需可调。AI应用协同:关键数据直通GPU显存、向量检索与KV Cache专项加速、BurstBuffer本地加速技术等。这时候,甲方负责这个项目的技术主管抛出了个新问题↓

老季点点头,当然,用户收益有三点:

①以存提算,能让GPU满负荷运转,利用率直接翻倍

存储效率上来了,训练数据秒级加载、Checkpoint分钟级恢复,训练周期大幅缩短。②以存代算,为GPU分担计算任务

比如在KV Cache、RAG检索阶段,GPU只管“输出”,存储来“记忆+查资料”,大大提升了推理速度。

以万卡集群为例,每花1块钱在存储,至少能换回10块钱的GPU算力收益,因为曙光AI全闪存储能GPU利用率提升1倍+。老季的话音刚落,甲方领导又提出了第二个问题。在今年2月25日的SPC-1 V3测试榜单上,它直接干到了依托亿级 IOPS 和毫秒级低延时,可将 token 生成延迟降低高达 80%,整体效率提升超过 50%。讲完了“干大活的 F9000”、“极速飞行的 FlashNexus”,老季正要歇口气。甲方领导又开始发问了——老季早有准备——

那必然选曙光ParaStor S6000系列!

现在大模型需要的数据存储容量越来也大,动不动就是几百TB、几PB,要存模型参数、训练日志、版本文件、推理数据、清洗数据、原始数据…老季推荐这款存储,理由就就两点:

首先,存得多,成本低

单柜支持1.44PB超大容量,24TB× 60盘位,4U空间就能搞定,容量密度提升 70%,省机房、省电、更省钱。

第二,有策略、不乱存

S6000能实现【冷热分层+智能调度】:热数据自动放到 NVMe,读写快;冷数据全进 SATA/SAS,存得省。

这些都是通过智能调度,实现冷热数据无感流动。

几个回合下来,甲方领导听的津津有味,紧锁的眉头也展开了,笑呵呵地又问了一个问题。老季点点头,确实!这年头,大家不仅要存储性能和容量,还越来越关心数据管理。

以前这些问题,基本靠猜。

现在曙光存储提供一张图,让你纵观全局数据流动!

每一步的数据流动路径、存储位置、冷热分布,全都一目了然。

就这样,项目复盘会在剑拔弩张中开始,却在谈笑风生中结束。最终,客户认识到原有存储的问题,果断追加了预算,并单一来源采购了曙光AI存储。半个月后,项目顺利上线,用老季的话讲:体验爽到飞起,终于扬眉吐气!

阅读原文

跳转微信打开