微軟昨(1)日公布最新一代小語言模型(SLM)推理版本Phi-4-Reasoning系列,包括Phi-4-reasoning、Phi-4-reasoning-plus和最小的Phi-4-mini-reasoning,強調效能比美參數量大的模型。微軟預告,新模型之後將會用於支援Copilot+ PC的AI功能。

這是微軟自去年4月公布輕量模型Phi-3後最新進展。Phi-3今年1月推進到Phi-4,並開源140億參數版本。隨後一個月又發表了Phi-4多模態模型。

最新的Phi-4-reasoning為140億參數的開源權重推理模型,是以Phi-4為基礎,利用OpenAI o3-mini示範作為訓練資料,以監督式微調訓練而成。它能有效運用推論時的額外運算資源來生成詳盡的推論串,context length為32k token。而Phi-4-reasoning-plus則是以Phi-4-reasoning為基礎強化學習訓練,比起Phi-4-reasoning,能用更多推論時運算資源,並使用1.5倍的字詞(token)量來提供更準確的回應。

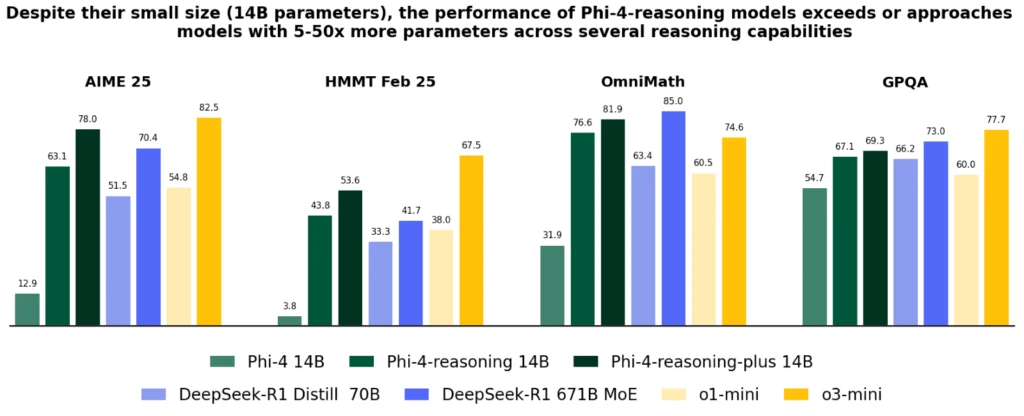

微軟說,Phi-4-reasoning運用精心安排的訓練資料和高品質的合成資料集,可展現媲美大模型的效能。根據微軟提供的AIME 25、HMMT Feb 25、OmniMath及GPQA等標竿測試數據,Phi-4-reasoning比起Phi-4明顯進步,而在推理及能力如數學、程式、解決演算問題與規劃中,都超越DeepSeek-R1 Distill 70B,而且逼近DeepSeek-R1 671B MoE。同時間,二個模型在AIME 25及GPQA測試略遜o3-mini,但OmniMath測試表現卻雙雙超越。

圖片來源/微軟

Phi-4-reasoning及Phi-4-reasoning-plus在所有項目都超越OpenAI-o1-mini。Phi-4-reasoning家族和DeepSeek-R1 671B MoE相比,則是勝負各半。

目前二款模型已在Azure AI Foundry及Hugging Face開放。

微軟還公布了Phi-4-mini-reasoning,是一輕巧的transformer-based語言模型,利用DeepSeek-R1模型的合成資料,包括從中學到博士等級數學題目訓練而成,可以說專為數學推理優化。Phi-4-mini-reasoning參數量僅3.84B,支援128k context length,適合教育、教學應用,也能輕易在筆電等邊緣裝置或是行動裝置上執行。雖然規模小巧,但微軟搬出數據顯示,Phi-4-mini-reasoning在常見數學標竿測試超越參數量二倍大的模型如OpenThinker-70B、Bespoke-Stratos-7B、DeepSeek-R1-Distill-Qwen-7B與DeepSeek-R1-Distill-Llama-8B,甚至在Math-500測試中超越OpenAI o1-mini。

Phi-4-mini-reasoning也在Azure AI Foundry、Hugging Face上公開。

微軟表示,Phi模型已經用於Copilot+ PC上,像是經過為NPU優化的Phi Silica變種已用在支援Click to Do等AI功能。微軟預告,Phi-4-reasoning和mini版都會針對Phi Silica的低位元優化(low-bit optimizations)進行調整,目的是讓它們能夠直接在新一代PC的NPU上執行。這意謂它們不再完全依賴雲端資源,而是能本地運作,提高AI回應的速度與隱私保護。