豆包之前几天更新了图片的超能创意 1.0 模式,试了一次,给我整麻了。

图片生成的门槛再次大幅降低,而且效率高了超级多。

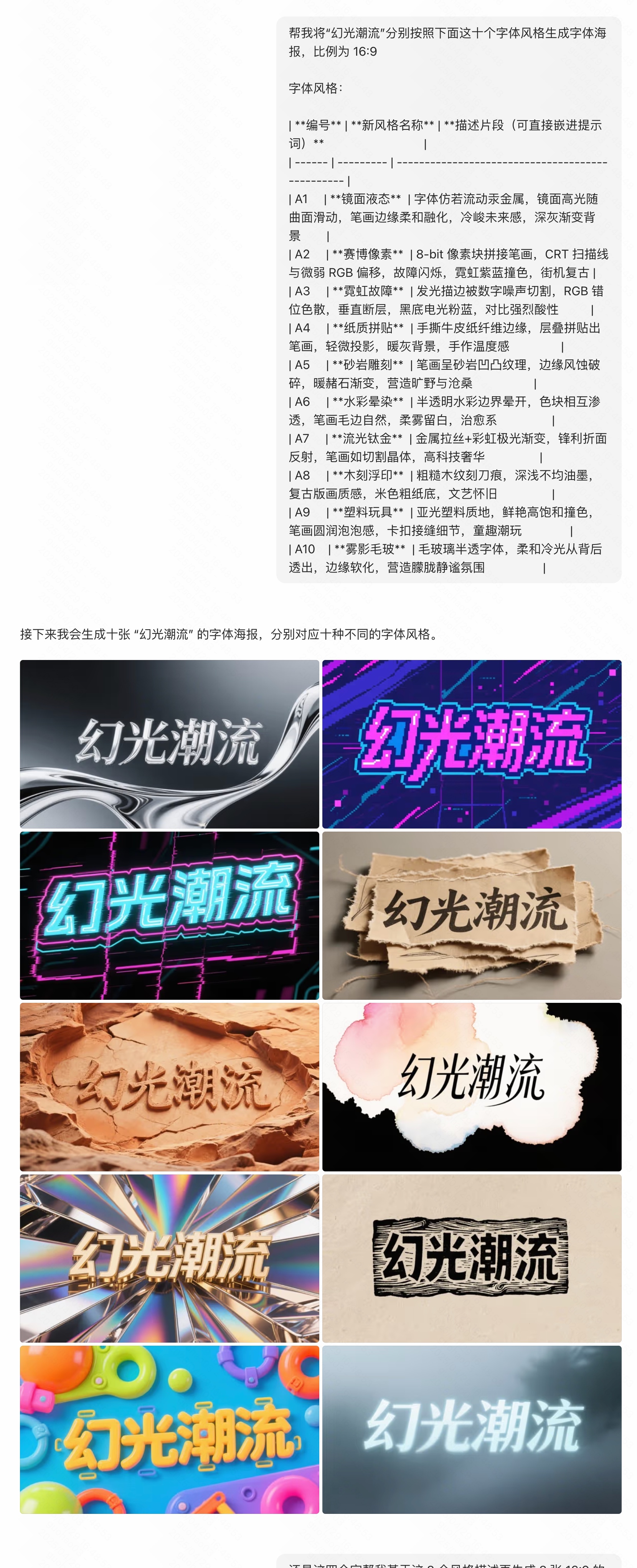

这个例子,他直接从LLM 模型拿到了这些知识然后还按照要求改了提示词。

太离谱了,而且这十张图片的生成速度比 4o 一张都要快很多。

下面是详细测试👇

我测试完总结了一下这次的升级主要是三个部分:

智能增强:图像模型可以使用 LLM 的智能,提示词可以不用写的很细,一些知识模型自己知道;

上下文理解:你可以连续对生成的图片进行修改和调整;

批量生成:支持批量生成不同的图片,比如不同比例相同提示词的或者相同提示词不同比例的图片。

我们先来看一下批量生成能力:

支持不同内容和比例的批量生成,对提示词的理解和响应都非常好,而且速度非常的快。

你可以让他针对同一个设计生成不同比例的社交媒体图片,也可以基于同一个内容给你不同的风格图片。

智能增强

之前 3.0 图像模型相较于 4o 最大的问题是你的提示词需要写的很细,模型不会联想和获取知识,这次超能创意更新之后这不再是问题。

你可以给他一个案例让他自己发散其他的案例,而且一些常识性内容你不需要说他也知道,看图片的 logo 样机和Q 版茶饮品牌门店例子。

上下文理解

现在豆包的图片生成可以记住上次的东西基于上一张生成的结果进行修改,也可以跟豆包一起探索和碰撞新的创意。

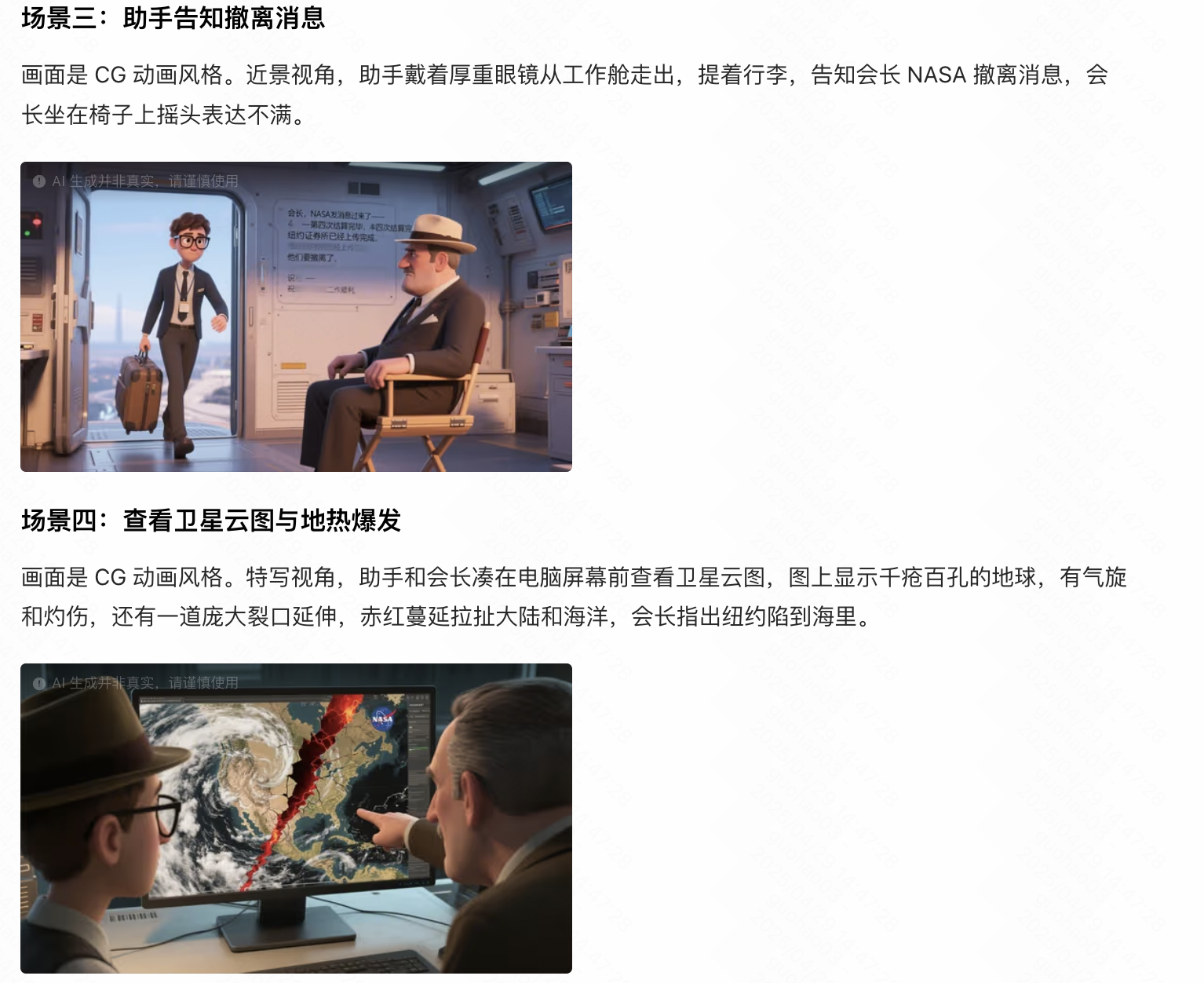

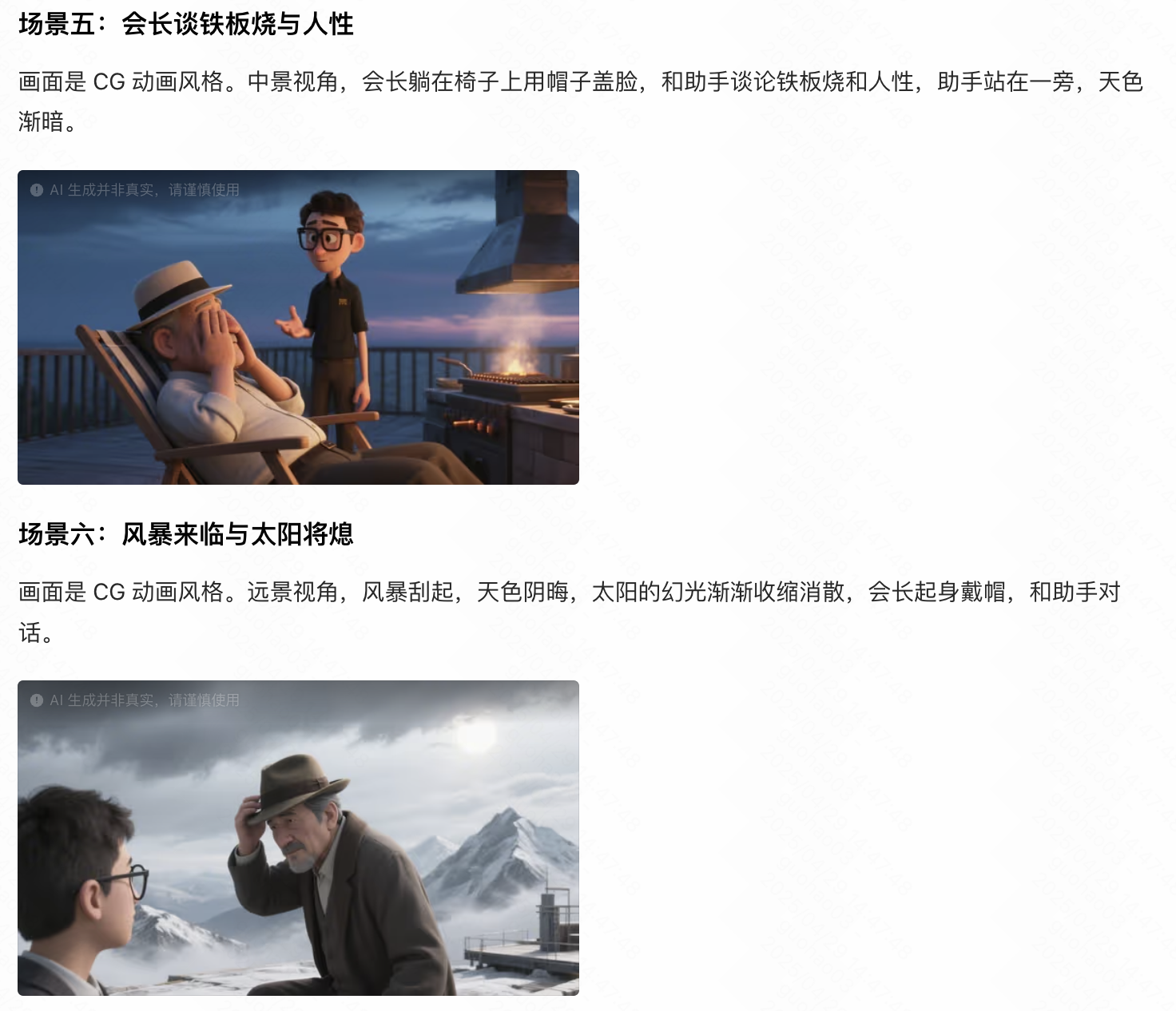

最强的使用场景是直接从小说内容转换分镜图片

甚至不需要说任何提示词只需要提供内容就行,这个太强了。

可以看到下面几个连续的分镜人物的穿着和形象都是可以保持一致的。

好了这次的体验和测试就是这些,希望能够对你有些启发。

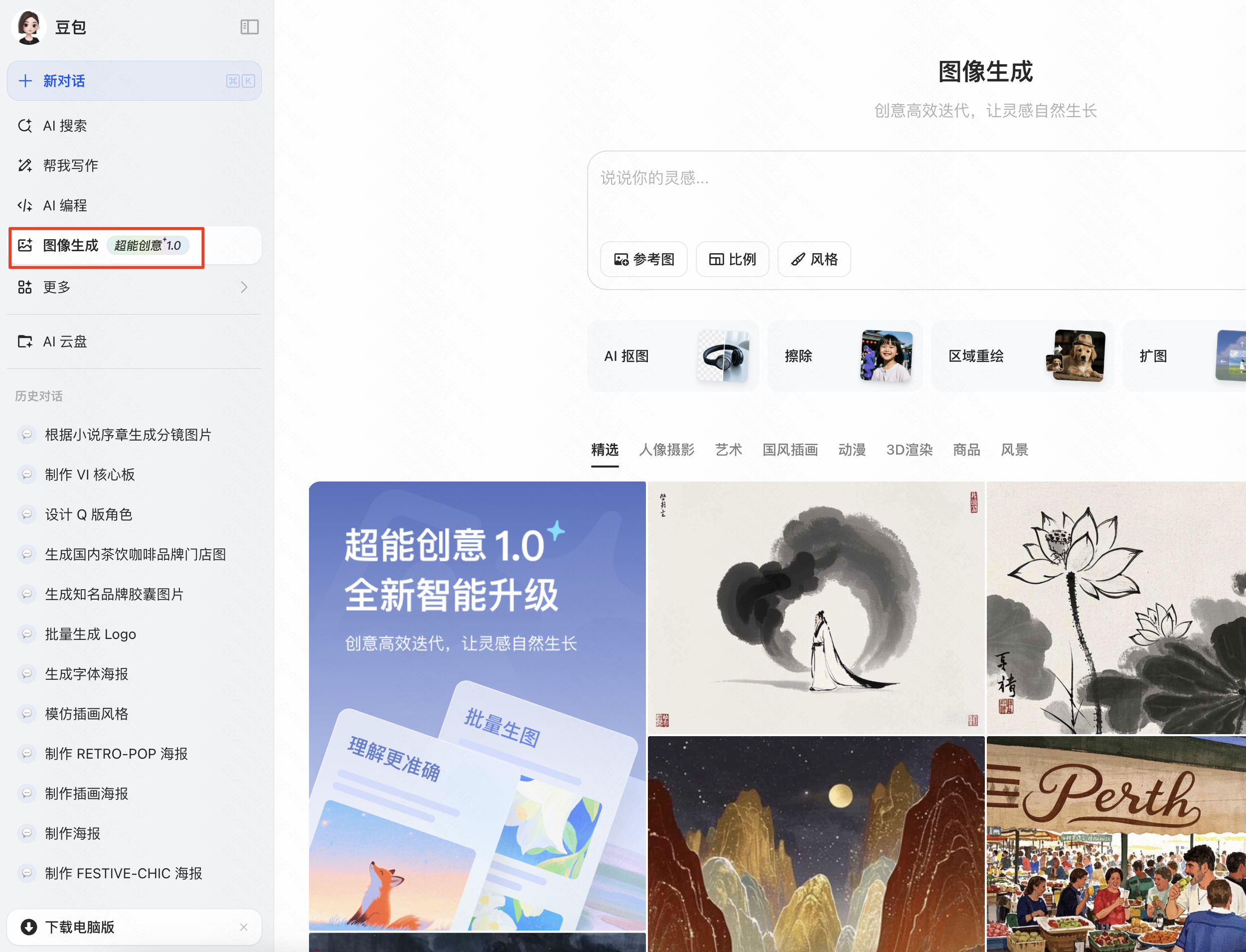

功能在豆包左侧导航的图片生成部分使用,如果有超能创意就是可以用了