大型语言模型(LLMs)在边缘设备上的部署日益增多,为AI和实时服务带来便利。然而,LLMs参数量巨大,对设备内存和计算能力要求高,限制了其应用。低比特量化技术通过压缩模型、减少内存需求,提高了运行效率。混合精度矩阵乘法(mpGEMM)技术支持不同精度数据相乘,如int8*int1等,在速度、内存效率和计算准确性之间实现平衡。尽管硬件支持仍有局限,但这些进步为LLMs在边缘设备上的高效运行提供了重要支持。

📱LLMs边缘部署需求:大型语言模型越来越多地部署在智能手机、笔记本电脑和机器人等边缘设备上,以支持高级AI和实时服务。

💾低比特量化优势:低比特量化技术通过压缩模型、减少内存需求,为LLMs在资源受限的边缘设备上运行提供了解决方案,提高了运行效率。

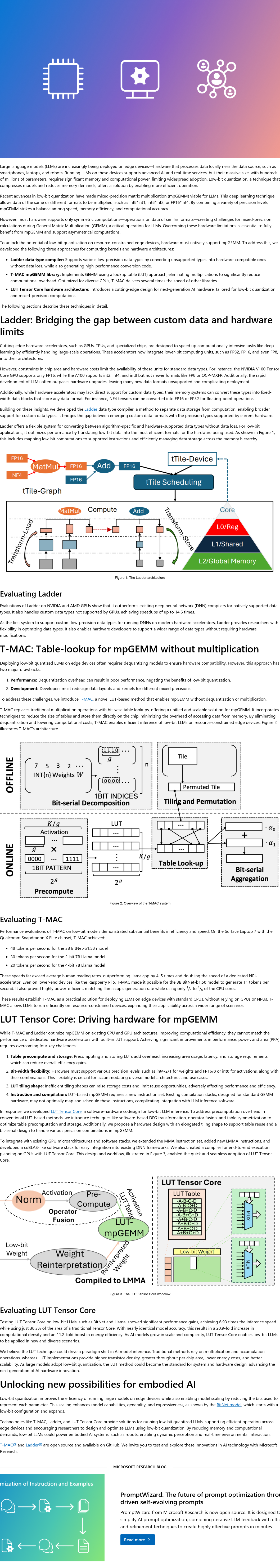

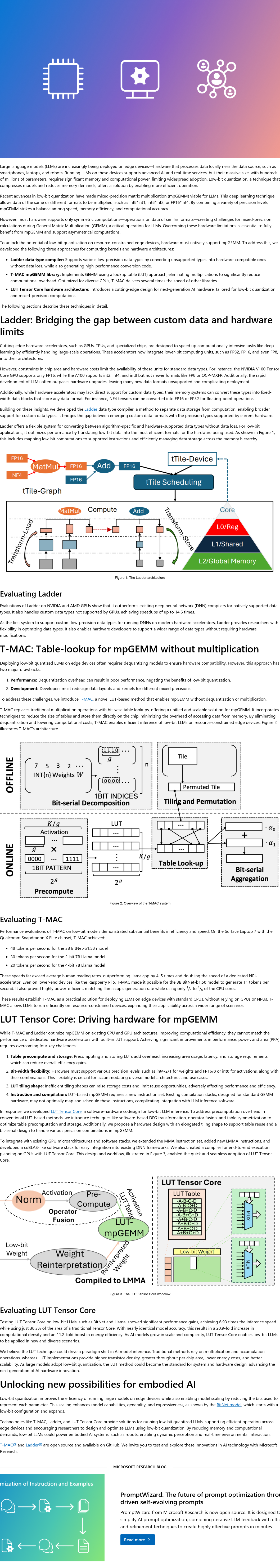

🧮mpGEMM技术特点:混合精度矩阵乘法(mpGEMM)技术允许不同格式的数据相乘,例如int8*int1、int8*int2或FP16*int4,从而在速度、内存效率和计算准确性之间取得平衡。

🛠️硬件支持局限:目前大多数硬件仅支持对称计算,这限制了mpGEMM的全面应用,未来需要进一步的硬件改进以充分利用mpGEMM的潜力。

大型语言模型(LLMs)正越来越多地部署在边缘设备上,如智能手机、笔记本电脑和机器人等,这些设备可在数据源附近本地处理数据,支持高级AI和实时服务。然而,由于LLMs参数量巨大,对内存和计算能力要求高,限制了其广泛应用。低比特量化技术通过压缩模型、减少内存需求提供了解决方案,使操作更加高效。近期进展使得混合精度矩阵乘法(mpGEMM)成为可能,该技术允许不同格式的数据相乘,例如int8*int1、int8*int2或FP16*int4,通过结合多种精度水平,在速度、内存效率和计算准确性之间取得平衡。但目前大多数硬件仅支持对称计算,这限制了mpGEMM的全面应用。尽管如此,低比特量化和mpGEMM的进步为LLMs在边缘设备上的高效运行提供了重要支持。

本专栏通过快照技术转载,仅保留核心内容

内容中包含的图片若涉及版权问题,请及时与我们联系删除