多个业务微调模型部署,面临成本和管理复杂的挑战

现如今,LoRA 微调技术已经成为许多公司提高模型性能的重要方法。实验表明,针对特定任务进行 LoRA 微调,尤其是在开源基础模型上,可以显著超越像 GPT-4 等闭源模型的效果。

越来越多的企业开始采用 LoRA 微调技术,为特定任务量身定制高效的 AI 模型。例如,在招聘行业,可以针对不同的面试环节,如提问、追问和答疑来训练专门的定制模型。

然而,想要让模型在实际业务场景中发挥最佳效果,就需要不断进行微调和优化,并且逐一部署。多个场景的 LoRA 微调模型会带来更高的复杂度和成本。

100个业务微调模型部署难题:费钱、费时、费力

了解大模型部署的朋友都知道,部署 100 个 7B LoRA 微调模型需要面临巨大的算力、人力以及时间成本。按照传统部署方案,使用开源推理框架,通常需要:

部署周期:部署 100 个 LoRA 微调模型需经历算力申请、审批和 GPU 资源协调等多个环节。根据经验,整个流程可能耗时长达 1 周。

如何解决这些问题,这里分享一个案例。

企业0卡投入下,1小时内轻松部署100个7B微调模型

特别推荐使用在以下场景:

业务场景多样化:业务场景较多,并且每个场景都需要根据其特定数据进行微调生成一份自己的大模型。

调用量较小:每个业务场景的调用量相对较少,那么单独为每个场景部署一份大模型的成本将显得很高。

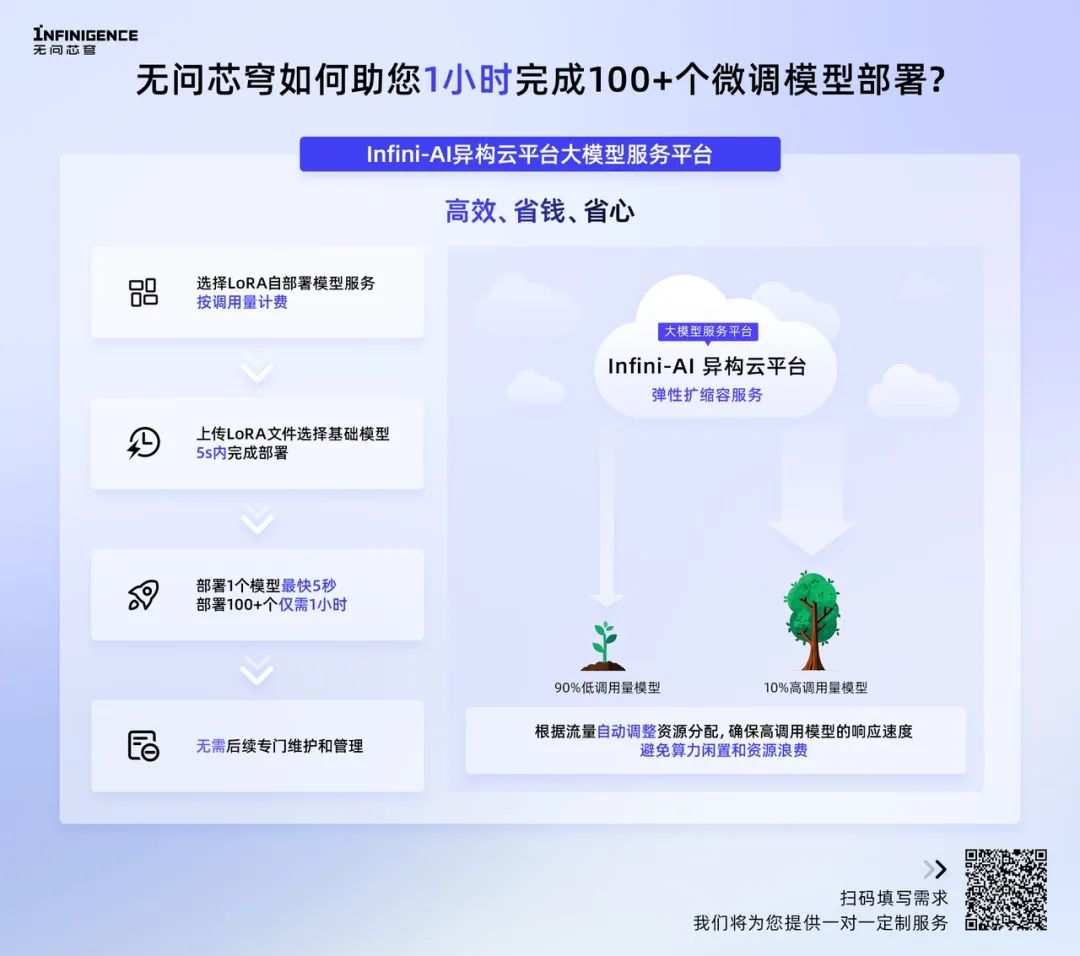

1. 模型部署像API一样简单,降低部署复杂性

3、根据流量自动调整资源分配,资源最大化

我也有需求,希望有定制解决方案

无问芯穹成立于 2023 年 5 月,由清华大学电子工程系教授、系主任汪玉教授发起,清华大学电子系博士毕业的夏立雪任联合创始人和 CEO。

无问芯穹Infini-AI异构云平台·大模型服务平台「LoRA自部署模型服务」为企业提供了一种操作极简、成本低的部署方式,让模型落地将不再受高昂部署成本、低资源利用率以及反复部署的困扰。

扫码或点击阅读原文 提交需求,无问芯穹会一对一对接您的需求!

内容中包含的图片若涉及版权问题,请及时与我们联系删除