核技术等技术治理经验为人工智能治理路径提供了“他山之石”

2024年8月19日,兰德公司发布了国土安全、刑事司法、情报界和武装部队的科技政策等方面的技术专家Michael Vermee撰写的报告《可以为人工智能治理提供信息的历史类比(Historical Analogues That Can Inform AI Governance)》。作者指出了人工智能治理是当前不能回避的课题,讨论了二战以来与人工智能治理面对类似困境的核技术、互联网、加密产品和基因工程的治理模式,最后总结了既有新兴技术与人工智能技术的异同以及为人工智能治理可以提供的治理经验。

首先,作者强调了人工智能(Artificial Intelligence, AI)治理具有紧迫性,多方利益相关者愈加关注人工智能潜在福祉和风险治理。人工智能可能对社会产生诸多负面影响,如导致就业机会削减、在重大决策中嵌入偏见,以及由于误导信息和社交媒体操纵的加剧导致社会凝聚力的减弱;AI技术的发展与国家在经济和军事领域占领制高点密切相关,使得技术发展较为落后的国家可能面临国家安全风险;以及,以生成式AI和大型语言模型为代表的先进人工智能还可能对人类的生命和福祉造成诸如生物或核武器相关的威胁。这些对AI技术的担忧推动了政府和其他多方利益相关者开展了人工智能治理的实践探索。政府层面,美国政府在2023年发布了一项广泛的行政命令,阐明了人工智能系统开发和使用的原则和优先事项;美国商务部通过对前沿AI模型所需的硬件进行出口管制以维持美国在AI领域的优势地位,此外,美国政府还寻求在人工智能军用方面达成国际共识。多方利益相关者层面,部分利益相关者基于其他新兴技术的历史治理经验提出了治理方案,比如OpenAI创始人Sam Altman建立成立类似国际原子能机构的AI治理国际机构,有学者将AI技术视为互联网技术,呼吁采取“拥抱开放性、透明度和广泛访问”的治理方式,还有学者认为AI技术等同于基因工程技术,呼吁暂停某些人工智能领域的工作。

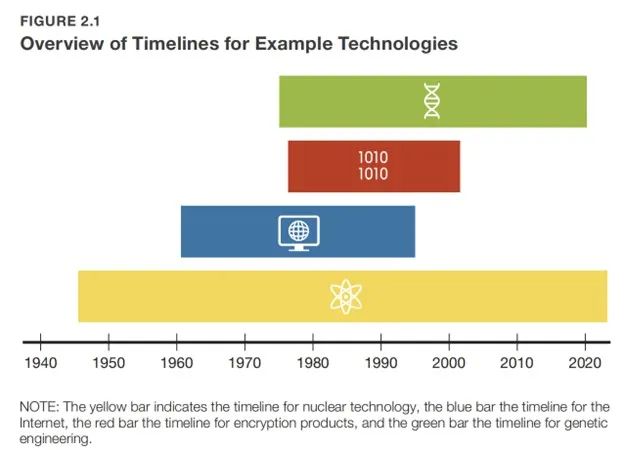

其次,作者为了更好地制定AI治理地方案,分别梳理了核技术、互联网、加密产品和基因工程所对应的治理路径。(如Figure 2.1)

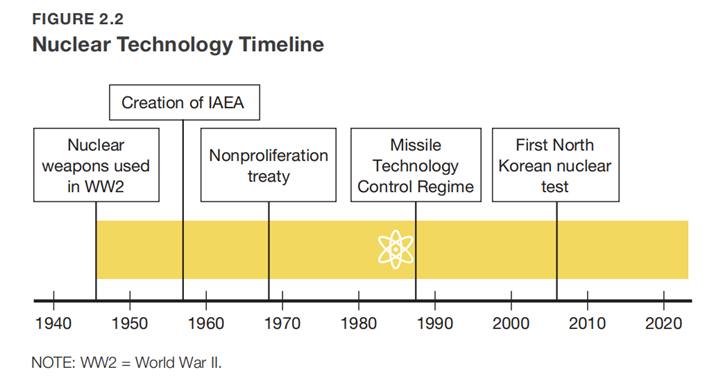

就核技术而言,对于核技术扩散的担忧是推动核技术的治理机制演变的动力。除了1968年签订的《核武器不扩散条约》之外,核技术的治理还采取了其他的治理实践(如Figure 2.2):第一,成立了超国家组织国际原子能机构(International Atomic Energy Agency, IAEA)并达成了相关的“原子促进和平”倡议,该组织可以拥有核材料,并通过传播相关知识实现和平利用核技术的目标。第二,设立无核区,限制核武器的部署点。第三,推动签署《全面禁止核试验条约》。第四,监管和限制核裂变材料的进出口。第五,限制核武器运载系统的运输。上述治理模式取得的明显成效,首先,自二战结束以来的近八十年内,核武器没有在战争中被使用;其次,尽管国际社会有几十个国家具备制造或获取核武器的能力,但实际上真正拥核的国家只有十个,其中,南非资源拆除了核武库,核武器并未如当初预料般广泛扩散;再者,当前的国家行为体能够和平利用核能的技术的能力,有力地避免了核战争并减缓了核武器技术的扩散。然而,核技术治理模式的缺点在于发生核武器冲突的风险依然存在,一些拥核的国家或计划拥核的国家通过对其武器库进行现代化改造以规避国际条约的制约,从而对国际安全产生威胁。

核技术治理历程

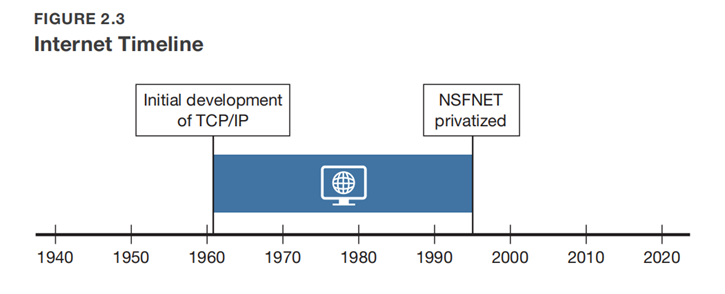

就互联网治理而言,其采用了由私营部门主导、公私部门相互合作的治理模式,政府为治理提供资金并促进技术的发展,而私营部门则为治理的具体实践者(如Figure 2.3)。首先,互联网技术的治理根植于一种实验主义的、以协作和创新为主的治理理念与文化,在该文化下,互联网被定义为“一个全球信息系统”,该系统使用“互联网协议(Internet Protocol, IP)”进行连接,支持使用传输控制协议(Transmission Control Protocol, TCP)或互联网协议进行通信,并在相关通信基础设施上提供高层服务。其次,随着互联网的发展,其发展了名为“请求意见稿(Request For Comments, RFCs)”的一种分享观点的开放、非正式的方法,并通过美国能源部、美国国家航空航天局以及由国家科学基金会(National Science Foundation, NSF)资助的多个公共和私人TCP或IP网络发展壮大。第三,随着互联网治理国际合作的需求增加,NSF指示其区域网络寻求商业和非学术客户的参与,以利用规模经济降低成本,同时其还采取了刺激私人部门开发、拥有和运营长途网络的措施。最终,互联网治理的最终形成依托诸如互联网工程任务组(The Internet Engineering Task Force, IETF)、互联网研究任务组和万维网联盟等组织的开放、协作,同时还有其他私营实体的参与共治的模式。这一由私营部门主导的治理模式的显著缺陷在于其限制了政府维护自身利益的能力,比如IETF曾经拒绝了美国政府修改协议以方便合法获取通信内容的请求。

互联网治理模式演变

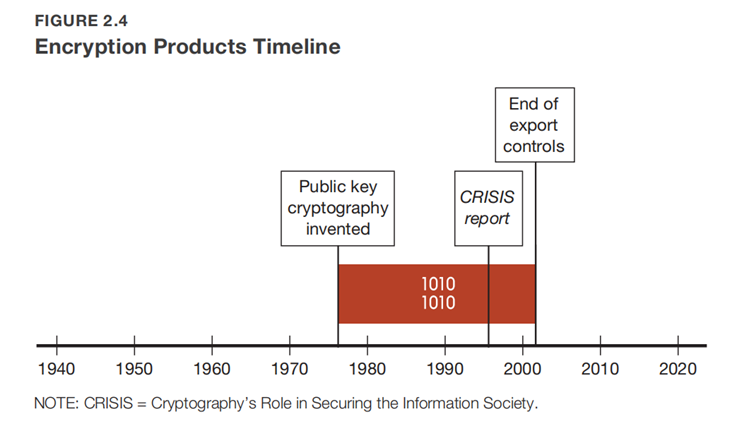

就加密产品而言,其代表了学术界和私营部门与国家和公共部门由达成共识到分歧凸显的负面治理案例,加密产品的治理模式经历了由公私部门达成共同规范到规范分异的历程(见Figure 2.4)。首先,随着美国国家安全局(National Security Agency, NSA)的工作人员对密码学在国际上得到广泛传播的担忧加深,NSA在说服NSF停止资助密码学研究的失败,NSA与NSF等政府部门开展了合作,并与学术界就多方利益相关者的关切进行沟通,使得加密产品治理在前期呈现出国家与私营部门在与密码学相关的研究、审查和决策方面的规范达成了共识。其次,在共同规范下,加密产品的属性归类与弹药相当,强加密的产品还受到国家安全审查和出口管制,高于某一强度的加密产品或未提供密钥豁免的产品则不能在国际市场上销售。与此同时,加密技术与美国民众生活的融合度越来越高,加密产品的商业应用越来越广泛,而对其的限制损害了美国信息技术行业的主导地位与竞争力,因而,美国的私营部门与政府在加密技术治理上产生了较大的分歧。第三,1996年美国国家科学院发布的《密码学在保护信息社会中的作用》标志着加密产品治理体系的结束。纵观加密技术治理历程,其治理失败的原因有三:其一,尽管强加密技术在全球范围内的扩散受到了限制,但仍有一些恶意行为者可能利用治理漏洞获取技术;其二,美国的加密技术政策严重损害了美国软件行业的经济效益,使得美国企业缺少市场份额,进而引发了私营部门和政府的对立;其三,美国内部私营部门和公共利益部门的规范冲突使美国国家安全部门丧失了公信力,同时,美国政府的出口管制也限制了国内对于加密产品的使用和获得,进而引发了更多的诸如网络安全等问题。

加密产品的治理历程

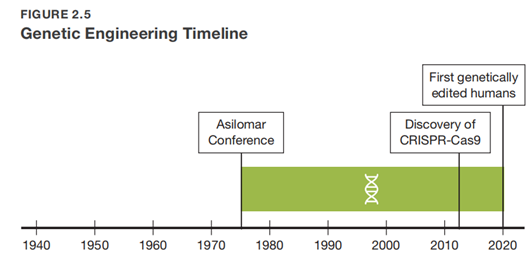

就基因工程而言,其采用的以私营部门和社会部门为主体、通过设置和开展国际会议,并创造性的发展“暂停”措施的治理模式被广泛视为在面对不确定风险时成功的技术治理案例(如Figure 2.5)。首先,20世纪70年代初,彼时前沿的基因工程技术表现为充足和改进“DNA(DeoxyriboNucleic Acid, DNA)”,并使得通过不同生物体的片段创建新的DNA序列。尽管这项技术有助于带来巨大潜在利益,但科学家们对该技术相关的风险非常担忧。因而,初期的基因工程技术治理呈现为科学家在更好地理解所研发技术的风险之前自愿暂停实验的形式;美国的科学家们还成立了一个小型科学家委员会以讨论这项技术的潜在风险,并进一步召开国际会议解决相关问题。其次,1975年在加利福尼亚州太平洋格罗夫举行的所谓阿西洛马重组DNA会议标志着该技术的治理模式进入轨道化、机制化阶段,具体表现为该会议确定了是否解除科学家的自愿暂停以及如何安全地继续进行相关研究的主题,参会的人员不仅包括了生物技术领域的科学家,还包括律师、记者、政府官员和国际科学代表团等多方利益相关者。2013年开发的更精确、更强大的基因编辑工具CRISPR-Cas9技术也采用了类似的治理模式。纵观基因工程技术的治理演变,尽管最初各方行为体广泛遵守了“暂停”措施,与此同时国际社会加速达成共识并制定适当的指导方针和风险管理措施,最终形成了“由科学共同体设计技术安全应用的指导方针、多方共同参与”的既定模式,然而,全球人类基因组编辑的政策仍然呈现严重分裂的现状,第一个基因编辑人类则是治理失败的例子。

基因工程的治理历程

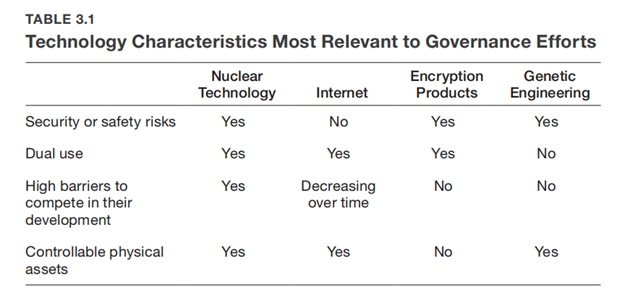

第三,作者指出了这四种新兴技术与AI的相似之处,并指出最有效的AI治理方法将取决于未来的特征,例如进入该领域所需的资源、有效控制物理或非物理资产的能力、AI的主要用途、它所带来的安全风险,以及在这些风险上形成共识的能力。(如Table 3.1)

核技术与AI技术的相似之处有三:其一,人工智能和核技术都具有和平用途与军事应用两种属性,同时,在冲突中可以提供战略性和不对称的优势。其二,这两种技术在技术和专业知识方面都有极高的门槛。其三,这两种技术都被视为对全球构成灾难性风险、甚至对人类构成生存威胁的技术。然而,核技术与AI技术仍存在差异,其中的差异导致了核技术可能带来的的灾难性风险比人工智能更加具体,同时对于核技术的治理,即防扩散本质上是对核技术相关的有形资产的治理,而以大语言模型为代表的人工智能技术产品本质上为非有形资产。互联网技术与AI技术的相似之处有二:其一,这两种技术都可以是信息和通信技术。其二,这两种技术主要是为非军事用途开发的,而且治理尚未由政府部门主导。但互联网技术与AI技术存在显著差异:互联网的起始阶段并没有直接威胁到人类安全和国家安全,而人工智能从一开始就居于其对人类安全和国家安全具有安全威胁的话语背景下。尽管互联网治理拥抱开放和透明度的规范值得AI治理学习,但采用这种治理模式的行为体可能需要解决人工智能重大风险等相关问题,其可能也不适用于那些不共享该规范的竞争者和对手的人工智能发展。加密技术与AI技术有两点相似之处:其一,这两种技术的产品都为“非有形资产”;其二,这两种技术都是商业和军事双重用途的,因此美国政府对这两种技术都有合法的国家安全担忧。然而,其存在两点相异之处:其一,加密产品的开发最初是由公共部门为维护国家安全开始的,商业用途的应用在后期才得以显现。其二,加密产品传播的国家安全风险可能小于目前考虑的人工智能风险。考虑到这些相似之处和差异,加密产品的治理表明,形成对技术治理规范的共识对治理的成功至关重要,并且政府发现很难治理与加密产品相关的非有形资产,因而政策制定者应警惕任何严重依赖于控制诸如软件或模型的非有形资产的治理机制。基因工程与AI技术存在三点相似之处:其一,私营部门的参与者主导了开发,但技术治理依赖国家和国际机构来制定指导原则。其二,研究人员和技术开发者通常是指出这些技术风险的人,这些风险包括安全、伦理和国际竞争相关的风险。其三,人类基因编辑和人工智能的商业环境存在研发资金丰厚、收益预期巨大和国际参与和研究兴趣广泛的共同特点。然而,其也存在不同之处:其一,重组DNA技术和人类基因编辑不是双重用途技术;其二,基因工程几乎总是涉及对物理实体的管理,如细胞培养或人体试验,而这些涉及物理实体的工作有严格的法律和法规来有效指导、监控和控制这些工作;其三,基因工程研究人员对技术的实质性风险有广泛共识,而对于人工智能则不存在类似的共识。因而,在没有就必须解决的风险达成共识的情况下,人工智能开发和研究的暂停令不太可能成功。

最后,作者根据人工智能治理可能出现的三类场境提出治理建议。第一,当人工智能对人类造成广泛且严重的风险时,即人工智能的使用需要大量资源,并涉及可以被监控和控制的有形资产,在该场景下可以借鉴参考核技术的治理模式,要求各利益相关方就AI技术的安全目的达成共识,同时可以成立类似国际原子能机构的国际组织促进AI技术负责任的发展,并分享人工智能带来的利益。第二,当人工智能带来较小的发展风险时,即人工智能在开发过程中面临的风险很少,且竞争障碍较低,但可能对政府和人类福祉带来重大风险的情况下,互联网治理可能是人工智能治理的一个有用类比。政府可以将治理权委托给私营部门,比如委托给围绕共享规范和基于共识的标准建立的社区和组织,从而在达成共识的基础上进行治理。第三,当人工智能面临的竞争障碍较少,但对政府和人类福祉带来显著风险时,可以以加密产品的治理模式为鉴戒。在政府能够控制有形资产的情况下,可以参考借鉴对有形资产进行治理的路径;在危险的人工智能模型可以利用通用计算硬件轻易创建的情景下,类似于基因工程的治理模型可能更加有效,AI技术的治理可以通过形成或加强公私合作伙伴关系,从而调解特定类型人工智能开发或应用的治理。