index_new5.html

../../../zaker_core/zaker_tpl_static/wap/tpl_guoji1.html

![]()

讲座讨论大模型产生组合幻觉的原因,如何预测未发生的幻觉现象及消除幻觉,还探讨了模型幻觉与泛化的关系及应对方法,报告嘉宾为张雨季。

🎯大模型在全部正确的训练数据上仍产生幻觉,讲座将深入探讨其本质原因,如训练过程中数据不平衡导致模型产生组合幻觉。

💡通过大量实验和分析,揭示了大模型组合幻觉和泛化之间的强关联性,这让我们重新思考如何达到二者之间的平衡。

🛠基于思考,详细介绍了基于自对比解码的幻觉预测及消除方法,以找到适合消除幻觉同时保持大模型智能的方法。

报告主题:幻觉即泛化,知识掩盖导致大模型的组合幻觉

报告日期:8月20日(周二)10:30-11:30

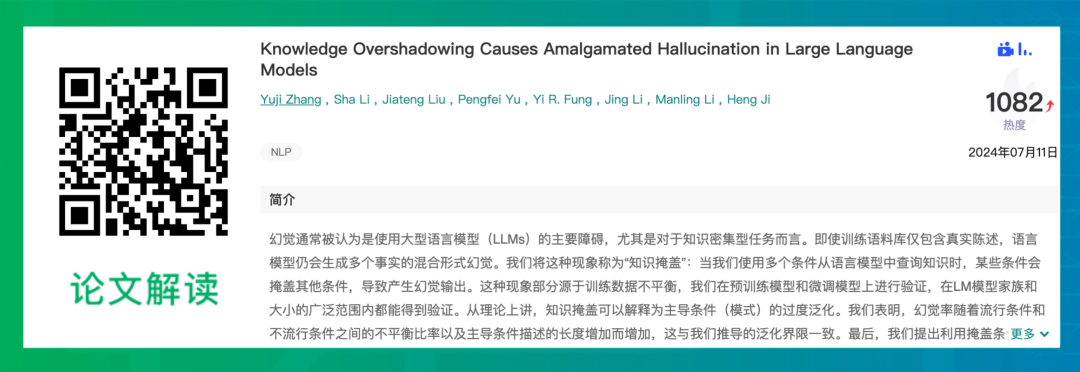

为什么大语言模型在全部正确的训练数据上仍会产生幻觉?本次讲座会详细地讨论大模型产生组合幻觉的本质原因,并会讨论我们如何利用这一发现预测尚未发生的幻觉现象,以及如何使用无需训练的测试时间方法消除大模型组合幻觉。本次讲座将深入讨论我们如何发现并验证了训练过程中无处不在的数据不平衡导致模型产生组合幻觉这一现象,以及不同的模型大小,句子长度,不平衡程度和大模型幻觉的量化关系。通过大量实验和分析,我们揭示了大模型组合幻觉和泛化之间的强关联性,这一发现的重要之处在于长久以来我们认为大模型的强泛化是其高度智能的重要来源,而本文发现的幻觉和泛化之间的强关联性使得我们开始重新思考如何达到大模型泛化和幻觉之间的平衡,以及什么样的方法才是适合消除幻觉同时保持大模型智能的方法。基于这些思考,我们会详细介绍本文提出的基于自对比解码的幻觉预测以及幻觉消除方法。张雨季,香港理工大学(PolyU)的计算机博士研究生,同时是伊利诺伊大学香槟分校(UIUC)季姮教授组的访问学者。她的主要研究方向为如何在不断发展变化的现实世界中使得语言模型仍能够快速学习适应新知识并保持强健可信的语言能力,以及如何从理论角度诠释并改进语言模型的运作机制。她曾在EMNLP/ACL等顶级会议发表多篇论文。

扫码报名