报告主题:超越人类的二级推理,揭秘大语言模型推理机制

报告日期:8月15日(周四)10:30-11:30

扫码报名

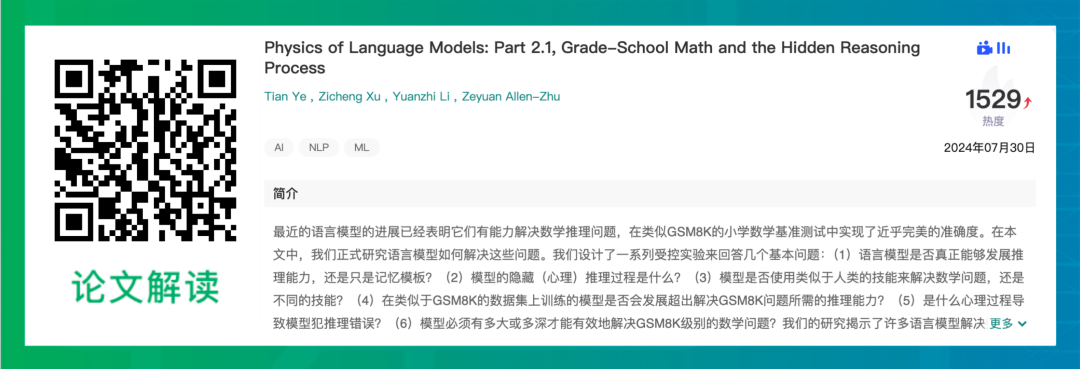

🎯语言模型在小学数学测试题集上有高准确率,引发对其推理能力的探讨,是真正推理还是依赖答题模板记忆需研究。

🧐研究语言模型内在推理过程,了解其解决数学问题的方式,以及是否采用类似人类的技巧。

🔍探讨在特定数据集上训练的模型能否学到超出解决该数据集问题所需的推理技巧,还有导致模型推理错误的原因。

📏研究模型有效解决数学问题所需的规模或深度,以深入理解大语言模型的推理机制。

报告主题:超越人类的二级推理,揭秘大语言模型推理机制

报告日期:8月15日(周四)10:30-11:30

扫码报名

AI辅助创作,多种专业模板,深度分析,高质量内容生成。从观点提取到深度思考,FishAI为您提供全方位的创作支持。新版本引入自定义参数,让您的创作更加个性化和精准。

鱼阅,AI 时代的下一个智能信息助手,助你摆脱信息焦虑