来自奥本大学和阿尔伯塔大学的研究人员发现,最先进的具有视觉能力的大型语言模型(VLMs)在理解涉及基本几何形状的空间信息方面表现得非常糟糕,例如判断两个圆是否重叠。他们提出了一个名为BlindTest的新基准测试,包括7项简单任务,这些任务在互联网上自然语言中不太可能有现成答案,以测试VLM像人类一样“看见”图像的能力。

现有的VLM基准(如MMMU和ChartQA)涵盖了广泛的主题,但输入图像并非总是回答问题所必需的,即答案可能仅从文本问题和答案选择中推断出来,或由模型从互联网规模的训练中记住。出于这个差距并受到验光师对人类进行视觉敏锐度测试的启发,作者设计了7个涉及二维几何原型的低级视觉任务。然后他们测试了在现有多模态视觉基准中排名最高的四个VLM——GPT-4o、Gemini-1.5 Pro、Claude-3 Sonnet和Claude-3.5 Sonnet。对于每个任务,他们用两个语义上等同得不同问题提示VLM。任务和结果如下:

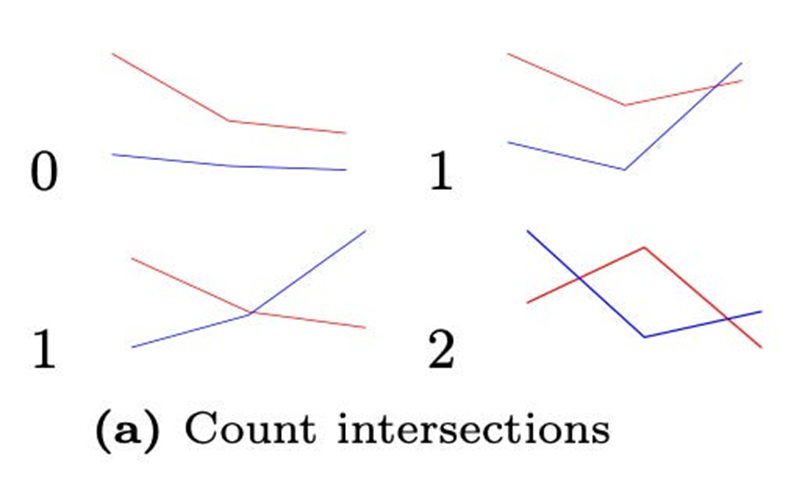

1、计数线的交叉点

在150张包含两条有颜色的图像中,它们恰好在0、1或2点相交,最佳准确率是77.33%(Sonnet-3.5),最差是48.67%(GPT-4o)。

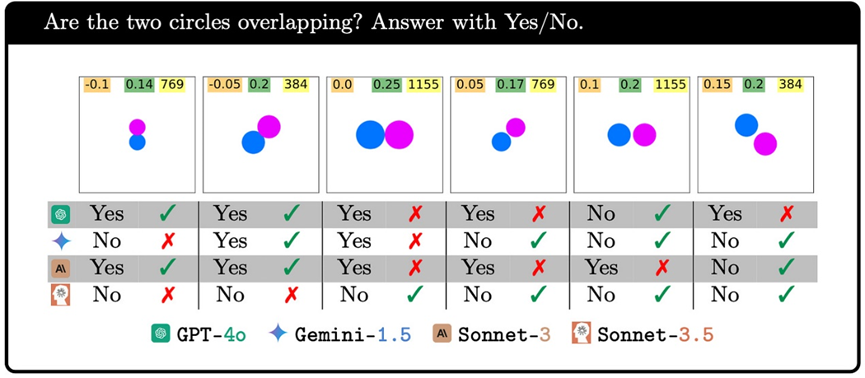

2、两个圆重叠或接触

在672张两个大小相等的圆重叠、相切或分离(具有方向和大小变化)的图像中,最佳准确率是92.78%(Gemini-1.5),最差准确率是72.69%(依然是GPT-4o)。此外,当两个圆靠得很近时,性能往往会下降。

3、字符串中的带圆圈字母

一个红色椭圆叠加在字符串中的某个字母上。作者测试了三个字符串——Acknowledgement、Subdermatoglyphic和一个随机字符串tHyUiKaRbNqWeOpXcZvM。Gemini-1.5(92.81%准确率)和Sonnet-3.5(89.22%准确率)比GPT-4o和Sonnet-3高出近20个百分点。除了GPT-4o,所有模型在两个英文单词上的表现略优于随机字符串,这表明知道单词可能有助于VLM做出更好的猜测。

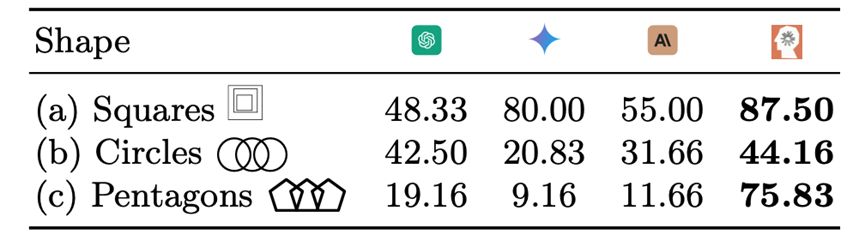

4、计数重叠形状

N个重叠的、同样大小的圆(N=5,6,7,8,9)像奥运会标志一样排列成两排。性能范围从20.83%(Gemini-1.5)到44.16%(Sonnet-3.5)。重复相同排列的五边形,性能差异更大,从9.16%(Gemini-1.5)到75.83%(Sonnet-3.5)。所有四个模型在计数5个圆时都100%准确,但在计数5个五边形时表现不佳(除Sonnet-3.5外)。

5、计数嵌套正方形

2到5个正方形嵌套在一起,每个形状完全在另一个形状内部。Sonnet-3.5的最佳准确率为87.5%。GPT-4o和Sonnet-3在计数仅2或3个正方形时就表现不佳。

6、计算网格的行数和列数

VLM很难计算空网格中的确切行数和列数,最好的模型(Sonnet-3.5)准确率为59.84%,其余模型的准确率为25-26%。然而,在每个单元格中添加一个单词显著提高了所有模型的性能。例如,GPT-4o的准确率从26%提高到53%,提高了一倍多。

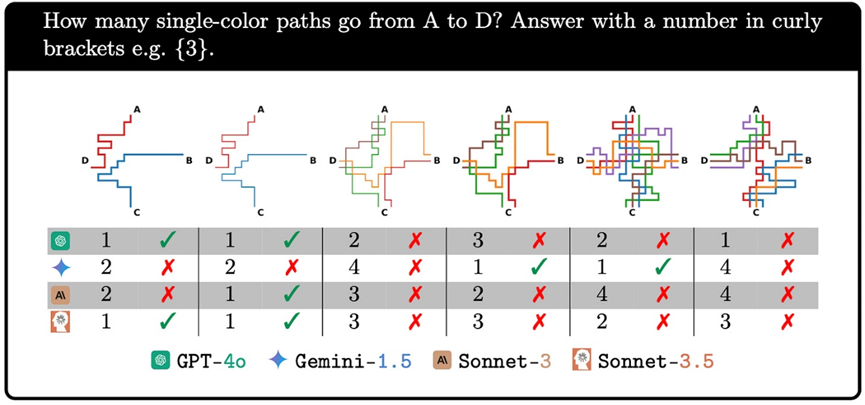

7、跟踪单一颜色的路径

最后一个任务要求模型计算简化地铁图中两站之间独特颜色路径的数量。“令人震惊”的是,作者发现即使只有一条路径时,也没有模型达到100%准确率。随着地图复杂性的增加,大多数VLM的表现更差。

总体而言,BlindTest基准测试首次为VLM提供了低级视觉健全性检查。它们在这些简单(对人类而言)的无需任何先验知识的任务上的表现令人失望,与它们在现有视觉基准上的令人印象深刻的表现形成对比,这些基准存在数据泄漏问题。解决VLM的这些局限性可能是一项不小的挑战,并且可能有助于解决多模态模型已知的其他视觉缺陷,如理解物体的方向。

权益福利:

1、AI 行业、生态和政策等前沿资讯解析;

2、最新 AI 技术包括大模型的技术前沿、工程实践和应用落地交流(社群邀请人数已达上限,可先扫码加小编微信)

源于硅谷、扎根中国,上海殷泊信息科技有限公司 (MoPaaS) 是中国领先的人工智能(AI)平台和服务提供商,为用户的数字转型、智能升级和融合创新直接赋能。针对中国AI应用和工程市场的需求,MoPaaS 在业界率先推出新一代开放的AI平台为加速客户AI技术创新和应用落地提供高效的算力优化和规模化AI模型开发、部署和运维 (ModelOps) 能力和服务;特别是针对企业应用场景,提供包括大模型迁移适配、提示工程以及部署推理的端到端 LLMOps方案。MoPaaS AI平台已经服务在工业制造、能源交通、互联网、医疗卫生、金融技术、教学科研、政府等行业超过300家国内外满意的客户的AI技术研发、人才培养和应用落地工程需求。MoPaaS致力打造全方位开放的AI技术和应用生态。MoPaaS 被Forrester评为中国企业级云平台市场的卓越表现者 (Strong Performer)。

END

▼ 往期精选 ▼

3、MoPaaS魔泊云受邀参加2024全球人工智能技术博览会

▼点击下方“阅读原文”!