本论文研究了机器学习和优化中两个不同但重要的主题。

第一个主题将过度参数化的神经网络与较小的网络的特征进行比较。第 2 章介绍了一种比较过度参数化网络和较小网络特征表达能力的方法。使用这种方法,它发现较小的网络无法完全捕捉过度参数化网络的特征,而这些特征是过度参数化网络性能优越的原因。本章还通过一个玩具问题证明了某些特征只能通过过度参数化网络来学习。

论文的第二个主题集中在优化昂贵的黑盒函数和有限的评估。在第 3 章中,提出了一种称为 KGLQ 策略的新策略,它使用二次函数在局部近似真实函数,并通过将其建模为不同于测量噪声的异方差噪声来整合结构偏差。这种方法解决了在存在参数模型的情况下使用信息值策略时出现的问题。本章评估的几个测试问题证明了,与现有的小预算策略相比,KGLQ 策略的表现更具竞争力。第 4 章介绍了一种利用 KGLQ 背后概念的全局置信模型。开发了一个分层置信模型,通过考虑全局置信模型的各种估计水平来产生近似值。使用此分层模型,开发了 HKGLQ 策略,并证明其渐近收敛。与渐近收敛策略相比,测试问题上的实验提供了有关 KGLQ 在较大预算下的表现的见解。

论文题目:From Learning to Optimal Learning: Understanding the Impact of Overparameterization on Features of Neural Networks to Optimal Learning of Expensive, Noisy Functions Using Low-Dimensional Belief Models

作者:Duzgun, Ahmet Cagri

类型:2023年博士论文

学校:Princeton University(美国普林斯顿大学)

下载链接:

链接: https://pan.baidu.com/s/1cy8mWQEvv8nHZ2iWWEuIJA?pwd=aicb

硕博论文汇总:

链接: https://pan.baidu.com/s/1Gv3R58pgUfHPu4PYFhCSJw?pwd=svp5

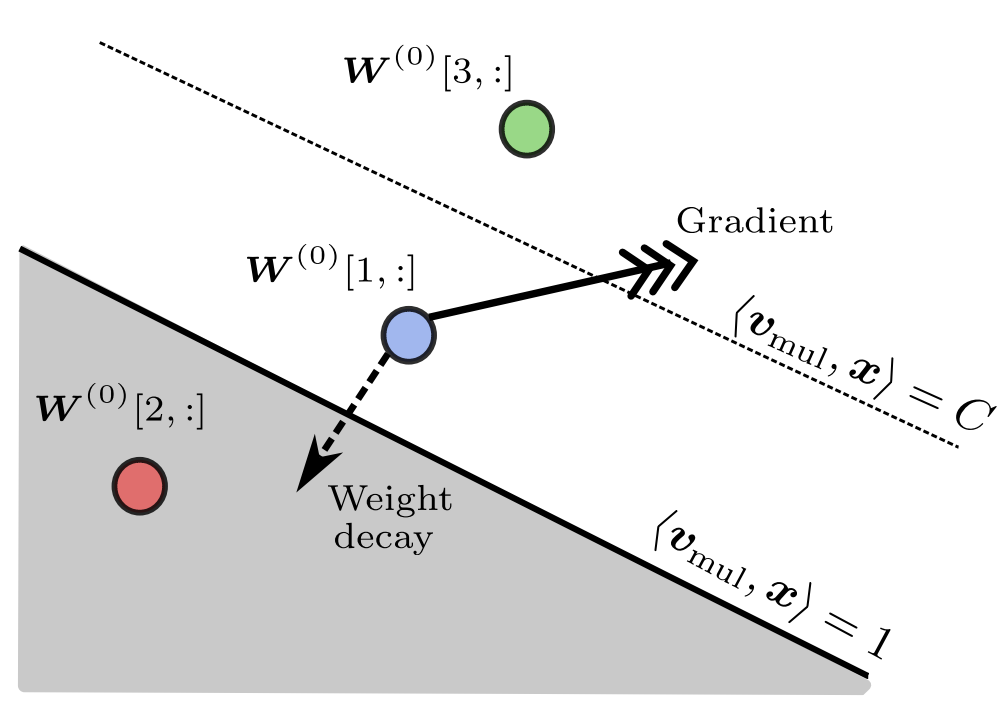

特征 x 初始化时神经元的激活。灰色和白色区域分别代表非激活区和激活区。如果 W(0)[2, :] 不在 x(或任何其他特征)的激活区内,则它不会学习 x(或任何其他特征)。W(0)[1, :] 和 W(0)[3, :] 都在特征 x 的激活区内,并且都可以学习特征 x。但是,W(0)[3, :] 更有可能学习特征 x,因为它距离激活超平面较远。另一方面,W(0)[1, :] 可能会因权重衰减的压力和梯度的弱信号而被停用,尤其是在训练早期梯度中存在更多噪声时。

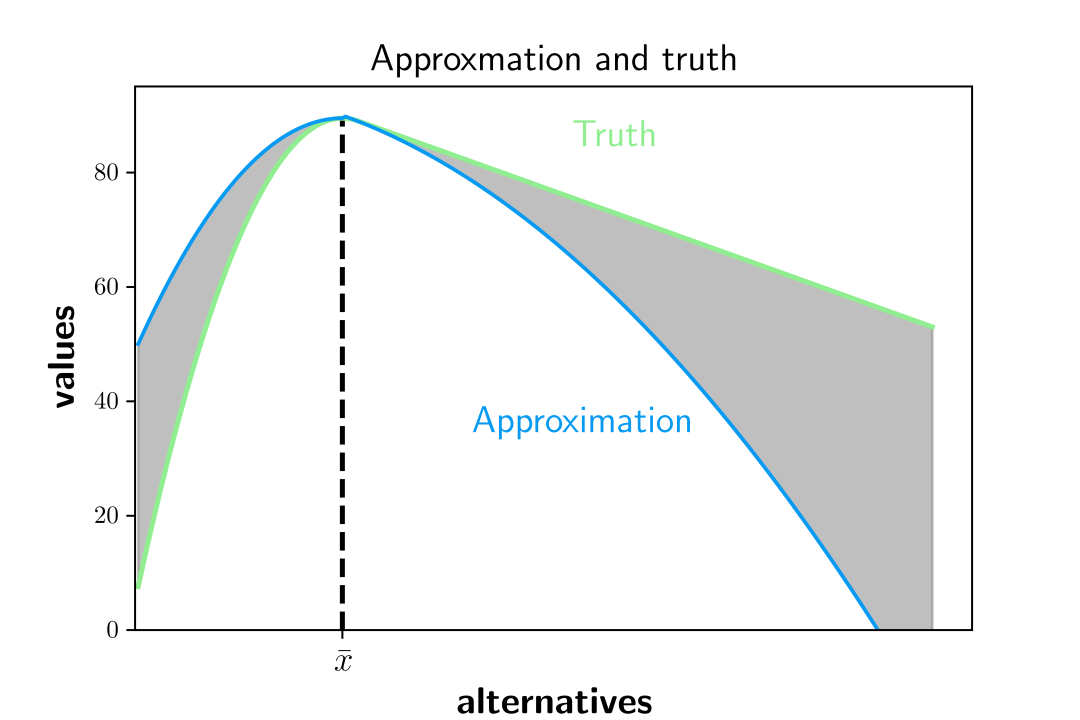

阴影区域表示真实值与近似值之间的差异。

微信群 公众号