面壁小钢炮新一代多模态模型 MiniCPM-V 4.0 现已开源。依靠 4B 参数,取得 在 OpenCompass、OCRBench、MathVista 等多个榜单上取得了同级 SOTA 成绩,且 实现了在手机上稳定、丝滑运行。此外,我们也正式开源了 推理部署工具 MiniCPM-V CookBook,帮助开发者面向不同需求、不同场景、不同设备,均可实现开箱即用的轻量、简易部署。

话不多说,先来看看 MiniCPM-V 4.0 在手机上运行的惊艳效果。作为最适合在手机上运行的模型尺寸,MiniCPM-V 4.0 以 4B 的参数量真正做到了稳定运行、快速响应,且在手机、平板等设备长时间连续使用无发热、无卡顿。

目前,可支持 MiniCPM-V 4.0 本地部署的 IOS App 已开源,开发者可在 CookBook 中下载使用。

Github: 🔗 https://github.com/OpenBMB/MiniCPM-o

Hugging Face: 🔗 https://huggingface.co/openbmb/MiniCPM-V-4

ModelScope: 🔗 https://modelscope.cn/models/OpenBMB/MiniCPM-V-4

CookBook: 🔗 https://github.com/OpenSQZ/MiniCPM-V-CookBook

4B 参数,综合性能达到同级SOTA

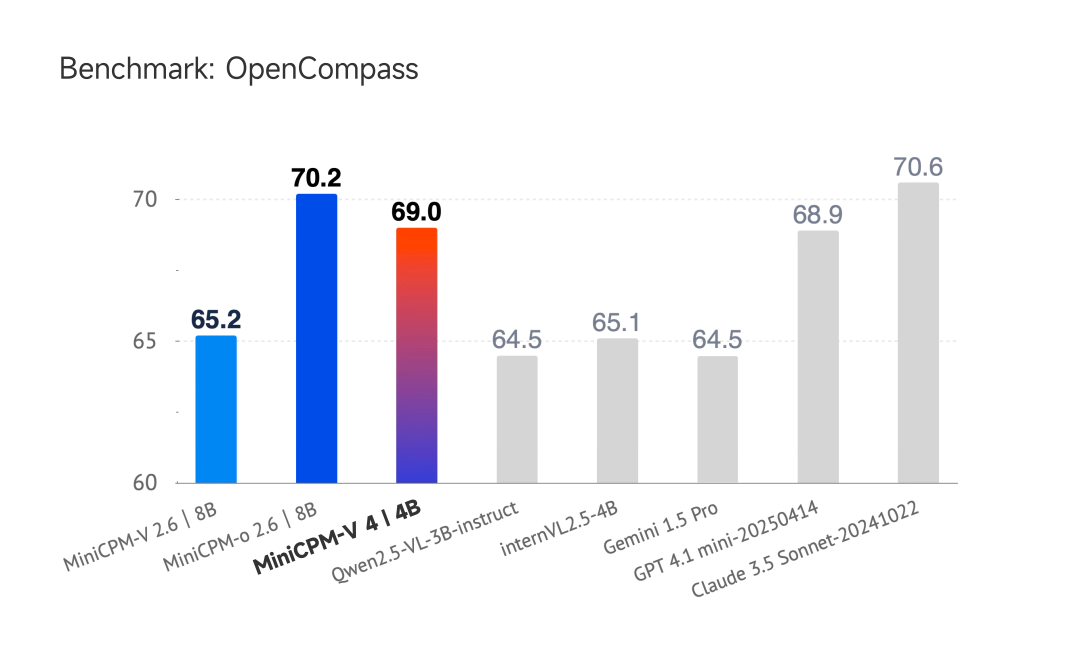

作为端侧多模态模型的新晋王者,MiniCPM-V 4.0 在 4B 参数量级的 PK 中,在单图、多图、视频理解等多模态能力上已达到同级 SOTA 级别。在 OpenCompass、OCRBench、MathVista、MMVet、MMBench V1.1、MMStar、AI2D、HallusionBench 等评测基准测试中,MiniCPM-V 4.0 综合性能均为同级最高。

其中,在 OpenCompass 测评中,MiniCPM-V 4.0 综合性能超过 Qwen2.5-VL 3B 模型和 InternVL2.5 4B 模型,甚至可比肩 GPT-4.1-mini、 Claude 3.5 Sonnet。相较于上一代 MiniCPM-V 2.6 的 8B 模型,MiniCPM-V 4.0 在 模型参数减半 的同时,多模态能力也实现了显著提升。

总的来说,MiniCPM-V 4.0 再一次验证了大模型“知识密度”定律 Densing Law,也再一次刷新了端侧多模态模型的能力上限。

低显存+快响应,打造端侧丝滑运行的模型标杆

之所以能在手机、PC 等端侧丝滑、流畅的完成实时视频理解、图像理解等任务,除了 MiniCPM-V 4.0 出色的效果以外,也得益于独特的模型结构设计,实现了同尺寸模型下可最快的首响时间与更低的显存占用。

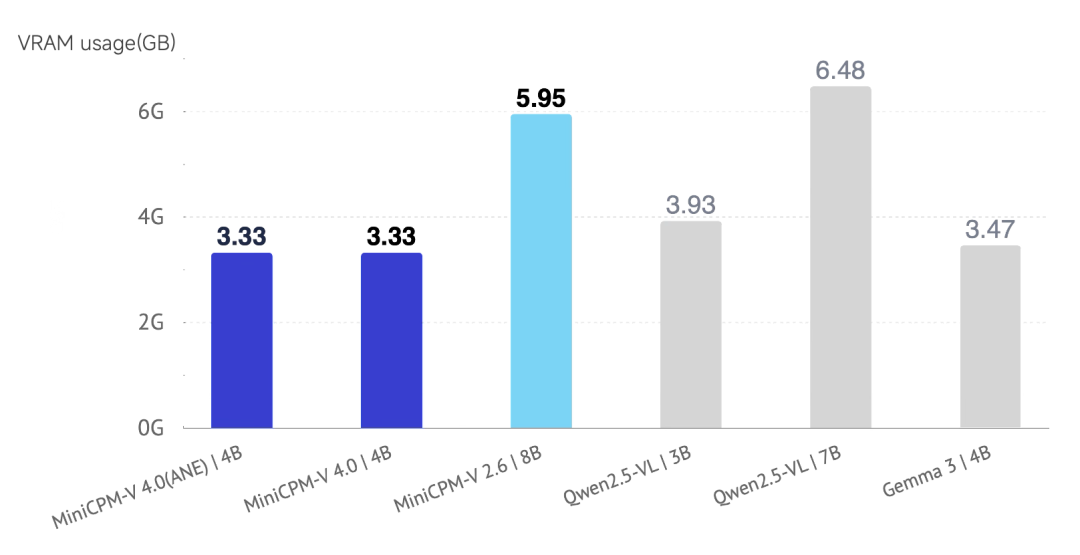

经在 Apple M4 Metal 上测试,正常运行 MiniCPM-V 4.0 模型,显存占用仅为 3.33 GB,比 Qwen2.5-VL 3B、Gemma 3-4B更低。

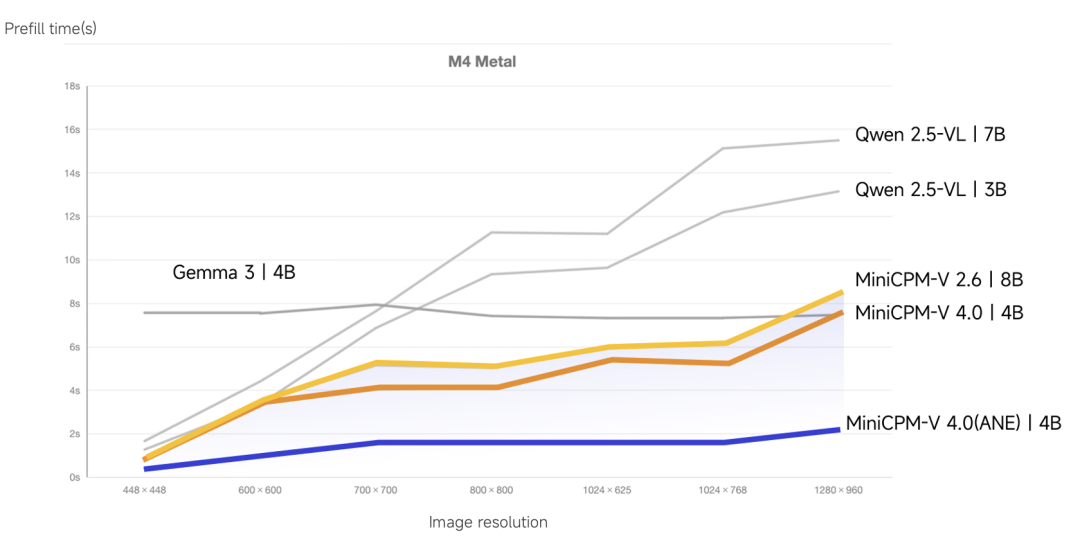

同样,在 Apple M4 Metal 上进行图片理解测试中,MiniCPM-V 4.0 模型借助 ANE + Metal 辅助加速,让首次响应时间大幅缩短,实现了同尺寸最佳,且随着输入的图片分辨率提高,首响时间快的优势更为明显。

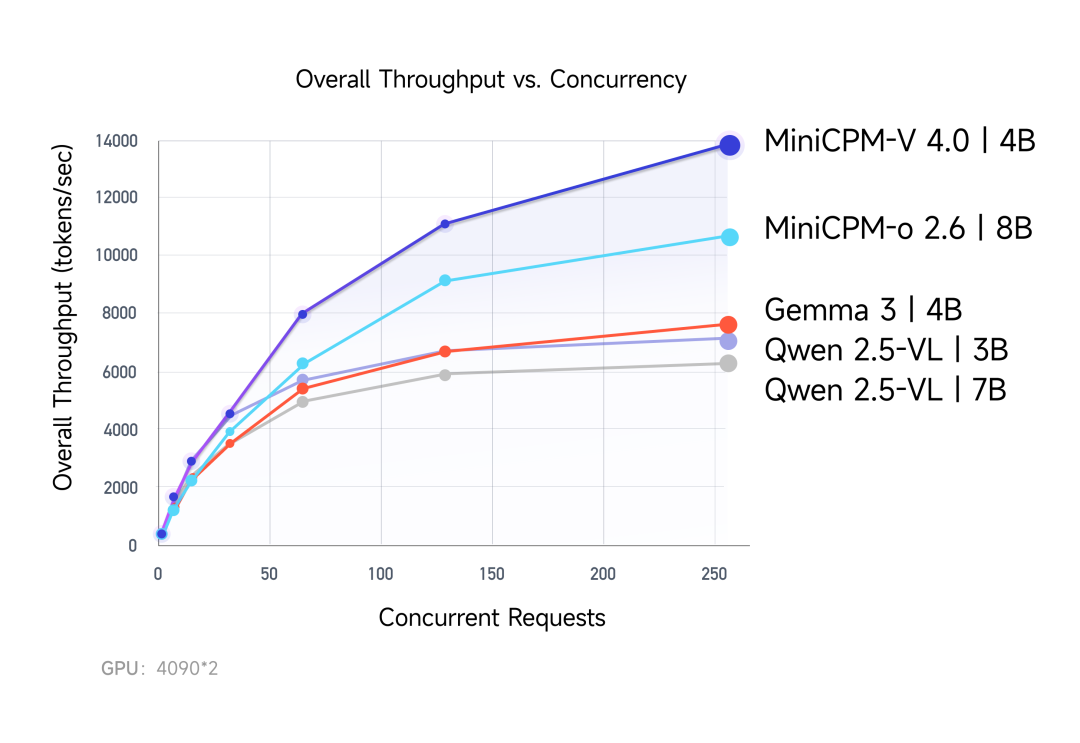

此外,我们也利用 2 张 4090 GPU 对模型并发量、吞吐量进行了测试。实验结果显示,在算力资源可支持的范围内,随着并发量的增加,MiniCPM-V 4.0 模型总吞吐量优势更为明显。例如在 256 并发用户需求下,MiniCPM-V 4.0 吞吐量高达 13856 tokens/s,远超 Qwen2.5-VL 的 7153 tokens/s、Gemma 3 的 7607 tokens/s。

CookBook 上线,面向各类场景轻松部署

为了广大的开发者群体能够方便部署并使用 MiniCPM-V 4.0 模型,我们与上海期智研究院首次系统开源了推理部署工具 MiniCPM-V CookBook,面向多种场景实现开箱即用的轻量部署,并提供详尽文档以降低部署门槛、加速落地。

MiniCPM-V CookBook 在框架兼容性上做到了“三端并举”,再次扩大了 MiniCPM-V 模型的用户群体。面向 个人开发者,可通过 llama.cpp 和 Ollama 等框架,在手机、平板、PC 等端侧实现部署,并完成图像问答或简易多模态实验;面对 企业侧的高并发场景,MiniCPM-V 与 vLLM、SGLang 高并发服务框架深度集成,获得高吞吐、低时延的稳定服务;而 学术与算法研究者 则可以基于 Hugging Face Transformers 等继续做二次开发、Prompt 注入和量化对比实验,快速验证新想法、分享复现实验。

同时,MiniCPM-V CookBook 不仅给出一键启动的 FastAPI 私有 Web-Demo,方便快速搭建 RAG 知识库或内部服务;还内置 GGUF、BNB 及 AutoAWQ 多条量化流水线,结合量化模型实现低资源高效部署;同时提供完整 iOS 示例,使端侧设备如 iPhone 和 Pad 上的实时多模态交互依旧保持“丝滑”体验。

本文由 Hugging Face 中文社区内容共建项目提供,稿件由社区成员投稿,经授权发布于 Hugging Face 公众号。文章内容不代表官方立场,文中介绍的产品和服务等均不构成投资建议。了解更多请关注公众号:

如果你有与开源 AI、Hugging Face 相关的技术和实践分享内容,以及最新的开源 AI 项目发布,希望通过我们分享给更多 AI 从业者和开发者们,请通过下面的链接投稿与我们取得联系:

内容中包含的图片若涉及版权问题,请及时与我们联系删除