作者:mumuu

编辑:李宝珠

转载请联系本公众号获得授权,并标明来源

OpenAI 正式开源 gpt-oss-120b 和 gpt-oss-20b,前者以千亿级参数专为复杂推理与知识密集型场景设计,后者则更适合低延迟、本地或专业垂直领域使用。在多项测试中,gpt-oss-120b 性能媲美 OpenAI o4-mini ,而 gpt-oss-20b 也接近 o3-mini 的表现。

时隔 6 年,自 GPT-2 以来,OpenAI 终于再度发布开源大模型——推出 gpt-oss-120b 和 gpt-oss-20b,前者以千亿级参数专为复杂推理与知识密集型场景设计,后者则更适合低延迟、本地或专业垂直领域使用,可在消费级硬件(如笔记本、边缘设备等)流畅运行。这种「大模型通用性+小模型专业性」的双版本以定位差异化和部署灵活性特点,较好地满足了用户的多场景使用需求。

在技术层面,gpy-oss 采用 MoE 架构保证强大性能的同时,显著降低了计算和内存需求,其中 gpt-oss-120b 能在单个 80GB GPU 上高效运行,而 gpt-oss-20b 可在仅配备 16GB 内存的边缘设备上运行。

在实际任务评估中,gpt-oss-120b 在 Codeforces、MMLU 和 HLE 以及工具调用 TauBench 的评测中表现优于 o3‑mini,并与 o4-mini 持平、甚至反超。此外,其在 HealthBench 和 AIME 2024 和 2025 上表现得比 o4-mini 更好。尽管 gpt-oss-20b 的模型参数规模较小,但在这些相同的评估中,其表现直逼 o3‑mini。

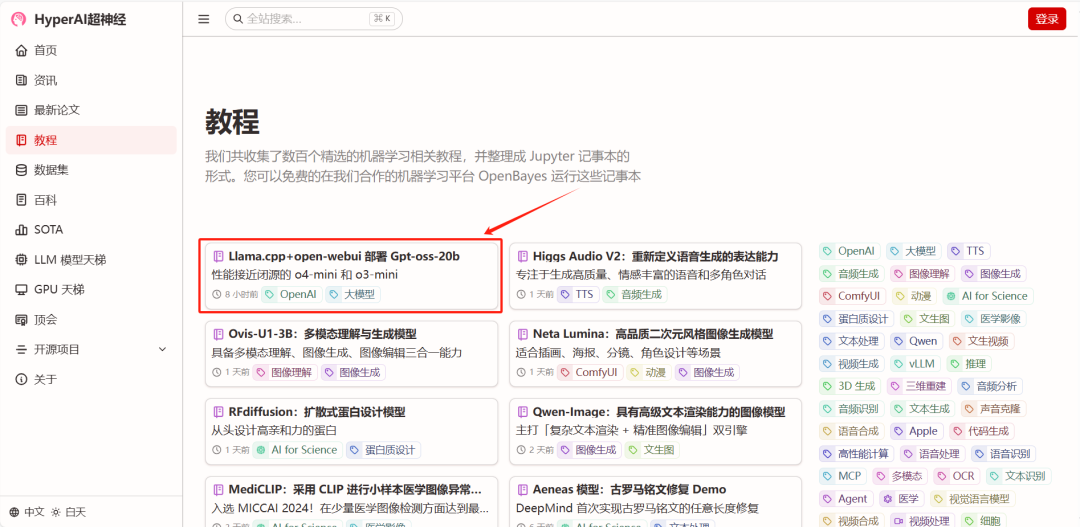

为了让大家能够更加流畅地体验 gpt-oss,HyperAI超神经官网(hyper.ai)的「教程」板块现已上线了「Llama.cpp+open-webui 部署 Gpt-oss-20b」,一键即可启动,基于单卡 NVIDIA RTX 4090 即可感受开源 SOTA 模型的强大能力。

另外,gpt-oss-120b 的教程也在紧锣密鼓地制作中,激情期待!

教程链接:

https://go.hyper.ai/iEJvN

Demo 运行

1. 进入 hyper.ai 首页后,选择「教程」页面,并选择「Llama.cpp+open-webui 部署 gpt-oss-20b」,点击「在线运行此教程」。

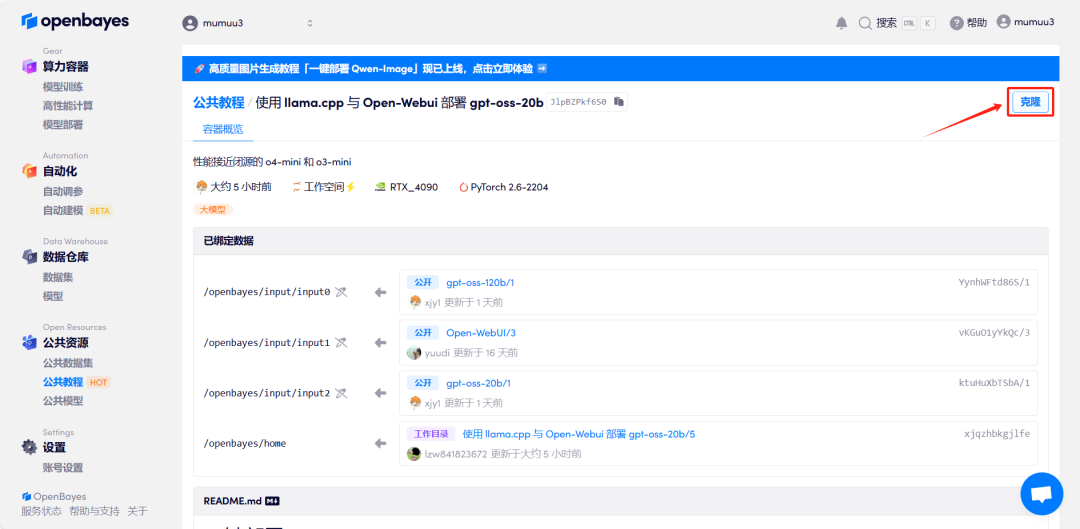

2.页面跳转后,点击右上角「克隆」,将该教程克隆至自己的容器中。

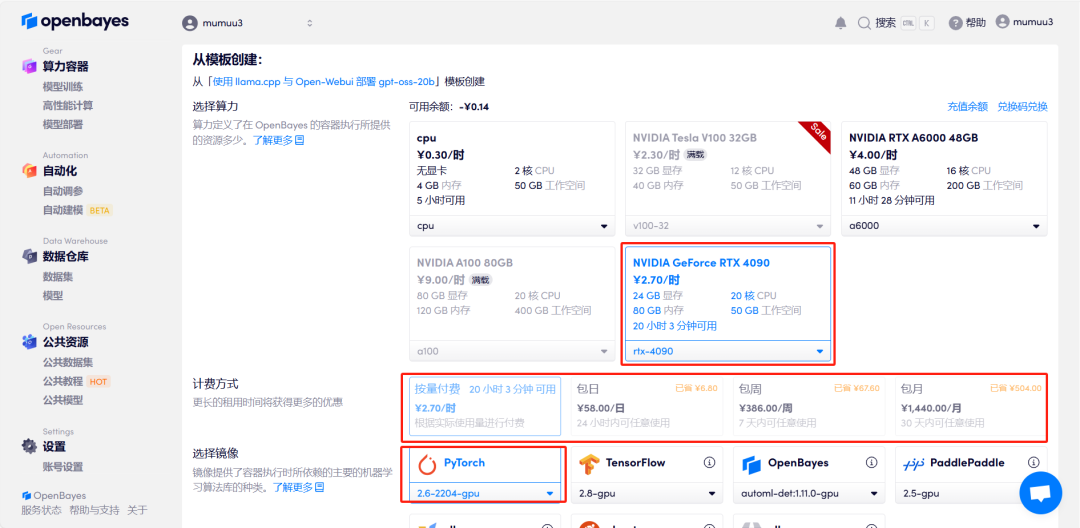

3.选择「NVIDIA GeForce RTX 4090」以及「PyTorch」镜像,按照需求选择「按量付费」或「包日/周/月」,点击「继续执行」。新用户使用下方邀请链接注册,可获得 4 小时 RTX 4090 + 5 小时 CPU 的免费时长!

HyperAI超神经专属邀请链接(直接复制到浏览器打开):

https://openbayes.com/console/signup?r=Ada0322_NR0n

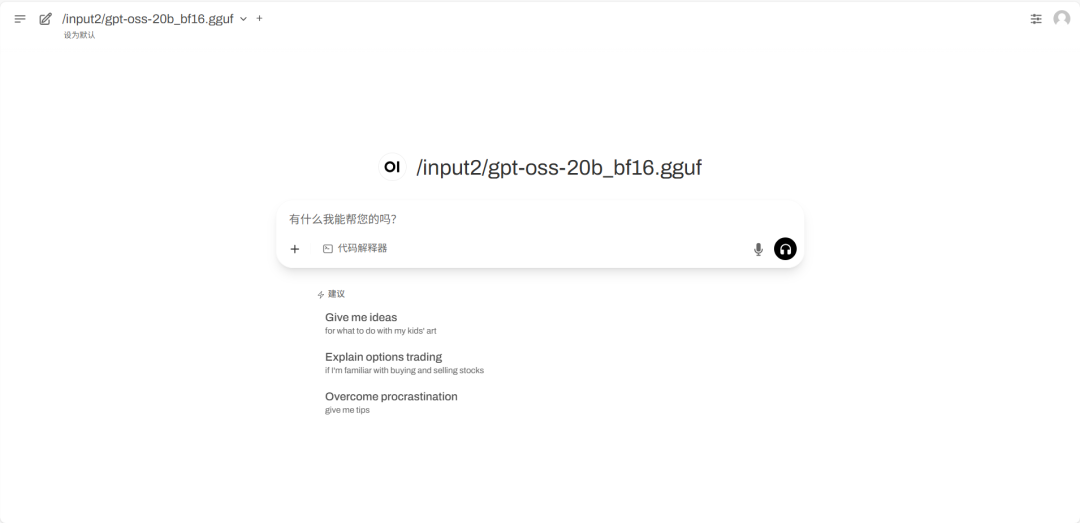

4.等待分配资源,首次克隆需等待 3 分钟左右的时间。当状态变为「运行中」后,点击「API 地址」旁边的跳转箭头,即可跳转至 Demo 页面。请注意,用户需在实名认证后才能使用 API 地址访问功能。

效果演示

进入 Demo 运行页面后,在对话框内输入 Prompt 并点击运行即可。

笔者对模型的内容创作、数学问题、推理能力进行了简单测试,gpt-oss 的回答都还不错。

Prompt:请撰写一个关于肯德基疯狂星期四的喜剧剧本,300字左右。

Prompt:(根号2+根号3)的2006次方,小数点后第一位第二位数是多少?

Prompt:判断逻辑是否正确:因为凶手不是背包旅客,而且你不是背包旅客,所以你是凶手。

以上就是 HyperAI超神经本期推荐的教程,欢迎大家前来体验!

教程链接:

https://go.hyper.ai/iEJvN

往期推荐

戳“阅读原文”,免费获取海量数据集资源!

内容中包含的图片若涉及版权问题,请及时与我们联系删除