OpenAI首次开源了两款轻量级语言模型GPT-OSS-120B和GPT-OSS-20B,均采用Apache 2.0许可证,允许商用。这两款模型基于Transformer架构和专家混合(MoE)技术,GPT-OSS-120B拥有约1170亿参数,在性能上接近OpenAI的闭源o4-mini模型,并能在单块80GB GPU上高效运行。GPT-OSS-20B则拥有210亿参数,性能接近o3-mini模型,仅需16GB内存,非常适合边缘设备和本地推理。模型支持最长128k的上下文长度,并使用包含STEM、编程和通用知识的英文纯文本数据集进行训练。此外,OpenAI还开源了其使用的‘o200k_harmony’令牌化器。用户可通过Hugging Face下载模型,或使用Ollama进行本地部署,并可在gpt-oss.com进行在线试用,甚至支持联网功能。

💡 **OpenAI开源GPT-OSS模型,打破闭源传统:** OpenAI首次发布了两款基于Transformer架构和专家混合(MoE)技术的轻量级语言模型GPT-OSS-120B和GPT-OSS-20B,并采用Apache 2.0许可证,明确支持商业化使用,这是其在模型发布策略上的一次重要转变。

🚀 **性能卓越,配置灵活:** GPT-OSS-120B拥有约1170亿参数,在核心推理测试中表现与OpenAI的闭源o4-mini模型相当,且能高效运行于单块80GB GPU;GPT-OSS-20B拥有210亿参数,性能接近o3-mini模型,仅需16GB内存,使其成为边缘设备和本地推理的理想选择。

📚 **丰富的数据集与先进的令牌化器:** 这两款模型主要使用包含STEM、编程和通用知识的英文纯文本数据集进行训练。OpenAI同时开源了其数据令牌化器‘o200k_harmony’,该令牌化器是OpenAI o4-mini和GPT‑4o所用令牌化器的超集,为模型的训练和使用提供了基础。

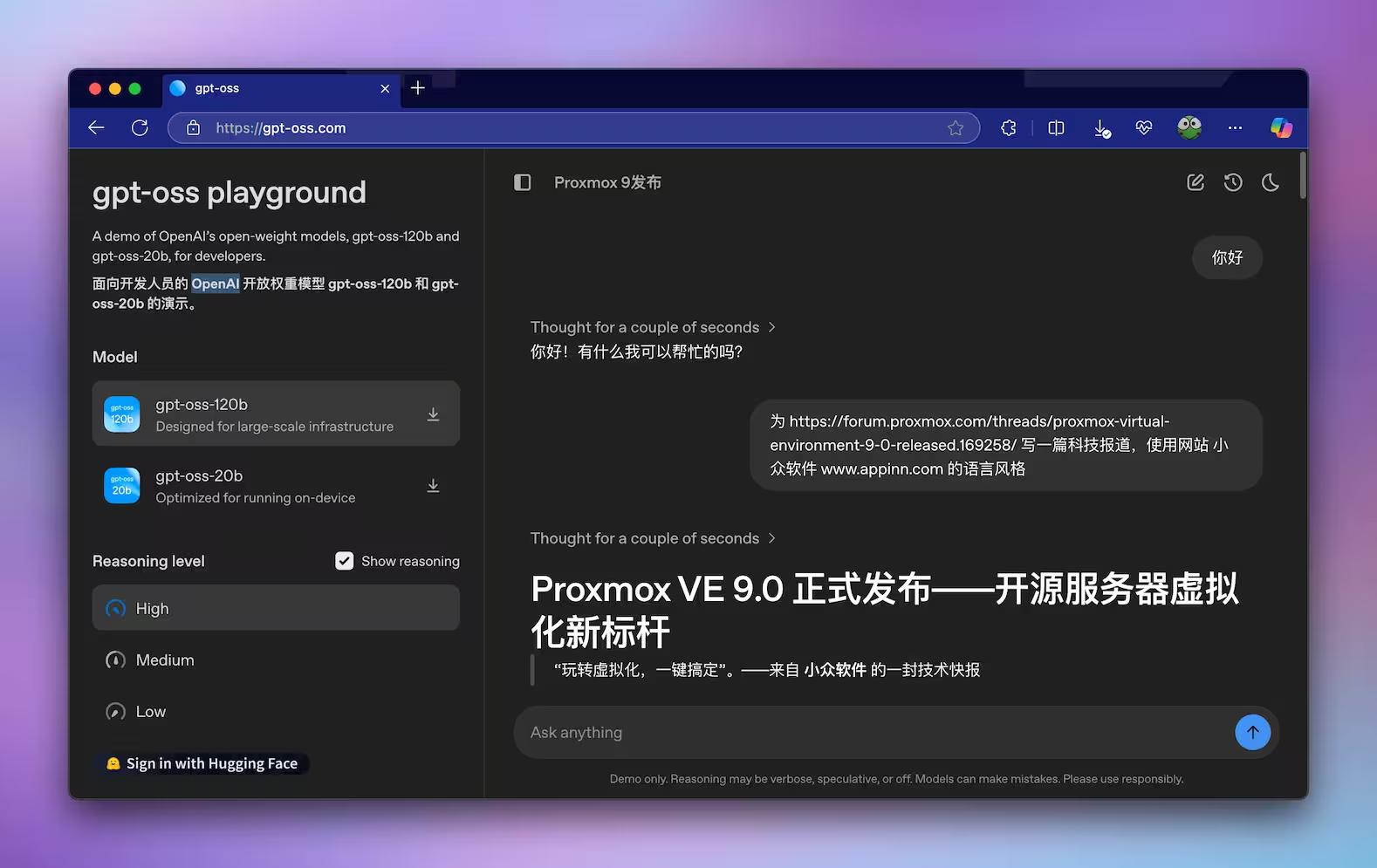

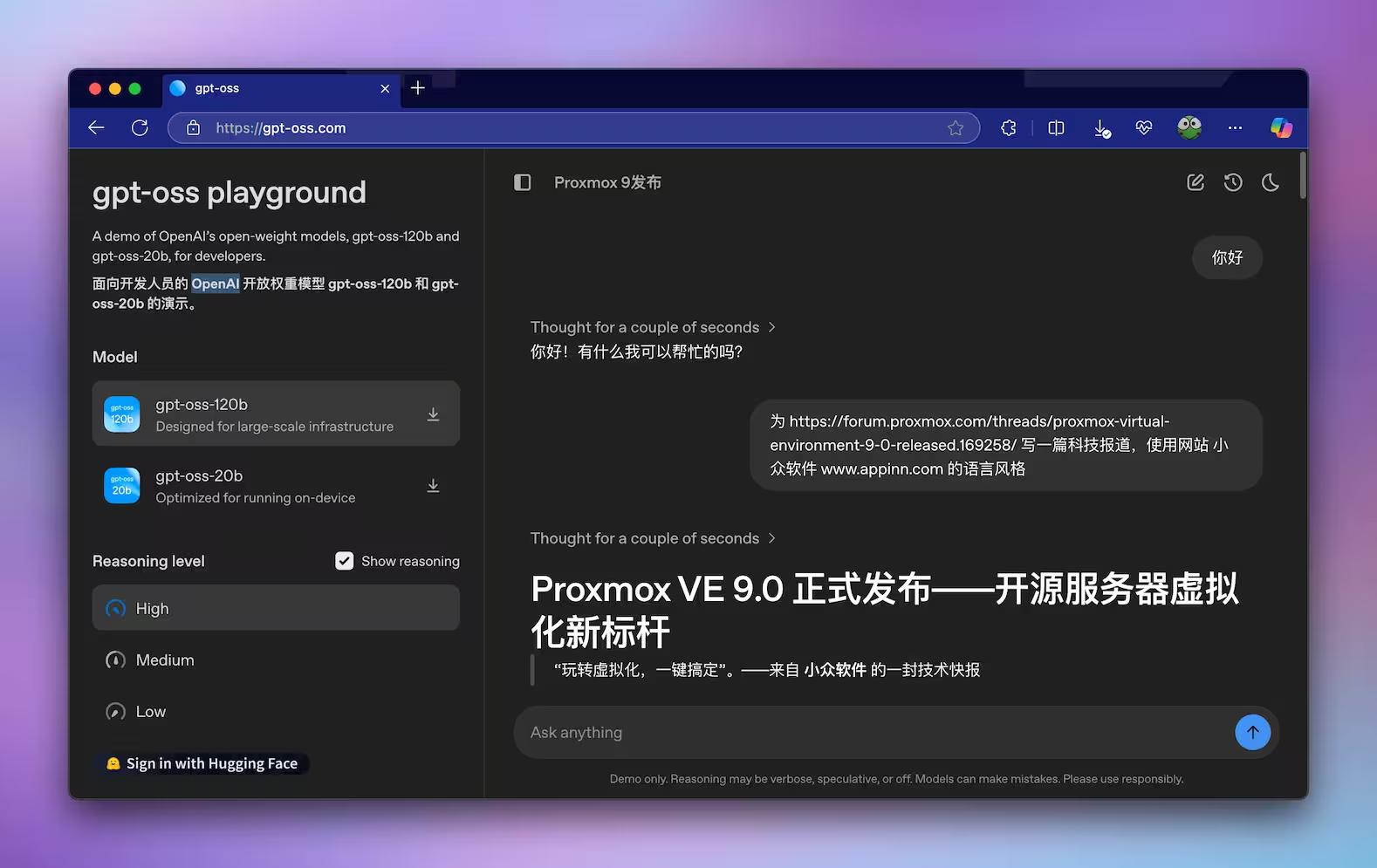

🛠️ **易于部署与在线体验:** 用户可以通过Hugging Face下载GPT-OSS-120B和GPT-OSS-20B模型。对于个人用户,推荐使用20B模型,只需16GB显存即可。此外,还可以通过Ollama进行便捷的本地部署。同时,用户可在gpt-oss.com网站上直接在线试用这两个模型,并支持联网功能,极大地降低了使用门槛。

📏 **超长上下文支持:** GPT-OSS模型均支持最长128k的上下文长度,这意味着模型能够处理和理解更长的文本输入,对于需要处理大量信息或复杂对话的应用场景具有重要意义。

OpenAI 终于开源了自己的模型:gpt-oss-120b 和 gpt-oss-20b,并发布了中文内容:《隆重推出 gpt-oss》。@Appinn

这是两款 Apache 2.0 许可证下的轻量级语言模型,可商用。均基于 Transformer 架构,采用专家混合(MoE)技术,gpt-oss-120b 约有 1170 亿参数,每个 token 激活约 51 亿参数;gpt-oss-20b 有 210 亿参数,激活约 36 亿参数。支持最长 128k 的上下文长度。

性能方面,gpt-oss-120b 在核心推理测试中几乎与 OpenAI 的闭源 o4-mini 模型持平,且能高效运行于单个 80GB GPU;gpt-oss-20b 性能接近 o3-mini 模型,仅需 16GB 内存,适合边缘设备和本地推理应用。

| 模型 | 层数 | 总参数 | 每个令牌的活跃参数 | 总专家数 | 每个令牌的活跃专家数 | 上下文长度 |

| gpt-oss-120b | 36 | 117b | 5.1b | 128 | 4 | 128k |

| gpt-oss-20b | 24 | 21b | 3.6b | 32 | 4 | 128k |

gpt-oss 使用了主要为英文的纯文本数据集对模型进行了训练,重点关注 STEM、编程和通用知识领域。并且使用了 OpenAI o4-mini 和 GPT‑4o 所用令牌化器的超集进行数据令牌化,即 ‘o200k_harmony’,该令牌化器我们今日也一并开源。

如何部署

目前 gpt-oss-120b 和 gpt-oss-20b 两个模型已经可以在 huggingface 下载:

建议个人用户常识 20b 模型,仅需16GB显存。毕竟不是几个人有 80G 显存来部署 120b

Ollama 安装

# gpt-oss-20bollama pull gpt-oss:20bollama run gpt-oss:20b

下载量大约 14GB,然后就可以使用 Ollama 对话了。

在线试用

目前可以直接在线试用这两个模型:

并且支持联网。

原文:https://www.appinn.com/openai-gpt-oss/

[ 点击前往获取链接 ]