本文介绍了两个好用的工具:Athina 和 Dify,分别用于 prompt 版本管理和多模型测试。Athina 支持自定义 API key 和 prompt 版本提交,可以方便地测试同一个模型下不同 prompt 的效果。Dify 可以添加多个模型输出,方便比较同一个 prompt 在不同模型下的表现。

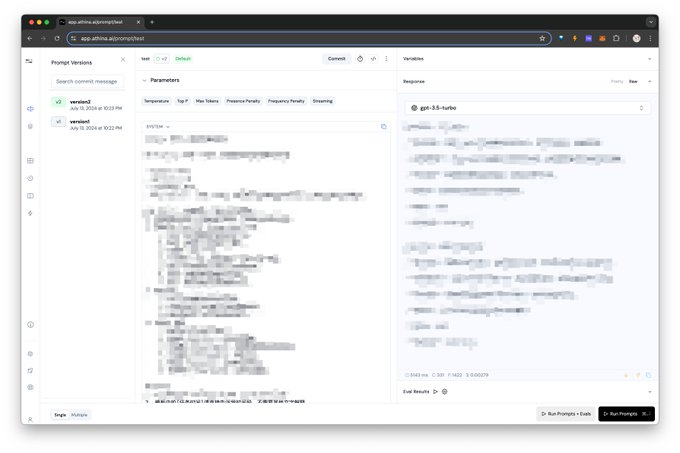

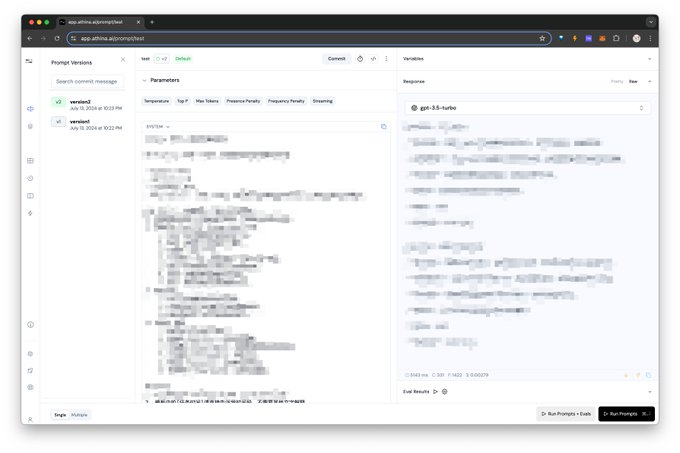

🤔 Athina:Athina 是一款优秀的 prompt 版本管理工具,支持自定义 API key 和 prompt 版本提交,可以方便地跟踪 prompt 的演变过程。在同一个模型下,用户可以测试多个 prompt 的效果,并进行比较,找到最佳的 prompt 版本。

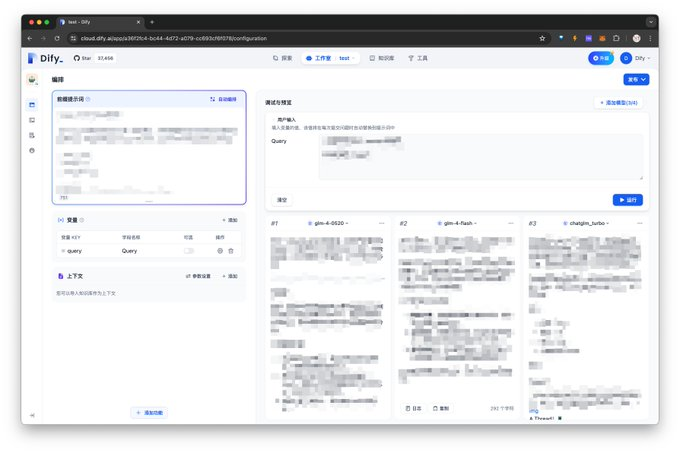

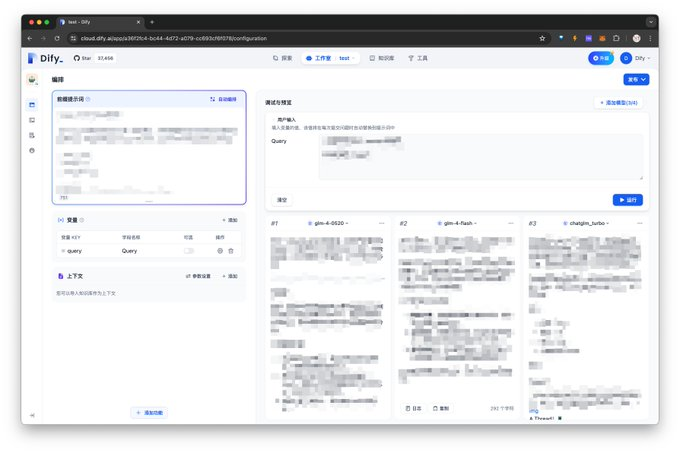

🚀 Dify:Dify 是一款强大的多模型测试工具,支持添加多个模型输出,方便用户比较同一个 prompt 在不同模型下的表现。例如,用户可以同时测试同一个 prompt 在 GPT4、deepseek、GLM4 等不同模型下的输出效果,并进行直观的对比,帮助用户选择最适合的模型。

💡 利用 Athina 和 Dify 的组合,可以有效地管理 prompt 版本,测试 prompt 在不同模型下的表现,从而找到最佳的 prompt 版本和模型组合,提升 prompt 的效率和效果。

由于最近写 prompt 越来越多,那么对于 prompt 的版本管理需求也会越来越多。

具体需求:

1.prompt 的版本管理,需要有历史版本。

2.同一个 prompt 在多模型下的表现。

我测试了一些 prompt 管理的网站,包括:

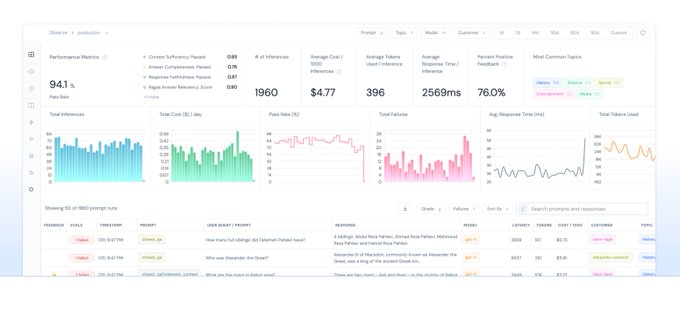

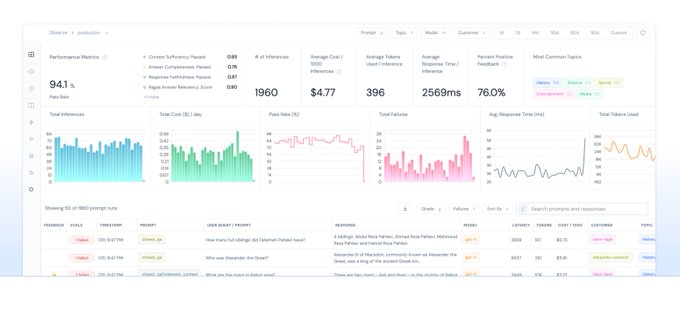

Athina

Lunary

Helicone

Langchain

Langfuse

Promptknit

Pezzo

经过测试,比较好的版本管理工具是 Athina。它支持自定义 API key,并支持 prompt 的版本提交,可以在同一个模型下测试多个 prompt 的效果。

https://app.athina.ai

1.用Athina控制prompt 版本

2.用 dify 测试多模型的效果

prompt 开发好之后,如果想要测试多模型下同一个 prompt 的效果,可以使用 Dify,它支持添加多模型输出,非常方便。

比如你可以同时测试同一个 prompt 情况下

在 GPT4、deepseek、GLM4 的不同模型下输出的效果,有一个非常直观的比较。

以上就是我最近体验的比较好用的 workflow