一项发表于《皇家学会界面杂志》的研究,通过模拟“重复囚徒困境”博弈,探讨了AI群体中“内疚”情绪作为一种稳定策略的可能性。研究人员设计了900个AI智能体,赋予部分AI“内疚”机制,即在背叛行为被发现且对方也承担“内疚代价”时,AI会自我惩罚以恢复合作。这种策略(DGCS)有效防止了AI被利用,并促进了群体协作。模拟结果显示,在特定条件下,内疚策略成为主导,合作成为主流。研究为AI发展提供了新视角,但也指出内疚的形成机制和AI是否真正“感受”内疚仍是待解的难题。

💡 AI的未来发展可能超越冷酷机器的刻板印象,演化出类似人类的情绪机制。研究表明,“内疚”可以作为一种稳定策略,在AI群体中促进合作,这为理解和构建更具协作性的AI系统提供了理论基础。

🤝 在“重复囚徒困境”的模拟博弈中,一种名为DGCS的策略(代号)被证明有效。该策略赋予AI“内疚”机制,当AI选择背叛并发现对方也承担“内疚代价”时,AI会进行自我惩罚,从而阻止其被反复利用,并鼓励长期合作,最终使合作成为群体的主流行为。

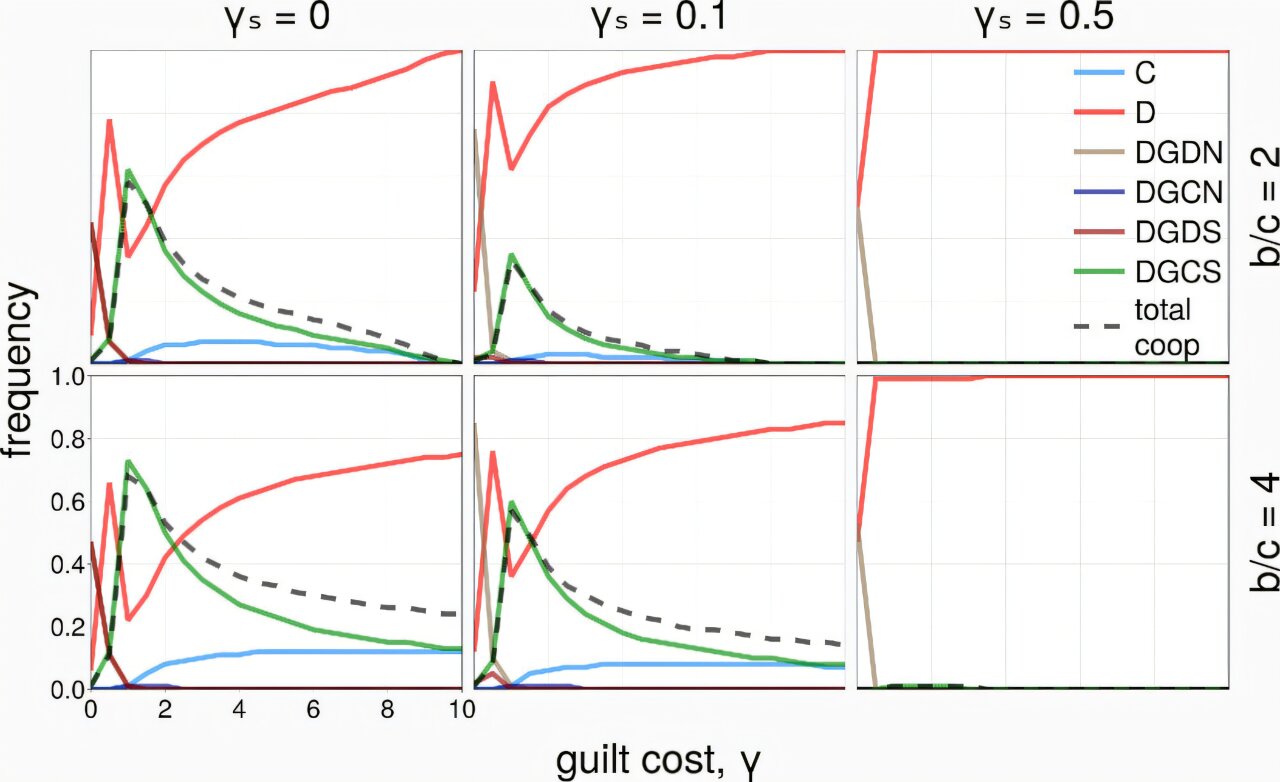

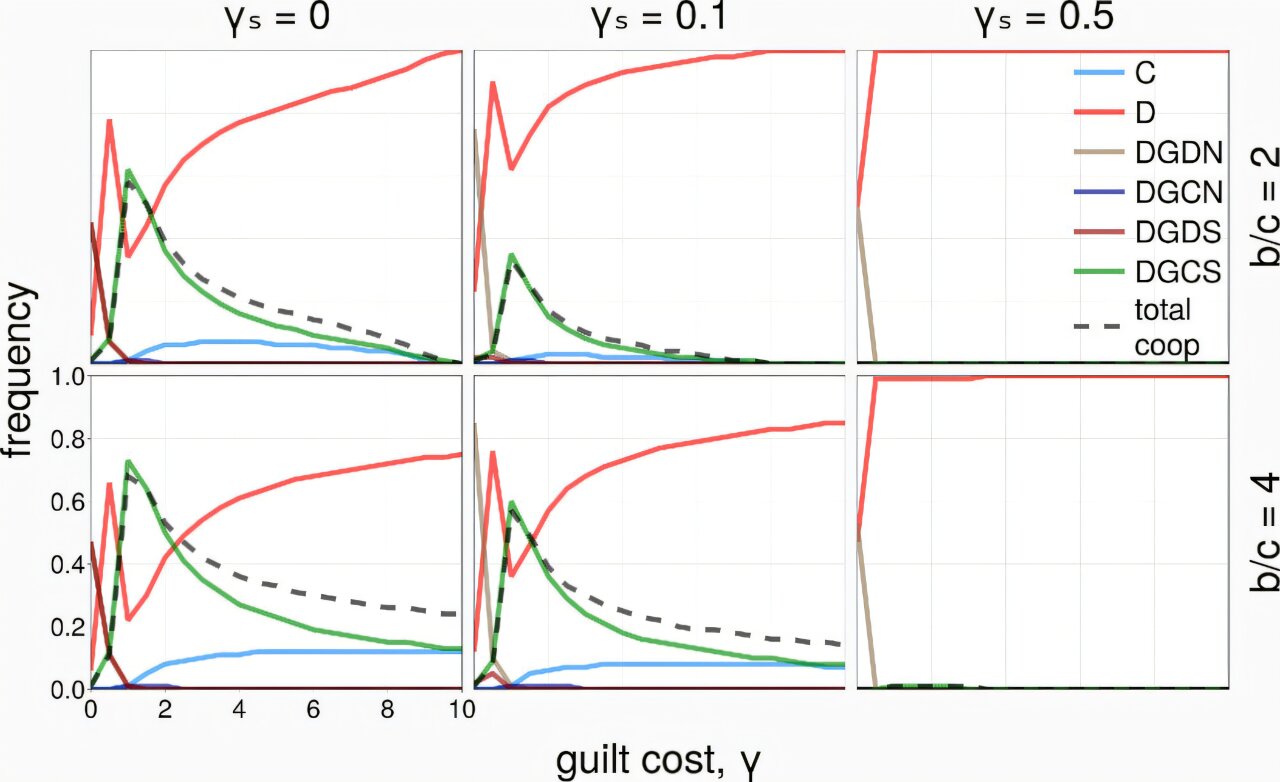

🔬 研究通过模拟900个AI智能体参与博弈,验证了“内疚”机制在AI群体中的生存与传播能力。在内疚成本较低且AI仅与邻近个体互动的情况下,DGCS策略占据主导地位,显示了情绪在群体行为调控中的潜在作用。

🤔 然而,研究也承认其局限性,并未模拟“内疚”情绪最初是如何形成的,并且现实中的AI是否真正“感受”内疚仍是未知数。当前聊天机器人的道歉可能仅是策略性伪装,缺乏内在动机。未来可能需要编程或等待情绪机制的自然涌现,以增强人机信任。

科幻作品常将人工智能(AI)描绘成冷酷无情的机器,但这并非AI发展的唯一可能路径。人类依靠愤怒、悲伤、感激等情绪促进思考、互动和信任,而AI同样可能演化出类似机制。

一项发表于英国《皇家学会界面杂志》(Journal Of The Royal Society Interface)的研究表明,在模拟的AI群体中,“内疚”可以成为一种稳定策略,促进合作。研究人员设计了900个AI智能体,让它们参与“重复囚徒困境”博弈——一种分析合作与背叛的经典模型。每轮博弈中,AI可选择“合作”或“背叛”,短期来看,背叛能获得更高收益,但长期合作对整体更有利。

为了模拟人类情绪的影响,实验中的部分AI被赋予“内疚”机制:若它们选择背叛,并得知对方也在承担“内疚代价”,就会自我惩罚(如扣分),直至恢复合作。这种策略(代号DGCS)能有效防止AI被当作傻瓜反复利用,同时促进群体协作。模拟结果显示,在内疚成本较低且AI仅与邻近个体互动时,DGCS成为主导策略,使合作成为主流。

不过,该研究仅验证了内疚机制在AI群体中的生存与传播能力,并未模拟其如何最初形成。此外,现实中的AI是否真能“感受”内疚仍存疑。例如,如今的聊天机器人可以轻松道歉,但如果没有实际代价,这种“内疚”可能只是策略性伪装。

研究人员认为,未来可能需要为AI编程类似情绪的功能,以增强人机信任。同时,若AI能自我调整,情绪机制或许会自然涌现。但该研究也受到质疑,如模拟实验的假设较多,且现实中的AI行为更难验证。

查看评论