AMD最新的锐龙AI Max+ 395平台迎来了重大升级,现已支持在本地运行高达1280亿参数的大型AI模型。这一成就需要搭配128GB统一内存,其中96GB将分配给显存,并运行在Vulkan llama.cpp环境下。最新的测试版驱动程序(25.10 RC 24)为这一突破提供了支持。这使得锐龙AI Max+ 395成为首个能够本地运行Meta Llama 4 Sout大模型的平台,该模型拥有1090亿参数,体积66GB,并支持Vision、MCP功能。得益于混合专家(MoE)模式,模型仅激活部分参数即可保持性能,实测每秒可达15 Tokens。此外,该平台还能流畅运行Mistral Large(1230亿参数)以及Qwen3 A3B(300亿参数)、Google Gemma(270亿参数)等模型。锐龙AI Max+ 395还支持多种模型尺寸和量化格式,如GGUF。值得关注的是,其上下文尺寸大幅扩展至256000 Tokens,能够处理和分析更大规模的数据,此功能需要开启Flash Attention和Q8 KV Cache。整体而言,配备128GB内存的锐龙AI Max+ 395迷你AI工作站价格亲民,性价比极高。

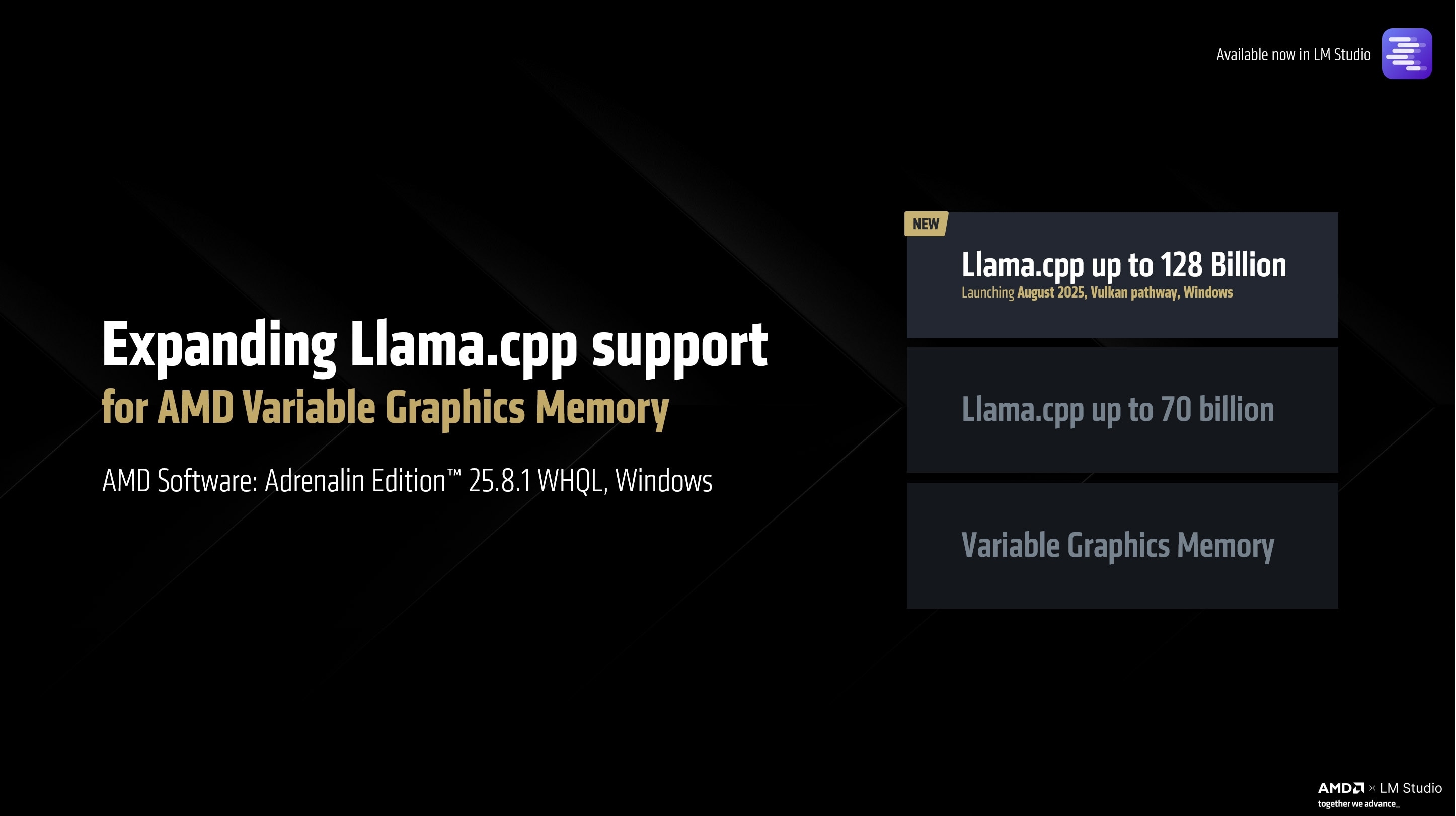

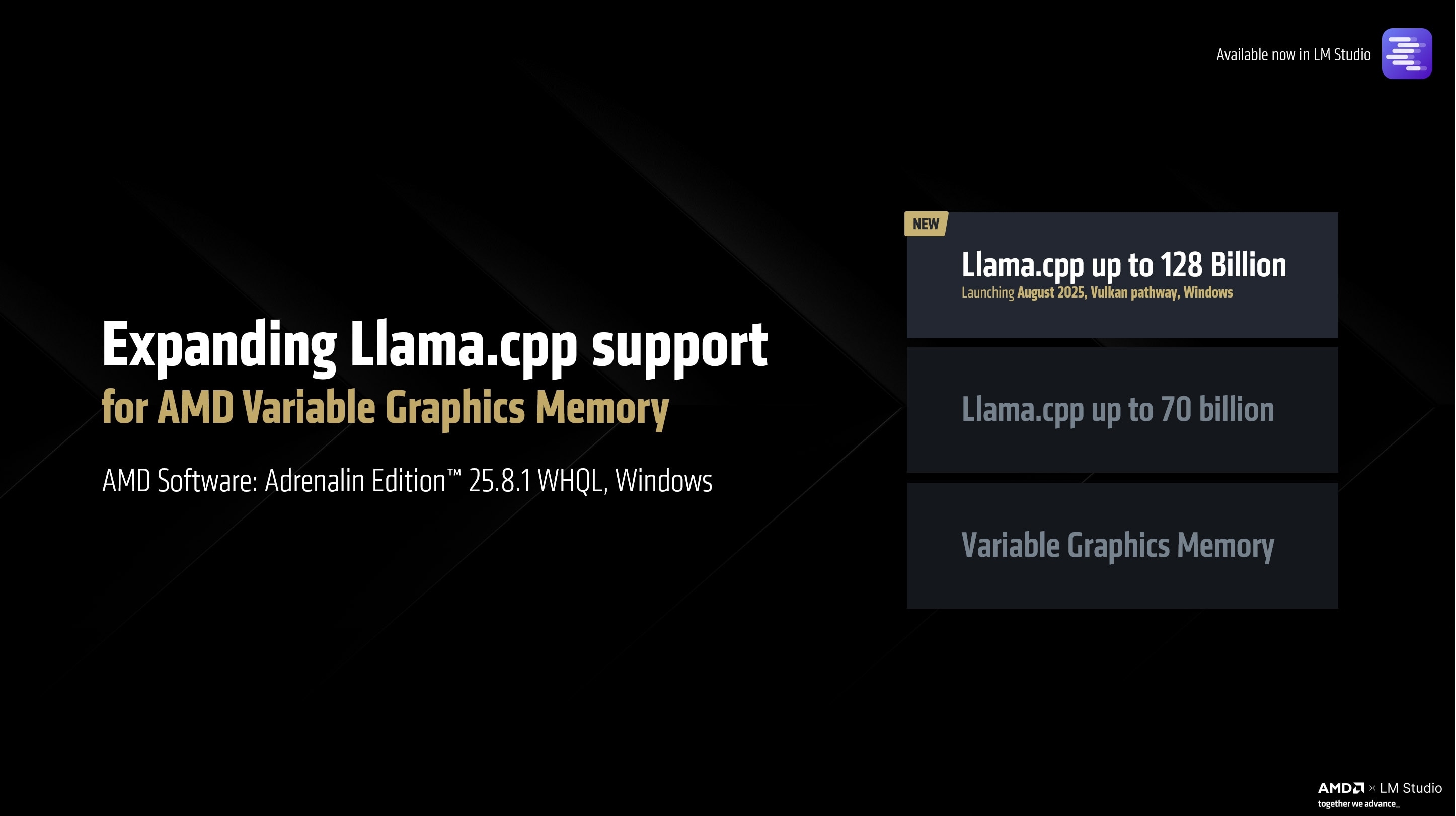

🚀 **本地AI模型运行能力大幅提升**:AMD锐龙AI Max+ 395平台现在能够支持在本地运行高达1280亿参数的大型AI模型,相较于之前的700亿参数模型是一个显著的进步。这是通过搭配128GB统一内存(分配96GB作为显存)以及在Vulkan llama.cpp环境下实现的。

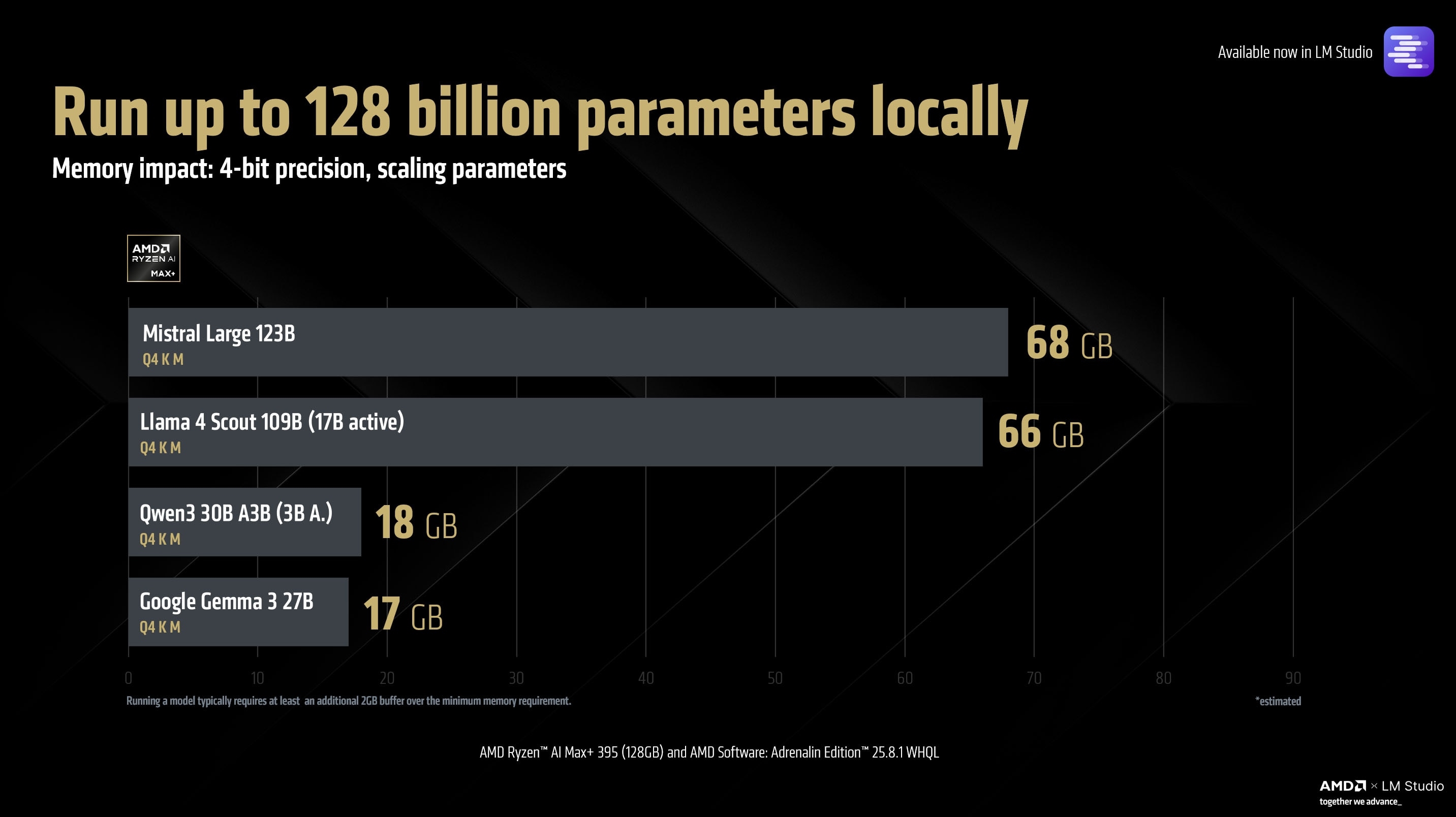

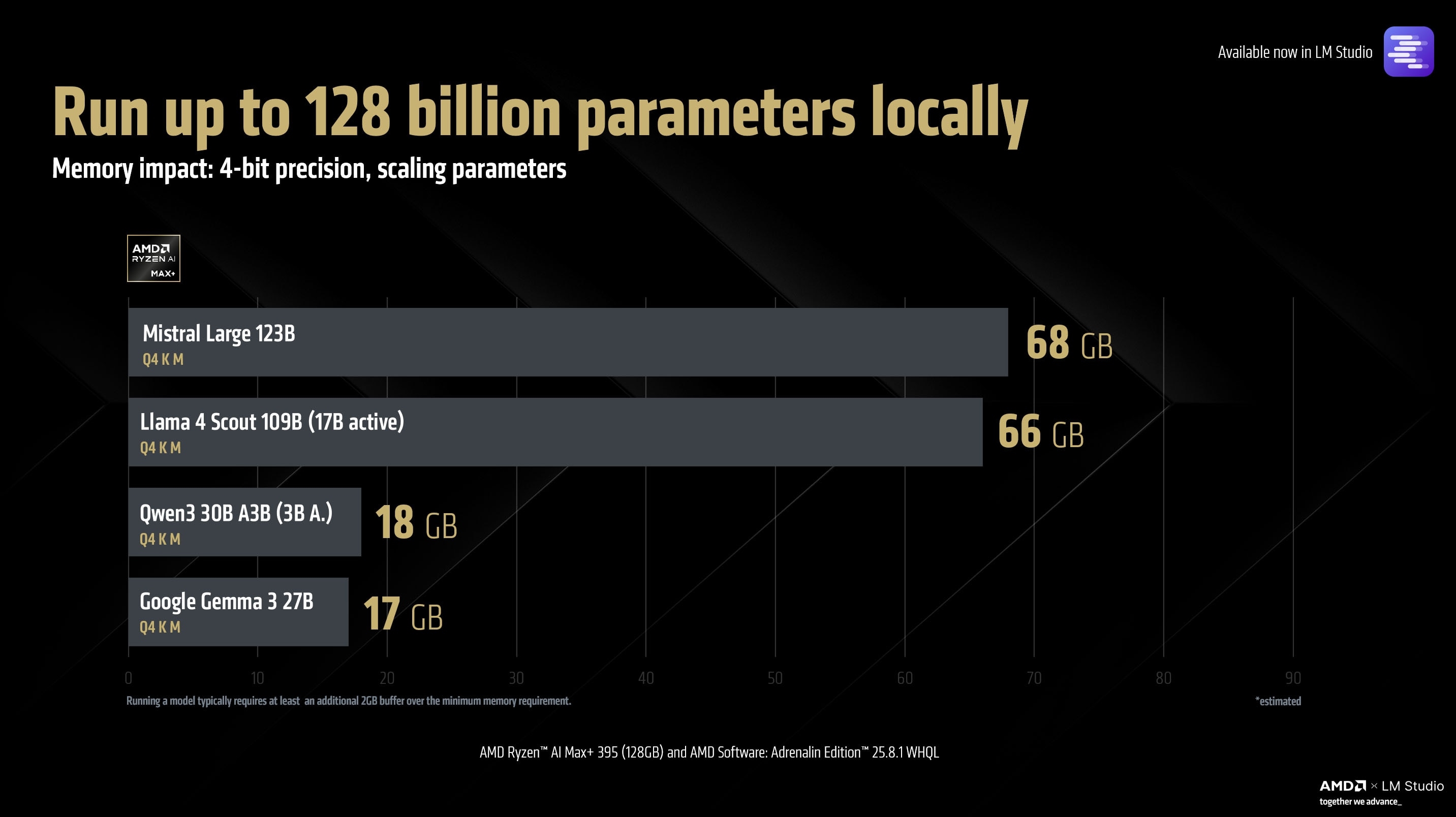

💡 **支持多种大型AI模型**:该平台不仅能运行Meta Llama 4 Sout(1090亿参数,66GB体积),还支持Mistral Large(1230亿参数,68GB体积),以及Qwen3 A3B(300亿参数,18GB体积)和Google Gemma(270亿参数,17GB体积)等模型。模型支持混合专家(MoE)模式,能更高效地管理参数激活,实测性能可达每秒15 Tokens。

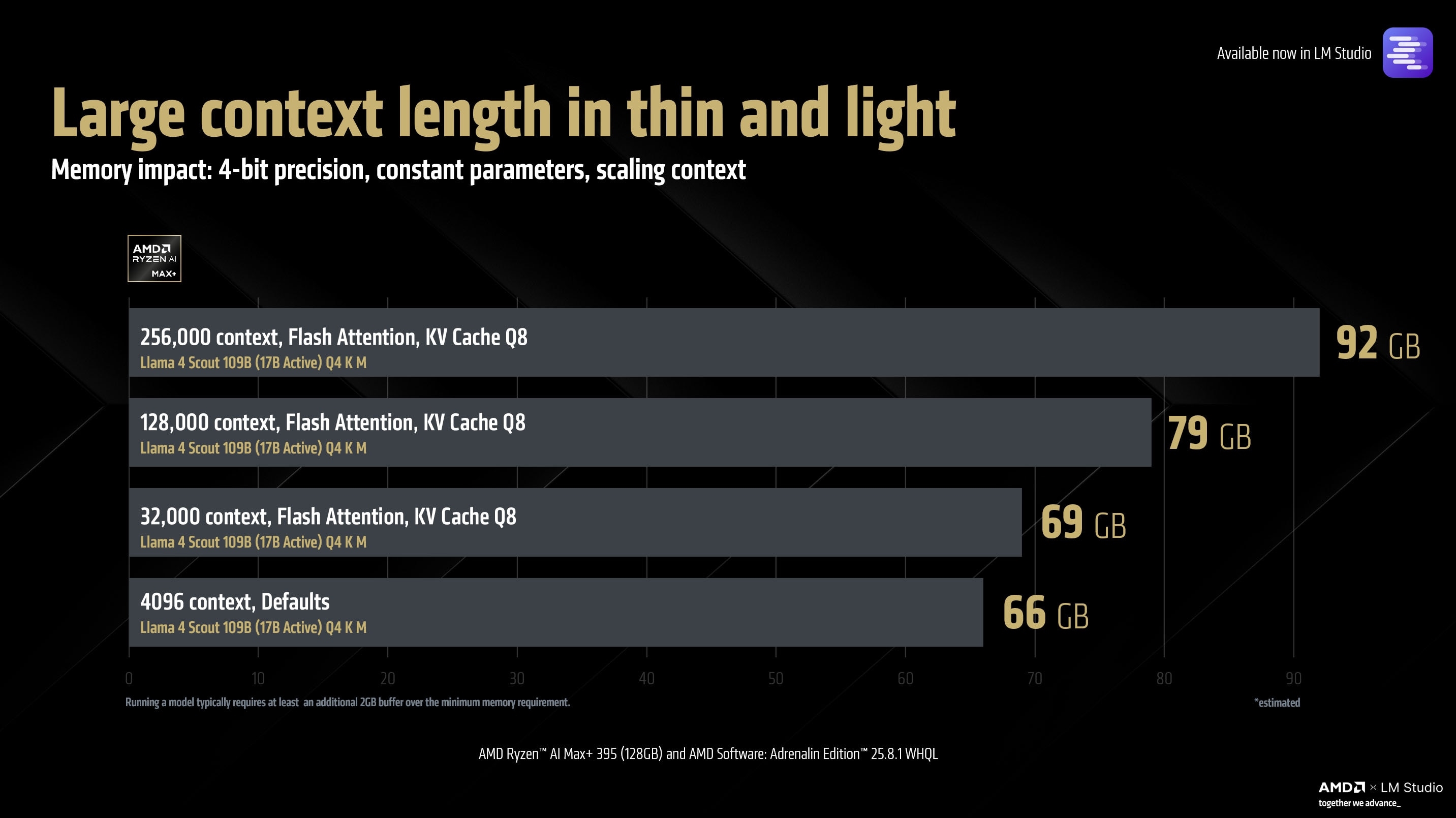

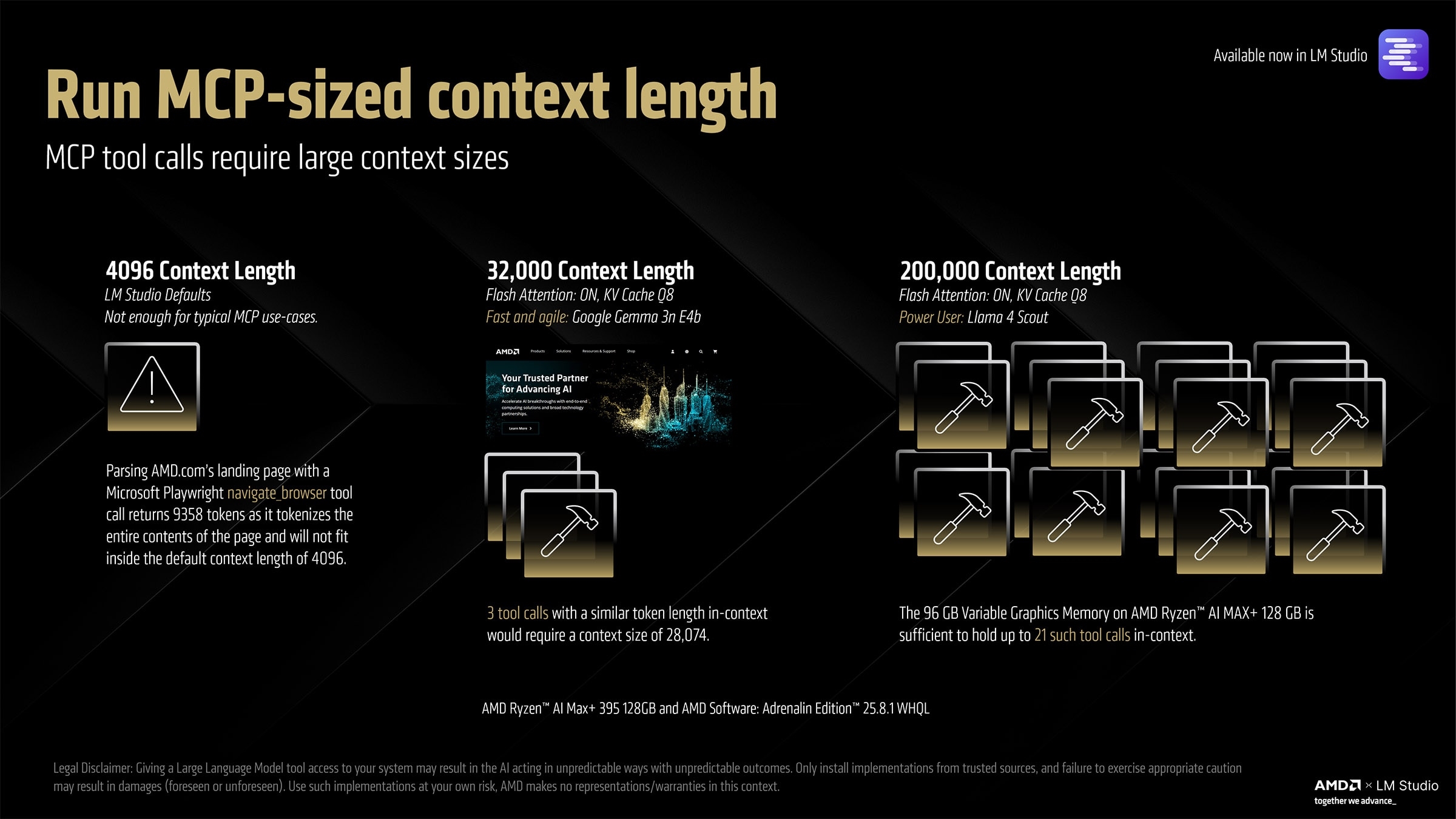

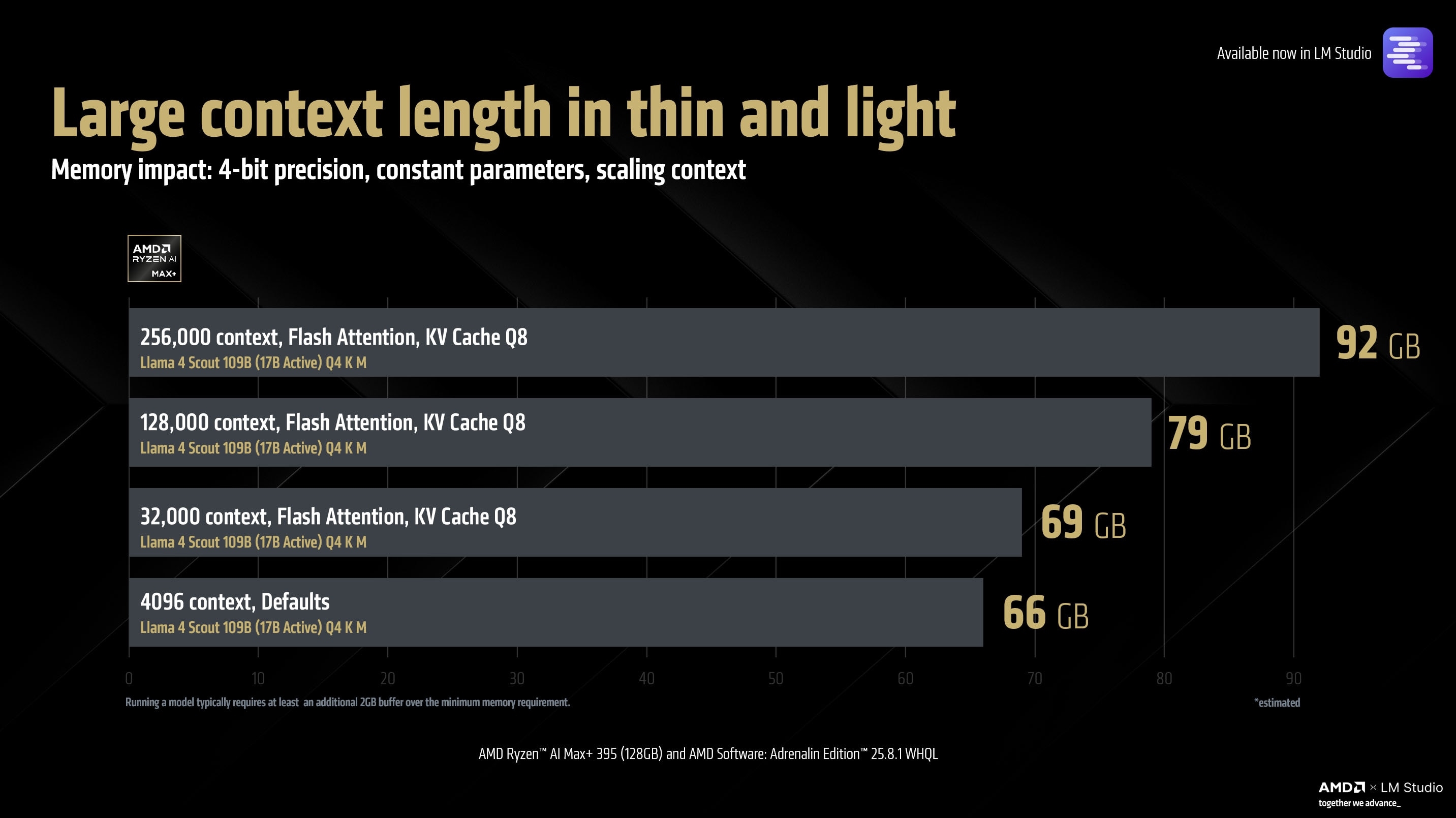

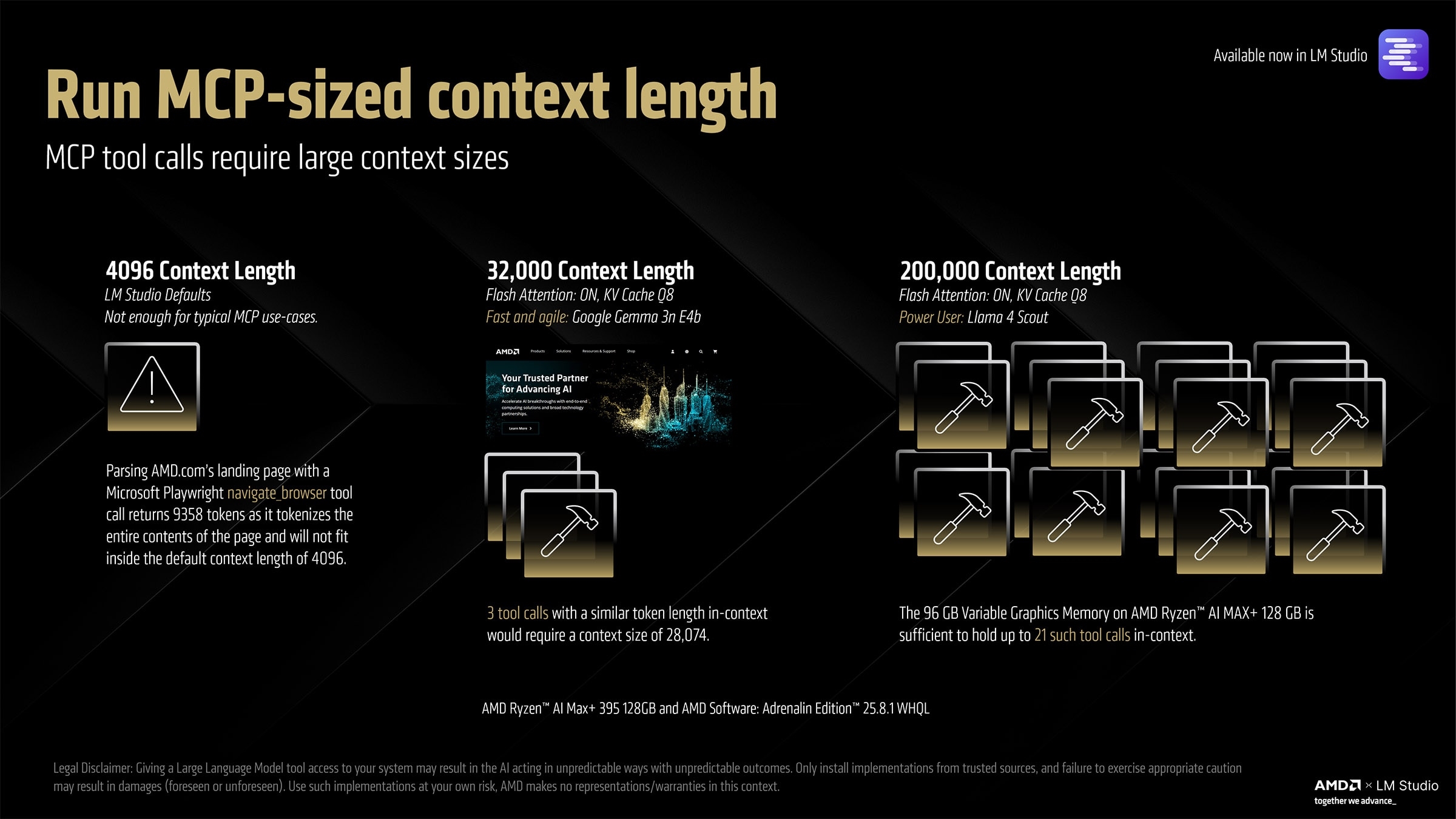

📚 **革命性的上下文处理能力**:锐龙AI Max+ 395将上下文尺寸从传统的4096 Tokens大幅提升至256000 Tokens,极大地增强了处理和分析大规模文档及数据资料的能力。此功能需要开启Flash Attention和Q8 KV Cache。

💰 **高性价比的AI工作站解决方案**:配备128GB内存的锐龙AI Max+ 395迷你AI工作站,价格已降至约1.3万元人民币,为用户提供了极具竞争力的本地AI计算解决方案,使得先进的AI模型得以普及。

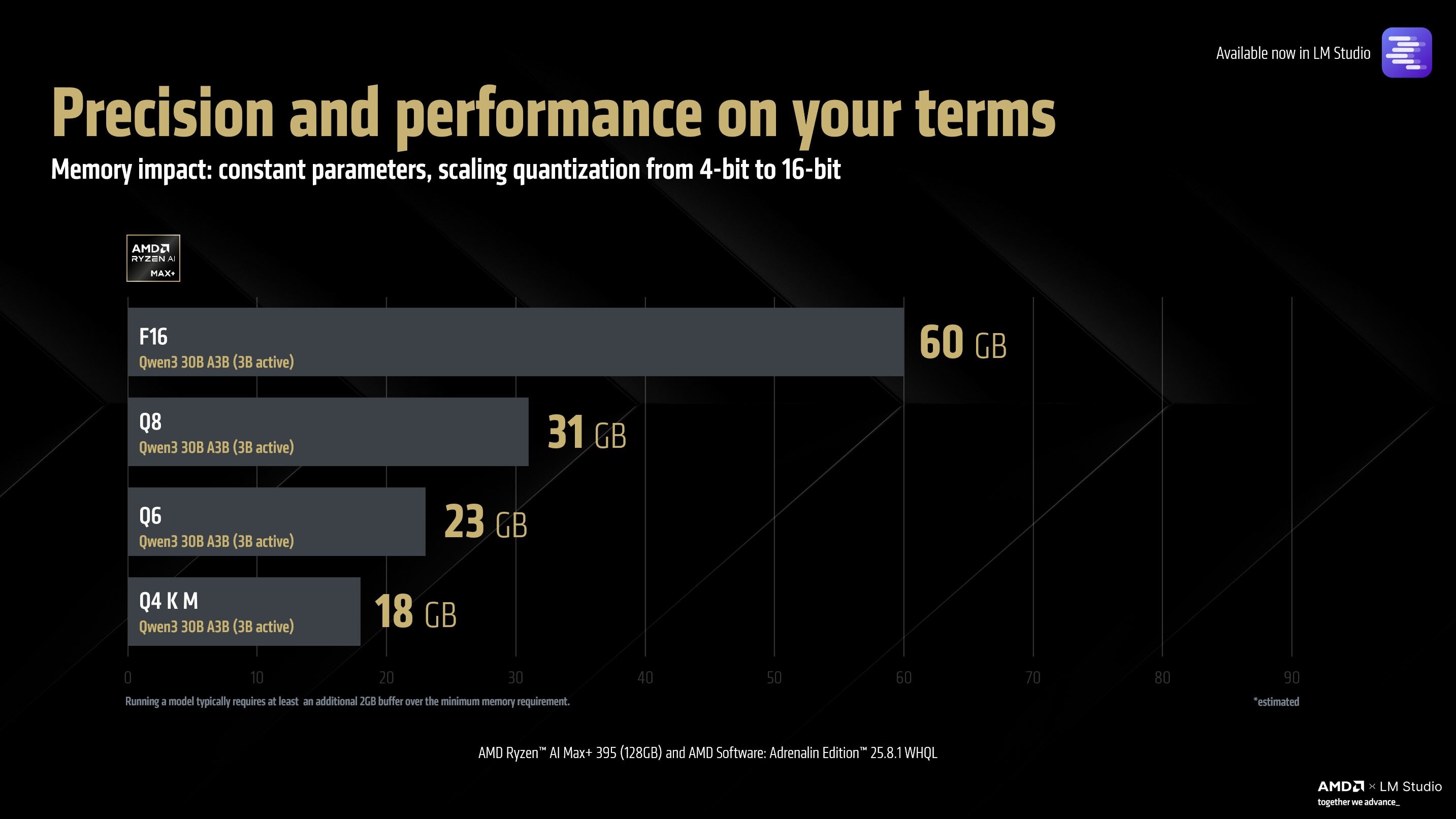

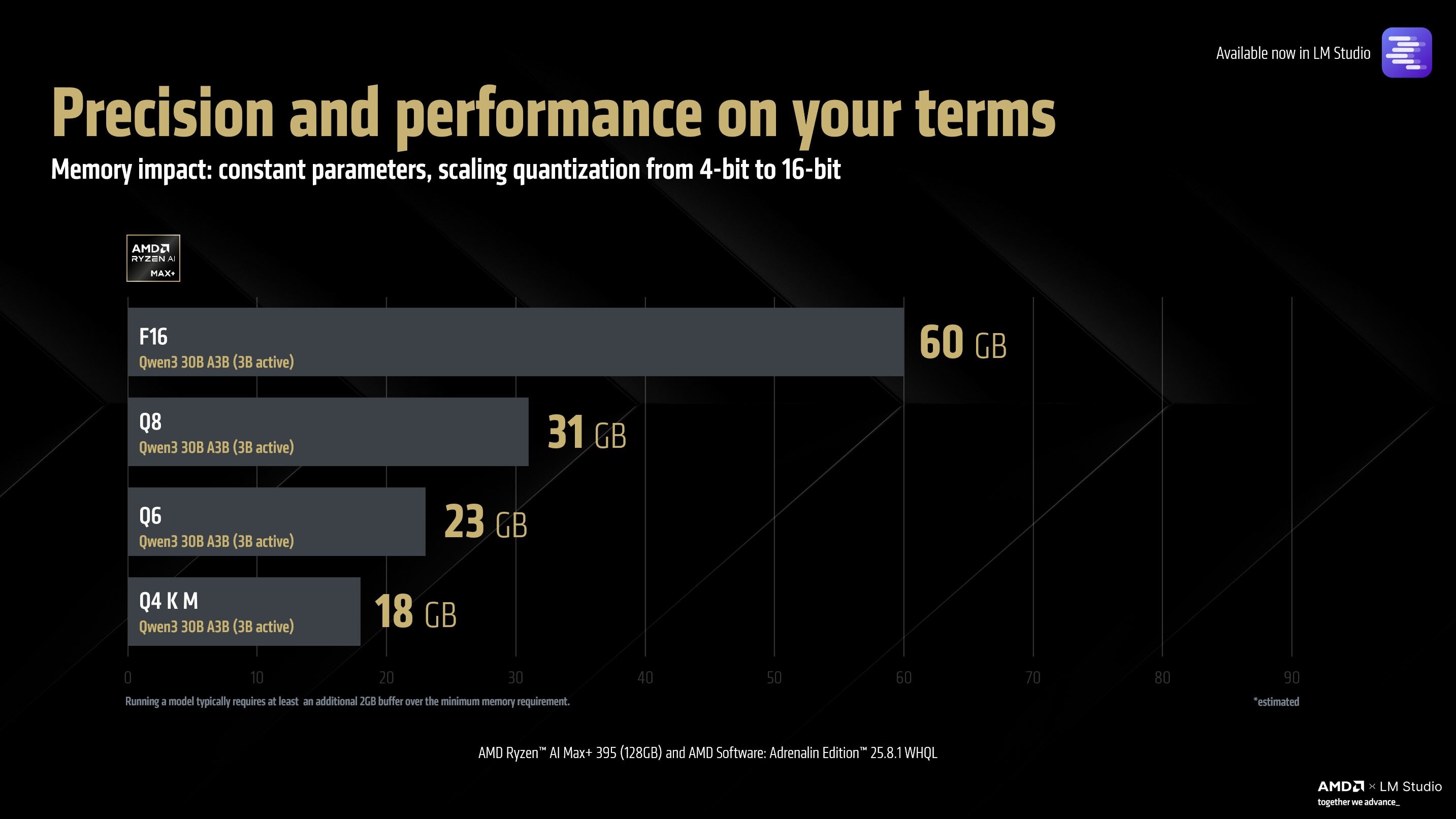

⚙️ **技术细节与驱动支持**:实现这些强大功能离不开最新的测试版驱动程序(25.10 RC 24),该版本预计下个月初将更新为正式版25.8.1。同时,平台支持GGUF等多种模型尺寸和量化格式,为用户提供了广泛的灵活性。

AMD Zen5架构的锐龙AI Max+ 395,是第一个可以在本地运行700亿参数AI大模型的平台,当然需要搭配128GB统一内存,而现在,AMD奉上重磅升级,1280亿参数大模型都可以在本地运行了!

当然,能做到这一点的还是只有锐龙AI Max+ 395,还是必须搭配128GB统一内存,并分配96GB作为显存,而且必须在Vulkan llama.cpp环境下。

驱动方面需要搭配还在测试阶段的25.10 RC 24版本,下个月初将会变成正式版25.8.1。

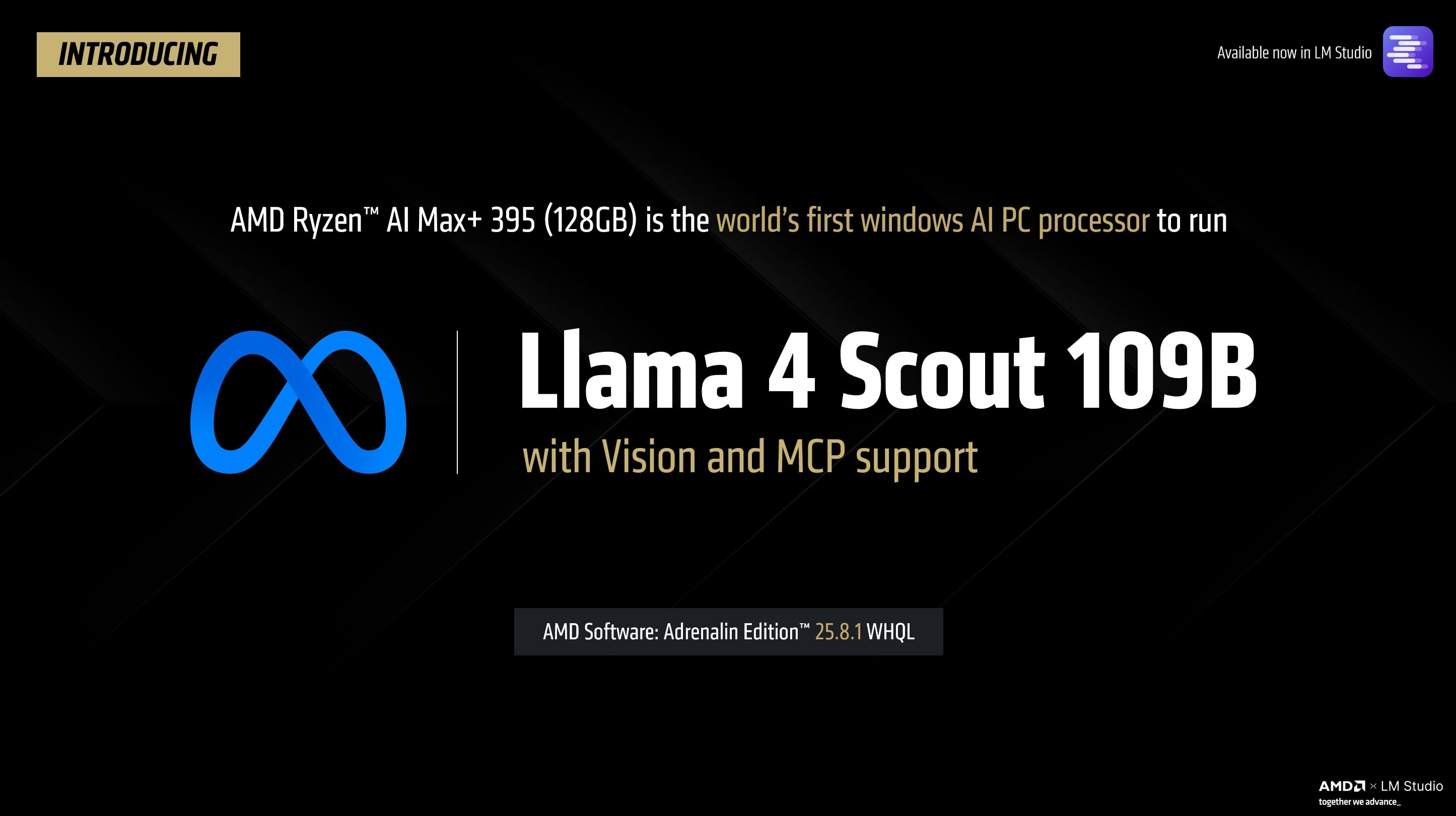

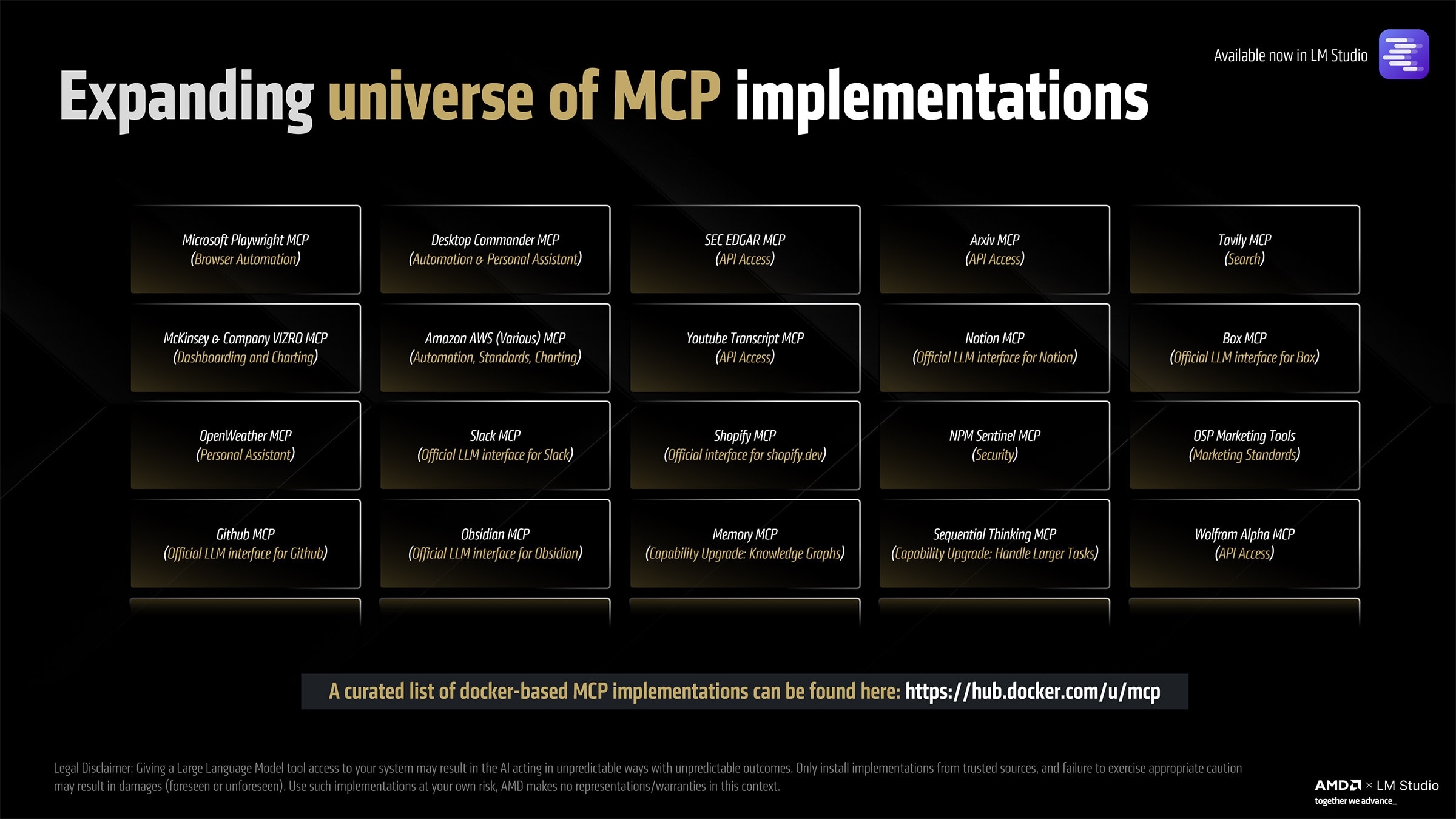

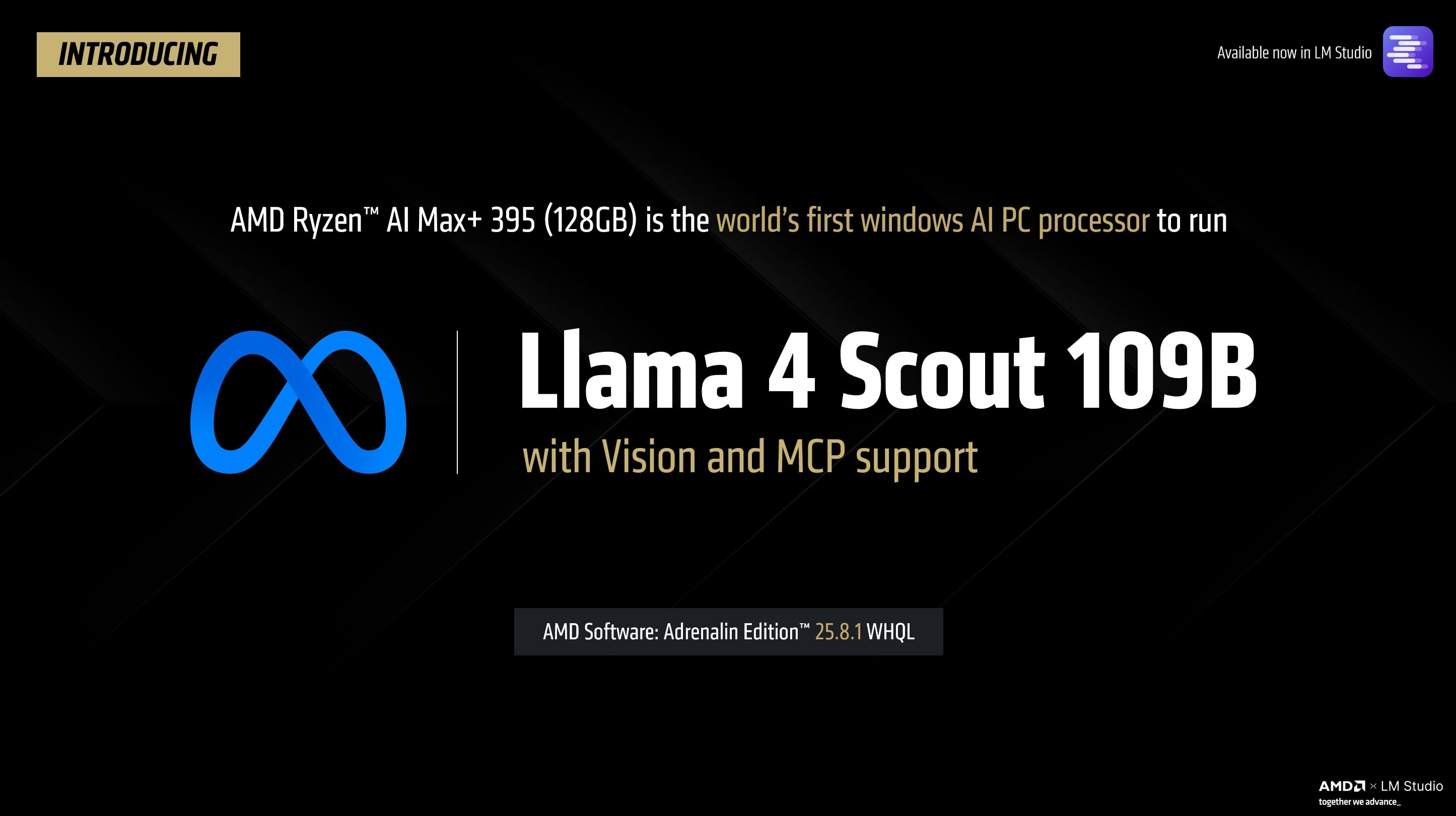

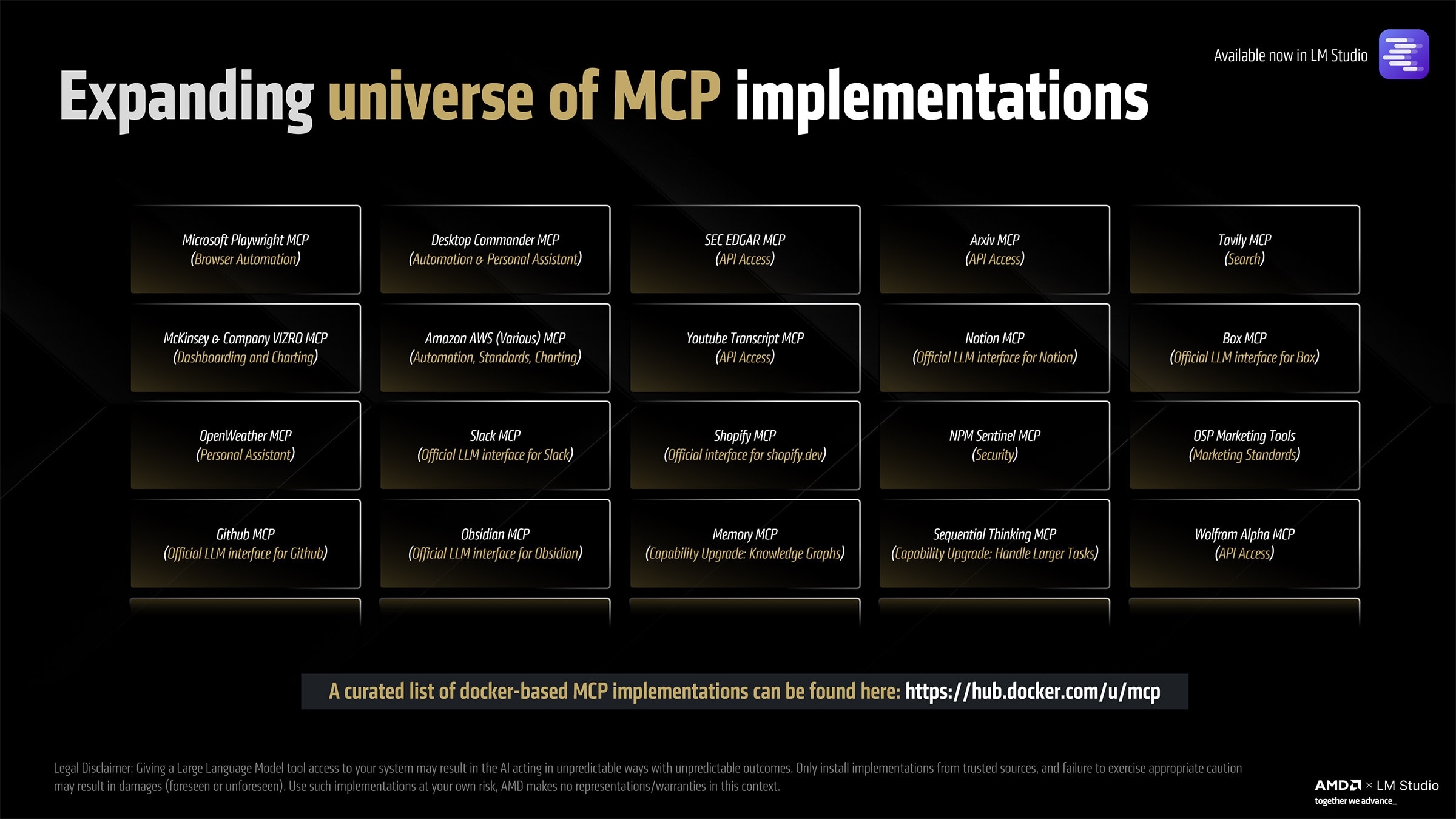

这使得锐龙AI Max+ 395成为第一个能在本地运行1090亿参数的Meta Llama 4 Sout大模型的平台,体积多达66GB,活跃参数最多170亿,并支持Vision、MCP。

这得益于该模型使用了混合专家(MoE)模式,每次只激活模型的一部分,从而保持性能可用,锐龙AI Max+ 395实测可以做到每秒15 Tokens。

同时,锐龙AI Max+ 395还可以跑68GB体积、1230亿参数的Mistral Large,至于18GB、300亿参数的Qwen3 A3B、17GB、270亿参数的Google Gemma,自然更是不在话下。

当然,锐龙AI Max+ 395还支持各种各样的模型尺寸、量化格式,包括GGUF。

同样重要的是,锐龙AI Max+ 395升级支持了更大的上下文尺寸,从传统的4096 Tokens左右,一举来到了惊人的256000 Tokens,从而能够分析、汇总更大规模的文档等数据资料。

不过这里需要注意,得开启Flash Attention、Q8 KV Cache。

对于一般的非大规模模型,32000 Tokens的上下文就足够用了,锐龙AI Max+ 395则提供了新的可能,而以往如此超大规模的上下文,往往需要几万十几万的设备才能实现。

锐龙AI Max+ 395、128GB配置的迷你AI工作站,价格已经低至1.3万元左右,可以说性价比是相当高了。