在上海世界人工智能大会上,华为首次展出了其创新的昇腾384超节点,也称为Atlas 900 A3 SuperPoD。这款产品打破了传统的CPU中心架构,采用了对等计算架构,并将总线扩展至整机柜乃至跨机柜,极大地优化了数据传输和处理方式。相较于传统集群,昇腾超节点在通信带宽上提升了15倍,通信时延降低了10倍,并能实现384颗NPU的点对点超大带宽互联。它在LlaMA3等稠密模型训练上性能提升2.5倍以上,在Qwen、DeepSeek等多模态、MoE模型上性能提升更可达3倍以上,是当前业界最大规模的超节点,为大模型训练和推理带来了显著的效率提升。

🚀 **颠覆性架构与互联优势**:华为昇腾384超节点摒弃了传统的CPU中心冯·诺依曼架构,创新性地采用了对等计算架构,并将总线从服务器内部扩展到整机柜乃至跨机柜。这种设计突破了传统集群在大规模训练时资源利用率低、故障频发的问题,通过高速总线连接多颗NPU,实现了像一台计算机一样的协同工作,解决了互联瓶颈,大幅提升了数据传输和处理效率。

💡 **通信性能的飞跃**:昇腾384超节点在通信方面实现了质的飞跃,其跨节点通信带宽相较于传统架构提升了15倍,显著加快了数据传输速度。同时,通信时延从2μs大幅降低至0.2μs,减少了10倍,极大地缩短了数据处理的等待时间。这种超大带宽和超低时延的特性,使得数据交互更加流畅,满足了大规模AI训练对高效率通信的严苛需求。

🌐 **卓越的互联能力与MoE模型优化**:该超节点支持最大384颗NPU的点对点超大带宽互联,是业界唯一能在单个超节点域内完成所有专家并行(EP)方案的产品。这使其成为MoE(Mixture of Experts)模型的理想训练和推理平台,能够极大提高模型训练和推理的效率,特别是在处理如DeepSeek V/R1这类模型时,其优势尤为突出。

⚡ **超低时延与实时交互能力**:昇腾384超节点支持全局内存统一编址,具备高效的内存语义通信能力,通过更低时延的指令级内存语义通信,能够满足大模型训练/推理中对小包通信的需求,提升专家网络小包数据传输及离散随机访存的效率。此外,它更是业界唯一突破Decode时延15ms的方案,能够满足实时深度思考场景下的用户体验需求。

💪 **强大的训练性能提升**:实际测试表明,在昇腾384超节点集群上,LlaMA3等千亿级稠密模型的训练性能可以达到传统集群的2.5倍以上。对于通信占比更高的Qwen、DeepSeek等多模态和MoE模型,性能提升更是可以达到3倍以上。这标志着华为在AI算力领域取得了重大进展,为推动AI技术的进步提供了强大的硬件支撑。

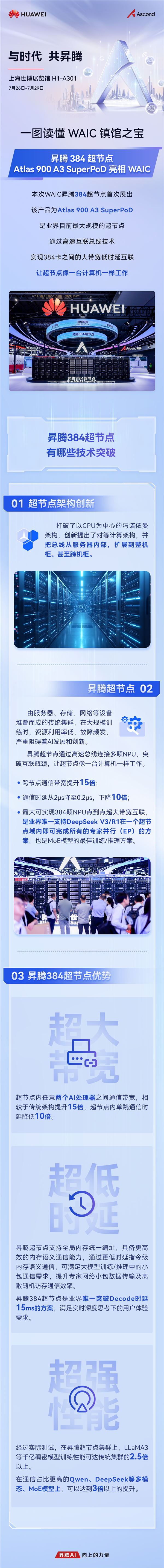

快科技7月29日消息,在7月26日-7月29日于上海世博展览馆H1-A301举办的WAIC(世界人工智能大会)上,华为昇腾384超节点,即Atlas 900 A3 SuperPoD首次展出,成为备受瞩目的“镇馆之宝”,是业界目前最大规模的超节点。

昇腾384超节点打破了以CPU为中心的冯诺依曼架构,创新提出了对等计算架构,还将总线从服务器内部扩展到整机柜、甚至跨机柜,极大地改变了数据传输和处理的方式。传统由服务器、存储、网络等设备堆叠而成的集群,在大规模训练时存在资源利用率低、故障频发的问题,严重阻碍AI发展。

而昇腾超节点通过高速总线连接多颗NPU,突破了互联瓶颈,让超节点像一台计算机一样协同工作。通信带宽飞跃:跨节点通信带宽提升15倍,使得数据传输速度大幅加快。通信时延骤减:通信时延从2μs降至0.2μs,下降了10倍,减少了数据处理等待时间。超强互联能力:最大可实现384颗NPU点到点超大带宽互联,并且是业界唯一支持DeepSeek V/R1在一个超节点域内即可完成所有专家并行(EP)方案的产品,也是MoE模型的最佳训练/推理方案,极大提高了模型训练和推理的效率。

昇腾384超节点拥有三大优势:超大带宽:超节点内任意两个AI处理器之间通信带宽,相较于传统架构提升15倍,超节点内单跳通信时延降低10倍,数据交互更流畅。超低时延:昇腾超节点支持全局内存统一编址,具备更高效的内存语义通信能力,通过更低时延指令级内存语义通信,可满足大模型训练/推理中的小包通信需求,提升专家网络小包数据传输及离散随机访存通信效率。而且昇腾384超节点是业界唯一突破Decode时延15ms的方案,能满足实时深度思考下的用户体验需求。超强性能:经过实际测试,在昇腾超节点集群上,LlaMA3等千亿稠密模型训练性能可达传统集群的2.5倍以上;在通信占比更高的Qwen、DeepSeek等多模态、MoE模型上,性能提升更是可以达到3倍以上。

【本文结束】如需转载请务必注明出处:快科技责任编辑:建嘉文章内容举报]article_adlist-->