阿里最新开源的电影级视频生成模型通义万相Wan2.2,集光影、色彩、镜头语言三大电影美学元素于一身,并提供60多个可控参数,显著提升电影级画面的制作效率。该模型单次可生成5秒高清视频,并支持多轮提示词进行短剧创作。此次开源包括文生视频、图生视频及统一视频生成三款模型,其中文生视频和图生视频模型采用了业界首个MoE架构,总参数量27B,激活参数14B,通过高低噪声专家模型协同工作,在提升复杂运动、人物交互和美学表达能力的同时,大幅降低了计算资源消耗。Wan2.2还具备媲美专业电影水平的电影美学控制系统,能根据用户输入的关键词生成多样化的视觉效果。

✨ **电影级美学元素集成与参数化控制**:通义万相Wan2.2模型将光影、色彩、镜头语言这三大电影制作的核心美学元素内嵌于模型之中,并提供了超过60个直观可控的参数,使得用户能够灵活组合这些元素,大幅提升了制作电影级画面的效率和创作自由度。

🚀 **高效视频生成与短剧制作能力**:模型单次即可生成5秒的高清视频,并支持用户通过多轮的提示词(prompt)指令进行连续的短剧内容创作,极大地简化了视频叙事流程。未来还将持续优化单次视频生成时长,进一步提升视频创作的整体效率。

💡 **首创MoE架构与资源优化**:Wan2.2开源的文生视频和图生视频模型是业界首个采用MoE(Mixture of Experts)架构的视频生成模型,总参数量27B,激活参数14B。这种架构由高噪声专家模型(负责整体布局)和低噪专家模型(负责细节完善)组成,在同等参数规模下,可节省约50%的计算资源,有效解决了视频生成中Token过长导致的计算资源消耗巨大的问题。

🌟 **显著的生成质量提升与美学控制**:在复杂运动生成、人物交互、美学表达等方面,Wan2.2相较于以往模型取得了显著提升。其首创的电影美学控制系统,能够精准控制光影、色彩、构图、微表情等细节,用户仅需输入如“黄昏、柔光、边缘光、暖色调、中心构图”等关键词,即可生成符合预期的画面效果,例如浪漫的落日余晖,或使用“冷色调、硬光、平衡图、低角度”生成科幻电影般的画面。

继上周阿里AI三连发后,阿里又扔出新的开源模型——电影级视频生成模型通义万相Wan2.2。Wan2.2可将光影、色彩、镜头语言三大电影美学元素装进模型,随意组合60多个直观可控的参数,大幅提升电影级画面的制作效率。

目前,该模型单次可生成5s的高清视频,用户可通过多轮提示词进一步完成短剧制作,未来通义万相还将继续提升单次视频生成的时长,让视频创作更高效。

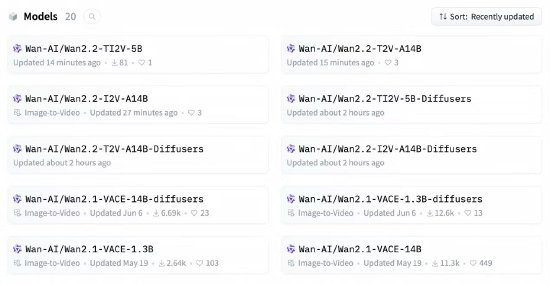

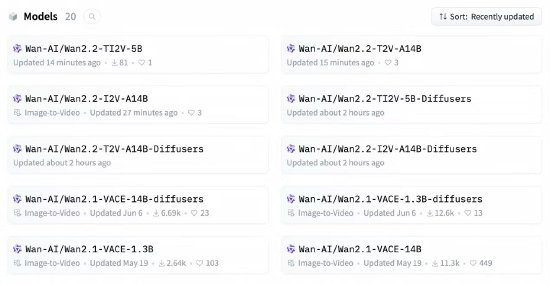

据悉,Wan2.2此次开源了文生视频(Wan2.2-T2V-A14B)、图生视频(Wan2.2-I2V-A14B)和统一视频生成(Wan2.2-TI2V-5B)三款模型,其中文生视频模型和图生视频模型均为业界首个使用MoE架构的视频生成模型,总参数量为27B,激活参数14B,均由高噪声专家模型和低噪专家模型组成,分别负责视频的整体布局和细节完善,在同参数规模下,可节省约50%的计算资源消耗,有效解决视频生成处理Token过长导致的计算资源消耗大问题,同时在复杂运动生成、人物交互、美学表达、复杂运动等维度上也取得了显著提升。

此外,Wan2.2还首创了电影美学控制系统,光影、色彩、构图、微表情等能力媲美专业电影水平。例如,用户输入黄昏、柔光、边缘光、暖色调、中心构图等关键词,模型可自动生成金色的落日余晖的浪漫画面;使用冷色调、硬光、平衡图、低角度的组合,则可以生成接近科幻片的画面效果。

查看评论