Lições de 12 meses projetando interfaces inteligentes para um setor tradicionalmente resistente à tecnologia.

O paradoxo do público low-tech na era da IA

Imagine descobrir que 55% dos advogados brasileiros já utilizam inteligência artificial em suas atividades diárias [1].

Para quem trabalha com tecnologia, isso pode não parecer surpreendente. Mas, para quem conhece o setor jurídico brasileiro, essa estatística é quase revolucionária.

Há um ano, quando entrei como Product Designer em uma empresa AI-first focada em auxiliar advogados na redação de documentos processuais, eu não fazia ideia da complexidade (e surpresas) que essa jornada traria. O que mais me impressionou, ao longo desse tempo, foi ver um público tradicionalmente low-tech que não apenas adotou a IA, mas começou a cocriar com ela.

Este artigo é sobre as lições que aprendi projetando para usuários que, simultaneamente, são competentes em suas áreas de expertise e cautelosos com tecnologia.

É sobre como descobrimos que “low-tech” não significa necessariamente “incapaz”, mas sim “seletivo”. E, principalmente, é sobre como o design de IA para esse público nos ensina princípios fundamentais que se aplicam muito além do setor jurídico.

Entendendo o usuário low-tech: além dos estereótipos

Quando falamos em usuários “low-tech”, é comum recorrermos a estereótipos. A imagem que frequentemente surge é a de pessoas mais velhas, resistentes à inovação, que insistem em métodos tradicionais por receio ou dificuldade de adaptação.

No entanto, a realidade que encontrei ao longo do último ano, especialmente entre advogados brasileiros, é bem mais complexa; e talvez isso também se aplique ao seu público, dependendo do contexto do seu produto.

O que muitas vezes chamamos de “low-tech” pode, na verdade, refletir um comportamento seletivo e criterioso diante da tecnologia.

Esses profissionais não evitam tecnologia por falta de capacidade, mas sim porque enfrentam diariamente sistemas tão pouco intuitivos que até mesmo nós, designers, nos vemos confusos diante deles.

Nesse cenário, a aparente resistência não é desinformação, mas uma resposta legítima à complexidade mal gerida.

O perfil do usuário low-tech competente

Os advogados com quem trabalhei são profissionais qualificados, muitos com décadas de experiência, que dominam completamente suas áreas de atuação. Eles navegam por sistemas jurídicos complexos, interpretam legislações intrincadas e constroem argumentações sofisticadas.

Sua relação com a tecnologia não é de incapacidade, mas de pragmatismo seletivo. Eles sabem usar o Word com maestria (eu mesma não sei) e navegam aquele sistema como se pilotassem um avião: conscientes de cada botãozinho.

Eles adotam, sim, tecnologias que claramente agregam valor ao seu trabalho, mas são extremamente céticos em relação a soluções que parecem complicar processos que já funcionam bem.

Não é resistência por resistência: é uma avaliação criteriosa de custo-benefício.

E ela inclui fatores como tempo de aprendizado, confiabilidade e impacto na qualidade e agilidade do trabalho.

A diferença entre resistência e cautela

Durante minha pesquisa com usuários, descobri que o que frequentemente interpretamos como “resistência à tecnologia” é, na verdade, uma forma sofisticada de gestão de risco.

Advogados lidam diariamente com consequências reais de erros: um documento mal elaborado pode custar um caso; uma interpretação incorreta pode prejudicar um cliente.

Essa perspectiva molda completamente como eles se relacionam com novas tecnologias. Eles não querem ser early adopters — querem ser adopters informados.

Não buscam a ferramenta mais inovadora, mas a mais confiável. E, principalmente, não querem abrir mão de controle sobre processos críticos.

A evolução em duas ondas: da I.A. invisível à co-criação

A maior descoberta do meu primeiro ano foi perceber que estamos vivendo uma mudança fundamental na forma como usuários low-tech se relacionam com IA. Essa mudança aconteceu em duas ondas distintas, cada uma com suas características, desafios e oportunidades. E essa evolução não é apenas uma observação local: ela reflete uma tendência global documentada por pesquisas recentes.

Segundo o relatório The State of AI da McKinsey de 2025, a adoção de IA por organizações saltou de 20% (2017) para impressionantes 78% (2024) [2]. Mais significativo ainda, o uso de IA generativa aumentou de 33% para mais de 65% apenas no último ano, indicando uma aceleração dramática na familiarização com tecnologias de IA [2].

1. Primeira onda: a era da I.A. escondida

A estratégia da invisibilidade

No início, nossa estratégia era simples: esconder a IA dos usuários.

Essa decisão pode soar contraintuitiva, especialmente em um momento em que tantas empresas estavam correndo para exibir o “poder” da IA de forma explícita. Mas, para o nosso contexto — uma ferramenta voltada para advogados brasileiros — a exposição direta da IA criava mais ruído do que clareza.

Sempre que tentávamos seguir pelo caminho de tratar a IA de forma mais explícita, percebíamos um padrão: dar controle total ao usuário parecia empoderador em teoria, mas, na prática, levava ao caos.

As tarefas se desvirtuavam, os resultados ficavam inconsistentes e a intenção do usuário se perdia na tentativa de comandar algo que ele ainda não entendia bem.

Mais do que isso, percebíamos que dar mais controle ao usuário não aumentava sua sensação de responsabilidade; pelo contrário: ele continuava se isentando dos resultados, independentemente do nível de liberdade que tinha.

Se algo dava errado, a culpa era da plataforma. Nunca da forma como a IA foi instruída. Criávamos, sem perceber, um espaço onde o usuário era, ao mesmo tempo, agente e vítima de um sistema que não dominava.

Então sempre voltávamos para o nosso próprio caminho: ao invés de abrir todas as alavancas, reduzíamos a exposição. A IA trabalhava em segundo plano, atuando como um assistente silencioso. Priorizávamos fluxos mais guiados, menos abertos, com limites claros e pontos de intervenção bem definidos.

O objetivo era simples: tirar do usuário a obrigação de entender a lógica da IA e devolver a ele o foco na tarefa que realmente importava.

Essa abordagem estava alinhada com o que pesquisadores chamam de “IA passiva”: sistemas que funcionam como ferramentas que aguardam input humano para executar tarefas específicas [3].

O usuário enviava informações por formulários estruturados, e o sistema “magicamente” retornava documentos prontos. A IA trabalhava nos bastidores, invisível e silenciosa. O controle do usuário era mínimo. Eles podiam fornecer inputs, mas não influenciar o processo ou entender como os resultados eram gerados.

Essa abordagem funcionou, pelo menos inicialmente. Conseguimos onboarding rápido e resultados consistentes. Usuários que nunca interagiram com IA estavam se beneficiando dela diariamente.

Dados da época (2024), sobre um público que pode refletir o mesmo caminhar do público jurídico, mostram que a resistência inicial à IA era significativa: pesquisas indicavam que até 76,6% dos servidores públicos apontaram “resistência à mudança” explicitamente como obstáculo à adoção da IA.

Com o tempo, porém, as limitações desse modelo começaram a aparecer — especialmente à medida que nosso público ganhava mais familiaridade com o uso de IA.

Quando os resultados não saíam exatamente como esperavam, os usuários queriam poder ajustar ou refinar. Os mais curiosos buscavam entender por que certas decisões haviam sido tomadas, mas não encontravam explicações.

À medida que a confiança na ferramenta crescia, surgia também o desejo por mais controle sobre o processo.

2. Segunda onda: o despertar da co-criação

A mudança começou de forma sutil.

Usuários que inicialmente só queriam “apertar um botão e receber o resultado” começaram a fazer perguntas:

- Por que o sistema escolheu essa abordagem?Posso ajustar esse parágrafo?Como faço para que ele entenda melhor o que eu quero?

Esta evolução reflete uma tendência global documentada.

Segundo o relatório da McKinsey (2025), quase todas as organizações já investem em IA generativa e estão redesenhando seus processos para integrar IA e ação humana. Até 2026, espera-se que a maioria delas use IA para decisão, com foco na colaboração humano‑IA, incluindo governança executiva e treinamento — e não uma automação puramente técnica.

Foi quando começamos a expor parte do funcionamento da IA que percebemos: nossos usuários já não eram os mesmos de antes.

Nossos usuários não apenas haviam se acostumado com a presença da IA — agora queriam fazer parte ativa do processo.

Queriam dar o tom, influenciar o estilo, ajustar o conteúdo. Só que, ao mesmo tempo, ainda precisavam de direcionamento para não se perder em possibilidades infinitas.

Essa nova postura inaugurou o que chamamos de segunda onda: um momento em que a invisibilidade já não era suficiente, e a demanda por participação começava a crescer.

O desafio, então, deixou de ser esconder a IA e passou a ser criar um modelo de interação que equilibrasse familiaridade e inovação.

Se fôssemos técnicos demais, afastaríamos os usuários.

Se simplificássemos demais, engessaríamos o potencial da IA [7].

A resposta veio com o conceito de co-criação guiada: interfaces que abrem espaço para personalização e influência, mas em estruturas que protegem o usuário da complexidade técnica e garantem a qualidade do resultado.

Era o início de um novo tipo de interface: uma que deixasse espaço para o inesperado, sem deixar o usuário desamparado.

Este conceito se alinha com o que autoridades digitais definem como “IA agêntica”: sistemas que compreendem objetivos dos usuários, decompõem tarefas complexas e executam ações proativamente, mas sempre em colaboração com humanos [6].

Essa transição para a co-criação não significou abandonar os princípios da primeira fase, mas sim evoluí-los.

Se antes o desafio era simplificar a interação com a IA, agora o desafio é equilibrar liberdade e estrutura.

Seguimos criando limites; não para restringir, mas para orientar.

5 diretrizes para interfaces de I.A. com autonomia controlada

Com base nas experiências que vivemos e nas heurísticas validadas por estudos como o de Li et al. (2023) sobre interação humano-I.A., trago aqui 5 diretrizes práticas que podem ajudar designers a construir interfaces que encorajam a colaboração com sistemas inteligentes sem exigir domínio técnico.

1. Deixe claro o que a I.A. pode — e o que não pode — fazer

(HAI Guideline 1: Make clear what the system can do)

Antes de permitir qualquer interação mais aberta, o sistema precisa comunicar suas capacidades com precisão. Evite frases genéricas como “usamos IA para te ajudar”. Seja específico.

Isso gera confiança, define o escopo da colaboração e reduz frustrações em relação ao que o sistema não faz, algo que o estudo mostrou ter impacto direto na percepção de utilidade e performance.

Aplicação genérica: Apresente exemplos concretos do que a IA pode entregar e use linguagem clara, sem exagerar nas promessas. Uma lista de “ações que a IA consegue realizar” pode funcionar melhor que uma explicação técnica.

Exemplo: ChatGPT

Antes da primeira interação, o ChatGPT apresenta uma tela com exemplos de prompts.

Interface mostra o que ele pode fazer com frases como:

- “Sugira ideias para minhas próximas férias”, ou“Ajude-me a escrever uma carta de apresentação”.

2. Crie espaços para correção e refinamento sem exigir expertise

(HAI Guideline 9: Support efficient correction)

Usuários querem interferir no que a IA faz, mas não querem aprender prompt engineering ou linguagens formais para isso.

Por isso, criar mecanismos simples de ajuste (como editar uma sugestão, substituir um termo ou indicar que algo está fora de contexto) é muito mais poderoso do que abrir uma caixa de prompt livre.

Aplicação genérica: Ofereça botões de edição leve (“reformule este parágrafo”, “adicione argumentos sobre X”), sugestões de reescrita, e painéis de revisão com ações comuns.

Exemplo: Notion AI

Quando seleciona um parágrafo, aparecem botões como:

- “Identificar tarefas”“Traduzir”“Resumir”“Explique isso”

Você não precisa digitar nenhum prompt. Só clicar.

3. Permita a intervenção, mas só quando fizer sentido

(HAI Guideline 10: Scope services when uncertain + Guideline 7: Support efficient invocation)

Nem todo momento é ideal para o usuário interferir. Ao invés de abrir sempre todos os controles, o sistema pode convidar o usuário a agir quando identificar baixa confiança ou ambiguidade. Isso equilibra poder com responsabilidade e evita sobrecarga.

Aplicação genérica: Quando a IA estiver incerta sobre uma sugestão, mostre isso claramente (“Não tenho certeza sobre este argumento, quer revisar?”). Use visualizações sutis de confiança ou áreas onde o input humano é mais necessário.

Exemplo: Grammarly

Nesta tela do Grammarly, o sistema identifica que a frase escrita pelo usuário (“We glued together the vase we broke quietly”) apresenta uma estrutura confusa, que pode afetar a clareza da mensagem.

Em vez de interromper a escrita a todo momento ou abrir espaço para edição manual, o sistema age de forma pontual e estratégica:

- Sinaliza o trecho problemático com sublinhados sutis, indicando onde há baixa clareza.Apresenta uma sugestão de reescrita no painel lateral, reformulando a frase para: “We glued the vase we broke back together quietly.”Explica que a nova versão pode tornar o texto mais eficaz, sem impor a mudança.Oferece botões claros para o usuário decidir entre “Usar esta versão” ou “Ignorar”, sem exigir conhecimento técnico ou prompt complexo.

A intervenção da IA só acontece porque há indícios de ambiguidade ou baixa confiança na redação. Em outras palavras: o sistema só pede revisão quando há motivo real, o que reduz ruído cognitivo e fortalece a sensação de colaboração entre humano e máquina.

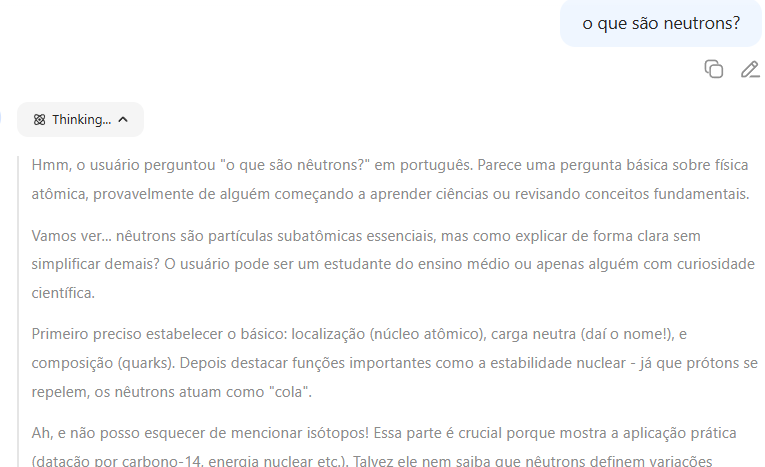

4. Explique as decisões da I.A. mesmo que de forma simplificada

(HAI Guideline 11: Provide explanations)

Ao permitir que o usuário co-crie com a IA, é fundamental que ele entenda por que o sistema fez certas escolhas. A ausência de explicação mina a confiança e reduz a sensação de parceria.

Aplicação genérica: Use tooltips, comentários laterais ou visualizações curtas para justificar ações da IA (“Este trecho foi gerado com tal finalidade”).

Exemplo: Deepthink do DeepSeek

A funcionalidade “Deep Thinking”, presente nos modelos da DeepSeek, é um exemplo claro de como explicações geradas pela IA podem aumentar a confiança do usuário e fomentar a coautoria.

Em vez de fornecer apenas a resposta final, o sistema expõe, de forma estruturada e didática, os passos de raciocínio que levaram àquela conclusão como se fosse um “pensamento em voz alta da IA”.

Essa abordagem ajuda o usuário a entender a lógica por trás da sugestão, identificar possíveis falhas e tomar decisões com mais segurança.

5. Permita personalização gradual (e segura)

(HAI Guideline 17: Provide global controls + Guideline 15: Learn from user behavior)

Usuários experientes vão, inevitavelmente, desejar ajustar o comportamento da IA. Ao invés de oferecer isso desde o início, pense em um modelo de destravamento progressivo: a personalização surge conforme o uso, sempre de forma assistida.

Aplicação genérica: Comece com opções simples (“preferência por estilo de escrita mais formal ou direto”) e vá adicionando opções avançadas apenas para quem explora ou solicita. Tudo com histórico claro e botão de “voltar ao padrão”.

A co-criação guiada nos mostrou que usuários considerados “low-tech” podem ser, na verdade, os mais estratégicos na forma como interagem com novas tecnologias.

Eles não querem apenas autonomia; querem confiança.

E a confiança se constrói quando o sistema oferece clareza, previsibilidade e espaço para participação sem exigir que o usuário se torne um expert em IA.

O design de interfaces inteligentes precisa ir além da eficiência: ele deve criar relações.

Relações de parceria, em que o usuário sente que está no comando, mesmo quando não entende todos os bastidores e sente que pode confiar na IA, não por ser mágica, mas porque ela o escuta, responde e respeita sua intenção.

Caso queira conhecer as aplicações que fiz em meu trabalho real, acesse:

Jurídico AI - Assistente jurídico de Inteligência Artificial

Lá você poderá ver diversas aplicações desses conceitos em fluxos diferentes.

Se quiser saber mais sobre é só mandar um alô via LinkedIn.

Referências

- Migalhas. “O impacto da IA no cenário jurídico brasileiro”.McKinsey & Company. (2025). The state of AI: The state of AI: How organizations are rewiring to capture value.

Superagency in the Workplace: Empowering people to unlock AI’s full potential. McKinsey, 28 jan. 2025. McKinsey Global Survey on AI.AllUpNext IT Solutions LLP. (2025). From Passive Tools to Active Agents: The Future of Human-AI Collaboration. LinkedIn.Liao, Q. V., & Vaughan, J. W. (2024). AI Transparency in the Age of LLMs: A Human-Centered Research Roadmap. Harvard Data Science Review.Forbes Technology Council. (2025). The New Era of Work: Human-AI Collaboration Is Redefining the Modern Workplace.AWS (site corporativo). What Is Agentic AI?.Wroblewski, L. (2025, Junho 9). Agent Management Interface Patterns.MONTEZANO, Lana; OLIVEIRA, Hudson Onofre de; ALENCAR, Walisson Barbosa de; SILVA, Tiago Gomes da; PEREIRA, Adriana Aparecida Coelho. Percepção de servidores públicos quanto ao uso da inteligência artificial no setor público.LI, Tianyi; VORVOREANU, Mihaela; DEBELLIS, Derek; AMERSHI, Saleema. Assessing Human-AI Interaction Early through Factorial Surveys: A Study on the Guidelines for Human-AI Interaction.

Da resistência à co-criação: O que aprendi projetando um produto de IA para advogados brasileiros was originally published in UX Collective 🇧🇷 on Medium, where people are continuing the conversation by highlighting and responding to this story.