DRUGAI

大语言模型(LLMs)为化学研究提供了新的发展机遇,包括研究规划、实验优化、数据分析、自动化执行和知识管理等方面。将LLM部署于活跃的环境中(即能与工具和数据实时交互的场景)将大幅提升其能力。然而,评估其性能仍存在困难,同时也需应对诸如可重复性、数据隐私与偏见等伦理问题。本文系统探讨了LLM在化学研究中的现有与潜在应用,并指出其在研究中扮演“主动科学伙伴”的路径与挑战。

在数据科学和统计机器学习推动下,化学科学正步入“第四范式”,数据驱动方法逐渐取代或补充传统研究模式。研究人员已经开始使用机器学习预测分子、材料和化学反应的性质,优化实验流程,从文献中提取数据,加速模拟过程,并推动实验的自动化执行与结果解析。

LLM的兴起为化学研究进一步开辟了前沿。借助变换器架构,LLM能够接受文本、图像、音频等多模态输入,并以文本形式生成响应。在化学领域,研究人员已将LLM用于分子表示生成、新分子的设计,以及代码执行和实验控制等场景。部分系统(如Coscientist、ChemCrow)还集成了实验执行工具,使LLM具备主动规划实验的能力。

本文旨在全面阐述LLM在化学、化工和材料科学等领域的应用价值,并从评估标准、研究环节、工具集成及伦理等多个维度出发,探讨如何有效发挥其科学潜能。

评估大语言模型

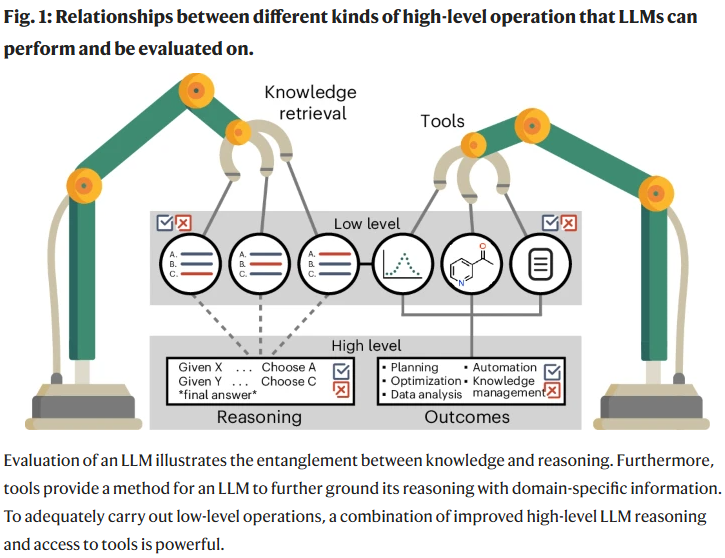

研究人员使用多种策略来评估LLM的能力,包括知识检索与推理能力的测试。常用方式包括选择题、结构转换、反应产物预测和性质估算等,但这些测试往往无法真实反映LLM在现实科研场景中的表现。相较之下,结合人类偏好数据的评估平台(如Chatbot Arena)能更精准地反映模型在开放性问题上的推理质量。

此外,LLM在执行复杂科研任务时表现出“奉承倾向”,这在化学知识有限的情境下可能导致误导性结论。因此,评估LLM在主动式任务(如实验规划与工具调用)中的表现也至关重要。这类评估强调其选择工具的时机与参数是否合理,最终是否实现了期望目标。

为更全面地评估LLM,研究人员提出构建虚拟科研环境(类比OpenAI Gym),以模拟实验任务并观察模型的表现路径,包括其推理过程、调用工具的逻辑顺序以及最终产出的科学结果。这不仅有助于识别模型能力边界,也为多工具协同测试与失败恢复策略的设计提供了基础。

研究人员还指出,当前通用型LLM在诸如化学命名转换、反应产率预测等任务上的表现仍不理想,部分专用模型虽能达到90%以上准确率,但大多数LLM仍难以超越传统机器学习模型。此外,LLM在人类专家难以覆盖的任务中,如基于实验数据生成新假设,表现出一定潜力,表明其在“未知问题”场景中具备补充人类的可能。

最后,为提升评估结果的信度,研究人员主张结合自动评分与人工评估两种方式,前者提高效率,后者减少偏倚。社区协作型平台如Chatbot Arena、Elo评分系统等也被提倡用于大规模对比评估。

跨越计算科学与化学科学

为明确LLM在化学研究中的潜力,研究人员首先需要定义具体、明确的任务,并回答两个核心问题:(1)LLM是否适用于该任务?(2)LLM在此任务中可能达到何种表现?

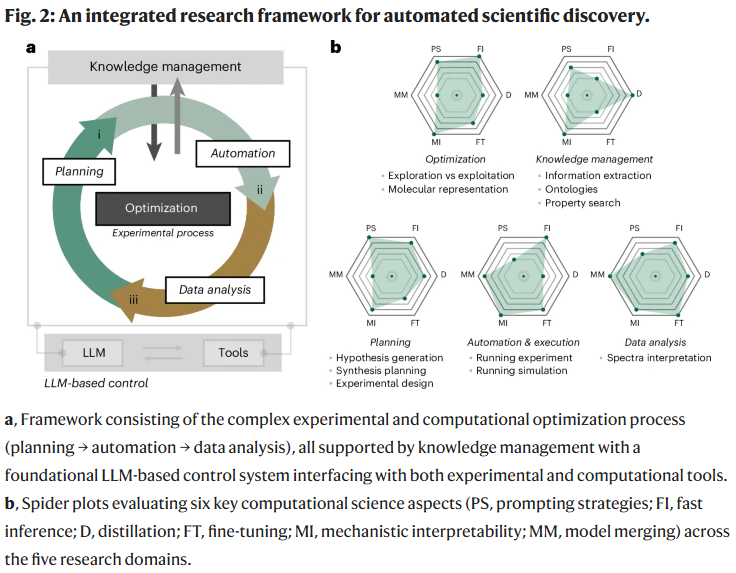

要解答上述问题,必须评估LLM在实际研究中的实用性和有效性。研究人员将化学科学研究流程分为五个主要阶段:规划、优化、数据分析与解释、自动化与执行,以及知识管理。并在此基础上讨论将LLM应用于每个环节所需的核心条件与注意事项。

在规划阶段,LLM需具备提出科学问题、形成假设并设计实验的能力;在优化阶段,则需有效建立输入条件与目标指标之间的响应关系;在数据分析阶段,LLM需能从谱图、质谱等复杂信号中提取关键特征;在自动化执行中,LLM需能与实验设备对接,实现任务转化与指令生成;而在知识管理中,LLM则需能高效检索、归纳和存储科研知识,实现科学信息的结构化与复用。

每一阶段都对LLM的知识理解、推理逻辑、数据整合与工具协同能力提出不同的要求,研究人员指出,在有工具协助的主动式环境中,LLM的表现明显优于静态回应提示的被动式环境。只有在“能理解上下文、能调用资源、能做出判断、能执行行动”的四位一体框架中,LLM才能真正成为高效的科研合作者。

深度集成带来的叠加性收益

LLM不仅应用于自然语言处理研究,也逐步被引入强化学习领域。例如,Decision Transformer通过将强化学习问题建模为序列预测问题,利用变换器架构预测未来动作,从而实现策略优化。基于这一理念,研究人员开始将LLM生成的响应解析为“行动”,通过这些行动与环境交互,再获取新观测并生成下一轮行动。

该过程的有效性在很大程度上取决于提示策略和执行时的计算方式。一些模型(如DeepSeek-R和OpenAI的某些变体)通过推理激励机制显著提升了在复杂任务中的性能。此外,这类LLM生成的动作可以被进一步映射为工具调用,包括代码执行、数据库查询,甚至在物理世界中启动实验任务。

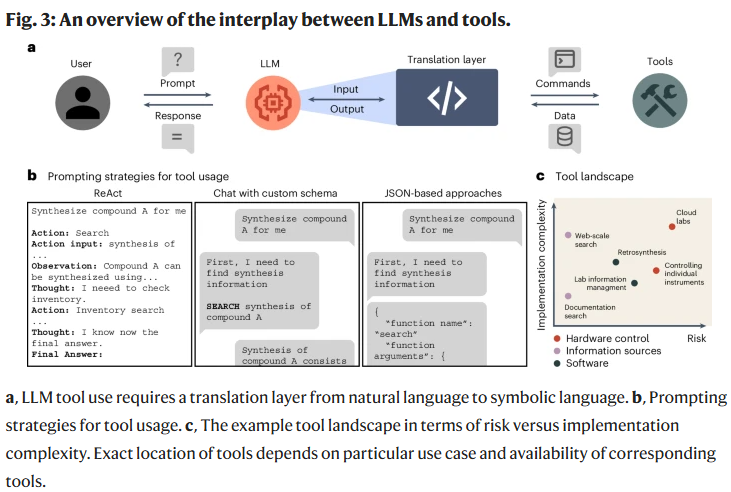

实现这一目标的关键在于构建“工具增强型”LLM系统。研究人员将工具定义为LLM可直接调用并返回结果的任何固定协议。在代理系统中,工具使用涉及三个核心方面:(1)工具的潜力与适用范围;(2)使用工具所体现的代理行为与推理逻辑;(3)LLM与工具之间的信息流动机制。

例如,集成数据库(如Reaxys或SciFinder)可为LLM提供结构化的权威信息,显著减少因幻觉引发的错误;调用合成规划、光谱解析或量子化学模拟软件也可扩展LLM的计算能力。然而,这些工具的集成难度不一:从简单的文档搜索到复杂的合成路径设计,其开发与部署复杂度显著不同。

更进一步,LLM还可与实验平台集成,实现与非数字化对象(如仪器、化学品)的交互。云实验室就是一例,允许LLM代理远程控制实验任务。这种深度集成既带来巨大潜能,也伴随高风险,因此需引入统一的标准与安全机制。

研究人员指出,仅有工具还不足以实现智能协作,LLM还需掌握合理调用工具、安排执行顺序并处理异常情况的能力。提示工程策略(如ReAct、链式思维、结构化输出模板等)正被用于提升其函数调用效率与逻辑推理能力。与此同时,研究人员也在探索如何衡量LLM的“多工具并行使用能力”与“故障适应能力”——这两项能力是实现高效科研流程的关键所在。

从化学信息交换的角度看,另一个挑战是如何表示化学实体。例如SMILES虽为主流,但不利于LLM直接操作;IUPAC命名较复杂,格式转换困难;CAS号虽具唯一性但缺乏结构信息;而光谱数据常为专有格式,难以标准化处理。因此,构建支持多种模态的科学AI系统成为突破方向。

总体而言,工具增强型LLM系统为科学研究提供了坚实基础,也是推动化学研究范式转型的核心技术路径。

实施挑战

尽管LLM已展现出广泛应用潜力,但其在科研实际部署中仍面临一系列工程难题和系统性障碍。

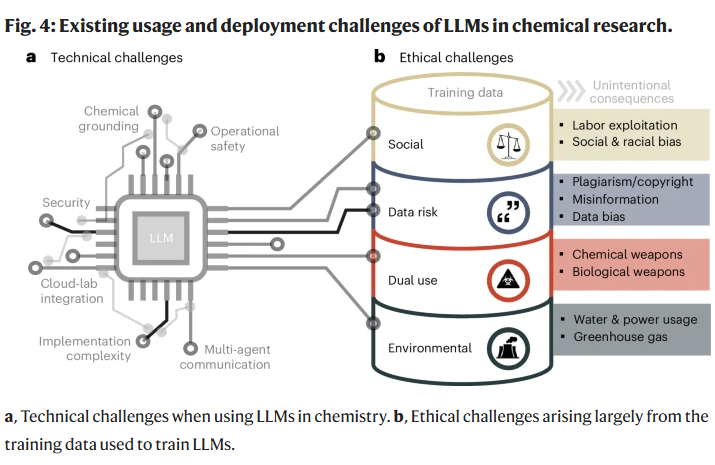

从技术角度看,首要挑战在于LLM模型本身并非为了生成“事实正确”的输出而设计,其训练数据中包含大量未经标注的真伪信息,因此产生“幻觉”现象在所难免。对于化学实验等高风险场景,这种幻觉不仅是学术偏差,更可能引发环境与安全事故。例如,错误推荐有毒物质、错误混合不相容试剂或给出错误处置方式等。

为缓解此问题,研究人员提出了“化学约束”策略,即为LLM补充结构化、权威的领域知识,例如接入可信数据库(如专利数据库、预印本、开放实验数据)、嵌入因果图谱或物理规则约束等方式。此外,借助外部工具对LLM输出进行二次验证也被认为是一条可行路径。

另一个关键挑战是模型的执行效率和交互能力。现有LLM在多步交互中生成速度较慢,难以支撑动态复杂任务。对此,研究人员提出可建立多路径执行队列,通过候选执行方案的评分与重排序机制优化最终输出。该策略尤其适用于多代理系统(multi-agent systems),可提升任务并行化能力与稳定性。

此外,由于不同工具接口标准不一,跨平台、跨语言的工具调用仍缺乏通用接口标准。若能建立统一的“翻译层”,将自然语言意图高效映射为结构化指令,将极大简化LLM代理系统的开发与维护。

从实验层面看,即使LLM已能连接至自动化实验平台(如云实验室),但仍需应对三类高层级挑战:

安全性:包括操作者与仪器安全,尤其是在生成有毒或高反应性物质时,必须具备多层防护机制(如危险组合验证模块、实时反应监控、异常处理协议等)。

通量限制:当前云实验室的运行效率远低于制药行业的高通量平台,因此需精心设计实验队列,使每一次实验都能最大化信息回报。

调度与集成问题:不同实验平台在通信协议、软硬件接口方面存在较大差异,缺乏统一调度标准阻碍了实验代理系统的推广。

研究人员提出,可通过构建“合成代理”、“筛选代理”等子模块,由主代理协调任务、评估资源使用率并合理分配执行顺序,从而提升整体系统效率。

综上所述,LLM要真正融入科学实验,需解决信息正确性、执行效率与系统接口三大瓶颈。通过强化安全机制、标准化接口与任务调度策略,有望推动LLM从语言工具迈向科研合作者。

科学研究中LLM的伦理考量

尽管LLM在科学研究中展现出强大能力,其伦理挑战亦不可忽视。首先,LLM输出的可重复性面临质疑,因为其训练数据来源不透明,研究人员难以判断特定回答是否基于可靠来源。这直接影响科学结论的可验证性与引用规范性。

其次,训练与部署LLM所需的能源、水资源及碳排放规模庞大,单一模型的训练甚至可能释放数百吨二氧化碳。尽管研究人员希望LLM的效率提升可抵消其环境成本,但该平衡仍需持续评估。

在社会维度上,LLM易受数据偏见影响。生物与药物化学研究中若未充分控制偏差,LLM可能在不经意间将生物过程与人口特征(如种族、性别)错误关联,进而误导实验设计或结论解释。这类隐性风险,往往难以察觉,却可能对边缘群体造成长期负面影响。

此外,LLM具备强大的化学知识生成能力,但也引发了被滥用于合成危险或受管制化合物的担忧。当前的防范措施主要依赖专家手动测试和策略防火墙,但面对复杂的化学路径空间,这些手段的覆盖范围仍有限。

因此,研究人员强调,应在全行业范围内建立明确的LLM使用规范与伦理框架。例如,正如化学家评估实验是否“绿色”一样,也应评估LLM是否可持续、透明并具社会责任感。该框架应由科学家与模型开发者共同制定,确保LLM真正为科学发展与社会福祉服务。

展望

LLM在科研系统中的广泛部署,正推动科学研究发生深刻变革。随着这类系统与实验自动化平台的紧密融合,研究人员将迎来一个“正反馈”循环:更多的数据促进模型能力增强,进而推动更具策略性的实验设计与数据生成。该循环有望将传统科研所需的几十年时间压缩至几年内完成,彻底改变催化剂设计、材料发现与药物研发等多个核心领域的发展路径。

远程实验的发展还使研究人员得以脱离危险化学操作环境,显著降低实验风险。LLM的主动部署也将提升科研安全性——从建模潜在反应风险、实时监测反应条件到自动执行应急措施,皆可实现多重防护。

随着这一转型,科学家的角色也将发生演变:不再只是实验执行者,而是AI驱动的科研战略制定者,引导与解释由模型生成的发现。化学研究将进入“分子编程”时代,科学家像编写程序一样操控现实世界的物质行为。正如软件工程师构建虚拟世界,未来的化学家将通过LLM撰写指令,创造现实中曾经难以想象的分子系统。

这一范式转移也提出了关于“科学发现本质”的新思考。传统科研常依赖偶然发现与直觉突破,而LLM支持的科学流程将更具系统性与可重复性。然而,真正强大的系统或许并非全然排除偶然性,而是在设计上“诱发受控偶然”,即让AI具备识别并探索意外观察现象的能力。这种“受控的惊喜”机制可能帮助科学家发现人类直觉难以洞察的新原理,启发新材料与反应路径的发现。

最终,LLM的持续进化将实现“人机共创”的科研范式:结合人类创造力与机器能力,推动化学创新走向更加开放、智能与高效的未来。

整理 | WJM

参考资料

MacKnight, R., Boiko, D.A., Regio, J.E. et al. Rethinking chemical research in the age of large language models. Nat Comput Sci (2025).

https://doi.org/10.1038/s43588-025-00811-y

内容中包含的图片若涉及版权问题,请及时与我们联系删除