Google DeepMind部門本周公布一款能執行在機器人上的Gemini Robotics On-Device,不需網路也能執行,並且具備高度任務泛化能力。

今年3月,Google介紹了一款視覺語言動作(vision language action,VLA)模型,將Gemini 2.0的多模態推理和實體世界理解能力帶進機器人領域。而本周Google DeepMind進一步公布Gemini Robotics On-Device,是該公司可直接執行在機器人上的最強大模型。且由於Gemini Robotics On-Device的模型運作不依賴資料網路,因而適合對延遲性十分敏感的應用程式,在頻寬不穩甚至沒有網路地區也能穩定運作。

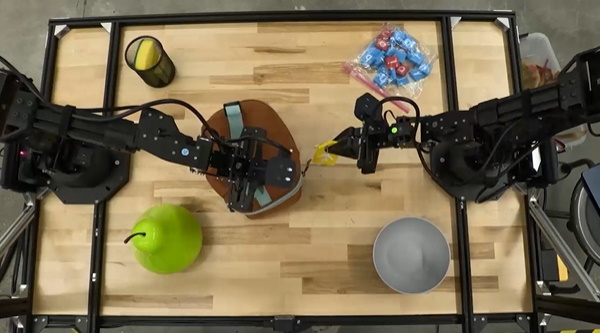

Gemini Robotics On-Device是雙臂機器人的基礎模型,只需最少的運算資源。它是建立在Gemini Robotics的任務泛化及靈活性基礎上而開發。Google強調它設計宗旨是快速實驗、靈活操控,能透過微調適應新任務,而且能在本地執行低延遲性的推論。

Gemini Robotics On-Device能在多種測試場景展現強大的視覺、語意和行為泛化能力,超越Gemini Robotics和其他裝置上執行的模型,且能遵從自然語言指令,透過在機器人端執行而完成高難度任務,像是解開袋子拉鏈,或折疊衣服。

圖片來源/Google

Gemini Robotics On-Device也是Google首個開放微調的VLA模型。它在未微調情況下也能執行眾多任務,但開發人員還是可以加以微調以適應新領域,過程中開發人員只需給予50到100次示範。

Gemini Robotics On-Device是以ALOHA機器人訓練,但Google示範,經過微調,也能執行在第三方廠商的機器人,如德國Apptronik的Franka FR3雙臂工業機器人或Apollo人型機器人。

Google並釋出Gemini Robotics SDK,可幫開發人員評估Gemini Robotics On-Device用於其環境下或任務的效能,他們也可以利用Google幾年前釋出的MuJoCo物理模擬函式庫測試模型,並快速適應其他新領域。開發人員現在只要報名加入信賴測試員計畫即可存取SDK。