6月7日上午,智源大会「下一代AI路径探索」专题论坛如期举行。人工智能发展迅猛,其未来路径与方向成为科研关键命题。本次智源大会特设论坛,邀请领域资深学者,从多维度探索下一代 AI 发展:生成式模型方面,聚焦 Transformer 与 Diffusion 的理论、实践及架构创新;知识融合路径上,关注神经符号等交叉探索;系统层面,探讨硬件设计、效率优化与软硬协同;此外,还涵盖类脑启发模型、图与离散数据处理等前沿方向。

本次论坛由清华大学人工智能研究院副院长、生数科技创始人兼首席科学家朱军主持,邀请到石佳欣博士、清华大学教授汪玉、伊利诺伊大学芝加哥分校教授俞士纶、香港理工大学助理教授吴郁杰、南京大学副教授戴望州等全球AI领域的领军人物,通过开放多元的交流,推动下一代 AI 路径的思想碰撞与探索。以下是核心内容整理:

(回放链接:https://event.baai.ac.cn/live/901)

关于下一代生成模型与架构的思考

石佳欣丨PhD

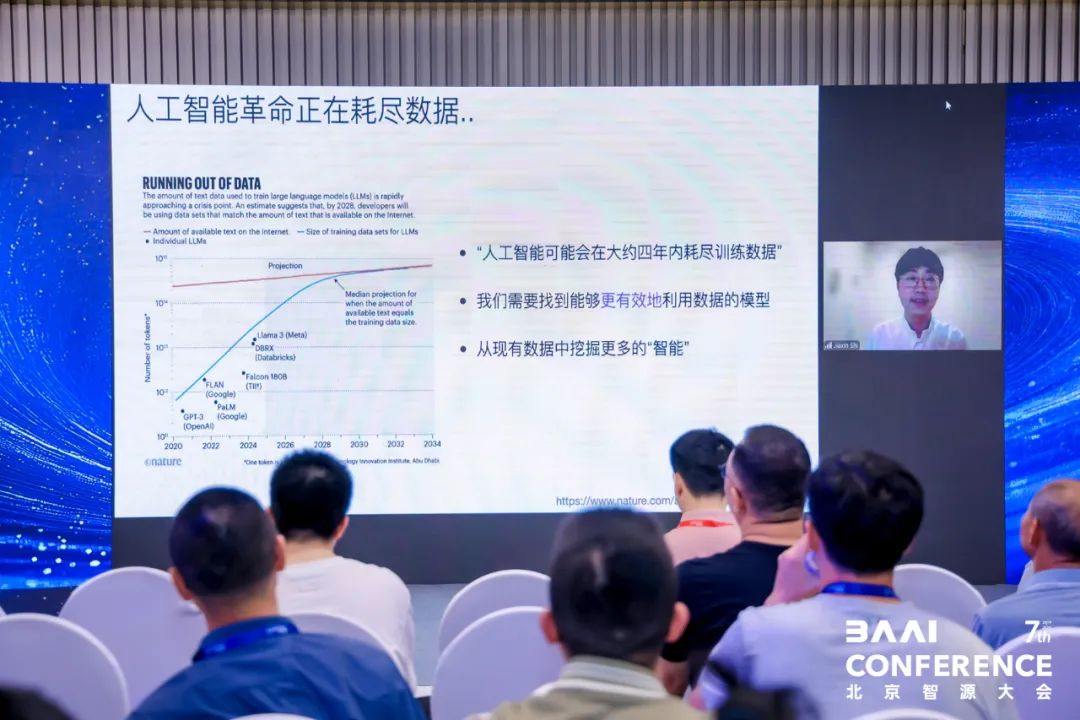

石佳欣博士在论坛中指出,当前大语言模型驱动的 AI 发展正面临数据耗尽危机 —— 按现有数据增长曲线预测,4 年后互联网数据将被大模型耗尽,迫使学界探索更高效的数据利用模型。生成式 AI 的核心是对高维数据拟合联合概率分布,而自回归模型通过 Transformer 架构分解条件分布,但 Soft Attention 的时空复杂度限制了多模态拟合能力,催生了线性注意力、状态空间模型等新架构探索。

首先针对“下一代Transformer何时出现”的行业之问,石佳欣提出,当前架构设计仍以经验驱动为主,缺乏统一理论框架。他团队提出的“Test-time Regression”框架,将架构设计抽象为回归问题,通过选择函数空间、分量重要性和优化算法三步法,统一解释了Linear Attention、状态空间模型(SSM)等新兴架构的设计逻辑。例如:

·线性注意力(Linear Attention) 本质是加权线性回归,通过外积更新状态实现高效计算;

·自注意力(Self-Attention) 则可视为局部多项式回归,其非线性拟合能力更强但计算成本更高。

实验表明,高阶回归对应的架构在时间序列预测任务中表现更优,验证了理论框架的指导价值。石佳欣呼吁,未来需建立更严谨的“架构设计科学”,以系统性突破现有局限。

其次自回归模型的单一次序生成范式在复杂场景中存在局限:游戏环境探索、科学数据建模等场景需要任意次序生成能力。掩码扩散模型作为代表,近期被证明可通过随机掩码训练实现有效生成,但语言模态的线性次序特性使其并非最优解。未来需发展能处理任意次序的生成模型,作为多模态探索的基石。

现有掩码扩散模型的 “随机掩码纠错”(Uninformed correction)缺乏上下文理解,如 “Table Jumps” 错误需人工定位。下一代模型需具备 “Informed correction” 能力,通过上下文直接定位错误区域,而非依赖随机掩码。这一能力将显著提升生成模型在逻辑推理、复杂任务中的可靠性。

石佳欣最后总结:

1.架构设计科学化:通过理论框架统一经验性探索;

2.生成范式革新:从单一次序转向任意次序建模;

3.智能纠错能力:从随机纠错升级为上下文感知的精准修正。

面向智能无人平台高能效系统的设计

汪玉|清华大学教授

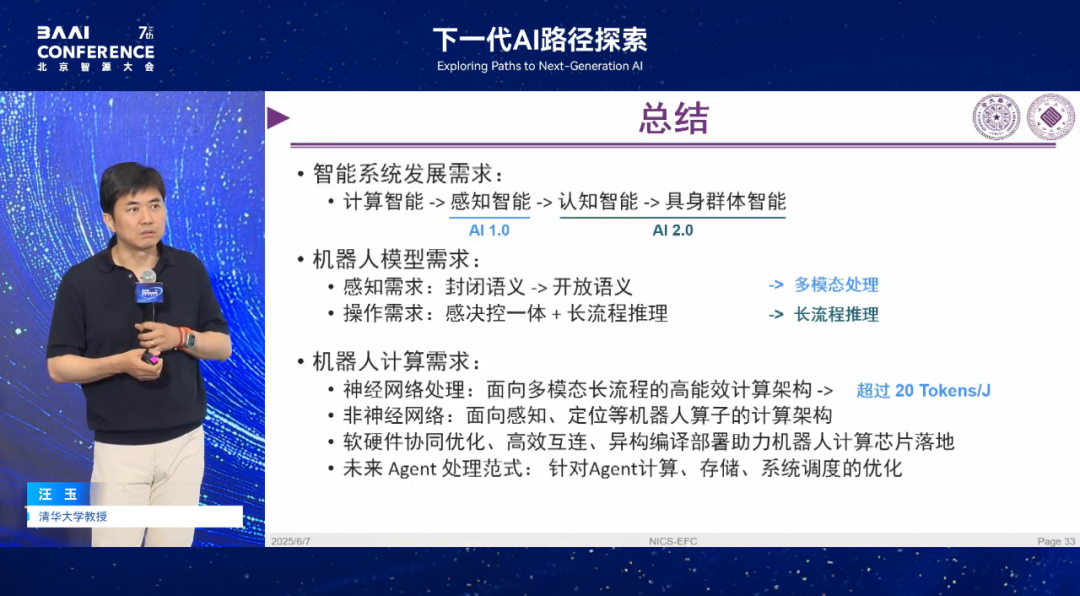

在本次论坛中,清华大学汪玉教授分享了面向智能无人平台的高能效系统设计的前沿思考,从群体智能、通信优化、智能算法到面向具身的架构,为机器人技术的未来发展提供了系统性解决方案。

群体智能:从单机到协作的必然演进

汪玉教授回顾,2018 年其团队面临 AI 芯片领域竞争激烈的局面,转而思考新方向。当时受知识图谱启发,探索知识图谱与深度学习结合的稀疏结构,后虽发现 Transformer 成为主流,但由此开启了面向具身智能的研究。从硬件角度看,单位瓦特计算次数提升有限,故转向多智能体协作方向。且从社会发展看,未来机器人将达亿级甚至十亿量级,机器与人、机器与机器的合作模式是必然趋势,因此将研究聚焦于群体智能系统。做群体协作需解决三大挑战:1.通信瓶颈;2.同步资源受限;3.数据稀缺。

系统构建与算法实践

在系统构建上,团队为解决多机器人建图通信问题,尝试用参数化或拓扑地图减少数据量,还搭建 1000 平米测试场,架 百余动捕摄像头进行仿真与实物验证。算法实践中,采用强化学习加速机器人决策,开展无人机打排球实验,提出三阶段分层自博弈算法,机器人自主学会二传吊球等人类策略,目前真机已能直上直下颠球 100 多次。

下一代机器人芯片:模块化与能效革命

面向机器人架构,团队关注感知视觉、交互语言及专用决策控制的整合,追求感知决策控制一体。在芯片设计上,提出端侧 AI 芯片新评价指标 Tokens/J,目前能做到几十个 Tokens/J,目标是 20 瓦左右实现 100 - 1000 个 Token per second 且大于 20Tokens/J。团队利用 FPGA 进行研究,发现机器人处理中 NN 模型只是一部分,还有应力传感等未被 NN 统一的部分,需在芯片上实现,如针对飞机轨迹重建中后处理和非线性优化成为瓶颈的问题,通过优化非 NN 部分,使端到端处理比 CPU 好 7 - 15 倍。团队畅想未来机器人芯片是 NN 处理器、CPU 等各类模块像乐高一样组合在基板上,以支持通用 Agent 运行。

最后,汪玉教授表示机器智能需载体且机器间要协作。这一愿景正推动其团队探索下一代机器人芯片的标准化与规模化路径。

多神经可塑造性增强的类脑智能系统

吴郁杰 |香港理工大学助理教授

吴郁杰教授从神经科学与脑科学视角,围绕 “多神经可塑性增强的类脑智能系统” 展开报告,分享类脑智能对 AI 发展的影响及相关探索。

大脑是 AI 发展的重要参考系与技术启发源。从历史看,AI 定义基于人类智能,诸多技术受大脑机制启发:感知层面,卷积神经网络借鉴视觉皮层机制;计算层面,存算一体、稀疏并行等特性推动忆阻器等研究;学习机制上,图灵机、强化学习等与大脑学习相关。大模型与大脑是接近通用 AI 的参考系,二者计算机制差异显著,如对比 Transformer 与海马体学习记忆,可改进 Transformer 设计,发展脑启发检索增强模块,且大脑资源有限下的高效学习机制,对在线终身 AI 系统意义重大。

大模型与大脑的本质差异推动新型架构探索:大脑依赖 “内生复杂性”(单个神经元的丰富计算机制),而当前 AI 依赖 “外生复杂性”(模型参数量扩张)。例如,复杂神经元在任务中性能优于 4 倍参数量的简单神经元,揭示类脑计算的高效潜力。

吴教授团队对类脑智能与类脑学习探索主要有:

1. 混合学习单元:融合全局与局部学习

受神经递质调节启发,团队设计脉冲神经网络混合单元:

双权重分支:慢权重通过 BP 全局更新,快权重通过局部 Hebbian 学习更新,实现 “记忆 - 决策” 互补。

性能优势:在序列决策中提升分类精度,小样本学习中接近人类表现,连续学习中缓解灾难性遗忘,鲁棒性测试中抗噪声能力显著增强。

2. 非 Hebbian 学习:秒级可塑性机制 BTSP

基于小鼠实验发现的新型学习规则:

特性:依赖前神经元刺激与随机信号,学习窗口达秒级(Hebbian 为毫秒级),不依赖后神经元发放,支持小样本快速记忆。

记忆系统验证:BTSP 用二级权重实现与 Hopfield 网络相当的记忆容量,重构任务中性能接近 Hebbian 学习,且权重表示精度更低。当前团队正探索其在认知地图构建及多规则整合中的应用。

最后,吴郁杰教授总结,大脑特征对下一代 AI 有重要启示,团队展示了整合局部学习到 BP 框架的优势,发现新的 BTSP 学习方法,其基于 BTSP 的系统能用低精度权重构造高性能记忆系统。

神经符号学习中的概念发现

戴望州|南京大学副教授

戴望州教授围绕 “神经符号学习中的概念发现” 展开报告,反思当前神经符号学习的局限,提出从经验中自动抽象概念的新路径。

大模型推理的困境:形式化与概念缺失

戴望州通过 GPT 计数元音的实验指出:早期 GPT-1/GPT-3 在计数任务中常因依赖直觉推理出错,直到 GPT-4 通过编写代码实现形式化计算才解决问题。这揭示了大模型推理的本质:当任务超出直觉范围时,需将问题抽象为形式化程序求解。类似地,在图像中识别苹果与桔子时,GPT-4 因缺乏 “苹果”“桔子” 的符号定义,无法调用目标检测模型,最终推理失败。这暴露出当前 AI 的核心缺陷:缺乏从经验中自动发现新概念的能力。

神经符号学习的局限:符号从何而来?

传统神经符号学习的痛点在于:符号和问题形式化均依赖人类预设。如 AIMA 教材作者 Stuart Russell 批评的,符号主义 AI 假设符号预先存在,而机器学习仅在人类定义的概念群中学习,从未从经验中自主抽象概念。对比人类与猴子玩吃豆人游戏的实验可见:高级玩家能抽象出 “存储大豆子” 等新策略(如 “Safe”“Stay” 符号),而猴子仅能形成基础策略,这表明符号抽象能力是智能水平的关键标志。

概念发现的突破:从亚符号环境中涌现符号

戴望州团队提出通过反绎学习实现概念自动发现,核心思路是在无预定义符号的环境中,让 AI 从状态转移中抽象逻辑结构。以 MiniGrid 任务为例,AI 需在纯像素输入下找到钥匙、开门、到达终点:

抽象状态机:将原始状态空间(像素图像)划分为抽象状态子集(如 “无钥匙状态”“有钥匙状态”),允许状态集合相交,通过状态转移关系构建逻辑规则。

反绎推理:基于成功与失败的轨迹采样,识别关键状态突变点(如拿到钥匙时的状态变化),将其作为符号发现的线索。

该方法在随机地图中泛化性能显著优于端到端强化学习,能自主生成 “钥匙”“门” 等概念,且在任务迁移时收敛速度更快。

戴望州强调,未来的研究方向是融合 System1 与 System2 的端到端学习,既要有 System1 的直觉感知能力,也要有 System2 的符号抽象与形式化推理能力。

Riemannian Geometric Deep Graph Learning: A New Perspective on Graph Foundation Models

俞士纶|伊利诺伊大学芝加哥分校教授

俞士纶教授在本次报告中,提出以黎曼几何视角优化图基础模型,突破传统局限。

俞士纶教授指出,尽管大语言模型火热,但在处理图结构和推理任务时存在不足,图模型仍具研究价值。传统图模型在欧式空间训练,泛化能力差,难以捕捉图的复杂结构。而黎曼空间包含双曲空间(负曲率,描述树形结构)、欧式空间(曲率为 0)和球形空间(正曲率,描述环形结构),能更好地刻画图的层级和循环特性。

在黎曼空间开展图深度学习面临公式复杂、边曲率不可微、空间映射困难等挑战。教授团队提出用乘积空间整合不同曲率空间,利用边的曲率信息定义 Ricci 流,辅助聚类和优化图结构。实验显示,在知识图谱和不同类型图中,黎曼空间能更精准解析结构差异,为模型泛化提供依据。

该方法无需标签数据即可进行对比学习,在节点分类、链接预测任务中表现优于欧式空间模型,泛化能力强,对训练和测试数据集敏感度低。同时,结合图结构设计新的消息传递机制,可有效避免过平滑和过挤压问题,支持模型层数大幅增加。

最后,教授总结,黎曼几何为图模型带来全新思路,在无外部标签情况下可处理分类、预测及动态网络,相比欧式空间显著提升泛化性与深度,为图基础模型发展提供了新方向。

Diffusion vs. Autoregression: Which is the Key to Next-Generation LLMs?

贺笛|北京大学助理教授

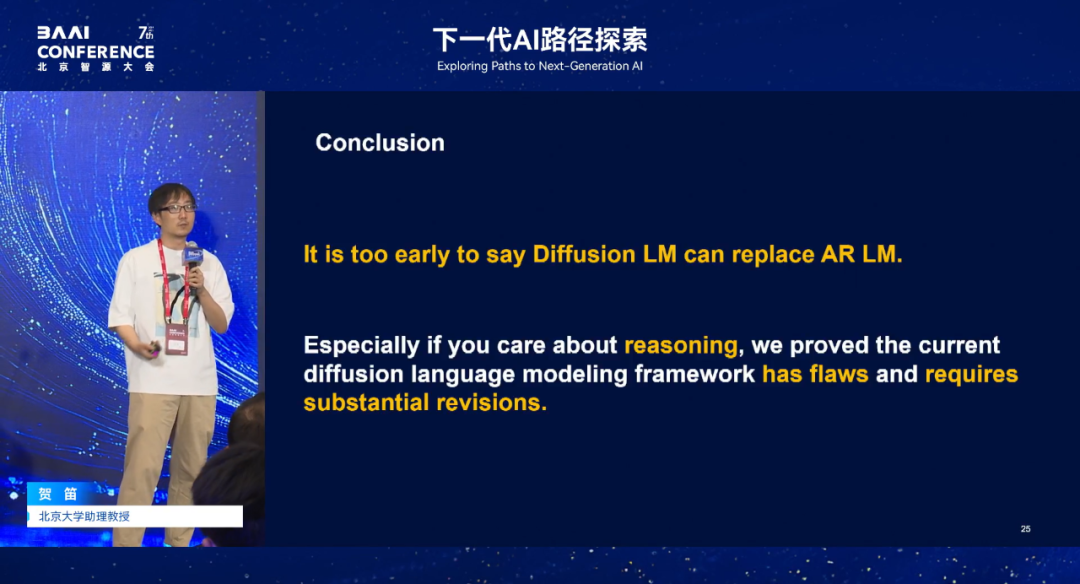

贺笛教授深入探讨扩散模型(Diffusion)与自回归模型(Autoregression)在大语言模型(LLMs)中的应用潜力和局限。

当前大模型多采用 Transformer 结构与自回归范式,但生成速度慢制约发展。学界和业界通过改进模型结构、采用投机解码等技术优化,而近期用 Diffusion 替代 Autoregression 解决自然语言生成任务成为热点。Diffusion 源于计算机视觉,通过前向加噪、反向去噪生成图像,其并行生成特性吸引 NLP 领域尝试,但需解决离散 Token 加噪问题,当前多采用 Mask 操作实现。

在实验对比中,贺笛团队对开源扩散语言模型(如Gemini Diffusion)进行严格测试,发现:

流畅性任务(如文本生成):扩散模型仅需常数步数即可达到与自回归模型相当的流畅度(Perplexity);

推理任务(如GSK8K、MBPP):扩散模型表现显著劣于自回归模型,即使步数超过文本长度,错误率仍高于50%。

核心矛盾:扩散模型虽能高效生成流畅文本,但无法保证逻辑连贯性,而推理任务依赖严格的从左到右的因果结构。

理论研究方面,教授团队发现,Diffusion 模型在生成流畅文本时,所需步数与文本长度无关,表现良好;但在处理序列结构正确性(如推理任务)时,即使扩散步数与文本长度同阶,错误率仍大于 1/2,表现远不及自回归模型 。

最后,贺笛教授总结,目前 Diffusion 模型取代自回归模型为时尚早,其理论上限有限,尤其在推理任务上表现不佳,若要实现超越,需对现有 Diffusion 语言模型框架进行重大改进。

本文版权归智源社区所有

内容中包含的图片若涉及版权问题,请及时与我们联系删除