推箱子、俄罗斯方块……这些人类的经典怀旧小游戏,也成大模型benchmark了。

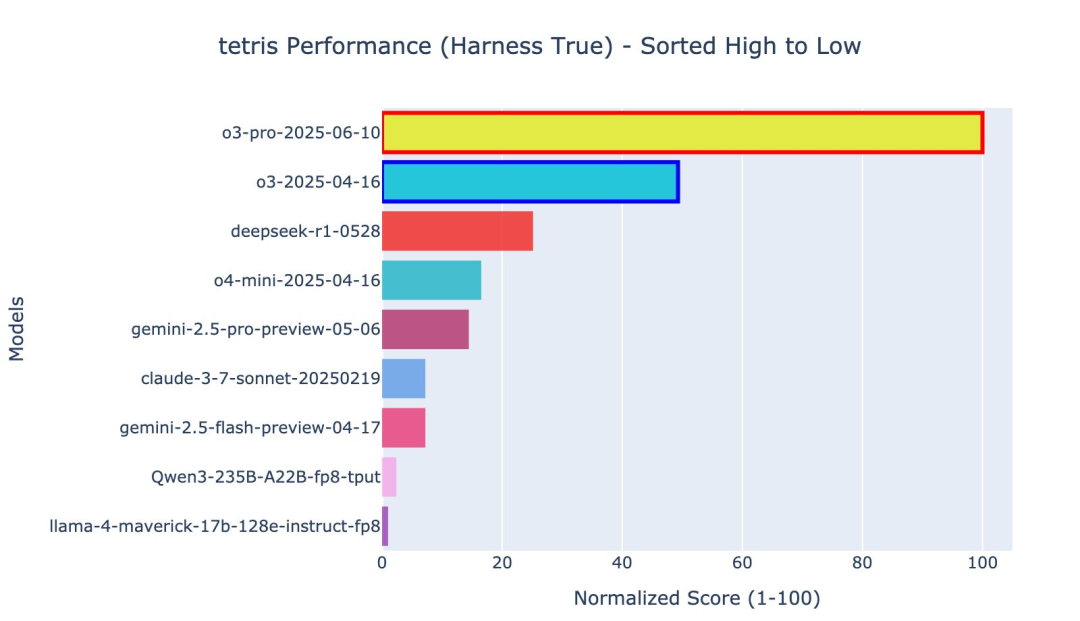

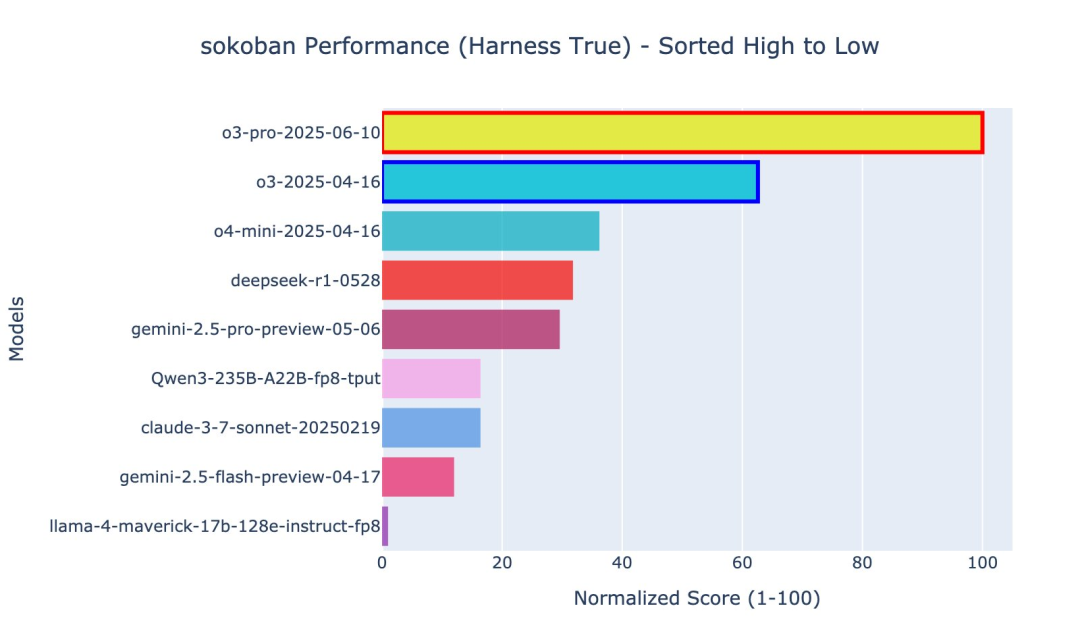

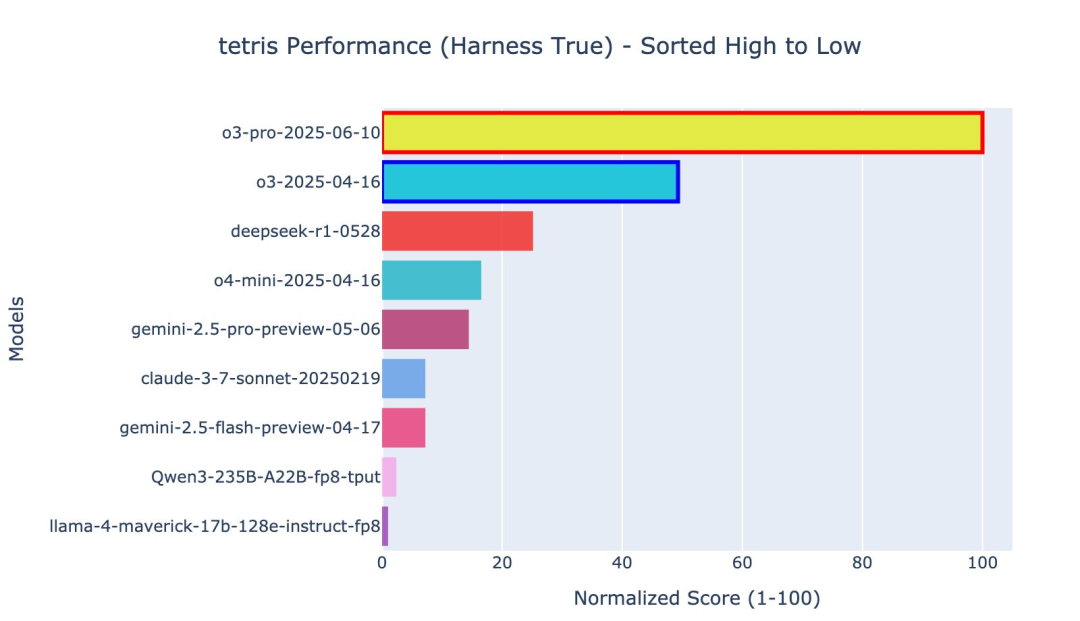

o3-pro刚刚也挑战了这两款游戏,而且表现还都不错,直接突破了benchmark上限。

具体来说,benchmark中推箱子一共就只做到了被o3-pro突破的第六关;俄罗斯方块则是强行终止的结果,实际上o3-pro根本停不下来。

如果和前SOTA——o3比较,o3-pro的成绩也是直接翻倍。

还有网友直言,比起大模型竞技场,这套标准才更适合做测试大模型的基准。

经典小游戏成为新Benchmark

o3-pro挑战的这两个游戏,出自一套名为Lmgame的benchmark,顾名思义就是让大模型玩游戏。

o3-pro挑战的推箱子是从1989年的版本修改而来,在o3-pro之前,评估指标是游戏结束之前推动到目标位置的箱子总数。

不过这次o3-pro直接把所有关卡都通了,颇有种“得一百分是因为卷面只有一百分”的感觉。

但也不必担心,测试基准会动态更新,GItHub仓库中半个月前更新的游戏地图还只有四关,原版游戏更是有足足50多个关卡。

而在o3-pro挑战之前,表现最好的是o3,o4-mini紧随其后,再然后是DeepSeek-R1的最新版本(0528)。

俄罗斯方块的得分计算方式则是将放置的方块数量与清除行数的10倍相加,直到游戏结束。

在o3-pro之前,表现最好的模型同样是o3,但后面R1和o4-mini的排名和推箱子相比交换了位置。

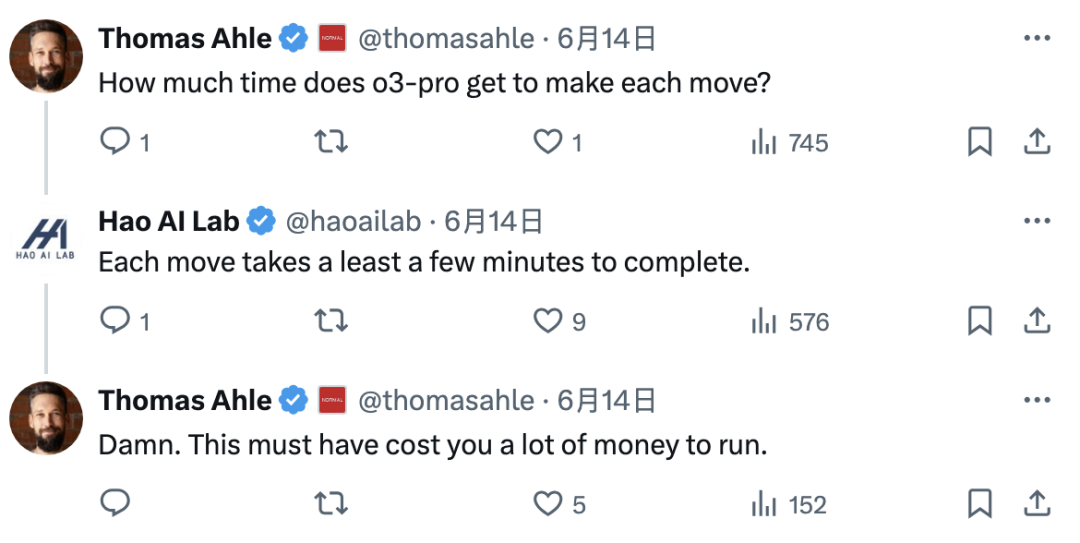

不过在时间上,o3-pro的操作相当耗时,每走一步都要花上好几分钟。

另外还有网友认为,如果让大模型编写程序而不是直接挑战,结果可能会更好。

除了o3-pro玩的推箱子和俄罗斯方块,Lmgame中还包括四款游戏——2048、糖果传奇、马里奥兄弟和逆转裁判。

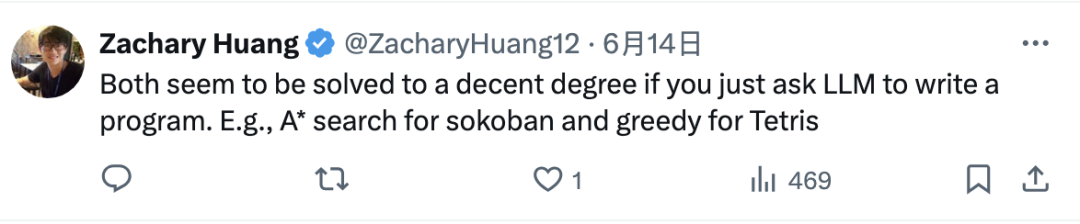

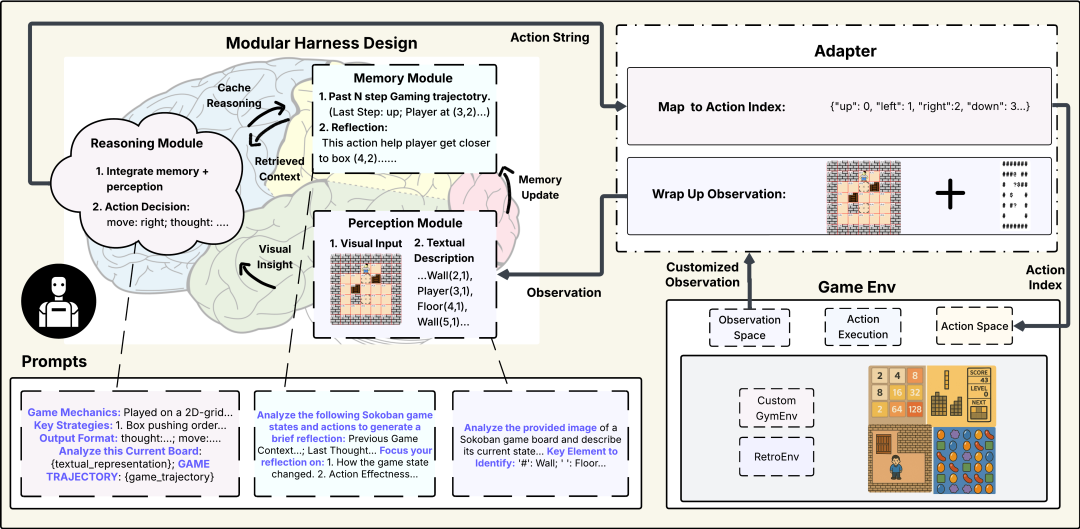

测试过程中通过一种迭代交互循环模式进行,游戏环境会持续地向大模型提供游戏状态,模型根据状态生成动作,这些动作随后在游戏环境中被执行,并根据执行结果计算奖励,接着游戏状态会更新以进行下一轮决策。

同时还引入了智能体框架作为辅助工具,其中包含了感知、记忆、推理等模块;为了确保评估结果的稳定性和可比性,该模式还实施了提示标准化,以减少提示提示词带来的性能波动。

根据游戏的特性和规则,具体到每个游戏的评价方式也有所区别:

不过这些游戏表现的衡量标准当中,都没有将时间作为考量因素。

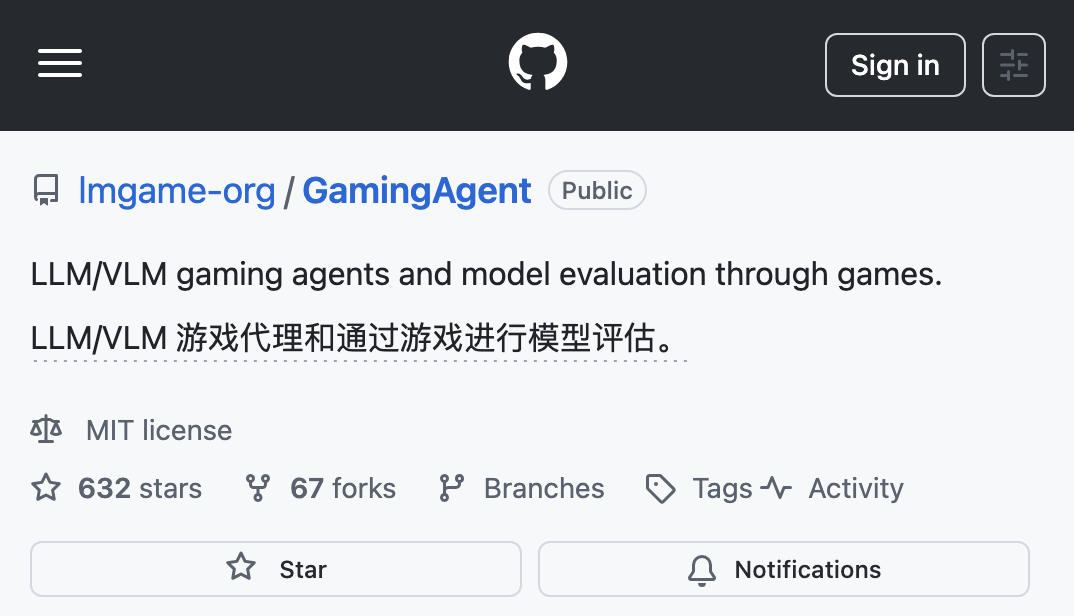

另外这套benchmark是开源的,有兴趣的话也可以自己下载下来对模型进行测试。

还有网友留言说想看宝可梦的结果,团队表示马上安排。

说到宝可梦,Gemini一直在全网直播当中进行挑战,并且在今年5月初成功通关了宝可梦·蓝。

当时谷歌CEO劈柴哥第一时间兴奋官宣,还放出了通关时刻的珍贵影像:

大模型竞技场顾问课题组出品

这个项目来自UCSD的Hao AI Lab,附属于USCD的机器学习系统实验室和NLP实验室,负责人是Halıcıoğlu数据科学研究所的助理教授张昊。

张昊本硕博分别就读于华南理工、上海交大和卡内基梅隆大学,之后到UC伯克利从事博士后研究,结束后加入UCSD。

此外张昊也参与过创立LMSYS,并担任大模型竞技场顾问。

LMSYS是一个非营利组织,大模型竞技场和知名模型框架SGLang、vLLM都是由LMSYS研发的。

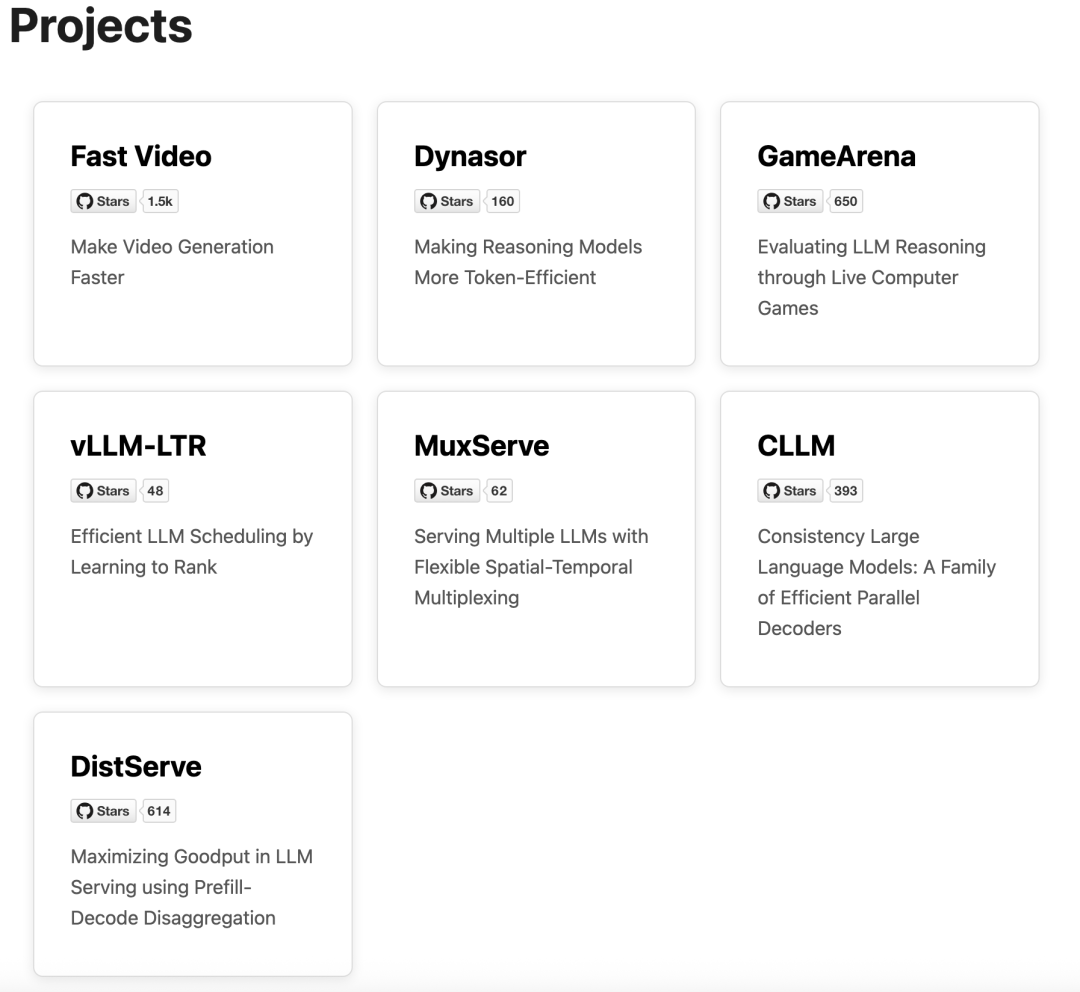

说回Hao AI Lab,该实验室创立了多个开源项目,其中GitHub星标数最多的是视频生成加速框架FastVideo,已获得1.5k星。

Hao AI Lab还接受谷歌和英伟达的资助,今年4月英伟达给该实验室捐赠了一台DGX B200。

参考链接:

https://x.com/haoailab/status/1933614723507106226

项目仓库:

https://github.com/lmgame-org/GamingAgent

榜单:

https://huggingface.co/spaces/lmgame/lmgame_bench

论文:

https://arxiv.org/abs/2505.15146

— 完 —

📪 量子位AI主题策划正在征集中!欢迎参与专题365行AI落地方案,一千零一个AI应用,或与我们分享你在寻找的AI产品,或发现的AI新动向。

💬 也欢迎你加入量子位每日AI交流群,一起来畅聊AI吧~

一键关注 👇 点亮星标

一键三连「点赞」「转发」「小心心」

欢迎在评论区留下你的想法!

内容中包含的图片若涉及版权问题,请及时与我们联系删除