index_new5.html

../../../zaker_core/zaker_tpl_static/wap/tpl_guoji1.html

![]()

昇思MindSpore为解决AI大模型时代开发者面临的框架与生态兼容问题,提供了一套高效便捷的解决方案。通过MSAdapter工具,开发者可以轻松地将主流大模型代码迁移至MindSpore平台,实现“Day0迁移”,且精度和性能有保障。在推理部署方面,MindSpore结合vLLM插件,支持HuggingFace模型快速部署上线。昇思MindSpore简化了模型迁移和部署流程,提升了效率,为开发者提供了更友好的使用体验。

💡 昇思MindSpore通过MSAdapter工具简化了大模型迁移流程。该工具能将其他框架的代码转换为MindSpore可识别的语言,实现代码的“零损耗”迁移,使得开发者无需过多修改代码即可在MindSpore上运行模型。

🚀 MindSpore在训练方面采用多项优化技术来提升性能。例如,动态图多级流水技术通过多核并行处理算子,加速训练过程;JIT编译技术将常用代码打包成高效模块,提升执行效率;自动策略寻优技术则能自动搜索最优并行策略,提升训练速度。

⏱️ 在推理部署方面,MindSpore结合vLLM-MindSpore插件,支持HuggingFace模型在半小时内完成部署。 针对千亿参数大模型,MindSpore采用三层部署模式,支持HuggingFace权重直接加载,并减少启动延迟,百亿参数模型加载时间缩短至30秒以内。

✅ 昇思MindSpore支持多种主流大模型,如DeepSeek、Pangu、Qwen等。 经过实测,基于Atlas 800I A2和Atlas 300I Pro,使用vLLM和MindSpore部署推理服务,在低时延下实现了高吞吐量,例如Pangu Pro MoE 72B单卡增量吞吐可达每秒1020tokens和130tokens。

没有一个大模型可以一统天下。

这,或许已经成为了AI大模型时代行业里的一个共识。

在如此背景之下,面对众多且日新月异的主流大模型和AI技术,如何能在一个框架、生态下去体验,却成了开发者们“老大难”的问题。

难道就没有一个又快又好又方便的解决办法吗?

有的——

华为开源的昇思MindSpore,了解一下。

在这里,主流SOTA大模型的“搬家”是这样的——训练Day0迁移:

只需改动极少极少的代码就OK,并且精度和性能都在线。

推理是一键部署的:

训练转推理全流程自动化,20多个主流大模型开箱即用,百亿参数模型加载只需不到30秒。

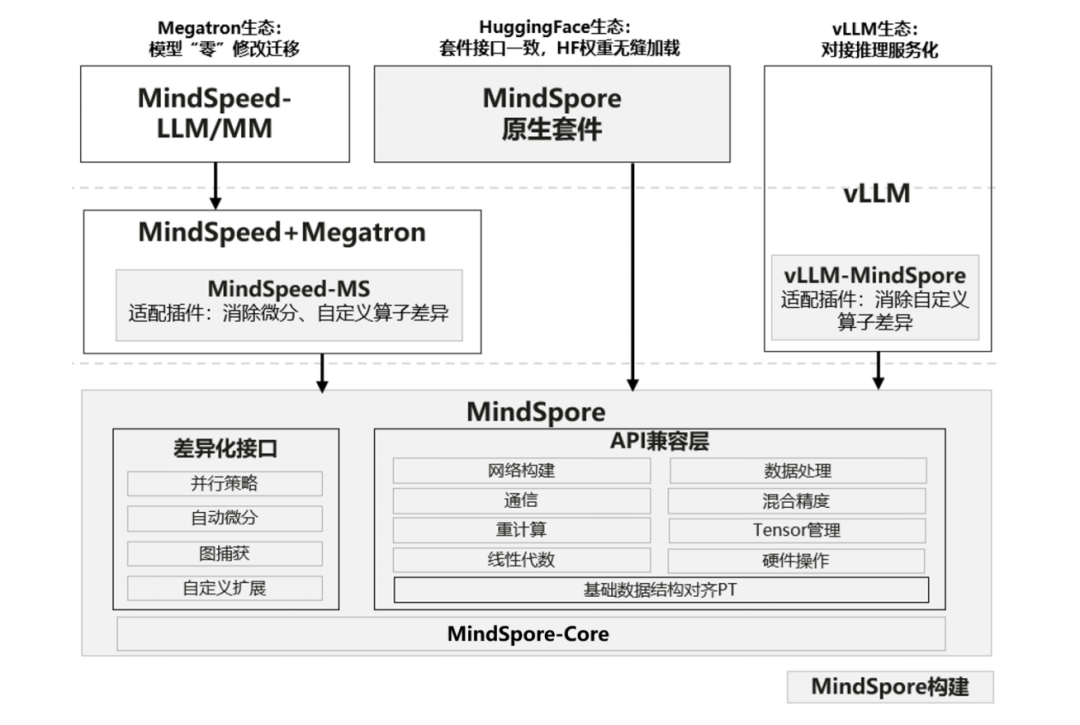

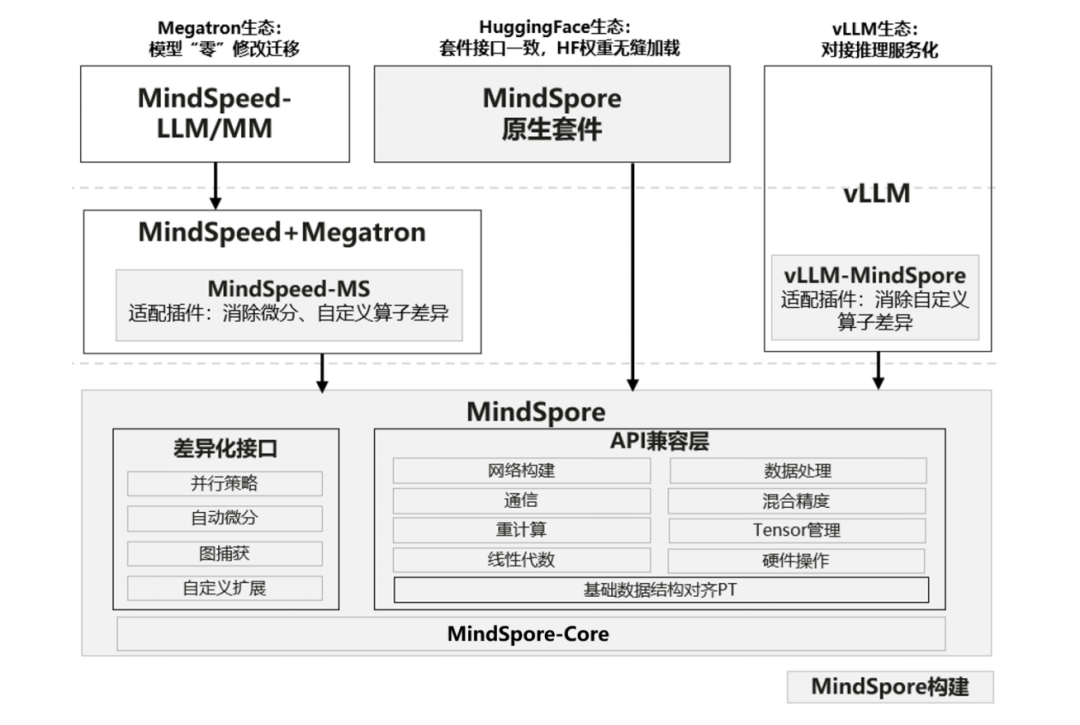

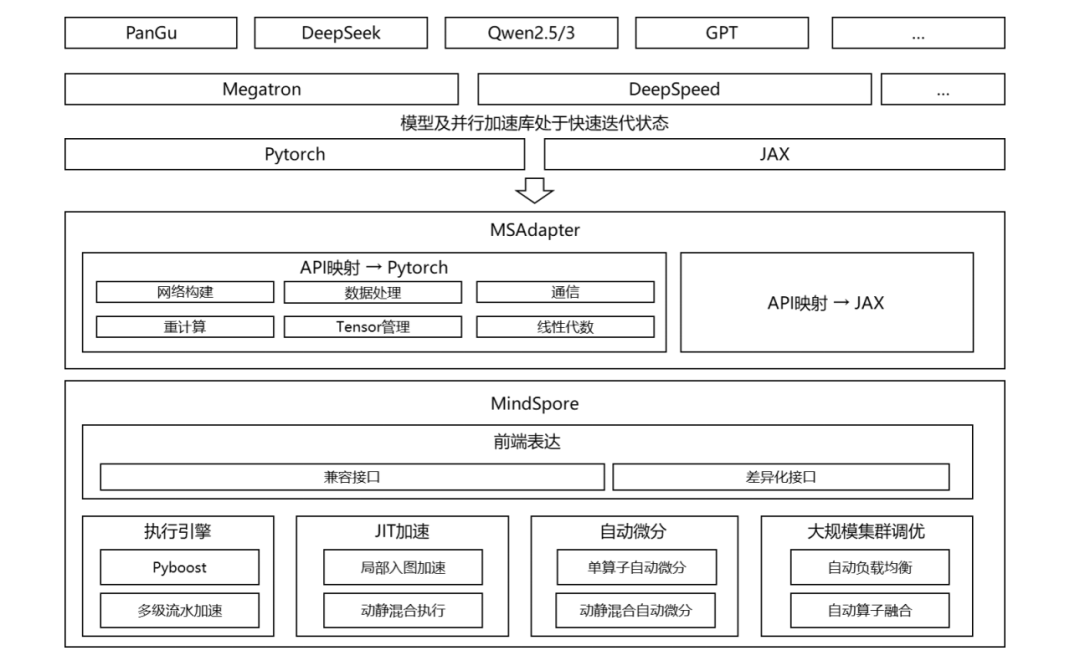

△MindSpore生态快速迁移解决方案的技术架构

那么昇思MindSpore是如何做到,我们继续往下看。

改4行代码,“搬家”DeepSeek-V3

为了让迁移大模型这件事变得无感知,昇思MindSpore“翻译神器”——MSAdapter。

简单来说,这个工具可以把其他框架的代码转换成MindSpore能看懂的语言,从而实现 “零损耗” 迁移。

比如PyTorch写的训练脚本,直接在MindSpore里运行,动态图体验和原来一样顺手,95%以上的接口都能自动转换,迁移损耗几乎为零。

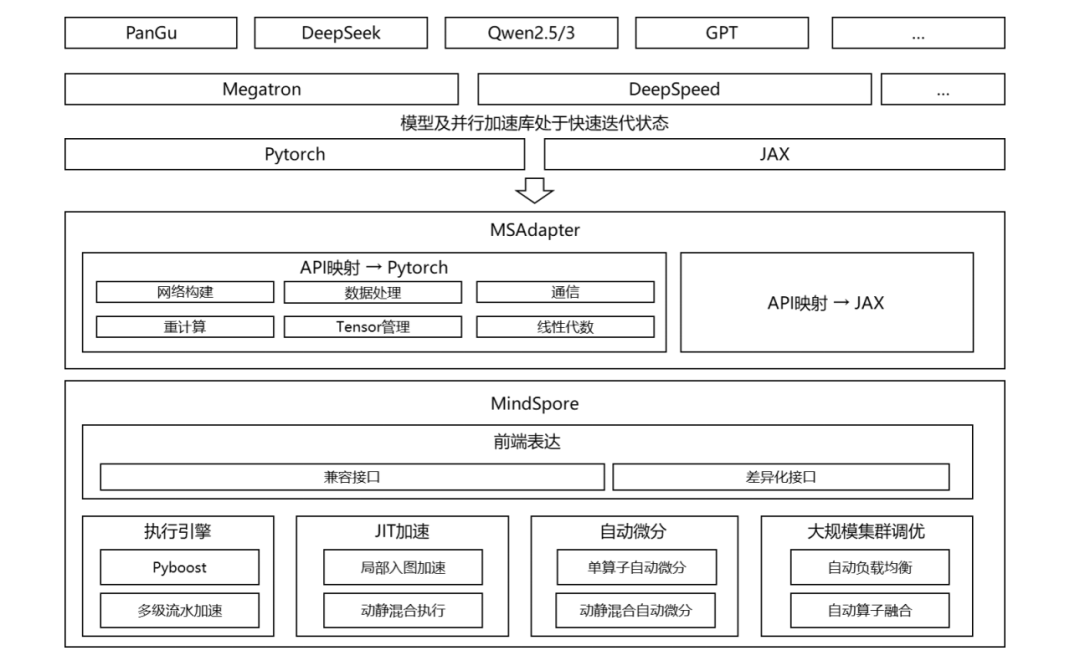

在此背后还有其他的“独家秘笈”,加速训练调试调优,具体技术如下:

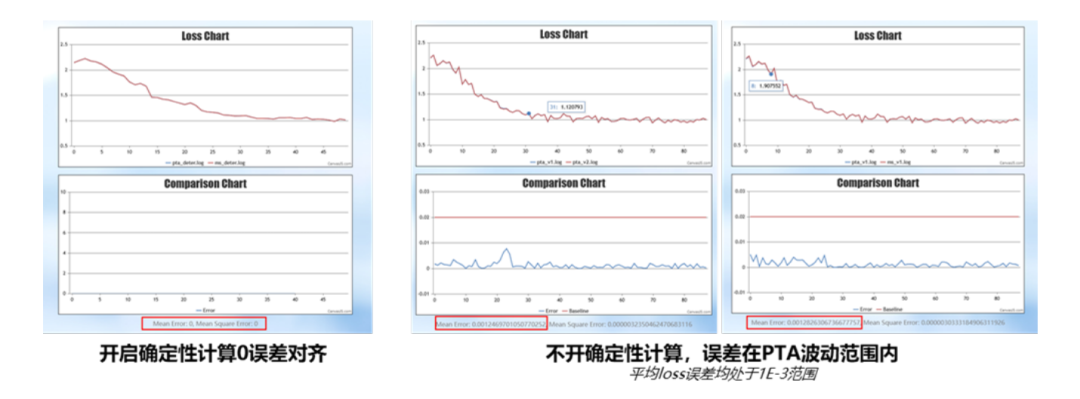

动态图多级流水:把算子(模型的基本计算单元)的处理拆成4个阶段(如Python 转换、形状推导等),用多核并行处理,速度提升3-4倍。JIT 编译:把常用代码 “打包” 成高效执行的模块,像把重复工作做成模板,用的时候直接拿出来用,兼顾灵活编程和高性能。自动策略寻优:大模型训练需要选最佳并行策略(比如数据并行、张量并行等),传统靠专家经验,现在MindSpore能自动搜索最优方案,比如在DeepSeek-V3训练中,性能提升了9.5%。执行序比对:大模型训练可能因算子执行顺序不同导致精度问题,MindSpore能自动比对执行顺序,快速找到差异,避免人工排查几十万算子的麻烦。

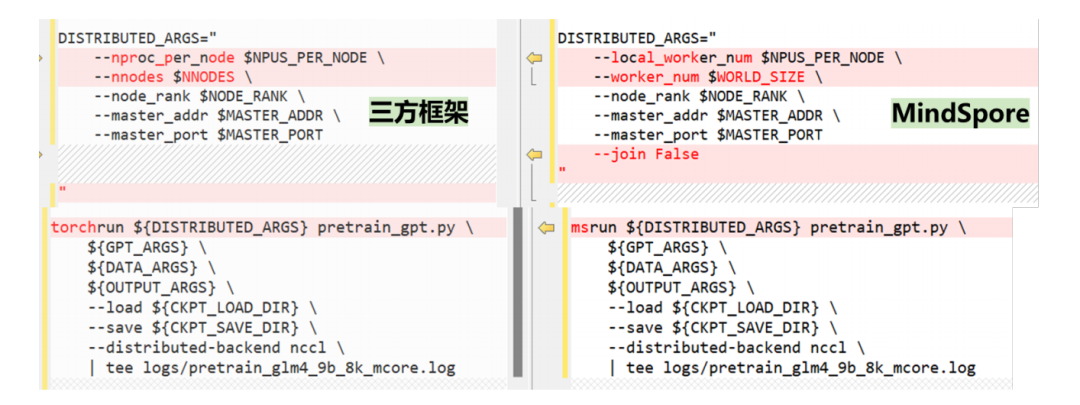

△MindSpore训练Day0迁移方案

以DeepSeek-V3为例,代码改动量如下:

Shell脚本:修改分布式任务启动相关参数,共涉及4行代码调整。

不仅精度上可以实现Day0对齐,而且在保持并行策略一致的情况下叠加MindSpore自研增量特性,性能还能提升5%。

HuggingFace模型们,推理一键部署

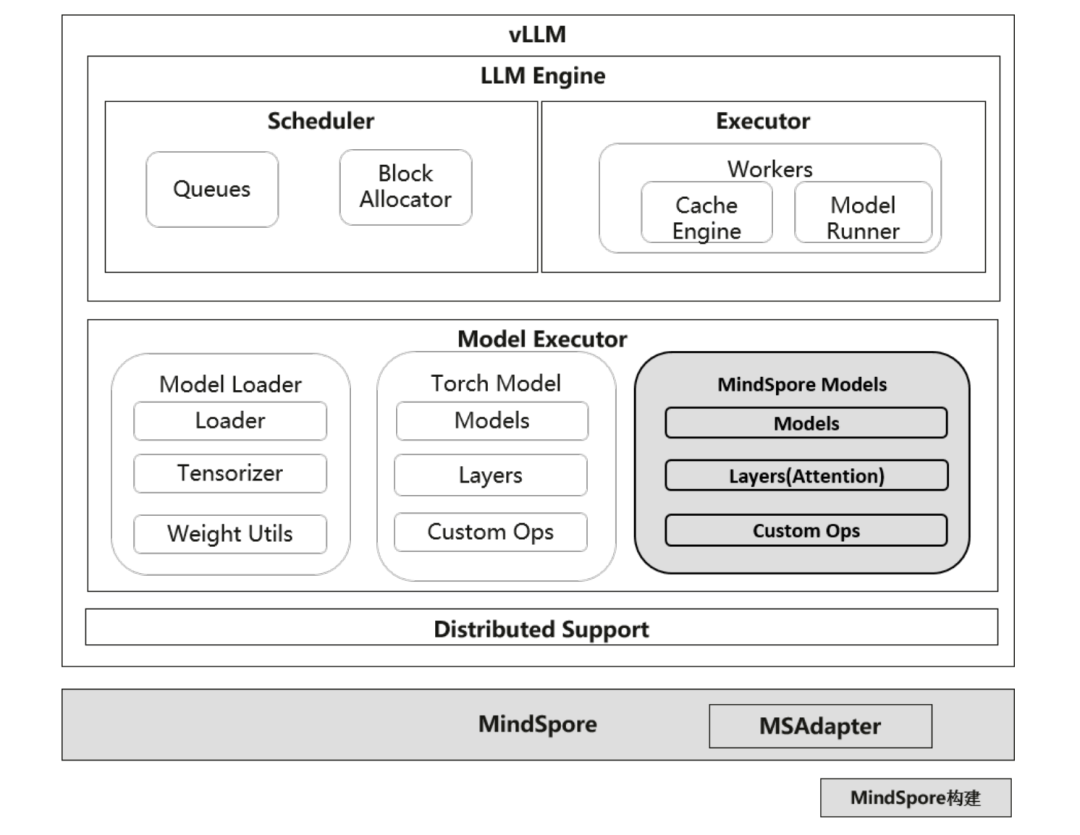

在推理部署这块儿,昇思则是用vLLM-MindSpore插件能让HuggingFace模型在半小时内完成部署并上线。

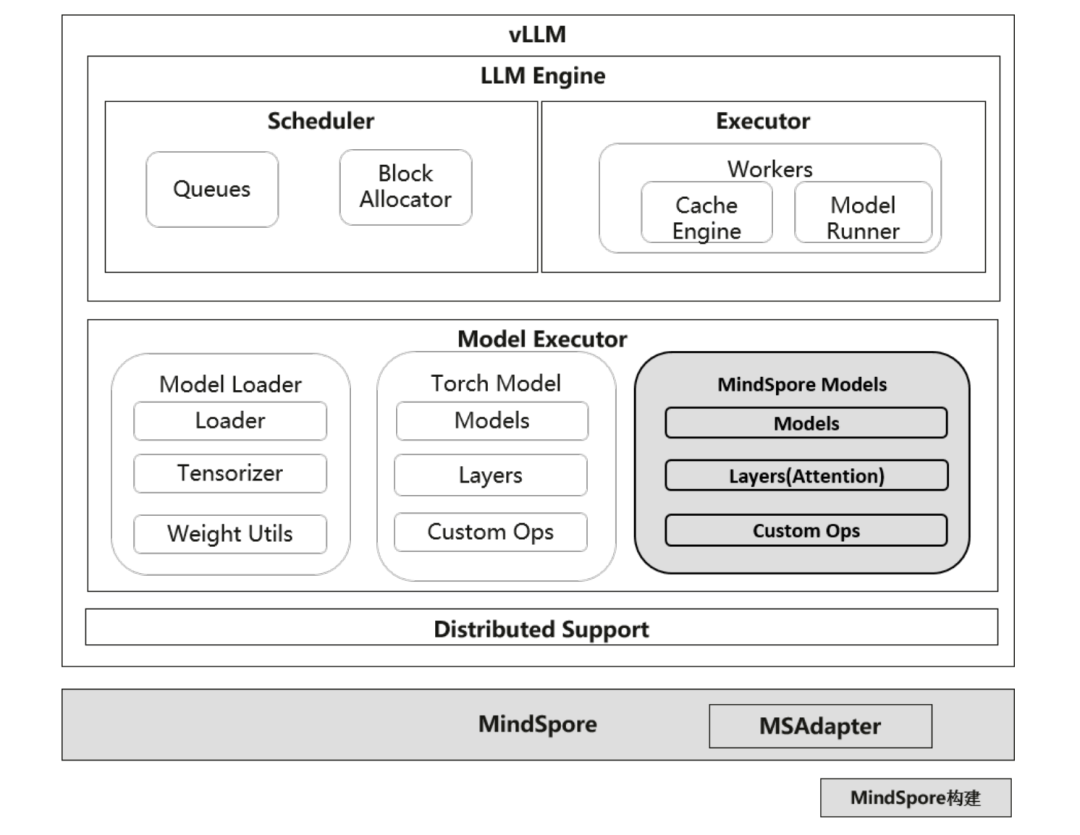

△vLLM x MindSpore 框架图

要是碰到千亿参数的大模型,MindSpore用三层部署模式重新打造了推理流程:

直接用HuggingFace的权重:能直接加载HuggingFace的模型权重,不用转换格式;通过vLLM - MindSpore插件,短短几分钟就能把模型变成可提供服务的状态。模型拿来就能用:支持很多业内常用的模型,拿来就能直接用,像DeepSeek、Pangu、Qwen这些,已经有20多个模型上线了。减少启动时的延迟:权重加载花费的时间减少了80%(百亿参数的模型加载时间不到30秒);图编译的延迟也压缩到了毫秒级别。

从实测效果来看,以Pangu Pro MoE 72B为例,使用vLLM和MindSpore在Atlas 800I A2上部署推理服务,当前在时延小于100ms的情况下单卡增量吞吐可达每秒1020tokens,在Atlas 300I Pro上可达每秒130tokens。

以上便是关于昇思MindSpore“训练Day0迁移、推理一键部署”的大致内容了,了解更多详情可戳 。

。

https://gitcode.com/ascend-tribe/ascend-cluster-infra/blob/main/MindSpore/ascend-cluster-infra-mindspore.md

一键三连「点赞」「转发」「小心心」

欢迎在评论区留下你的想法!

内容中包含的图片若涉及版权问题,请及时与我们联系删除

。

。