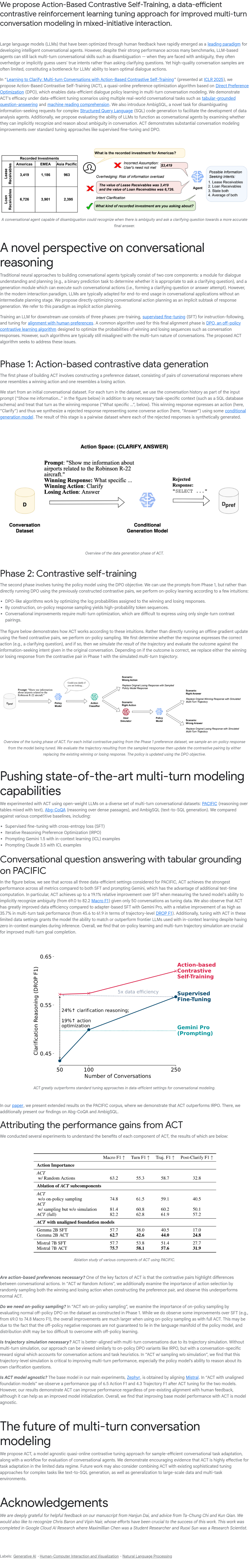

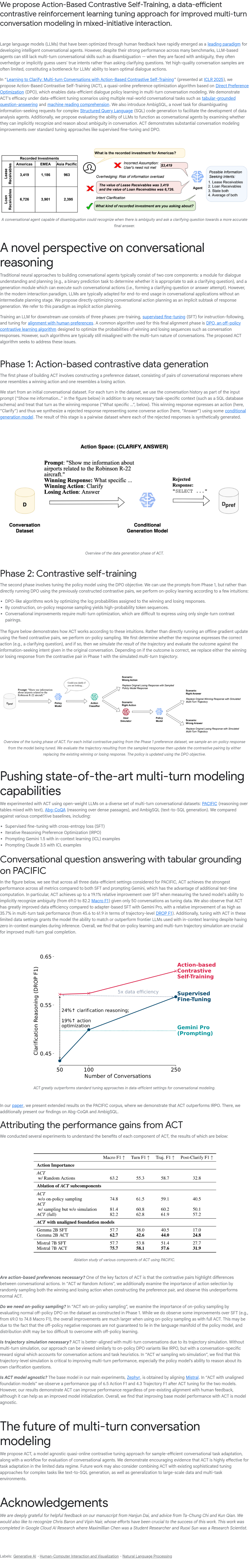

本文介绍了一种名为Action-Based Contrastive Self-Training (ACT) 的方法,它是一种数据驱动的对比强化学习微调技术,旨在改进混合主动交互中的多轮对话建模。尽管大型语言模型(LLMs)在许多任务中表现出色,但在多轮对话技能方面仍有提升空间。ACT方法通过对比自训练机制,在有限数据条件下优化对话代理的行为策略,特别是在多轮对话中增强其澄清能力,为开发更智能、更具交互性的对话系统提供了新思路。

💬 ACT方法的核心在于利用对比自训练机制,在有限的数据条件下优化对话代理的行为策略。这种方法侧重于提升模型在多轮对话中的澄清能力,以应对模糊情境。

💡 ACT方法针对大型语言模型(LLMs)在多轮对话技能方面的不足,例如在面对模糊情境时过度猜测用户意图。ACT方法旨在解决这一问题。

⚙️ ACT方法采用准在线偏好学习的方式,这有助于在实际应用中更有效地利用数据。通过这种方式,ACT能够不断优化对话代理的行为,使其更贴合用户需求。

✅ ACT方法的提出,为开发更智能、更具交互性的对话系统提供了新的思路。它强调在有限数据条件下,通过对比自训练来提升对话系统的性能。

🔍 ACT方法通过对比学习,使模型能够区分和学习更优的对话行为,增强了模型在复杂对话场景下的适应性和准确性。

本文提出了一种名为Action-Based Contrastive Self-Training (ACT) 的高效数据驱动对比强化学习微调方法,旨在提升混合主动交互中多轮对话建模的能力。尽管通过人类反馈优化的大型语言模型(LLMs)在许多基准测试中表现出色,但它们在多轮对话技能方面仍存在不足,例如在面对模糊情境时,往往倾向于过度猜测用户意图,而非主动询问以澄清问题。高质量的对话数据通常有限,成为限制LLMs学习最优对话策略的瓶颈。ACT方法通过准在线偏好学习的方式,利用对比自训练机制,在有限数据条件下优化对话代理的行为策略,特别是在多轮对话中增强其澄清能力。这种方法为开发更智能、更具交互性的对话系统提供了新思路。

本专栏通过快照技术转载,仅保留核心内容

内容中包含的图片若涉及版权问题,请及时与我们联系删除