index_new5.html

../../../zaker_core/zaker_tpl_static/wap/tpl_guoji1.html

![]()

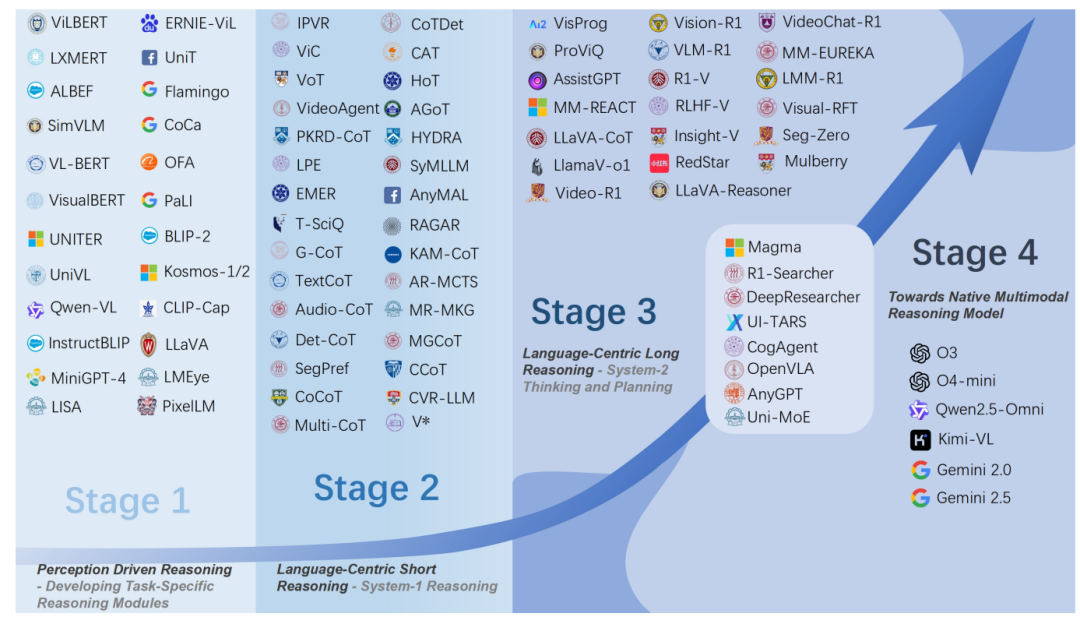

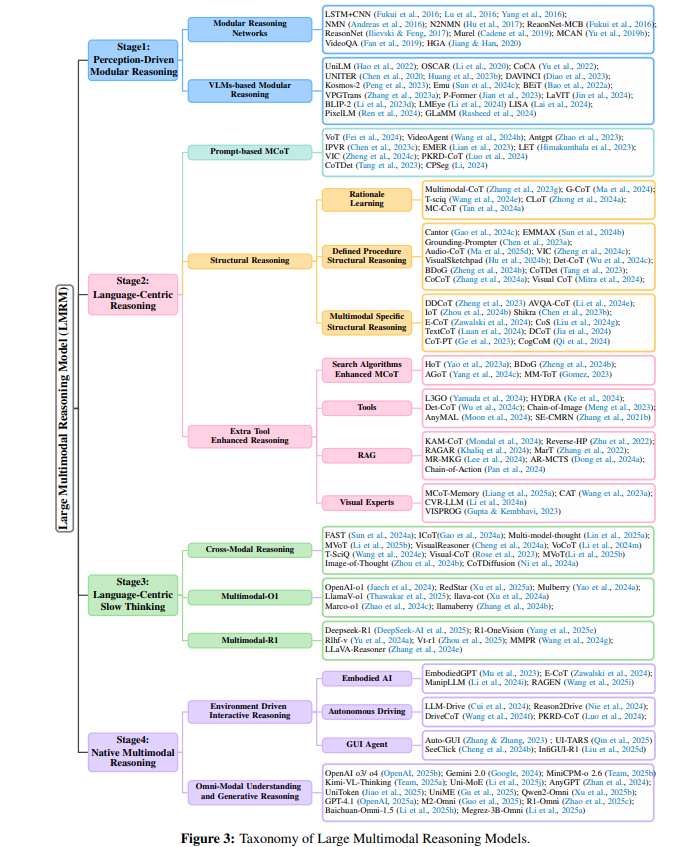

本文对大语言多模态推理模型(LMRMs)进行了全面综述,围绕感知驱动的模块化推理、以语言为中心的短推理、以语言为中心的长推理以及迈向原生多模态推理模型四个阶段展开。早期的模型采用模块化设计,但难以处理复杂推理。随着大规模预训练模型出现,推理能力提升,但依赖表面模式匹配。为处理复杂任务,研究者探索更深层次的推理能力,但仍依赖语言模型架构。为了克服局限性,提出了原生多模态推理模型,旨在实现多模态感知、生成和推理的统一。

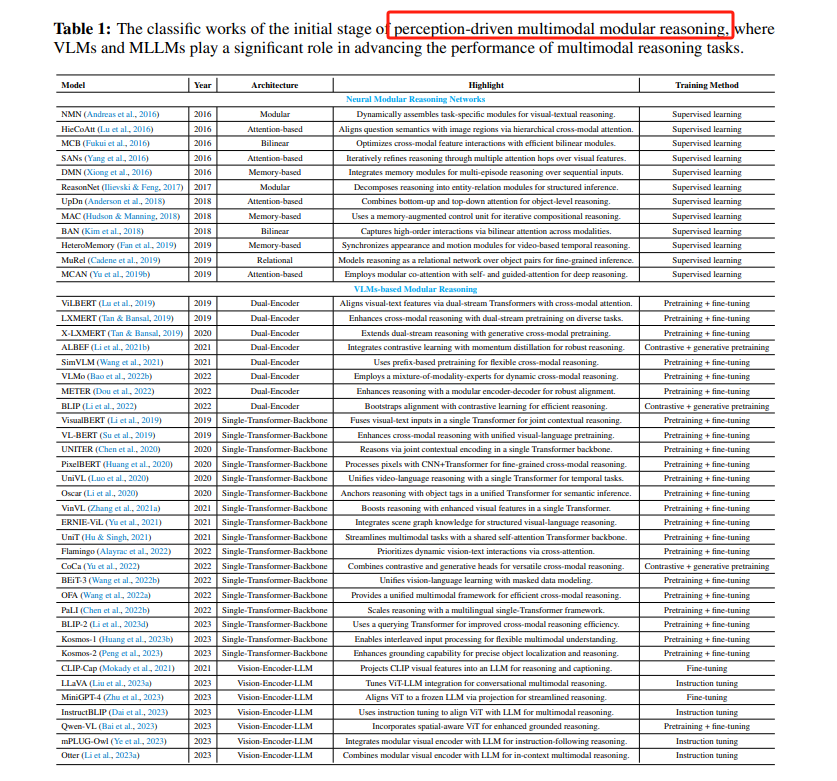

💡**感知驱动的模块化推理:** 早期多模态推理模型采用模块化设计,将推理过程分解为表示、对齐、融合和推理等独立组件,例如NMN和HieCoAtt,但这类模型难以处理复杂的多步推理场景。

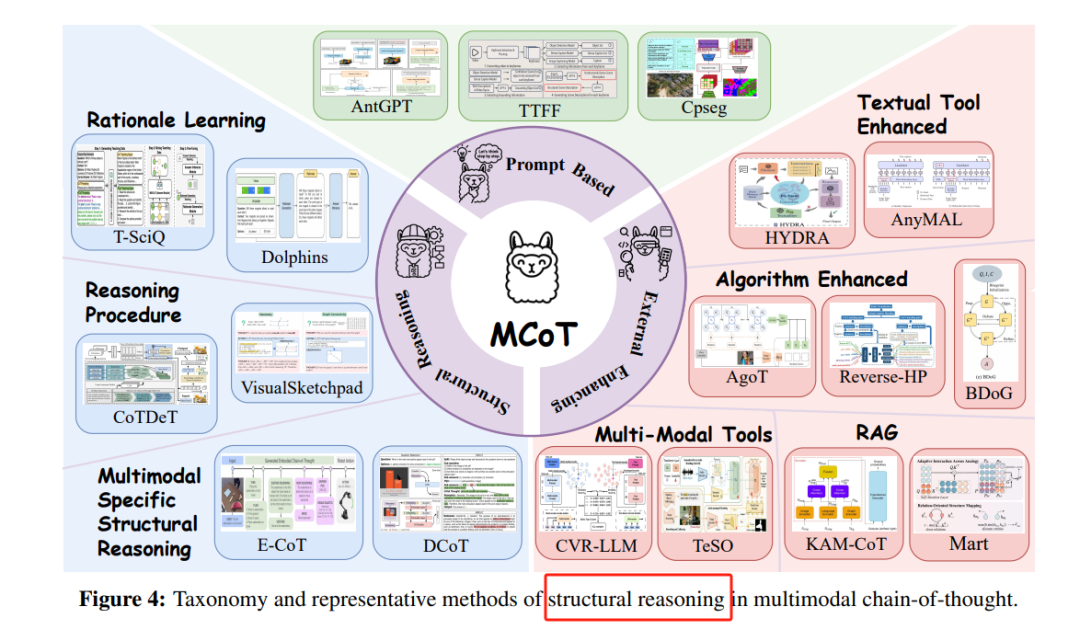

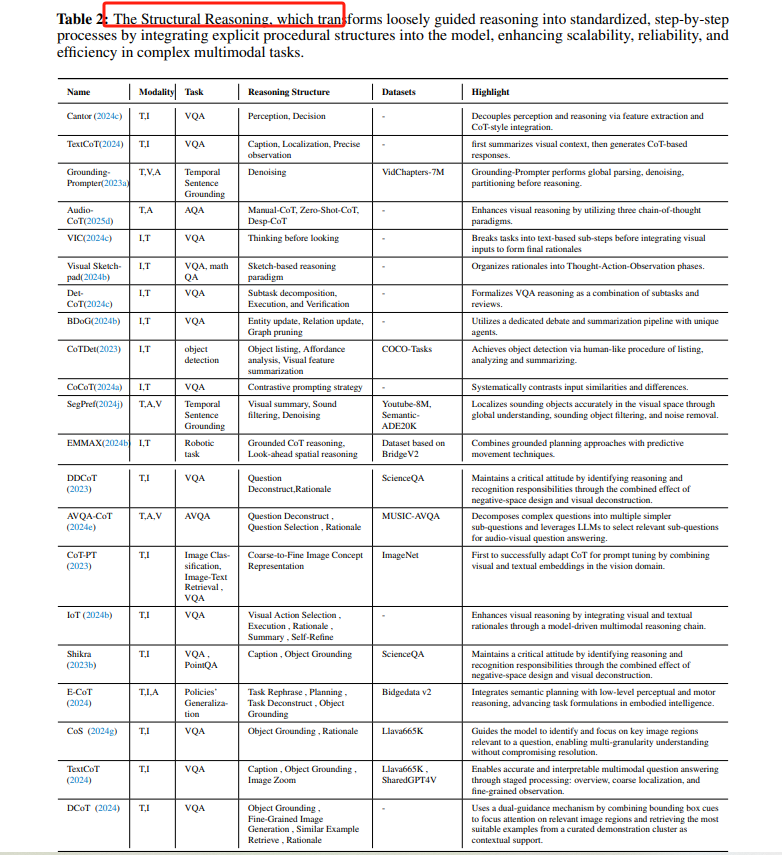

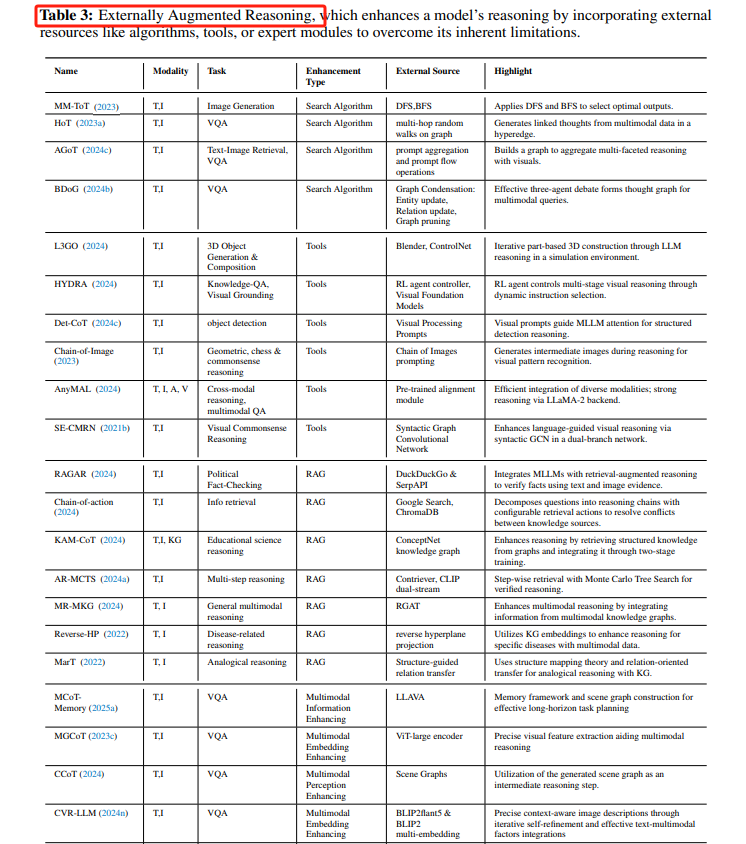

🔗 **以语言为中心的短推理:** 随着大规模多模态预训练模型的出现,多模态推理能力显著提升,主要依赖于表面模式匹配,缺乏动态假设生成和多步逻辑推理能力。Prompt-based MCoT、Structural Reasoning、Externally Augmented Reasoning等方法被提出。

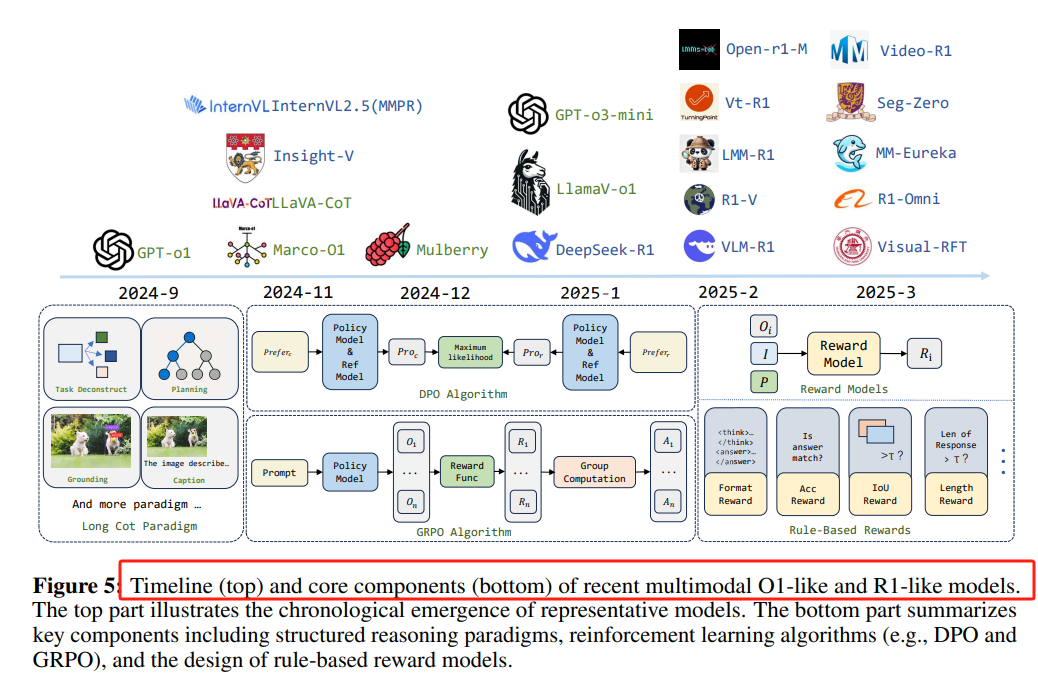

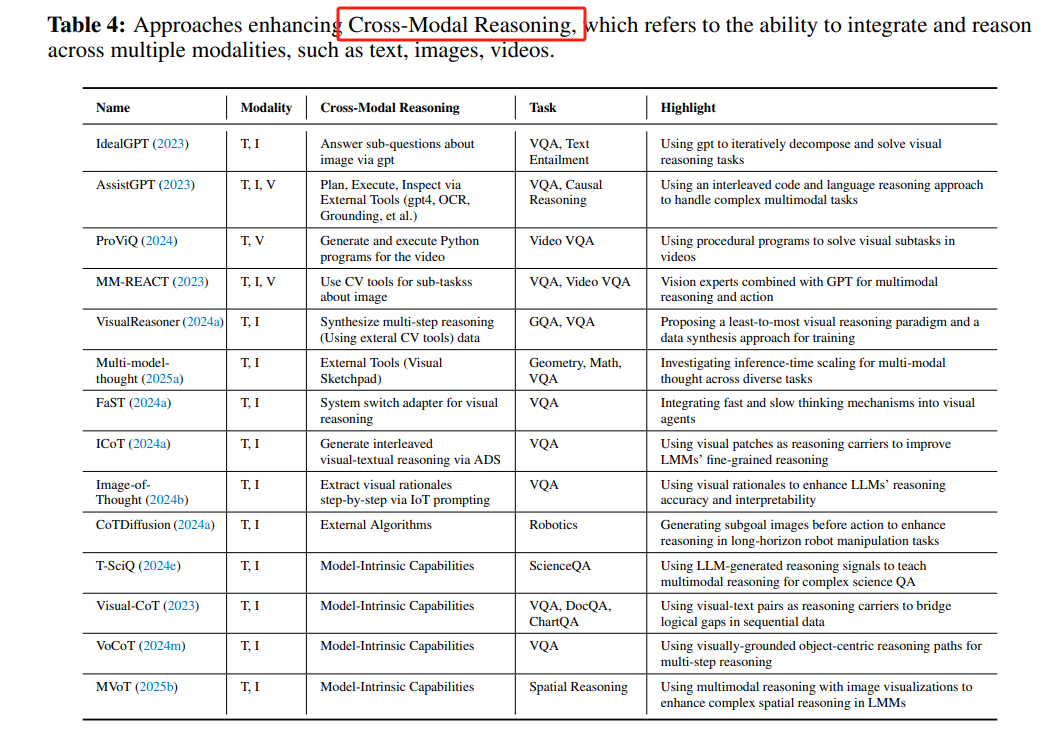

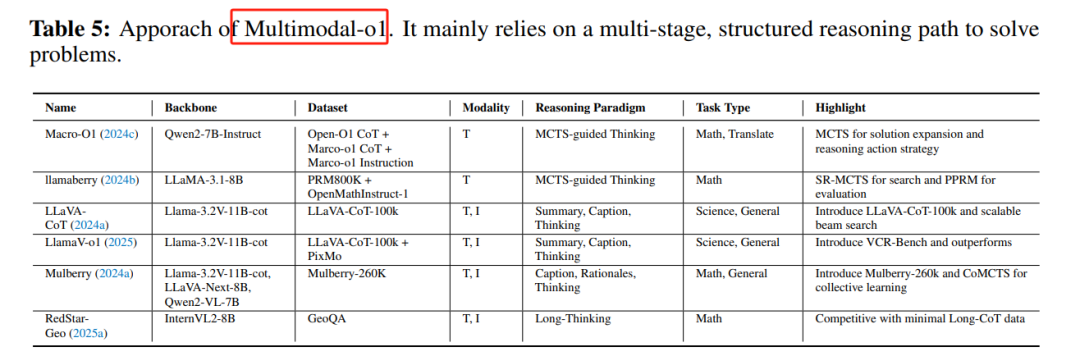

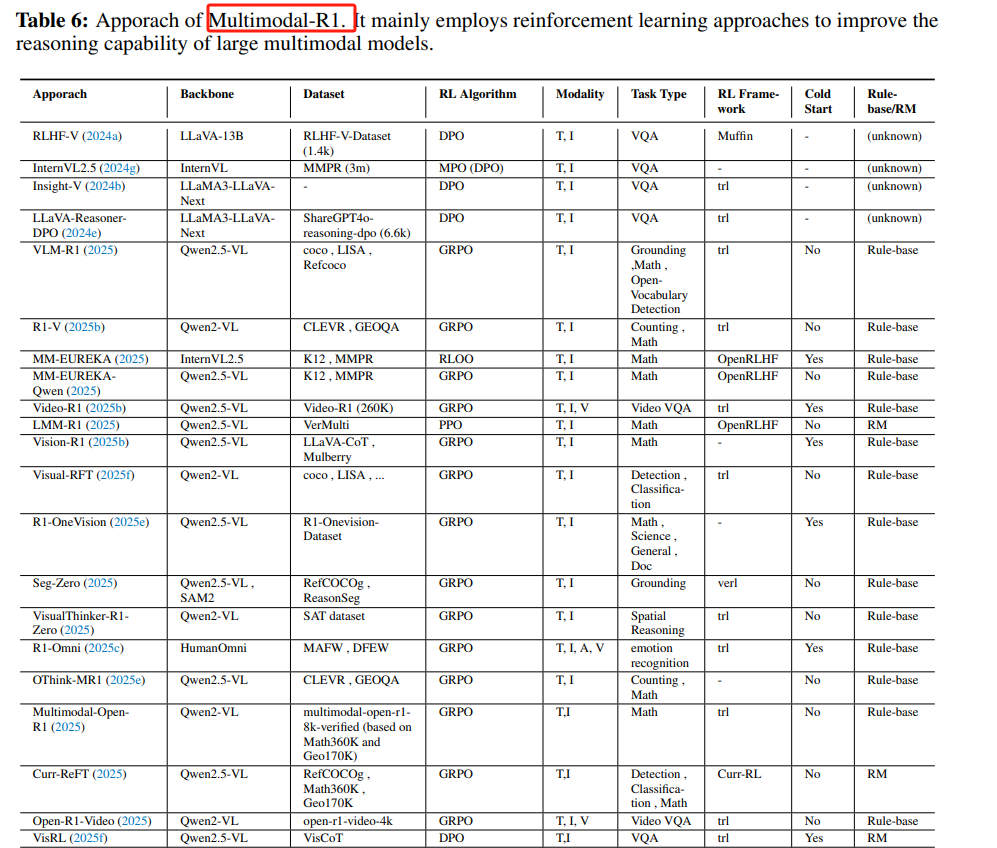

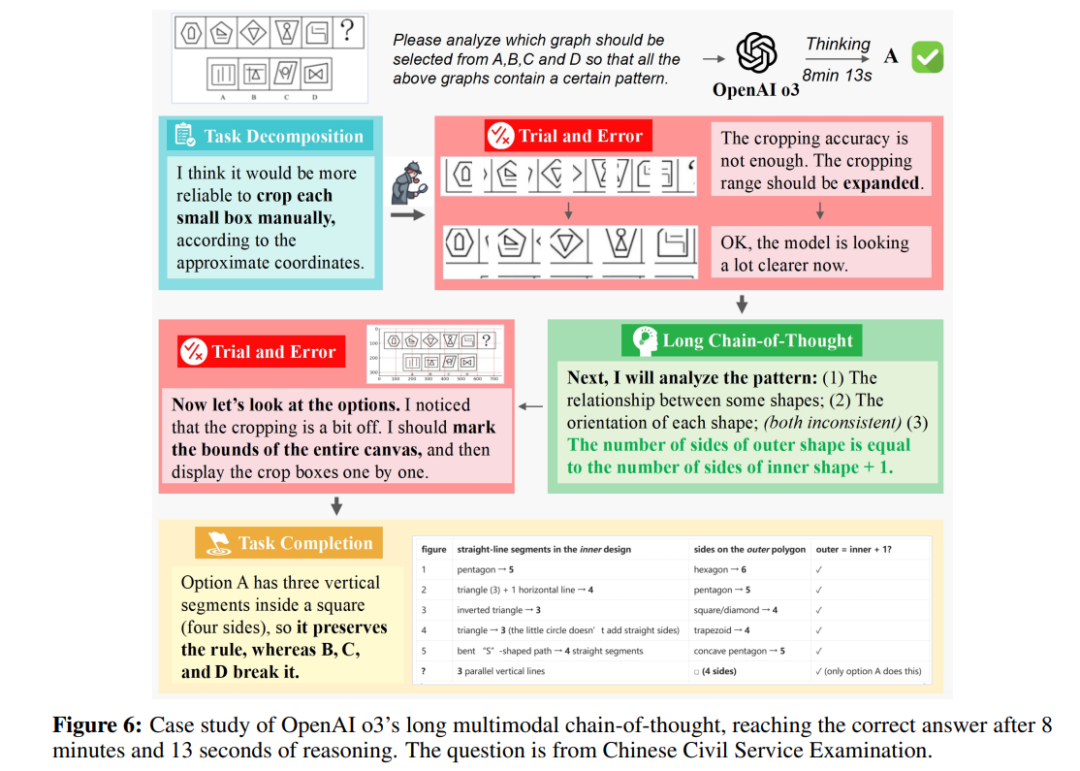

🧠 **以语言为中心的长推理:** 为了处理更复杂的多模态任务,研究者开始探索更深层次的推理能力,包括跨模态推理、多模态O1和R1模型,但这些模型仍然依赖于语言模型的架构,对多模态数据的处理能力有限。

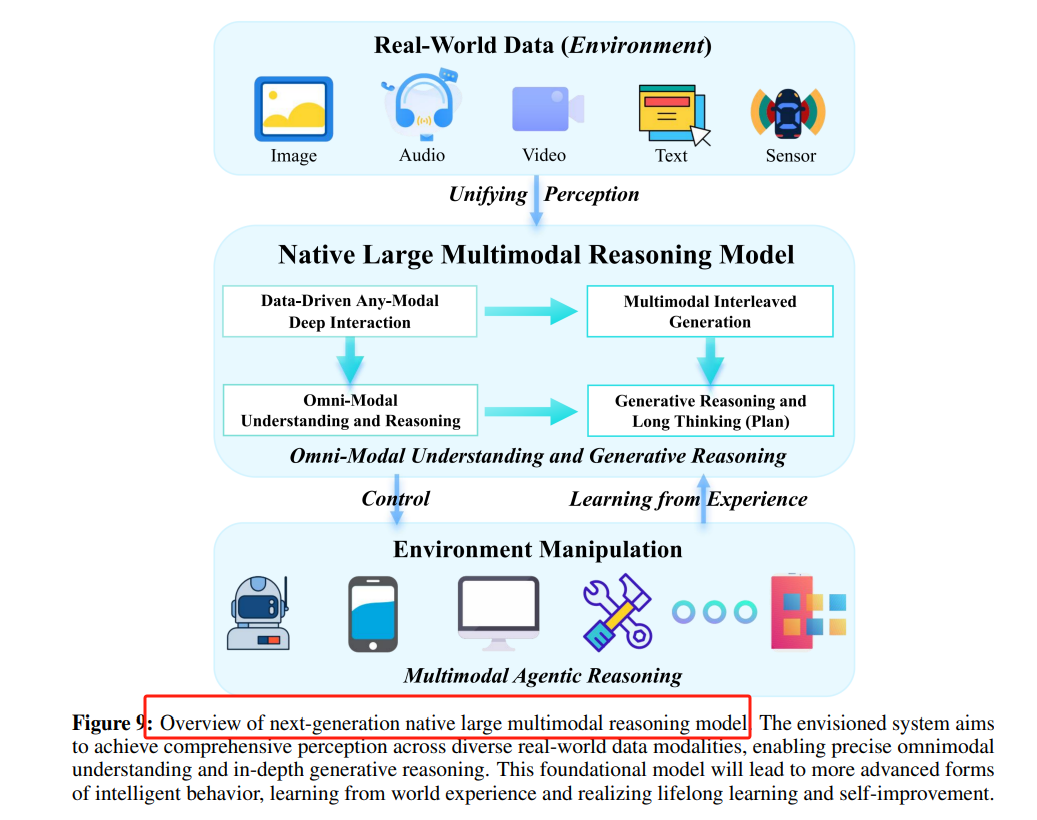

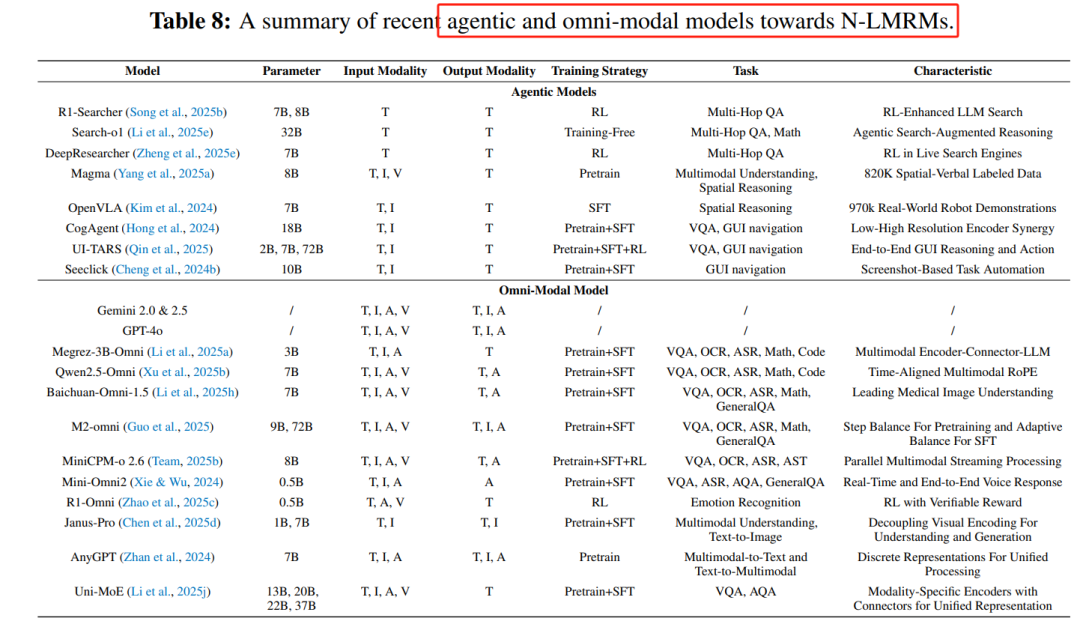

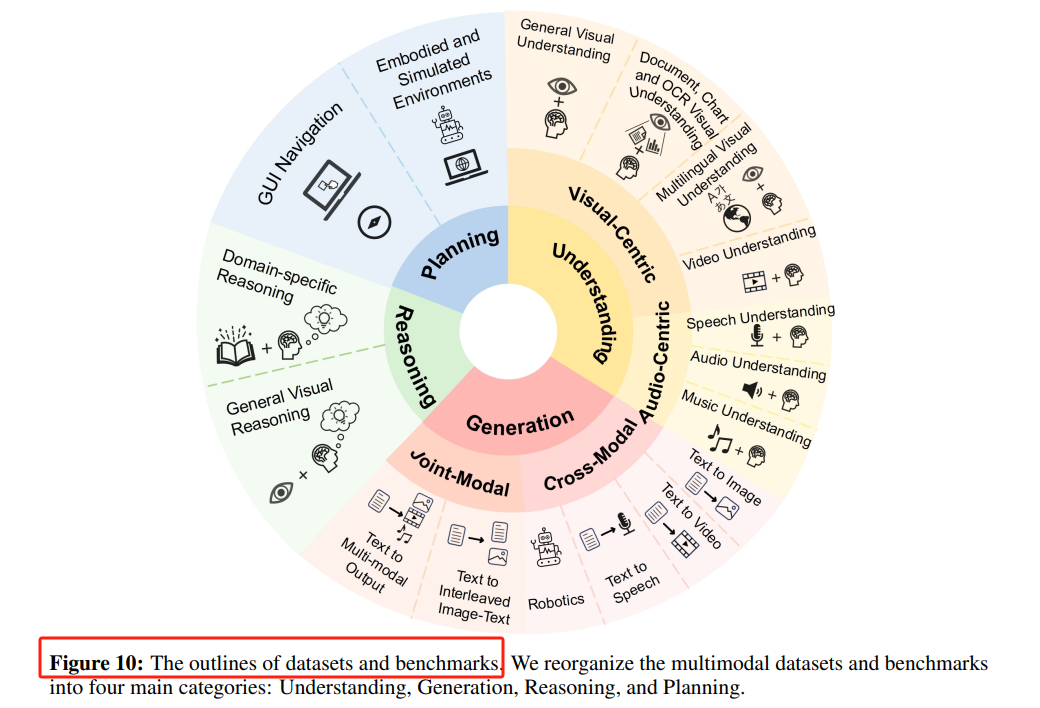

🤖 **迈向原生多模态推理模型:** 为了克服现有模型的局限性,研究者提出了原生多模态推理模型(N-LMRMs)的概念,旨在实现多模态感知、生成和推理的统一架构,关键能力包括Multimodal Agentic Reasoning和Omni-Modal Understanding and Generative Reasoning。

2025-05-12 18:07 湖北

推理是智能的核心,它塑造了决策、得出结论以及在不同领域进行泛化的能力,大语言多模态推理模型(LMRMs)作为一种有前景的范式应运而生,提出了一个全面且结构化的多模态推理研究综述,围绕一个四阶段的发展路线图展开:以及基于 OpenAI O3 和 O4-mini 的挑战性基准测试和实验案例的经验见解早期多模态推理模型受限于有限的多模态数据、不成熟的神经架构和不发达的学习方法,采用模块化设计,将推理过程分解为表示、对齐、融合和推理等独立组件。Modular Reasoning Networks:如NMN(Neural Module Networks)动态组装任务特定模块,用于视觉和文本特征的组合;HieCoAtt(Hierarchical Co-Attention)通过层次化跨模态注意力对齐问题语义与图像区域。Vision-Language Models-based Modular Reasoning:基于ViLBERT、LXMERT等模型,通过大规模图像-文本对训练,统一多模态表示、对齐和融合过程。

局限性:这些模型的推理能力通常隐含在基础感知处理和神经计算中,难以处理复杂的多步推理场景。随着大规模多模态预训练模型的出现,多模态推理能力显著提升,但这些模型的推理能力主要依赖于表面模式匹配,缺乏动态假设生成和多步逻辑推理能力。Prompt-based MCoT(Multimodal Chain-of-Thought):通过精心设计的提示引导模型生成逐步推理路径,如IPVR(Instruction-based Visual Reasoning)和VIC(Visual Infilling and Captioning)。

Structural Reasoning:通过引入结构化分解推理路径,如Multimodal-CoT(MCoT)和G-CoT(Graph-based CoT),提高模型的推理能力。

Externally Augmented Reasoning:通过引入外部工具(如搜索算法、工具增强)来扩展模型的推理能力,如HoT(Hyperedge of Thought)和RAG(Retrieval-Augmented Generation)。

局限性:这些方法主要依赖于语言模型的内在能力,缺乏对复杂多模态数据的处理能力,且推理深度有限。为了处理更复杂的多模态任务,研究者开始探索更深层次的推理能力,包括跨模态推理、多模态O1(OpenAI的O1模型)和R1(Reinforcement Learning-based Reasoning)模型。

Cross-Modal Reasoning:通过引入外部工具(如VisProg)和算法(如FAST和ICoT)增强模型的跨模态推理能力。

Multimodal-O1:基于OpenAI的O1模型,通过扩展推理链和引入结构化推理策略,提升模型的推理能力。

Multimodal-R1:通过强化学习(如DPO和GRPO)增强模型的规划和适应能力,如DeepSeek-R1和R1-OneVision。

局限性:尽管这些模型在推理深度和适应性方面取得了进展,但它们仍然依赖于语言模型的架构,对多模态数据的处理能力有限,且在实时交互和动态环境中表现不足。为了克服现有模型的局限性,研究者提出了原生多模态推理模型(Native Large Multimodal Reasoning Models, N-LMRMs)的概念,旨在实现多模态感知、生成和推理的统一架构。Multimodal Agentic Reasoning:通过目标驱动的交互和动态适应,使模型能够在复杂环境中进行长期规划和学习。

Omni-Modal Understanding and Generative Reasoning:通过统一表示空间实现多模态数据的无缝融合和分析,支持跨模态生成和推理。

Unified Representations and Cross-Modal Fusion:开发能够处理多种模态的统一模型架构。Interleaved Multimodal Long Chain-of-Thought:扩展推理链,实现多模态间的交错推理。Learning and Evolving from World Experiences:通过与环境的持续交互,实现模型的动态学习和自我改进。Data Synthesis:开发高质量的数据合成方法,支持模型的预训练和推理能力提升。

https://arxiv.org/pdf/2505.04921Perception, Reason, Think, and Plan:A Survey on Large Multimodal Reasoning Models

欢迎关注我的公众号“PaperAgent”,每天一篇大模型(LLM)文章来锻炼我们的思维,简单的例子,不简单的方法,提升自己。

阅读原文

跳转微信打开