index_new5.html

../../../zaker_core/zaker_tpl_static/wap/tpl_guoji1.html

![]()

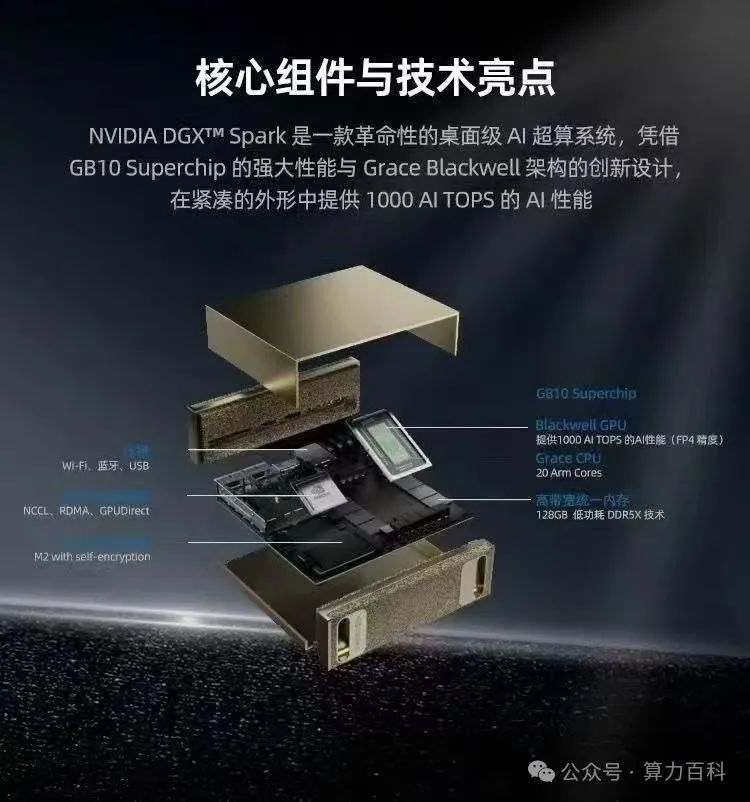

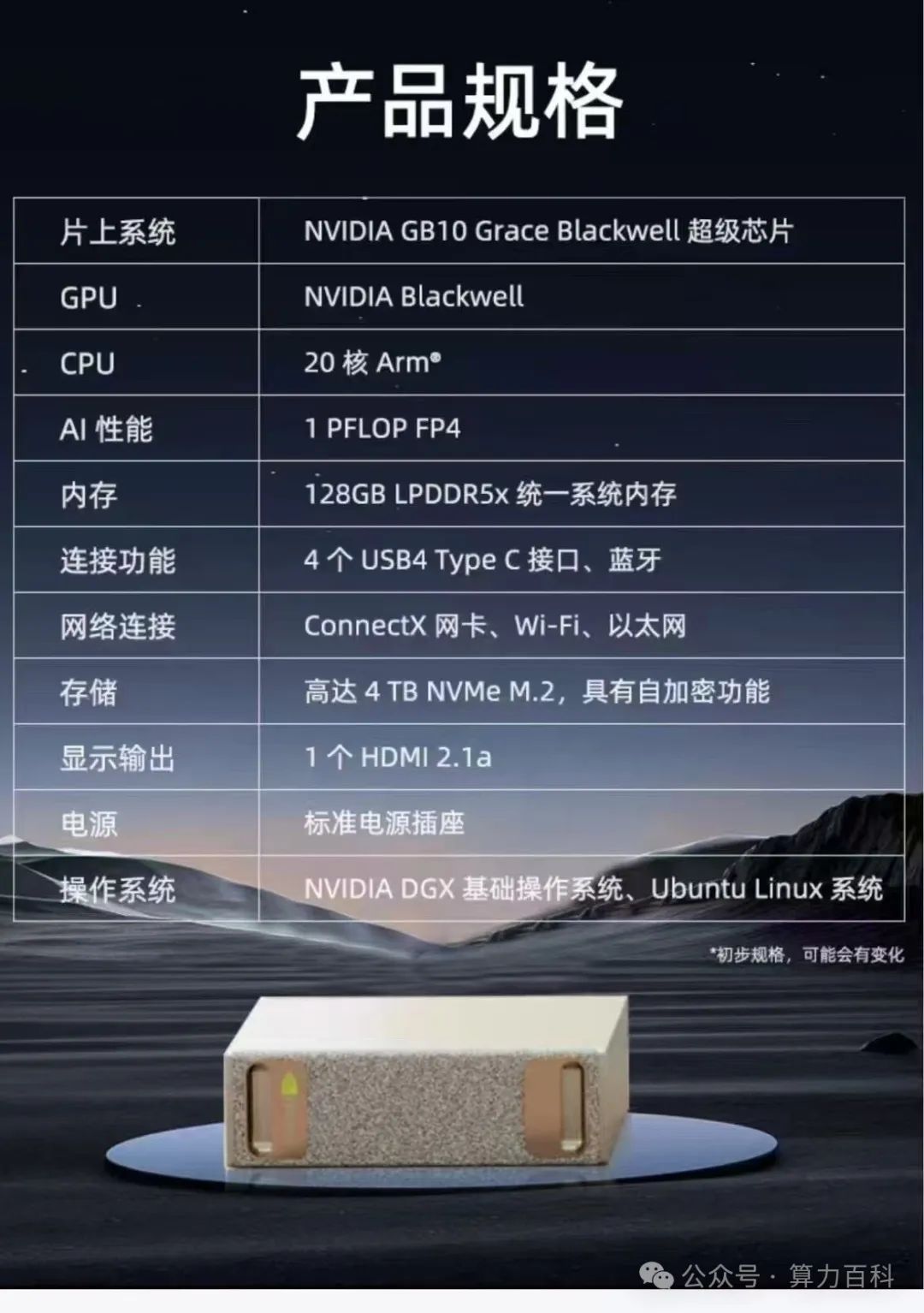

本文分析了英伟达基于Blackwell架构的GB10芯片对国产AI芯片市场的影响。GB10芯片合规且价格亲民,性能强大,尤其适合大模型推理市场。它集成了ARM CPU和Blackwell GPU,提供强大的FP4 AI性能和128GB LPDDR5X统一内存。更重要的是,GB10支持NVLink-C2C互联技术,提升了芯片间通信效率。尽管未来可能出现具有更大显存的消费级GPU,但GB10的企业级互联能力使其在构建高性能推理集群时具有显著优势。建议业内人士关注GB10芯片,将其应用于AI推理服务器或高性能Mini AI服务器的开发。

🚀GB10芯片基于Blackwell架构,由英伟达与联发科联合打造,集成ARM CPU和Blackwell GPU,专为大模型推理市场设计。

💡GB10具备强大的FP4/FP8计算能力(1 PFlops FP4 / 500T FP8),并配备128GB LPDDR5X统一内存,可作为GPU和CPU共享,满足大模型推理的需求。

🔗GB10支持NVLink-C2C芯片间互联技术,显著提升CPU与GPU之间的通信效率,这对于构建多芯片协同工作的AI系统至关重要。

💰GB10价格优势明显,与4090芯片价格相近,但性能更强,这将对国产AI芯片市场形成挤压。

原创 算力百科 J 2025-05-11 06:01 贵州

国产AI芯主要做推理市场,GB10+nvlink主要针对推理市场出货,会对国产AI芯市场形成挤压!

结论:国产AI芯主要做推理市场,GB10+nvlink主要针对推理市场出货,会对国产AI芯市场形成挤压! 除了非公开市场,极低功耗,极高性价比,你是客户你买谁?! 一位即将登场的“狠角色”——它就是基于Blackwell架构的英伟达GB200超级芯片中的关键一环,咱们姑且先聚焦于那颗令人心动的GB10 GB10 首先是他合规的,会大量进入中国市场(也许明天不合规了),第二他的价格仅仅相等于4090芯片的价格10k左右,非常香,主要是强的没边。 目标是大模型推理市场,低功耗,性能强,魔改的最佳选择; 它可不是一块简单的GPU,而是一款AISoC(AI System-on-Chip)芯片!它是英伟达与联发科强强联合的结晶,巧妙地融合了联发科基于ARM架构的CPU和英伟达最先进的Blackwell GPU。这颗芯片上集成了20个高效节能的ARM核心,更重要的是,它的Blackwell GPU部分能提供高达1 PFlops(每秒一千万亿次)的FP4 AI性能!注意,是FP4,这意味着它在处理轻量化但效率极高的AI计算时,能力是爆炸性的,轻松拿捏2000亿参数级别的大模型推理,毫无压力! 单颗GB10芯片,就提供了20个ARM核心加上这强大的FP4/FP8计算力(1000T FP4 / 500T FP8)。更让人兴奋的是它板载的128GB LPDDR5X统一内存!这可不是一般的显存,它可以作为GPU和CPU共享的内存,容量巨大且带宽不俗,对于动辄需要加载超大模型参数的推理任务来说,简直是雪中送炭! GB10最最最“可怕”的杀手锏是什么?是它自带的NVLink-C2C芯片间互联技术!这是基于英伟达看家本领NVLink技术的C2C互联,可以将GPU与CPU之间的通信效率提升到前所未有的高度。这对于需要频繁在CPU和GPU之间交换数据、或者构建多芯片协同工作的AI系统来说,是至关重要的! 单芯提供20core ARM+1000T FP4(500T fp8),提供128GB lp5x统一内存,可当显存用,可怕的是他自带C2C ,英伟达牛逼的nvlink技术打底的C2C还是很顶的; 有人可能会问,未来会不会有128GB显存的5090,那是不是更香?确实,GDDR7的带宽可能比LPDDR5X更高。但是,朋友们,GB10支持C2C,而消费级的5090不支持!在构建多芯片、高性能的推理集群时,C2C带来的通信效率优势,是单纯提升显存带宽无法比拟的。这种企业级的互联能力,才是GB10傲视群雄、剑指大规模推理市场的底气所在; 目前弯弯的产业链都在盯着GB10 的芯片资源,量产之后,将接替4090,成为推理新王。

各位手头有资源、有渠道的朋友,我在这里给大家一个强烈的建议:一定要盯紧这颗GB10芯片! 想办法把芯片拿到手,无论是做成8芯或16芯的AI推理服务器,专门针对像DeepSeek、Qwen这样的大模型做推理优化,这绝对是“爆品”无疑!或者,就算搞不到那么多芯片,能拿到它的主板也好啊! 以此为基础,打造一台高性能的大模型推理Mini AI 服务器,放在桌面就能跑通大型AI应用,这市场需求也是刚性的,同样会是“爆品”! 可以预见,GB10的热度,很可能像当初的4090一样,引发一场市场的“抢购潮”和应用的“革新潮”。 这不仅仅是一颗芯片,它代表着AI推理算力门槛的进一步降低,预示着更多创新应用即将落地,也已领AISOC的未来方向。  这玩意是真漂亮啦,又小,又强,又便宜,500P fp8 定价才2w出头,哪家还能做到?!

这玩意是真漂亮啦,又小,又强,又便宜,500P fp8 定价才2w出头,哪家还能做到?!

全国首个算力和大模型工程专属服务IP

阅读原文

跳转微信打开