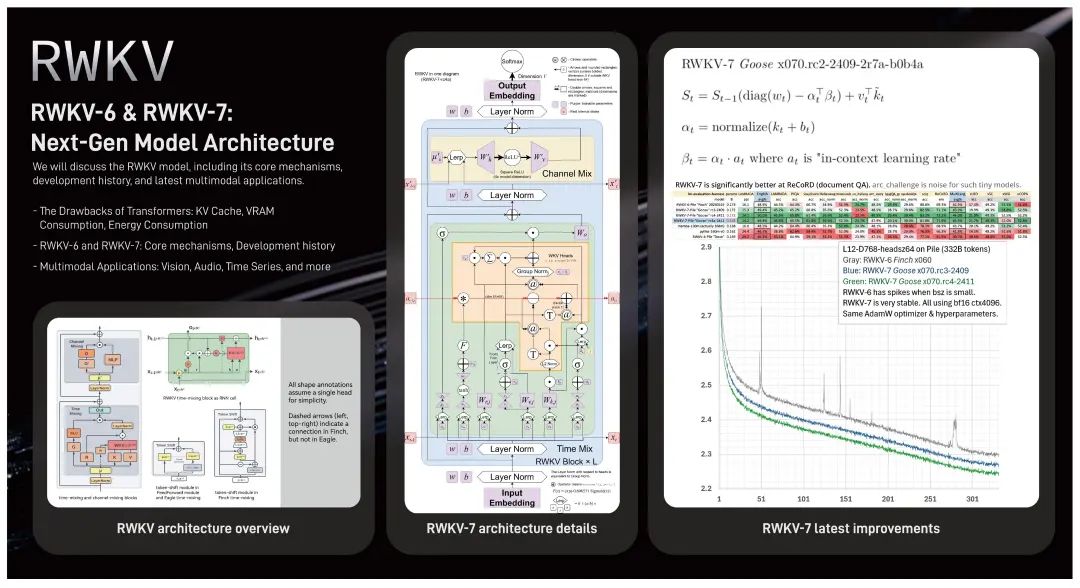

RWKV-7架构在NVIDIA GTC 2025大会上亮相,展示了其在AI大模型领域的最新进展。侯皓文博士现场讲解了RWKV-7的技术细节,并与开发者分享了其创新亮点和应用场景。RWKV-7是一种面向未来的高效AI大模型架构,超越了传统的attention机制,拥有强大的上下文学习和持续学习能力。通过引入广义Delta Rule,RWKV-7在计算效率、任务表现和模型表达力上全面超越了Transformer和过去的RWKV-6架构,其2.9B模型在语言建模能力上达到了SoTA水平。RWKV秉持开源开放理念,与全球AI从业者共同探索AI技术前沿。

💡RWKV-7架构在NVIDIA GTC 2025大会上由侯皓文博士讲解,向全球开发者展示了其技术创新亮点与应用场景,吸引了众多技术人员与开发者驻足交流。

🚀RWKV-7是一种面向未来的高效AI大模型架构,它超越了attention / linear attention 范式,速度与显存恒定,并拥有深刻上下文学习能力和真正持续学习能力,同时保持了100% RNN的特性。

📚RWKV-7的核心机制是引入并优化广义 Delta Rule 作为隐藏状态的演化机制,使其在计算效率、任务表现和模型表达力上全面超越了Transformer和过去的RWKV-6架构。例如,RWKV-7 2.9B 模型的英文和多语言能力均显著超越同尺寸模型。

🤝RWKV秉持全球开源开放的理念,希望与全球AI行业从业者、研究者、开发者与爱好者携手迎接智能革命,共同塑造智能时代的未来。欢迎加入RWKV社区,通过RWKV中文官网、论坛、QQ频道和群聊等渠道了解和探讨RWKV模型。

Ariel Wang 2025-03-20 17:52 广东

RWKV-7 在 NVIDIA GTC 2025 海报展示区

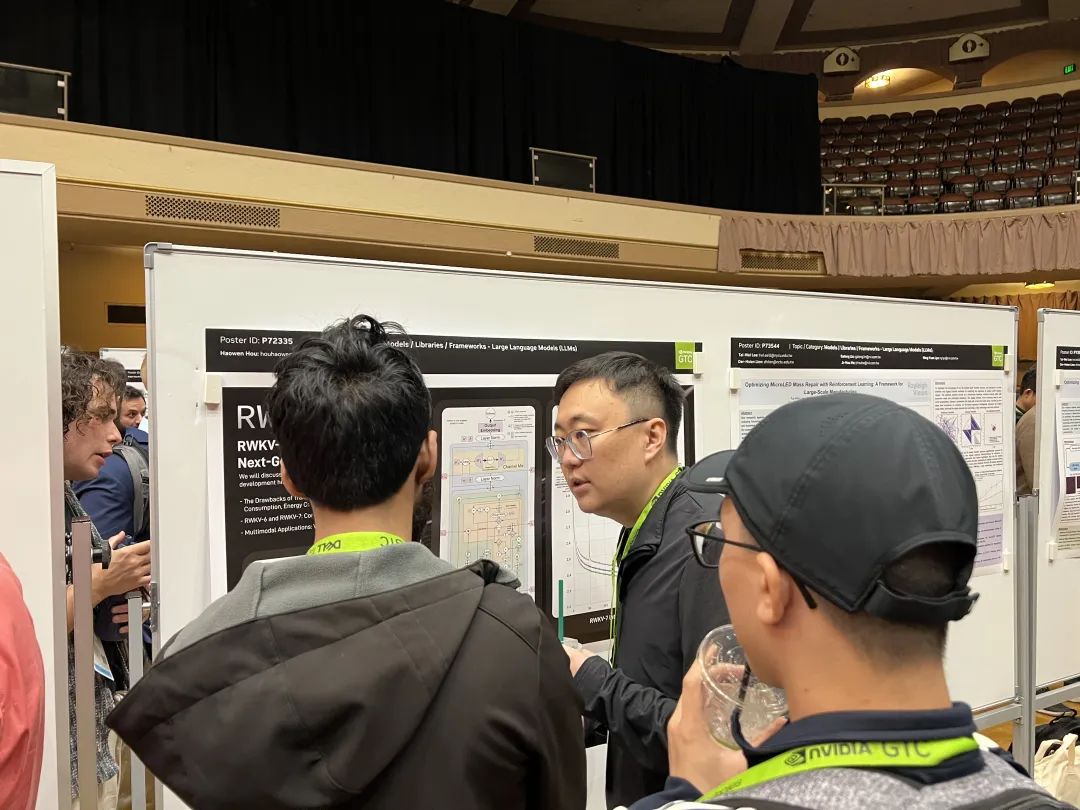

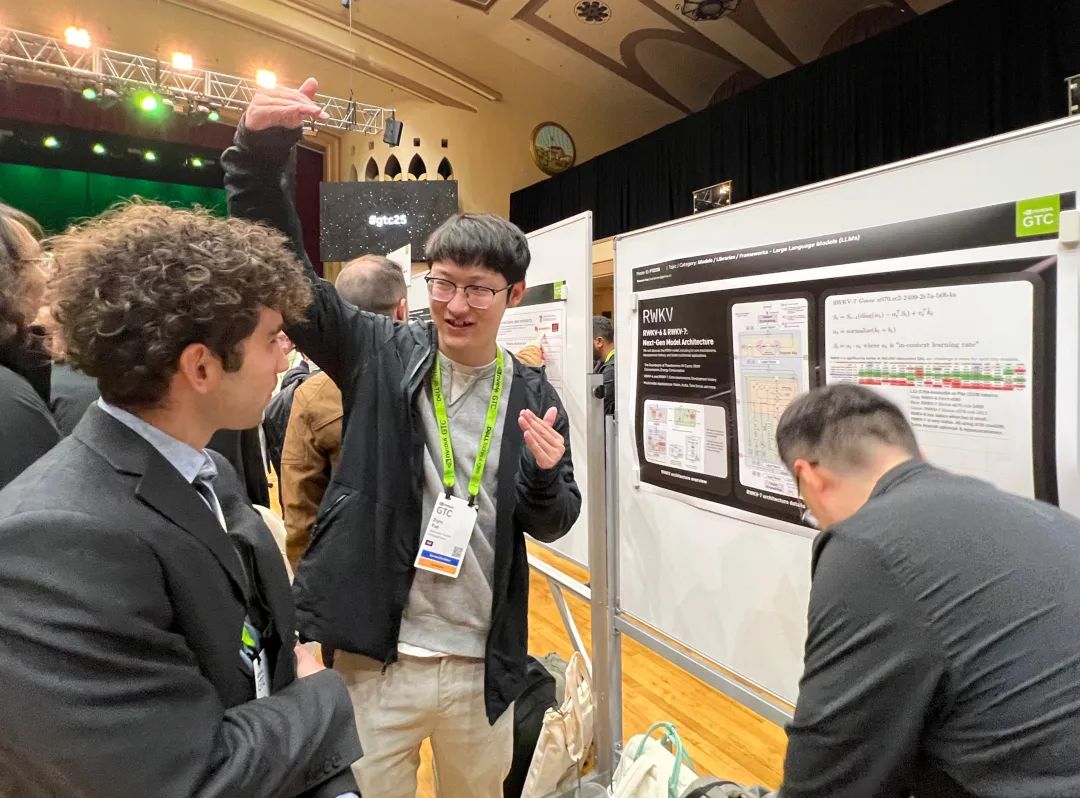

太平洋时间 2025 年 3 月 17 日- 21 日,全球人工智能大会 “NVIDIA GTC 2025” 在美国加州圣何塞正式举行。RWKV 团队在 NVIDIA GTC 的 Poster Reception 展示并讲解了 RWKV-7 架构的最新进展。RWKV 社区突出贡献者、RWKV-7 架构论文作者之一侯皓文博士在现场为来自全球各地的开发者及参会人员进行讲解技术细节,并耐心解答疑问,与全球的 AI 开发者与创新者分享、推广 RWKV-7 架构的技术创新亮点与各大领域的应用场景。

RWKV-7 在 NVIDIA GTC

RWKV 展示区现场学术氛围浓厚,讨论热烈,吸引了诸多技术人员与开发者在展位驻足交流,许多开发者与参会人员表达了对 RWKV-7 架构进展的浓厚兴趣与积极看法,更有不少人直接现场加入了 RWKV 全球开发者社区。

RWKV 团队成员为参会者讲解

RWKV-7 是面向未来的高效 AI 大模型架构,超越 attention / linear attention 范式,速度与显存恒定,并拥有深刻上下文学习能力,可真正持续学习,在保持 100% RNN 的同时,拥有极强的长文本能力。RWKV-7 的核心机制是引入并优化广义 Delta Rule 作为 RWKV-7 隐藏状态的演化机制(State Evolution),超越了传统的 attention / linear attention 范式,拥有强大的上下文学习(in-context learning)能力和持续学习能力。RWKV-7 模型在推理过程中能够不断自动根据新的数据进行自我优化和改进(test-time training),从而显著提升了模型的理解力和处理能力。通过一系列创新(例如广义 Delta Rule),RWKV-7 在计算效率、任务表现和模型表达力全面超越了 Transformer 和过去的 RWKV-6 架构。例如 RWKV-7 2.9B 模型的英文和多语言能力(英文评测 71.1%,多语言评测 62.3%),均显著超越所有同尺寸模型,在训练数据远低于 Qwen2.5、Llama3.2 等开源模型的前提下,RWKV-7-World 模型的语言建模能力在所有开源 3B 规模模型中达到 SoTA 水平。

RWKV-6 and RWKV-7: Next-Gen Model Architecture此次在 NVIDIA GTC 2025 的亮相,RWKV 向全球展示了其在大模型领域的技术积累与创新实力。未来,RWKV 也将秉持全球开源开放的理念,与全球 AI 行业从业者、研究者、开发者与爱好者携手迎接智能革命,不断探索 AI 技术的前沿方向,与全球生态伙伴共同塑造智能时代的未来。加入 RWKV 社区

欢迎大家加入 RWKV 社区,可以从 RWKV 中文官网了解 RWKV 模型,也可以加入 RWKV 论坛、QQ 频道和 QQ 群聊,一起探讨 RWKV 模型。

关注我们:

阅读原文

跳转微信打开