阿里云通义千问团队开源了两款语音基座模型 SenseVoice 和 CosyVoice,分别用于语音识别和语音生成,旨在增强人与大型语言模型之间的自然语音交互,实现语音翻译、情感语音聊天等应用场景。SenseVoice 支持多语言识别,识别效果优于 OpenAI Whisper 模型,并具备情感识别和声音事件检测能力。CosyVoice 支持多语言、音色和情感控制,在语音生成方面表现出色。这两款模型均采用 Apache 2.0 许可证,可免费使用。

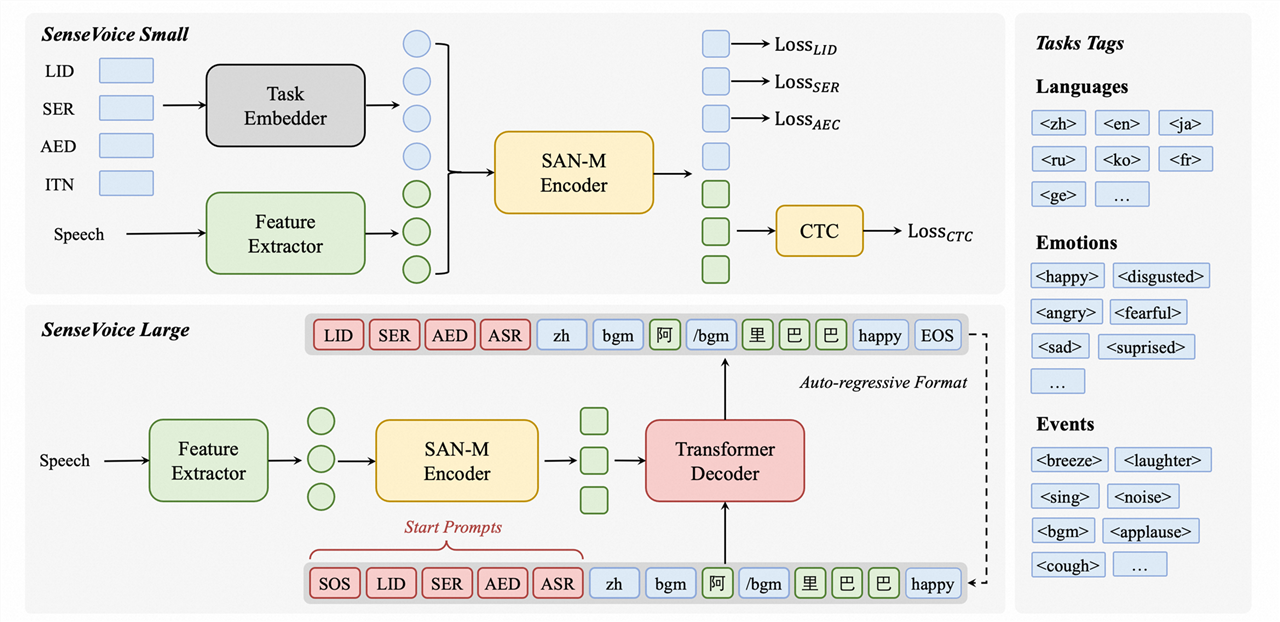

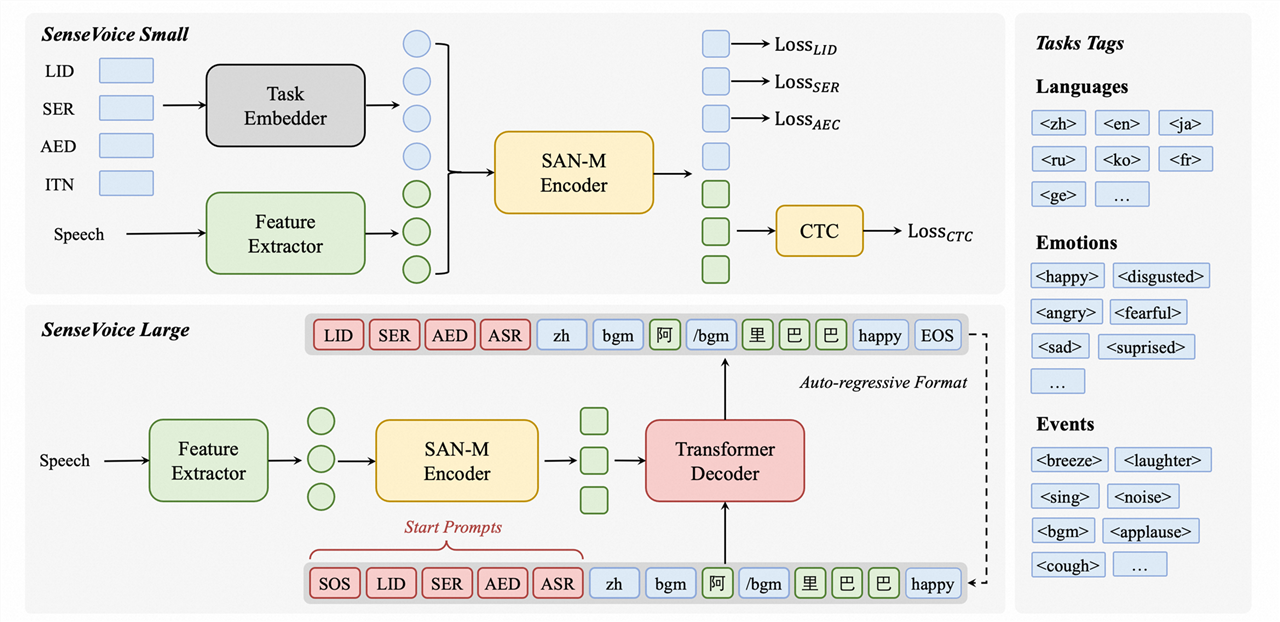

😄 **SenseVoice 模型:** SenseVoice 是一款多语言音频理解模型,支持语音识别、语种识别、语音情感识别、声学事件检测等能力。它采用工业级数十万小时的标注音频进行模型训练,保证了模型的通用识别效果。SenseVoice 可以被应用于中文、粤语、英语、日语、韩语音频识别,并输出带有情感和事件的富文本转写结果。

SenseVoice 模型具备以下特点:

* **多语言识别:** 采用超过 40 万小时数据训练,支持超过 50 种语言,识别效果上优于 Whisper 模型。

* **富文本识别:** 具备优秀的情感识别,能够在测试数据上达到和超过目前最佳情感识别模型的效果。

* **声音事件检测:** 支持音乐、掌声、笑声、哭声、咳嗽、喷嚏等多种常见人机交互事件进行检测。

* **高效推理:** SenseVoice-Small 模型采用非自回归端到端框架,推理延迟极低,10s 音频推理仅耗时 70ms,15 倍优于 Whisper-Large。

* **微调定制:** 具备便捷的微调脚本与策略,方便用户根据业务场景修复长尾样本问题。

* **服务部署:** 具有完整的服务部署链路,支持多并发请求,支持客户端语言有,python、c++、html、java 与 c# 等。

😁 **CosyVoice 模型:** CosyVoice 模型同样支持多语言、音色和情感控制,该模型在多语言语音、零样本语音生成、跨语言语音克隆和指令跟随等功能方面表现出色。

CosyVoice 模型具备以下特点:

* **多语言语音生成:** 支持多种语言的语音合成。

* **零样本语音生成:** 能够根据少量样本生成新的语音。

* **跨语言语音克隆:** 可以将一种语言的语音克隆到另一种语言。

* **指令跟随:** 可以根据指令生成符合要求的语音。

🥳 **FunAudioLLM 框架:** SenseVoice 和 CosyVoice 模型都是 FunAudioLLM 系列的,这是一个旨在增强人与大型语言模型之间自然语音交互的框架。FunAudioLLM 框架的目标是实现语音翻译、情感语音聊天、交互式博客和富有表现力的有声读物叙述等应用场景,突破语音交互技术的界限。

🤩 **模型获取:** 目前这些模型已经在 Modelscope 和 HuggingFace 平台提供,有兴趣的开发者可以通过这两个平台下载模型进行测试。

* **SenseVoice 模型:** https://github.com/FunAudioLLM/SenseVoice

* **CosyVoice 模型:** https://github.com/FunAudioLLM/CosyVoice

* **FunAudioLLM 完整说明:** https://fun-audio-llm.github.io/

阿里云通义千问团队日前在 Github 上开源了两款语音基座模型 SenseVoice 和 CosyVoice,前者用来识别语音、后者用来生成语音,这两款模型在性能方面也非常卓越,其中 SenseVoice 识别效果优于 OpenAI Whisper 模型。

这两款模型都是完全开源的,采用 Apache 2.0 许可证,因此无论是个人、开发者还是企业都可以免费下载模型部署后使用,可以成为 Whisper 等付费 API 模型的替代。

SenseVoice 模型:

SenseVoice 多语言音频理解模型,支持语音识别、语种识别、语音情感识别、声学事件检测、逆文本正则化等能力,采用工业级数十万小时的标注音频进行模型训练,保证了模型的通用识别效果。模型可以被应用于中文、粤语、英语、日语、韩语音频识别,并输出带有情感和事件的富文本转写结果。

多语言识别: 采用超过 40 万小时数据训练,支持超过 50 种语言,识别效果上优于 Whisper 模型。

富文本识别:具备优秀的情感识别,能够在测试数据上达到和超过目前最佳情感识别模型的效果。

支持声音事件检测能力,支持音乐、掌声、笑声、哭声、咳嗽、喷嚏等多种常见人机交互事件进行检测。

高效推理: SenseVoice-Small 模型采用非自回归端到端框架,推理延迟极低,10s 音频推理仅耗时 70ms,15 倍优于 Whisper-Large。

微调定制: 具备便捷的微调脚本与策略,方便用户根据业务场景修复长尾样本问题。

服务部署: 具有完整的服务部署链路,支持多并发请求,支持客户端语言有,python、c++、html、java 与 c# 等。

CosyVoice 模型同样支持多语言、音色和情感控制,该模型在多语言语音、零样本语音生成、跨语言语音克隆和指令跟随等功能方面表现出色。

这两款模型都是 FunAudioLLM 系列的,这是一个旨在增强人与大型语言模型之间自然语音交互的框架,从而实现语音翻译、情感语音聊天、交互式博客和富有表现力的有声读物叙述等应用场景,突破语音交互技术的界限。

目前这些模型已经在 Modelscope 和 HuggingFace 平台提供,有兴趣的开发者可以通过这两个平台下载模型进行测试,下面是项目地址。

SenseVoice 模型:https://github.com/FunAudioLLM/SenseVoice

CosyVoice 模型:https://github.com/FunAudioLLM/CosyVoice

有关 FunAudioLLM 完整说明:https://fun-audio-llm.github.io/