Hugging Face Hub 已成为 AI 协作的核心平台,托管了数万个模型、数据集以及交互式应用程序 (

值得注意的是,对于交互式应用,每位创作者都需自行制定隐私政策和用户知情同意机制。这意味着整个生态系统内部存在多样的治理策略,从而增加了治理的多样性和弹性。

这种分布式的方法也促成了多种用户知情同意机制的实践形式 —— 既包括强调 “隐私优先设计” (privacy-by-design) 原则的严格框架,也包括为大规模数据集提供“选择退出” (opt-out) 通道的灵活机制。这些多样的路径,展示了社区如何在真实环境中尝试数据使用与用户权利之间的平衡。

随着人工智能开发对大规模数据与道德责任的双重需求不断上升,Hub 所倡导的社区驱动模式,为我们提供了宝贵的启示:在尊重用户数据控制权的同时,也能推动技术创新的发展。

通过深入观察这些差异化的实践,我们可以更好地理解开放生态系统是如何构建出以人为本的用户同意协议。这些协议不仅满足基本的法律合规要求,更进一步回应了人们对人工智能在数据使用、模型开发和部署过程中的伦理期待。

Hub 上的用户知情同意机制

在 Hugging Face 的生态系统中,用户知情同意 (Consent) 的实践因项目和代码库而异,展现出丰富的多样性。这种差异化的做法催生出多种框架,让用户数据治理更加灵活:

开放系统与封闭系统的隐私影响差异: Hub 透明的开发流程使用户同意机制可以接受公众监督 (public scrutiny)。这种透明性带来了强烈的责任感,而这在许多封闭式系统中是缺失的。在开源项目中,同意机制的设计和实现可以被全球开发者审查、批评与持续优化;而在封闭系统中,这些机制常被隐藏在企业防火墙之后,外部无法审查,也难以建立信任。 比如,

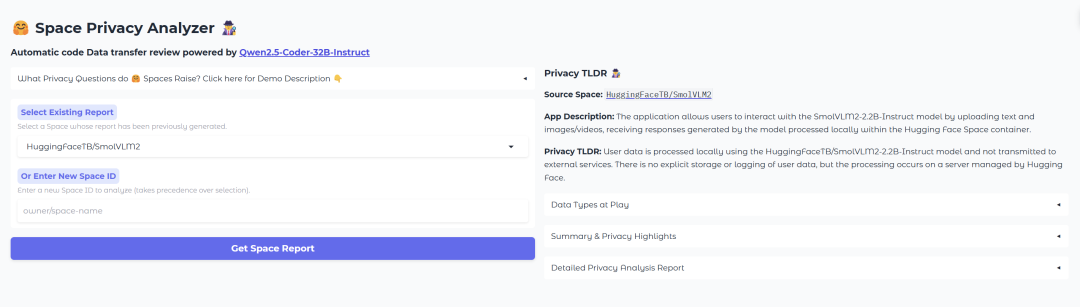

https://yjernite-space-privacy.hf.space/

社区驱动的标准与多样化的实现方式: Hub 倡导一种自下而上的发展方式,在这里,道德规范并非由上而下强制推行,而是通过实际的开发和应用逐步自然形成。这种方式使得伦理框架更加贴合社区的真实需求,也更具灵活性。

正因如此,用户同意机制在不同场景下被定制化地实现,形成了因地制宜的实践路径。例如:

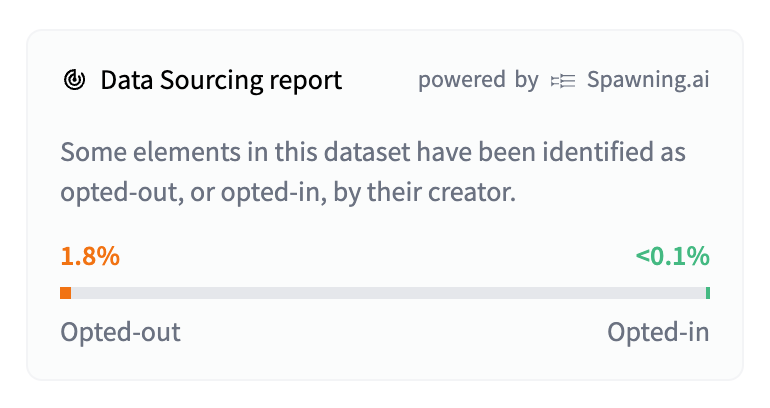

截至目前,已有大约 8000 万条选择退出的记录 (大多数是通过平台合作获取,只有约 4 万条来自个人艺术家) 。该系统目前已在 Hugging Face 生态系统中实现。

用户知情同意的技术实现示例

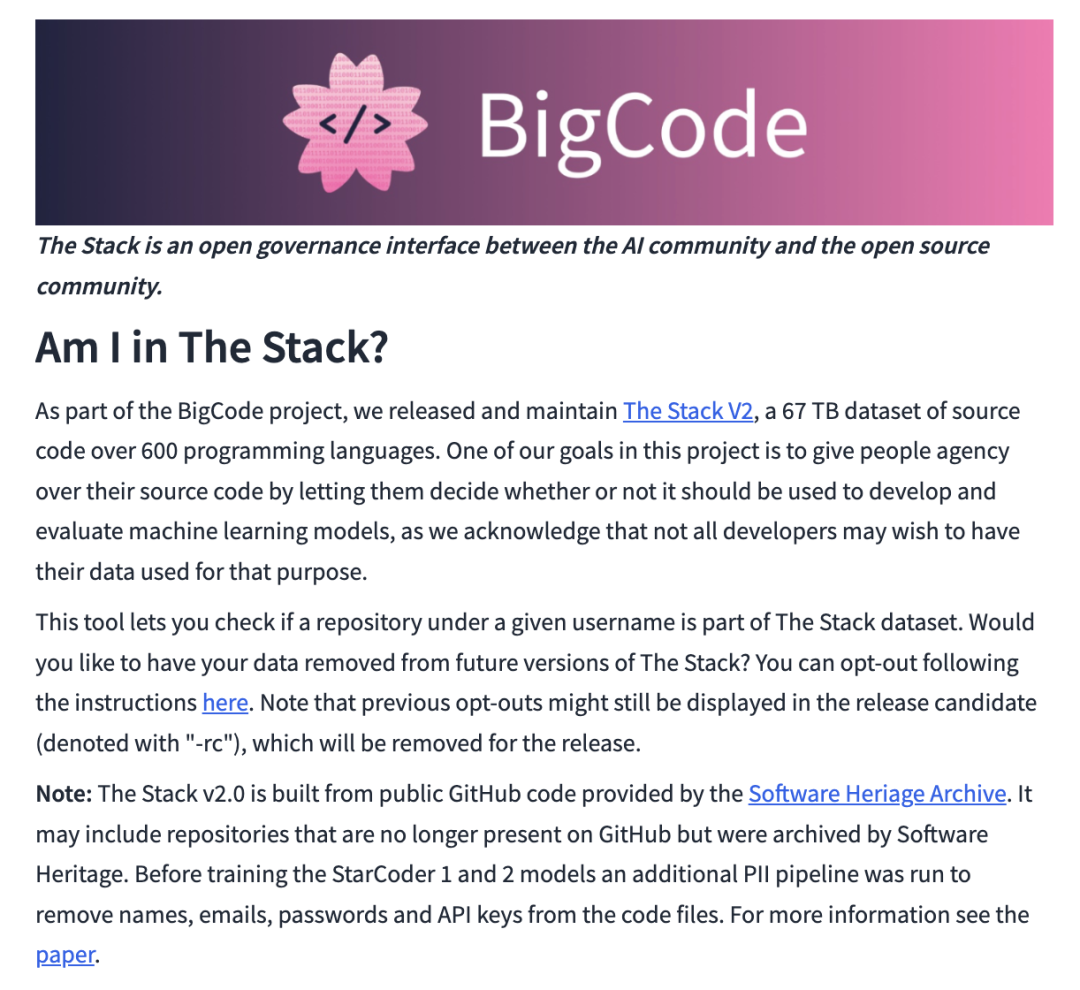

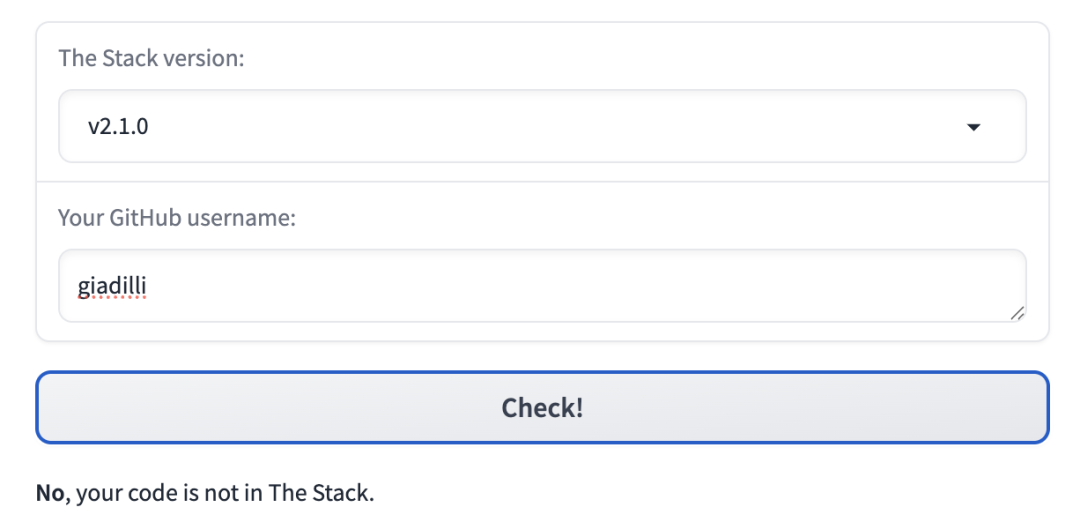

BigCode 数据溯源检测系统 (Am I In The Stack?)

这种“知情同意机制”的核心要素包括:

事后发现机制: 用户可以主动查询自己的特定代码仓库是否被包含在数据集中,从而实现数据收集的透明化。该项目通过提供可搜索的界面,大大降低了信息获取的门槛。

明确的“选择退出”机制: 为用户提供清晰的路径,申请将其数据从未来版本的 The Stack 数据集中移除。这种 “选择退出” 的方法承认了大规模数据集的集体价值与个体控制其数据使用权之间的张力。

数据来源的透明性: 项目对数据来源进行了详细说明 (例如:使用来自 Software Heritage Archive 的公共 GitHub 代码) ,其中包括一些已经不再存在于 GitHub 上的仓库。这种“历史性”特征也使同意机制更为复杂——例如:我们该如何处理来自已不再活跃的开发者,或已删除的仓库中的数据?该项目没有回避这些伦理灰区,而是通过记录这些边缘案例,正面回应了这些挑战。

隐私保护措施: 项目披露了在训练 StarCoder 模型前,所采取的移除个人敏感信息的技术流程,例如删除姓名、电子邮件地址、密码以及 API 密钥等。此举体现了对开发者潜在无意中暴露敏感数据问题的重视与防护。

学术支持文献: 该项目还引用了一篇已发表的学术论文,供希望进一步了解数据收集与处理细节的用户参考。这种与同行评审文献的衔接,使其“同意机制”符合学术界的记录规范与合理性要求。

BigCode 的该方法展示了在利用公开可用代码推动 AI 开发的同时,如何尊重开发者意愿,实现平衡:

FineWeb 的 “主动知情同意管理” 机制

选择退出系统: 不同于 BigCode 数据溯源检测系统所提供的基于仓库的搜索工具,FineWeb 实现了一个通用的“选择退出”表单系统,允许个人基于版权主张或隐私顾虑申请移除其内容。

响应式执行机制: FineWeb 团队积极处理并落实了大量内容移除请求,展现了他们在数据初步收集之后,依然致力于尊重用户的法律权利和个人隐私偏好。

处理流程的透明性: FineWeb 通过开源其完整的数据处理流程 datatrove 库

HuggingChat 的隐私优先策略

隐私优先的设计理念: HuggingChat 从产品开发的最初阶段就嵌入了

隐私保护机制: 所有对话内容都是明确私密的,不会因任何目的 (包括研究或模型训练) 被分享给任何人,甚至包括模型的开发者。这种做法是一种有意识的权衡,这可能会限制模型的优化空间,但优先保障了用户隐私的绝对性。

数据存储目的明确: 对话数据的存储仅用于让用户能够访问自己的历史记录。这一限制划定了数据使用的边界,避免了常见的 “数据被用于与最初目的无关用途” 的现象,而这一类用途通常缺乏额外的用户同意。

用户控制权: 用户可以随时通过点击 “删除” 图标,清除任何一段历史对话。这个实时控制机制让用户可以自主、立即地管理自己的数据,而无需走繁琐的申请流程。

通过将数据收集与用户账户关联,HuggingChat 在确保责任归属的同时,也为用户提供了具体可控的数据管理选项。这一实现方式展示了 “知情同意” 如何不只是一次性的授权,而是一个持续存在、可以被更新和撤回的过程。

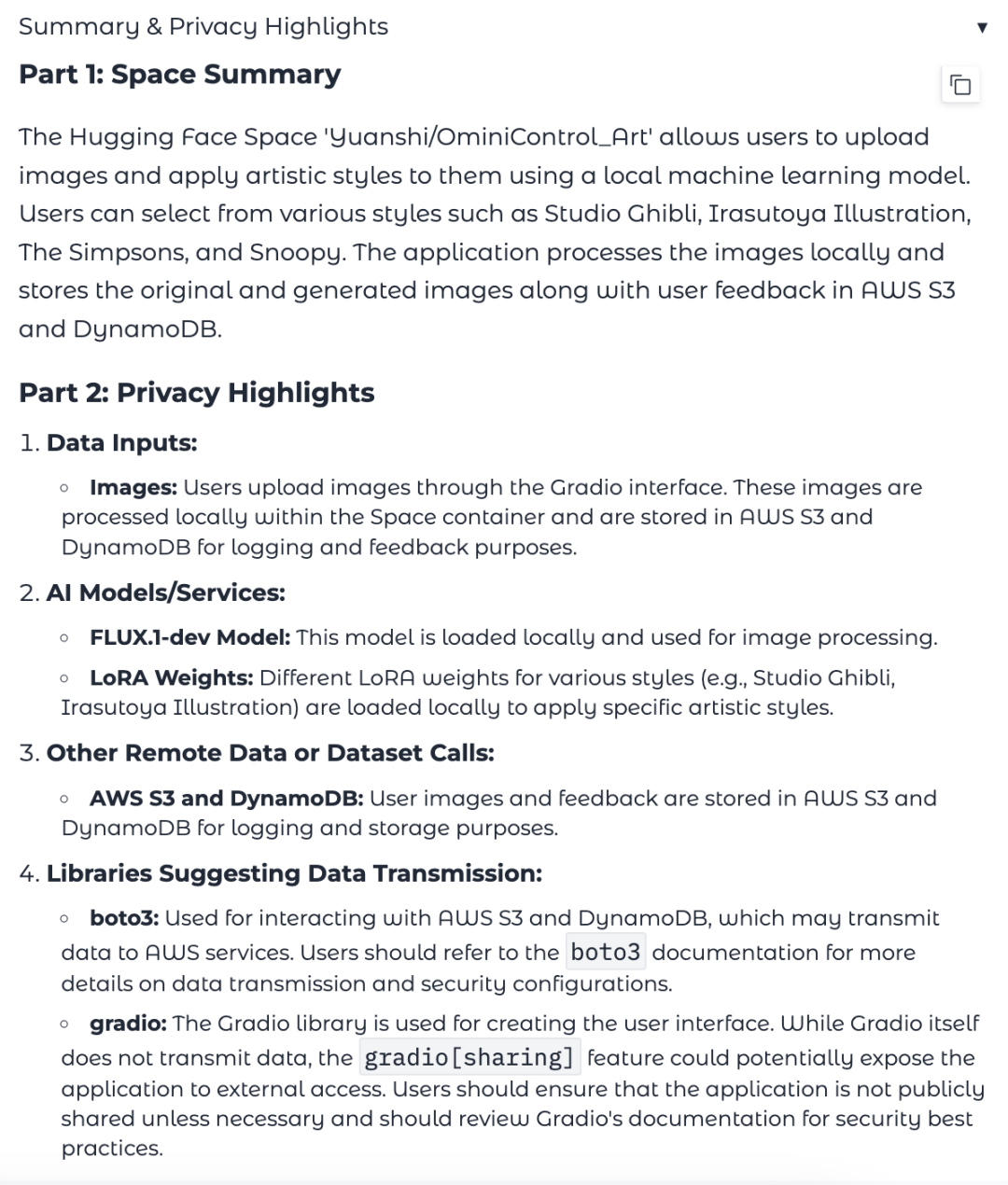

隐私分析器:通过代码分析实现透明性

隐私分析器

通过自动化分析 Spaces 如何处理用户数据,Privacy Analyzer 让 “代码层的实现” 与 “用户层的理解” 之间的鸿沟得以缩小。因为 “知情同意” 不仅需要在数据收集政策上实现透明,更需要在这些政策的技术实现过程中保持清晰可见。

授权机制的进化之路

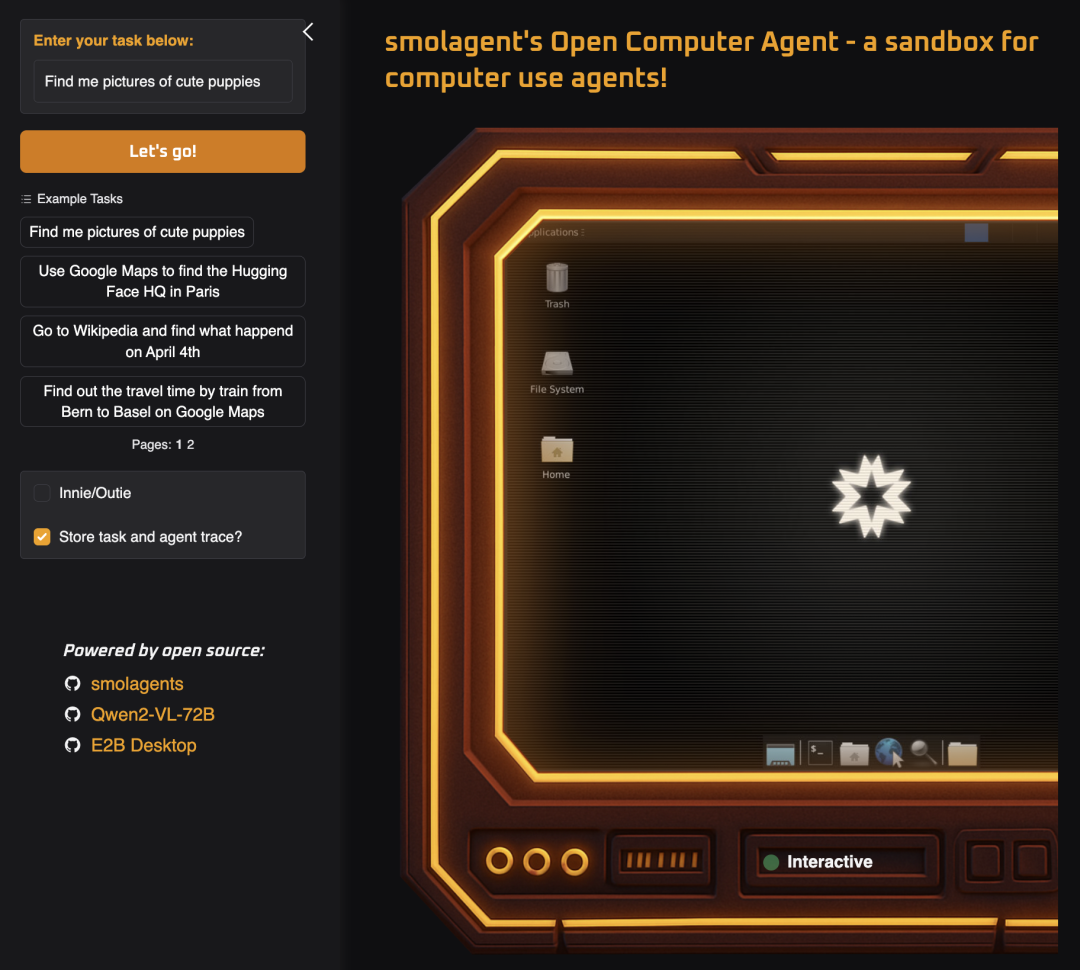

智能体交互式应用与任务日志控制

Hugging Face Hub 上的某些专用智能体交互式应用 (AI Agent Spaces),如 smolagent 的 Open Computer Agent 是通过显式的任务日志控制机制来实现用户知情同意的:

这种方式在提升智能体 (Agent) 性能所需的技术数据采集与用户的隐私关切之间实现了平衡。它通过在用户操作的关键节点上提供精确控制选项,使同意机制变得简洁而高效。与那些更复杂、长期的数据管理系统不同,该方法强调的是即时、基于当前会话的控制,让用户在每一次使用时都能清楚地掌控自己的数据使用权。

行业在知情同意机制与数据控制方面的实践

AI 行业在 “用户同意” 与 “数据管理” 方面呈现出多样化的方法,这些做法反映出各平台在隐私保护、功能实现与数据收集之间的不同侧重点:

商业化 AI 平台: 像

自托管解决方案: 例如

这些多样化的方法突显出 “知情同意机制” 正在从传统的简单授权,逐步演变为体现隐私价值的系统性架构。对像 Open WebUI 这样由用户主控的环境日益重视,表明在未来的 AI 交互中,数据主权 (data sovereignty) 可能会成为同意机制的核心要素。

结语:构建社区驱动的授权伦理体系

我们在 Hugging Face 生态系统中探讨的各种 “知情同意机制” 揭示了一个重要的事实:有效的知情同意实践不仅仅是法律合规或标准化政策的问题。它们是在社区实验、实际操作与伦理反思中逐步形成的。展望未来,这一领域的发展可能会沿着以下几个方向前进:

超越“二元”选择: 最先进的同意机制已不再局限于 “同意 / 拒绝” 这种简单模型,而是转向更细致的控制系统,允许用户精确设定收集哪些数据、如何使用、使用多久。这种 “精细化” 的控制体现了对 “知情同意” 复杂性的尊重。

将知情同意内嵌为基础架构的一部分: 不再将用户知情同意视为事后的附加操作,而是像 HuggingChat 的隐私设计、Open WebUI 的本地数据控制那样,把同意机制嵌入到 AI 系统的底层架构中,从而实现更强健的隐私保障。

协作式治理: Hugging Face Hub 中的 “由社区驱动的知情同意” 体现了一种治理新模式。即不是由平台单方面制定规则,而是由用户与开发者共同参与、共同塑造不断演进的标准。

技术素养与可访问性: 随着同意机制的日益复杂,如何确保它们对不同技术水平的用户都易于理解与使用,变得愈发关键。

最重要的是,Hugging Face 所倡导的去中心化模型为 “知情同意机制创新” 提供了一个独特实验场,这是传统封闭平台难以比拟的优势。通过开放共享、社区批判与持续优化,大家得以共同构建既能赋能用户、又能支持负责任 AI 开发的同意框架。

在 AI 领域中, “知情同意” 并不是一个可以 “一次性解决” 的问题,而是一场与技术同步演进的持续对话。Hugging Face 所代表的生态系统,通过其对透明性与社区参与的高度重视,为这场对话提供了一个理想的土壤,使其得以持续生长与深化。

英文原文:

https://hf.co/blog/giadap/consent-by-design 译者: Adeena

内容中包含的图片若涉及版权问题,请及时与我们联系删除