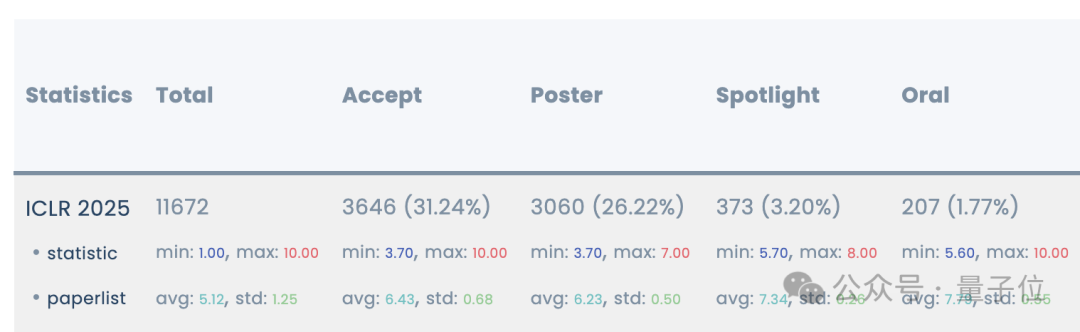

ICLR 2025杰出论文揭晓!

从11672篇中突出重围,共有三篇获奖论文,他们均有华人参与——

包括清华姚班、北大校友,OpenAI、DeepMind大厂技术人员以及中科大何向南团队。

获奖的论文分别是:

Safety Alignment Should be Made More Than Just a Few Tokens Deep

Learning Dynamics of LLM Finetuning * AlphaEdit: Null-Space Constrained Knowledge Editing for Language Models

这三篇均是华人学生为一作:OpenAI研究员漆翔宇、不列颠哥伦比亚大学Yi Ren以及新国立的Junfeng Fang,中科大Houcheng Jiang。其中最后一篇是由全华人团队完成。

一起来看看这三篇论文说了啥。

均是华人学生为一作

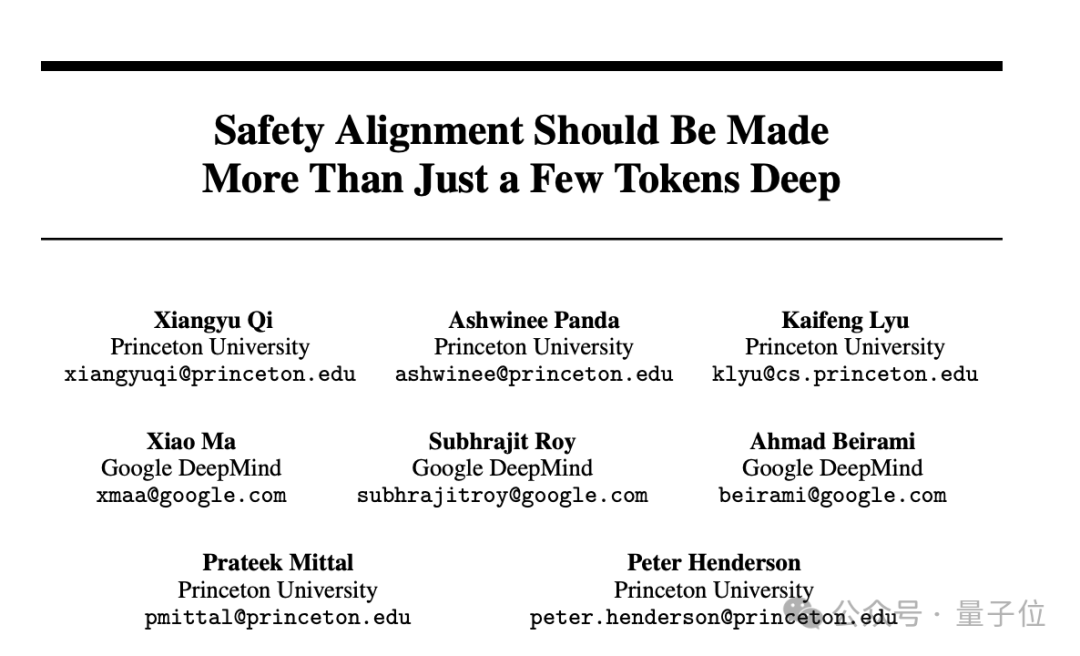

1、Safety Alignment Should be Made More Than Just a Few Tokens Deep

该研究由普林斯顿大学、DeepMind的研究人员完成,其中华人包括普林斯顿漆翔宇,他博士已毕业,目前在OpenAI当技术人员。

同样从普林斯顿博士毕业的还有吕凯风,今年6月他将前往清华叉院担任助理教授,本科毕业于清华姚班。还有DeepMind的Ma Xiao,本科毕业于北大。

这篇论文主要讨论了当前大语言模型在安全对齐方面存在的一个关键问题:安全对齐不够深入,仅仅停留在前几个输出token,并提出了相应的改进方法,包括数据增强、约束优化,都取得了很好的效果。

作者强调:未来的安全对齐不能只做 “表面功夫”,而要真正深入模型的生成逻辑。

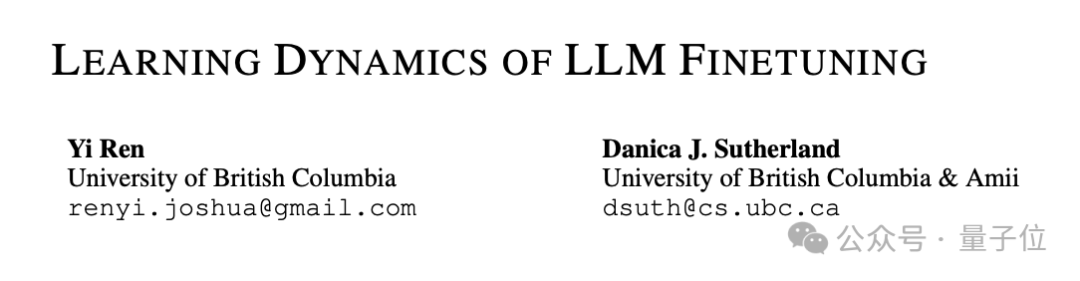

2、Learning Dynamics of LLM Finetuning

该研究由UBC(不列颠哥伦比亚大学)团队完成。

大语言模型微调对对齐人类偏好至关重要,但现有分析缺乏动态视角。本文引入学习动力学框架,解析大模型在指令微调(SFT)和偏好微调(如 DPO)中参数更新对预测的影响,旨在解释幻觉、重复生成等现象并优化对齐性能。

特别地,团队提出了一种假设性解释,说明为什么特定类型的幻觉在微调后会得到加强,例如,模型可能会使用问题B回答中的短语或事实来回答问题 A,或者模型可能会在生成回答时不断重复类似的简单短语。另外他们扩展了框架,强调了一种 “挤压效应”,来解释运行 DPO 时间过长甚至会降低预期输出的可能性。这一分析不仅为理解大模型的微调提供了一个新的视角,还启发了一种简单有效的方法来提高对齐性能。

3、AlphaEdit: Null-Space Constrained Knowledge Editing for Language Models

该研究由中科大何向南团队、新加坡国立大学蔡达成团队等组成的全华人团队完成。

大型语言模型(LLM)经常会出现幻觉,产生错误或过时的知识。因此,为了实现有针对性的知识更新,模型编辑方法应运而生。为了实现这一目标,一种流行的范式是定位编辑法,这种方法首先定位有影响力的参数,然后通过引入扰动对其进行编辑。但这种扰动不可避免地会破坏LLMs 中原本保存的知识,尤其是在连续编辑的情况下。

这篇论文提出了AlphaEdit 大语言模型知识编辑方法,解决现有方法更新知识易破坏原有知识的问题。技术亮点是将参数扰动投影到保留知识的零空间,仅专注更新目标知识,自动保护原有知识,且可轻松集成到现有方法。在各种模型(包括 LLaMA3、GPT2-XL 和 GPT-J)上进行的大量实验表明,AlphaEdit 只需为投影添加一行代码,就能将大多数定位编辑方法的性能平均提高 36.7%。

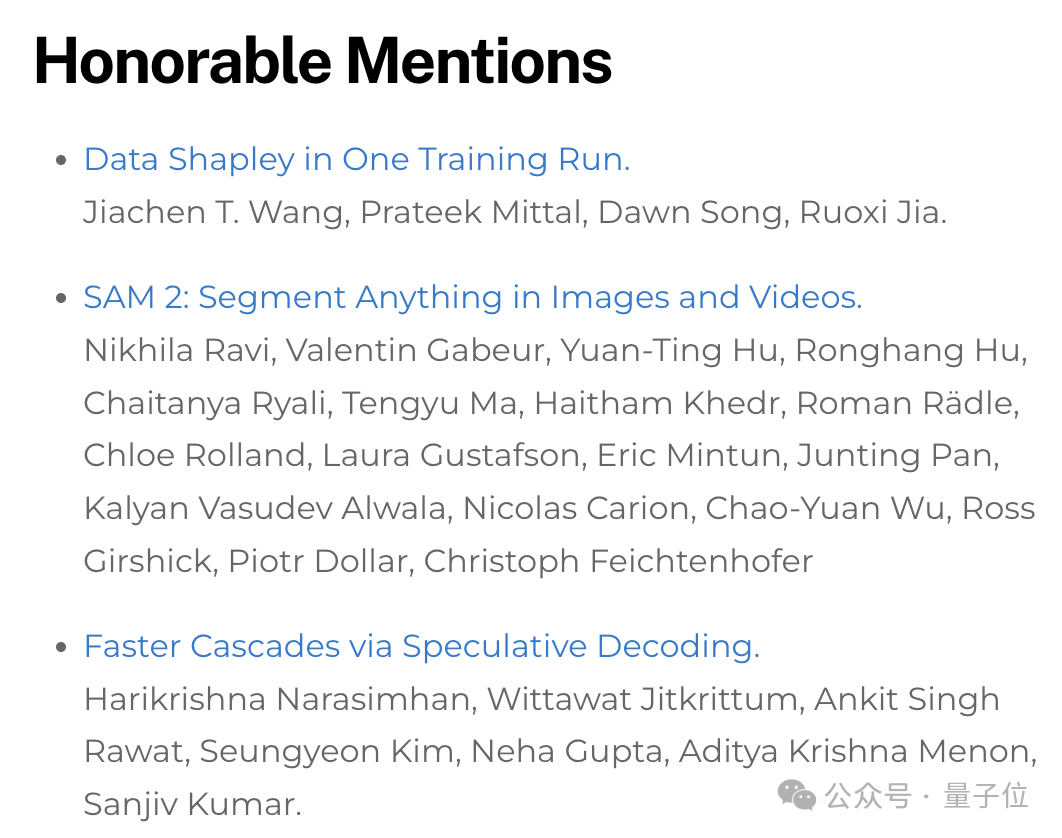

还有三篇提名

除此之外,还有三篇论文提名,他们分别是:

由普林斯顿、UC伯克利等团队提出的一种可扩展的机器学习数据归因算法In-Run Data Shapley;Meta出品的分割一切SAM 2.0版本以及谷歌研究院、DeepMind以及Mistral AI提出提高语言模型推理效率新型方法。

获奖论文链接:

https://arxiv.org/abs/2406.05946

https://arxiv.org/abs/2407.10490

https://arxiv.org/abs/2410.02355

参考链接:

https://blog.iclr.cc/2025/04/22/announcing-the-outstanding-paper-awards-at-iclr-2025/

*本文系量子位获授权刊载,观点仅为原作者所有。

一键三连「点赞」「转发」「小心心」

欢迎在评论区留下你的想法!

— 完 —

🌟 点亮星标 🌟

内容中包含的图片若涉及版权问题,请及时与我们联系删除