今天为大家介绍的是来自加拿大多伦多大学Bo Wang团队的一篇论文。基于transformer深度学习架构的大型语言模型已经彻底改变了自然语言处理领域。受人类语言与基因组生物学代码之间类比关系的启发,研究人员已开始基于transformer及相关架构开发基因组语言模型(gLMs)。本综述探讨了transformer和语言模型在基因组学中的应用。作者调查了适合使用gLMs的基因组学开放性问题,并论证了对这些问题使用gLMs和transformer架构的理由。作者讨论了gLMs通过无监督预训练任务对基因组进行建模的潜力,特别关注零样本和少样本学习的能力。作者探索了transformer架构的优势和局限性,以及当前gLMs更广泛的优势和局限性。此外,基于目前的研究趋势,作者思考了超越transformer架构的基因组建模的未来。本综述可作为对transformer和语言模型在基因组数据领域感兴趣的计算生物学家和计算机科学家的指南。

在过去的十年中,深度学习已被应用于复杂任务,包括生成艺术、表示语言和从氨基酸序列预测蛋白质结构。深度学习的成功归因于可用数据集的规模、可访问性和多模态性,以及推动生成越来越大模型的趋势。在基因组学中,新型技术如染色质可及性、甲基化、转录状态、染色质结构和结合分子等产生了大量且多样化的数据源。由于深度学习工具有潜力解决组学数据集带来的诸多挑战,它们被广泛应用于基因组学领域。

本综述将讨论基因组学中深度学习方法的发展轨迹,包括transformer,并详细讨论基因组语言模型(gLMs)的应用、成功和挑战。这里所指的gLMs是在基因组token序列(如核苷酸或k-mers)上预训练的模型。鉴于该领域发展迅速,作者承认无法做到全面,因此主要关注截至2024年7月的选定模型和进展。

基因组学深度学习模型训练使用的数据是什么?

生物体的基因组是由其完整的DNA序列集合定义的。仅使用四种不同的核苷酸(通常表示为A、T、G和C),生命所必需的信息被编码在连续的DNA片段中。DNA具有双链结构,两条互补的链结合在一起并以相反的方向读取。对于包括人类在内的许多复杂生物,DNA被缠绕并包装成数百万碱基对长的染色体。每条染色体包含许多基因,即转录成RNA的DNA区域。在转录过程中,许多不同的蛋白质复合物以特定顺序被招募,通常是通过被称为基序的核苷酸模式。这些基序存在于基因周围的非编码DNA序列中。有一些非编码DNA序列的例子可以影响数千碱基对远的基因的调控,作为启动子、增强子、抑制子或绝缘子发挥作用。DNA是以片段的形式进行测序,然后组装成研究充分的物种的全基因组参考序列,并存储在GenBank和RefSeq等公共数据库中。对于研究较少的物种,完整的组装体可能尚不存在。

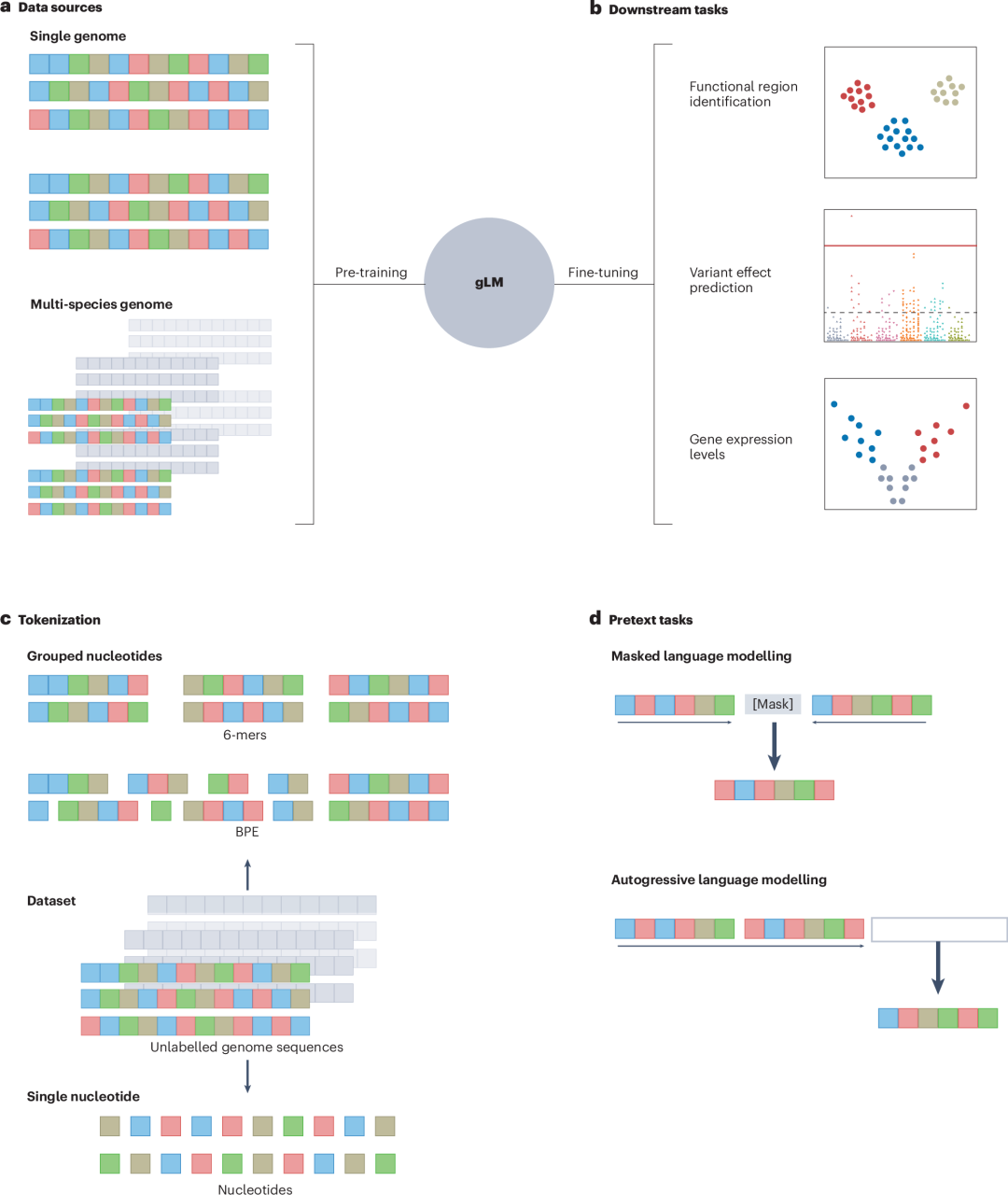

DNA序列数据在输入深度学习模型时要么被一位有效编码,要么被分词。DNA的一位有效编码将长度为N的序列转换成一个4×N的零和一的矩阵,表示在序列中每个位置上特定核苷酸的存在或缺失。分词策略各不相同,单核苷酸token、k-mers或字节对编码(BPE)创建了不同大小的词汇表(图1)。

图 1

k-mer分词借鉴了生物信息学原理,将长度为k的核苷酸子序列视为基因组语言的"单词"。BPE迭代地合并基因组中最常见的共同出现的核苷酸,构建一个指定大小的基因组词汇表,其中包含不同长度的"单词"。虽然染色体有数百万碱基对长,但深度学习模型限制于较短的输入,通常最多1,000个token。然而,巧妙的分词(例如,如果某些token表示100 bp长度的基序)可以将有效上下文扩展到10,000 bp。全染色体上下文仍然是一个开放性挑战。相反,由于染色体长度的序列太长,它们通常在分词或一位有效编码之前被分割成可管理的长度。

为什么选择transformer和gLMs?

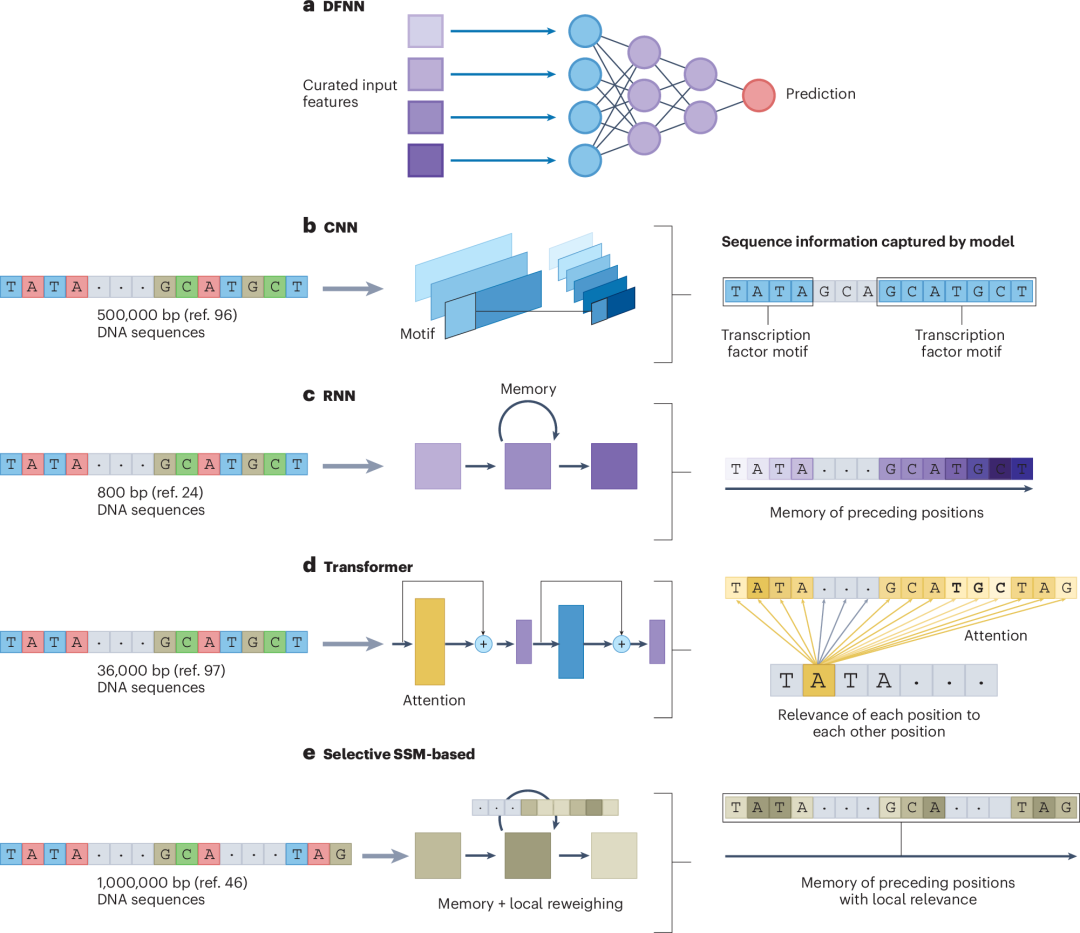

Transformer在DNA表示中表现出色,主要是因为它们的注意力机制,能够捕捉整个序列中的关系,而不受核苷酸邻近性的限制。这与循环神经网络(RNNs)形成对比,后者在处理长距离依赖关系时遇到困难,而卷积神经网络(CNNs)则仅限于捕捉固定窗口大小内的关系(图2)。Transformer最初作为编码器-解码器开发,自然地在早期用于基因组序列的编码器-解码器模型的成功基础上进行了构建。

图 2

大多数DNA序列数据都是未标记的。gLMs通过预训练解决了这个问题,从基因组token中学习可泛化的表示,而不依赖人工注释(图1)。这减少了偏见并提高了下游任务的性能。当设计良好时,预训练任务增强了模型执行"少样本"和"零样本"任务的能力。少样本性能在基因组学中特别有价值,因为生物学家经常使用有限的、经过良好表征的例子(例如,微RNA或增强子)。强大的零样本性能有潜力在基因组中发现新的调控语法。

Transformers:基因组语言模型(gLMs)

最早的基因组语言模型之一DNABERT,是为基因组序列建模而对原始BERT模型进行的改编。DNABERT使用掩码语言模型(MLM)任务对重叠的k-mers进行预训练,然后针对特定任务进行微调。这些任务包括以高精度预测近端和核心启动子区域以及转录因子结合位点的存在。然而,DNABERT有限的上下文窗口(512个token)限制了其建模长程依赖关系的能力。为解决这个问题,该模型的一个变体DNABERT-XL将较长的序列分割成较小的片段,然后独立输入到模型中。虽然这种增加上下文窗口大小的方法能够很好地区分TATA和非TATA启动子,但由于注意力计算成本的限制,DNABERT未能展示出在建模复杂长程依赖关系方面的端到端方法。

DNABERT的主要优势是引入了基因组数据的自监督预训练。如表1所示(表过大,请读者在网址中查阅,https://www.nature.com/articles/s42256-025-01007-9/tables/1),该模型在任何微调任务之前都经过了广泛的预训练。这减轻了后期对大量标记的特定任务数据的需求,并凸显了基因组语言模型的强大功能。与DNABERT类似,Nucleotide Transformer也以自监督方式进行预训练,并采用k-mer化进行标记化。这个模型家族的规模各不相同,从5亿到25亿参数不等,与DNABERT不同的是,它使用非重叠k-mers来避免重叠k-mers中的token泄漏问题。然而,非重叠k-mer方法也有局限性,主要是单个核苷酸碱基的插入或删除会导致序列标记化方式的巨大变化。

最小的Nucleotide Transformer模型比DNABERT大五倍,作者的基准测试实验(预测增强子、启动子、TATA启动子、剪接位点等)表明,增加模型大小可以获得更好的性能。这与导致像Enformer及其前身等实验预测模型增加其参数规模的直觉相同。Nucleotide Transformer还表明,使用物种内变异性进行训练(使用单一物种的多个基因组,如数千个人类基因组)的效果不如使用物种间变异性进行训练(他们的多物种训练方案)。这可能是因为多物种模型能够捕捉到在进化过程中保守的功能重要性,使它们即使在基于人类的预测任务上也能更好地泛化。Nucleotide Transformer模型强烈表明,在预训练中利用进化多样性数据的模型将提高捕捉功能相关性的能力。

DNABERT-2遵循多物种训练方法,并使用BPE而非k-mers进行标记化。这种方法避开了与重叠和非重叠k-mer标记化相关的问题。BPE在基因组内迭代合并频繁的核苷酸对或片段,而不是使用特定的k-mer。这导致模型的词汇表由一组可变长度的token组成,代表跨物种的整个基因组数据集。已观察到DNA序列的BPE标记化会产生生物学上显著的token,最长的token对应于已知重复的基因组元素。相比之下,k-mer标记化对基因组的所有区域一视同仁。此外,BPE方法保持与非重叠标记化相同的计算效率。DNABERT-2的作者采用了几种其他方法来提高比DNABERT的计算效率,包括使用Flash Attention等。尽管参数少21倍且计算成本显著降低,这些修改使DNABERT-2在几项任务中的表现与Nucleotide Transformer模型相当。

另一个最近推出的基于transformer的DNA基因组语言模型家族是GENA-LM。与DNABERT-2一样,它使用BPE标记化,并且像Nucleotide Transformer一样,有仅限人类和多物种模型,具有不同的参数。然而,GENA-LM与其他模型之间的一个显著区别是使用稀疏注意力机制,以帮助缓解transformer注意力机制在上下文长度上的二次计算复杂度。这使得GENA-LM模型比其他基于transformer的基因组语言模型具有更长的最大序列长度,最大标记化序列长度为4,096个token。BPE标记化后的中位token长度为九个碱基对,因此GENA-LM模型可以处理长达36,000个碱基对的序列。

Transformer以外的模型架构

尽管transformer是基因组语言模型的主导架构,但替代方案也能匹配其性能并经历类似的预训练机制(例如,MLM或ALM预训练任务)。目前尚不清楚transformer模型的成功是源于架构的特性,如注意力机制,还是这种机制只是使这些模型比其同类更快地扩展规模。可能是transformer的预训练能力(这不限于该架构)对其成功贡献最大。如果是这种情况,transformer模型可能会在自然语言处理、蛋白质组学和基因组学中被其他模型所取代。

基因组预训练网络(GPN)复制了transformer编码器模块的精确架构,但将注意力机制替换为跨序列的卷积操作。这一想法来源于最近的研究,这些研究表明预训练的CNN在自然语言处理和蛋白质建模方面与transformer具有竞争力。GPN模型利用MLM预训练任务进行预训练,并且仅基于单个核苷酸进行训练,而不使用BPE或任何k-mer化策略。预训练中使用的基因组包括来自国家生物技术信息中心(NCBI)基因组的八个十字花目参考基因组组装。在预训练期间,作者没有在512 bp窗口中平等地采样整个基因组,而是取了外显子(带有小的内含子侧翼)、启动子(转录起始位点上游1,000个碱基对)和来自整个基因组的互补随机窗口的并集。虽然作者表示这可能改善了性能,但他们没有展示任何实验来验证这一说法。

作者证明了GPN仅通过对基因组DNA序列的无监督预训练就能学习非编码变异效应,其表现优于监督深度学习模型,如DeepSEA。另一个非transformer的基因组语言模型HyenaDNA实现了100万核苷酸的上下文大小,是利用全对比注意力的最大基因组语言模型Nucleotide Transformer的500倍。原始Hyena论文的作者没有依赖二次方时间复杂度的注意力机制(该机制比较序列中的每对点),而是设计了一个亚二次时间层。HyenaDNA基于仅解码器transformer架构的结构,直接用Hyena算子替换了注意力机制。HyenaDNA使用ALM预训练任务进行生成式训练。HyenaDNA模型仅在一个人类参考基因组上进行训练,为未来的工作提供了明显的方向。该模型在GenomicBenchmarks的所有八个数据集上都表现出了最先进的性能。

最近提出的Evo模型在整个原核生物基因组上进行训练。Evo使用StripedHyena架构,这是注意力层和Hyena层的混合体。作者首次提供了缩放法则(Scaling Law)实验,证明使用StripedHyena架构而非Mamba、Hyena或一系列高效Transformer变体的合理性。缩放法则分析旨在确定预训练数据集大小、使用的模型架构和性能指标之间的关系。自然语言处理中语言模型的缩放法则表明,增加训练数据集大小和模型大小会导致性能成比例地提高。这是在自然语言处理中使用这些模型的强有力动机,并表明这些模型的训练任务学习了数据的底层结构。然而,基因组语言模型和蛋白质语言模型是否遵循这种缩放法则尚未得到有力证明。

Evo能够预测非编码RNA(不编码蛋白质但可能调节细胞活动的RNA)中的突变是否会导致适应性下降,这是通过非编码RNA深度突变扫描(ncRNA DMS)实验测量的。Evo展示了给定启动子-RNA结合位点序列对预测基因表达的能力,并能预测基因必要性,因为必要基因中的突变比非必要基因导致更大的负对数似然变化。总体而言,Evo的作者表明Evo在各种任务上表现出色,但仅在原核生物数据上进行测试,并与同时在真核和原核DNA上预训练的模型进行比较。此外,原核生物基因组比真核生物基因组简单得多,这使得Evo在基因组规模上的表现和Evo预训练的有效性不一定适用于真核生物DNA。

基因组语言模型的评测标准

为了标准化基因组语言模型比较,已提出了几个基准测试任务集合:GenomicBenchmarks、基因组理解评估(GUE)和BEND基准测试论文。GenomicBenchmarks和GUE评估微调性能,而BEND评估零样本和少样本性能,要么直接通过基因组语言模型嵌入,要么通过在它们之上训练浅层CNN。

一个良好预训练的基因组语言模型应该在嵌入空间中将相似序列嵌入到接近位置,将不相似序列嵌入到远离位置。对于变异效应预测,参考序列和变异序列嵌入之间的余弦距离可以指示功能差异。对于像增强子区域注释这样的任务,评估零样本嵌入不那么直接。这就是为什么在基因组语言模型嵌入之上训练浅层CNN,以从冻结的基因组语言模型预训练权重中预测特定注释,用于基因发现、染色质可及性、组蛋白修饰等任务。

BEND论文发现,当前的基因组语言模型显示出前景,但并不始终优于有监督基线,这与其他关于零样本性能的研究结果一致。Nucleotide Transformer多物种和原始DNABERT模型在零样本和少样本嵌入方面表现最佳,Nucleotide Transformer在基因发现和增强子注释方面表现出色,而DNABERT在染色质可及性和组蛋白修饰预测方面表现优异。这些模型接近像Enformer和Basset这样的混合模型的性能。然而,为基因组语言模型设计和策划基准测试任务和数据集仍然是未来研究的一个领域。

未来方向

随着基因组语言模型的日益普及,深度学习基因组模型的成功以及它们当前面临的局限性为未来提供了复杂的前景。在深度学习基因组建模的显著趋势中,最突出的是无监督预训练方案的潜力,特别是多物种预训练。这种方法可以捕获基因组中进化保守的数据,并更好地模拟其基本语法规则。

由于许多这些模型的成功被认为取决于其昂贵且耗时的预训练方案,因此了解模型在预训练与微调过程中究竟学习了什么至关重要。最近的研究调查了BERT模型在基因组学中的行为,显示从随机数据中获得的k-mer嵌入在下游任务上的表现与从真实生物序列预训练的k-mer嵌入相当。这告诉作者,虽然预训练和无监督学习可能增强基因组模型的能力,但这些模型的预训练任务必须经过精心设计和验证,以证明真正的基因组语法正在被捕获。作者建议对这些模型进行进一步实验,比较预训练和微调与随机初始化和微调的嵌入空间。

此外,作者质疑在整个基因组上进行预训练是否是充分利用预训练力量的最佳方式。重复的非编码DNA部分占人类基因组的近一半,这可能会压倒这些模型从相对较少但更重要的序列区域学习更相关信号的能力。

虽然这篇综述主要关注基于DNA的基因组语言模型,但单细胞RNA-seq语言模型遵循许多类似的原则。然而,这些模型有其自身的优势和局限性,特别是在处理转录组数据的非序列性质方面。对这些模型的深入探讨超出了本文范围,但作者预计DNA和单细胞RNA-seq语言模型之间的架构和预训练任务设计的许多进步将会趋同。

新的基因组语言模型架构如Hyena层正在出现,它们不依赖于注意力机制但仍支持预训练。与传统transformer相比,这些模型可能为基因组数据提供更好的可扩展性。注意力机制的二次复杂度是基因组建模的瓶颈,特别是如果增加上下文窗口大小至关重要的话。这为HyenaDNA、基于Mamba的模型和StripedHyena模型等新一代模型打开了大门,它们可能超越transformer的性能。

目前正在努力提高注意力机制的可扩展性,例如引入滑动窗口、提高效率和改进自然语言处理中的长程交互建模。尽管有这些进步,与使用Hyena层或使用选择性SSM的模型相比,transformer在上下文窗口大小方面仍然落后。未来注意力机制与其他类SSM层的混合为模型设计提供了更多调整的可能性。

随着多组学数据变得更加广泛可用,仅在序列token上训练基因组语言模型的兴趣可能会减弱。能够整合多模态数据的大型模型可以统一基因组、转录组、蛋白质组和表观基因组数据,提供更全面的生物系统视图。如果蛋白质深度学习模型的趋势能够预测基因组序列建模的未来趋势,那么基因组学中的下一个训练范式将是扩散模型。如果使用进化多样性数据的预训练对建模基因组信息很重要,那么扩散模型(其近似方法已广泛应用于进化理论)可能是显而易见的选择。基于DNA的扩散模型已经开始在建模基因组中的调控元件方面显示出前景。

强大且可解释的基因组深度学习模型的未来将用于个性化医疗、理解进化动态、药物发现、合成生物学等领域。作者认为现在是该领域的激动人心的时期,并希望看到多物种预训练的使用增加,以及更多生物学动机和下游任务对齐的预训练任务设计方法。此外,作者希望看到对提出的基因组语言模型的零样本性能给予更大的重视。

与这些原则一致的研究将在基因组建模方面取得最大成功,无论是通过transformer模型、Hyena层、Mamba层还是扩散式训练。此外,作者相信,只有在继续朝着基因组上下文内解释的方向迈进时,深度学习模型才能成功地建模基因组数据。

编译|黄海涛

审稿|王梓旭

参考资料

Consens, M. E., Dufault, C., Wainberg, M., Forster, D., Karimzadeh, M., Goodarzi, H., ... & Wang, B. (2025). Transformers and genome language models. Nature Machine Intelligence, 1-17.