index_new5.html

../../../zaker_core/zaker_tpl_static/wap/tpl_guoji1.html

![]()

谷歌推出了Gemini Live的全新功能,使用户能够通过手机屏幕与AI进行实时交互。用户可以共享屏幕内容或调用摄像头画面,Gemini能够理解屏幕内容、回答问题,并与用户进行互动。这项功能是谷歌“Project Astra”的首次亮相,预示着AI助手在实时、多模态交互方面的发展。通过Gemini,用户可以获得更智能、便捷的AI体验,进一步巩固了谷歌在AI助手领域的领先地位。

📱Gemini Live新增“共享屏幕”功能,用户可让Gemini实时查看手机屏幕内容,进行互动。Gemini可以识别屏幕上的信息,如时间、温度和APP,并根据屏幕内容回答用户问题。

📹Gemini Live还推出了实时视频功能,用户可以通过手机摄像头与Gemini互动,Gemini能实时分析摄像头捕捉到的画面,并回答相关问题。例如,帮助用户选择颜色。

🚀Gemini Live是谷歌“Project Astra”的早期版本,该项目旨在打造一个通用AI助手,能够看见世界、理解事物,并与用户进行实时交互。这项功能预示着2025年AI Agent的发展趋势。

💡Gemini Live功能将作为谷歌One AI高级计划的一部分,逐步向Gemini高级订阅用户推送,进一步提升用户体验。

刚刚,谷歌AI智能体首次上线手机,Gemini看懂屏幕实时交流!

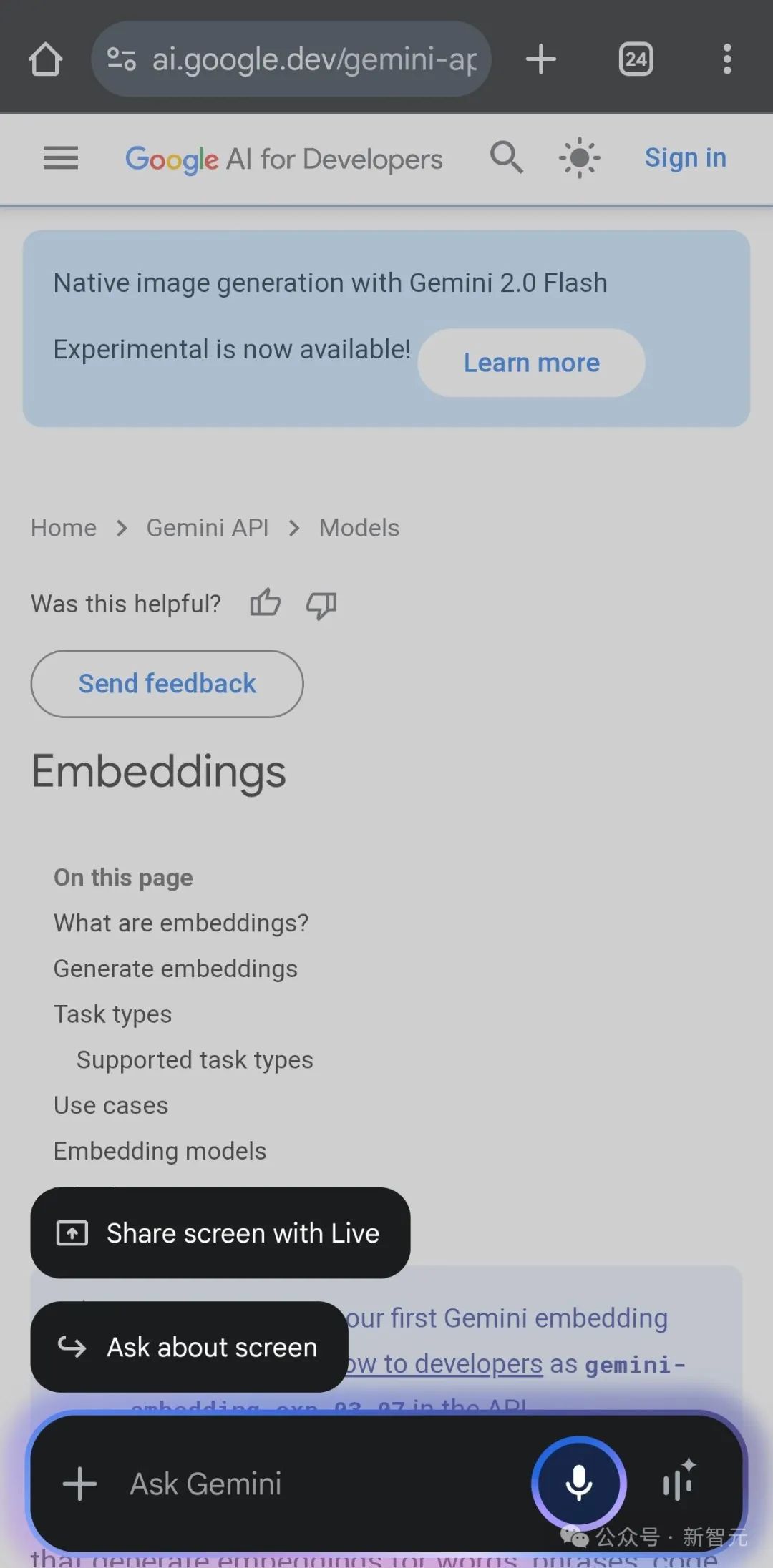

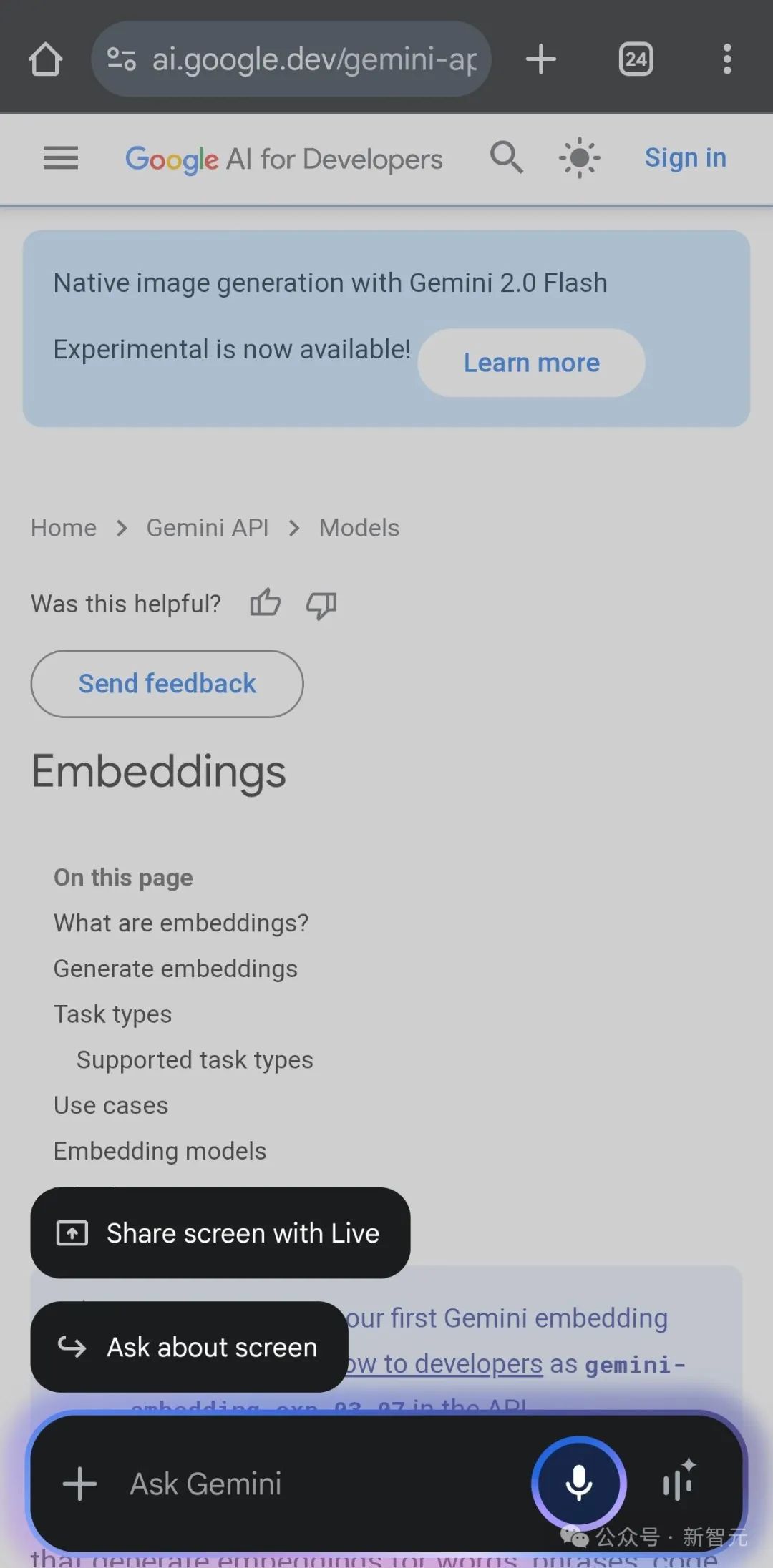

Gemini也许仅仅是在「话题度」稍稍落后ChatGPT,但不要忽视他的技术实力。最近,一位网友在激活了Gemini悬浮窗后,意外发现了一个全新新按钮——「与Live共享屏幕」。而这,正是谷歌为Gemini Live推出的全新「AI实时视频功能」。基于此,用户可以让Gemini实时查看屏幕内容,或者调用手机摄像头画面。

「Gemini,你可以看到我的手机屏幕吗?」

「没问题,我能到看到时间是8点50,温度是71度,日期是3月23日」

「你能通过屏幕内容猜到我的安卓系统是什么吗?」

「嗯,似乎猜起来似乎有些困难,看起来像是定制的系统」

「屏幕上哪个APP和我职业最相关?」

「嗯,似乎是Code Editor」

「你可以帮我播放视频吗?」

「嗯,因为我们正在实时对话,所以无法控制手机,不过我可以和你聊天、进行头脑风暴」

打开完整的Gemini Live界面,开启视频流之后,界面右下角有个按钮,点一下就能切换到前置摄像头,这样就能和周围环境直接互动了。这就像给Gemini装上了眼睛,让它能看世界。

开启这个功能后,Gemini能实时分析手机摄像头捕捉到的画面,然后回答你提出的相关问题。

比如,谷歌本月发布的演示视频里,有人想用颜料给新做好的釉陶上色,拿不定选什么颜色,就可以借助这个功能向Gemini求助。

对此谷歌表示,会在3月下旬「作为谷歌One AI高级计划的一部分,向Gemini高级订阅用户逐步推送」。「Project Astra」谷歌计划已久的AI助手

谷歌DeepMind的负责人、谷歌AI Efforts的领导者 Demis Hassabis在2024年3月谷歌I/O大会上提到。Demis Hassabis展示了一个他希望成为通用助手的非常早期版本,谷歌称其为「Project Astra」。这是一个实时、多模态的人工智能助手,它可以看见世界,知道事物是什么以及你把它们放在哪里,并且可以回答问题或帮助你做几乎所有事情。「Gemini Live共享屏幕」就是「Project Astra」的第一次亮相。同时也是2025 AI Agent之年某种产品「形态」的预告片。当AI「装上眼睛」实时观看现实世界,并且和你以及你的手机互动时。谷歌这次新功能的上线,进一步巩固了它在AI助手领域的领先地位。https://www.theverge.com/news/634480/google-gemini-live-video-screen-sharing-astra-features-rolling-out 内容中包含的图片若涉及版权问题,请及时与我们联系删除