index_new5.html

../../../zaker_core/zaker_tpl_static/wap/tpl_guoji1.html

![]()

DeepSeek开源了DeepEP,一个专为MoE模型训练和推理设计的开源EP通信库。DeepEP通过优化全对全通信,支持节点内和节点间通信,兼容NVLink和RDMA,从而实现训练和推理的高吞吐率和低延迟。该库原生支持FP8数据调度,并提供灵活的GPU资源控制,实现计算与通信的重叠处理,提升MoE模型的效率。DeepEP包含高吞吐量和低延迟两种计算模块,前者适用于训练和推理预填充阶段,后者专为推理解码阶段设计,能最大限度减少响应时间。

🚀 DeepEP是专为专家混合(MoE)和专家并行(EP)设计的通信库,旨在提供高吞吐、低延迟的全对全(all-to-all)GPU计算核,也被称为MoE dispatch 和 MoE combine,从而优化MoE模型的通信效率。

💽 DeepEP支持包括FP8在内的低精度计算操作,并通过软硬件协同优化,使得专家之间的数据传递更快速、更节省资源,显著提升训练和推理效率。

🔗 DeepEP为支持DeepSeek-V3论文中的组限门控算法,专门开发了计算模块,能高效处理不同网络连接之间的数据传输,如GPU之间的NVLink连接和服务器之间的RDMA连接。

⏱️ DeepEP提供两种主要类型的计算模块:高吞吐量模块,适用于训练和推理预填充阶段,可灵活调整GPU资源;低延迟模块,专为推理解码阶段设计,基于RDMA技术,最大限度减少响应时间。

上周五,DeepSeek 发推说本周将是开源周(OpenSourceWeek),并将连续开源五个软件库。就在刚刚,DeepSeek 第二天的开源项目 DeepEP 正式发布。DeepSeek 官方在 X 平台发文称:「很高兴向大家介绍 DeepEP——首个专为 MoE(专家混合)模型训练和推理打造的开源 EP 通信库。

✅ 高效优化的全对全(all-to-all)通信

✅ 支持节点内(intranode)和节点间(internode)通信,兼容 NVLink 和 RDMA✅ 训练与推理预填充(prefilling)阶段的高吞吐率计算核✅ 推理解码(decoding)阶段的低延迟计算核✅ 原生支持 FP8 数据调度✅ 灵活的 GPU 资源控制,实现计算与通信的重叠处理」

此外,该库还支持包括 FP8 在内的低精度计算操作。说人话就是,DeepEP 是 MoE 模型的「通信管家」,通过软硬件协同优化,让专家之间的数据传递又快又省资源,大幅提升训练和推理效率。另外,DeepEP 为支持 DeepSeek-V3 论文中的组限门控(group-limited gating) 算法,开发了专门的计算模块,这些模块能够高效处理不同网络连接之间的数据传输,比如从 GPU 之间的 NVLink 连接传输到服务器之间的 RDMA 连接。DeepEP 提供了两种主要类型的计算模块。一种是高吞吐量模块,它们在训练和推理预填充阶段表现出色,并且可以灵活调整 GPU 处理器资源;另一种是专为推理解码阶段设计的低延迟模块,完全基于 RDMA 技术,能够最大限度减少响应时间。

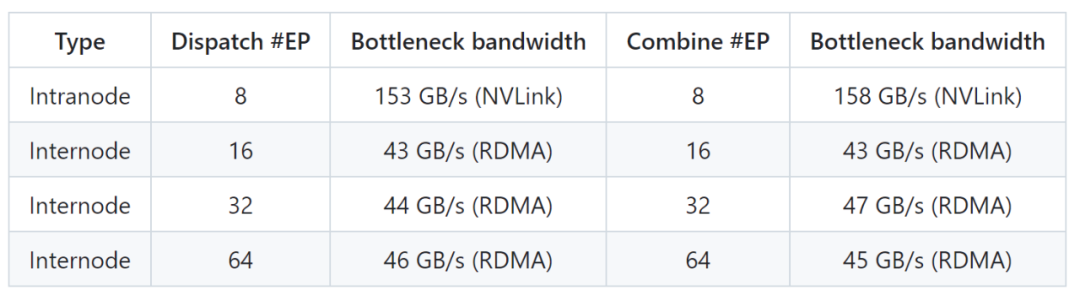

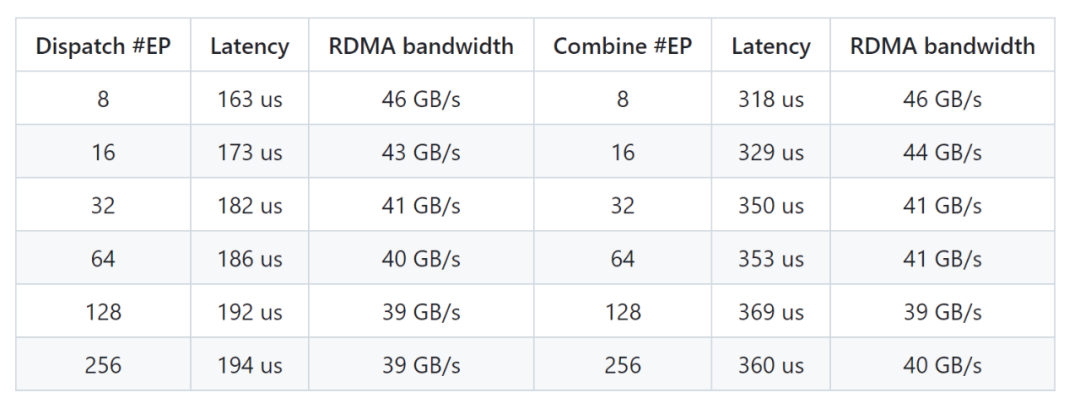

具有 NVLink 和 RDMA forwarding 的常规模块DeepSeek 在 H800 上测试常规内核(NVLink 最大带宽约 160 GB/s),每个 H800 连接到一个 CX7 InfiniBand 400 Gb/s RDMA 网卡(最大带宽约 50 GB/s)。他们遵循 DeepSeek-V3/R1 预训练设置(每批次 4096 个 token,7168 隐藏维度,top-4 组,top-8 专家,FP8 分发和 BF16 合并)。DeepSeek 在 H800 上测试低延迟模块,每个 H800 连接到一个 CX7 InfiniBand 400 Gb/s RDMA 网卡(最大带宽约 50 GB/s)。他们遵循典型的 DeepSeek-V3/R1 生产设置(每批次 128 个 token,7168 隐藏维度,top-8 专家,FP8 分发和 BF16 合并)。项目地址:https://github.com/deepseek-ai/DeepEP

一起“点赞”三连↓

一起“点赞”三连↓

内容中包含的图片若涉及版权问题,请及时与我们联系删除

一起“点赞”三连↓

一起“点赞”三连↓