index_new5.html

../../../zaker_core/zaker_tpl_static/wap/tpl_guoji1.html

![]()

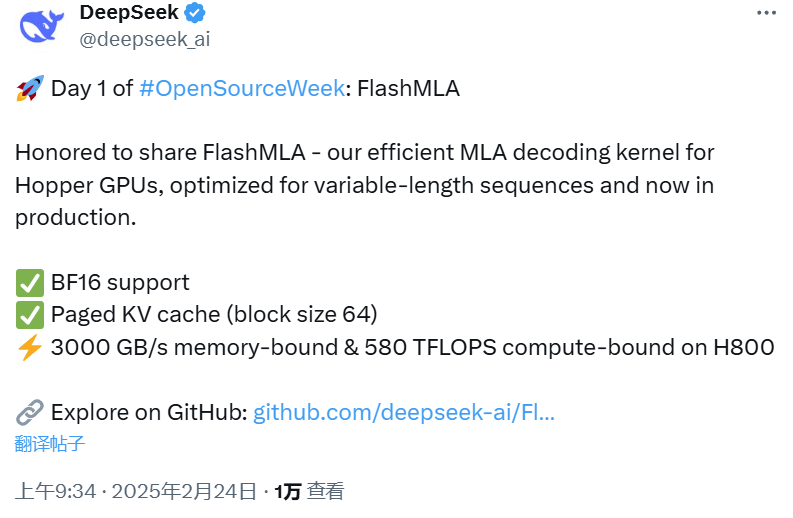

DeepSeek开源了FlashMLA,一款专为Hopper GPU设计的高效MLA解码内核,旨在优化可变长度序列服务。该项目一经发布便迅速获得大量关注,其核心优势在于极高的速度,在H800 SXM5 GPU上实现了高达3000 GB/s的内存速度上限和580 TFLOPS的计算上限。FlashMLA的开源展示了DeepSeek在降低大模型推理成本方面的诚意,通过减少推理过程中的KV Cache,实现在更少设备上推理更长的Context。该项目需要CUDA 12.3及以上版本和PyTorch 2.0及以上版本支持。

🚀 FlashMLA是DeepSeek开源的适用于Hopper GPU的高效MLA解码内核,专注于优化可变长度序列服务,旨在提升大模型推理效率。

💻 该内核在H800 SXM5 GPU上表现出色,实现了高达3000 GB/s的内存速度上限和580 TFLOPS的计算上限,显著提升了解码速度。

🛠️ 部署FlashMLA需要Hopper GPU、CUDA 12.3及以上版本以及PyTorch 2.0及以上版本,并通过简单的命令即可完成安装和测试。

👍 开源FlashMLA是DeepSeek在降低大模型推理成本方面的重要举措,通过技术创新减少KV Cache,从而在更少的设备上支持更长的Context推理。

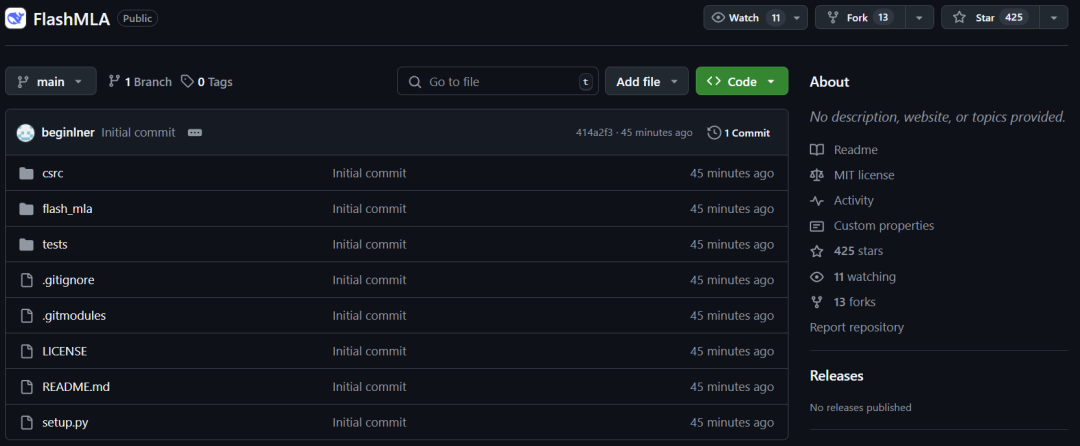

上周五,DeepSeek 发推说本周将是开源周(OpenSourceWeek),并将连续开源五个软件库。北京时间周一上午 9 点,刚一上班(同时是硅谷即将下班的时候),DeepSeek 兑现了自己的诺言,开源了一款用于 Hopper GPU 的高效型 MLA 解码核:FlashMLA。该项目上线才 45 分钟就已经收获了超过 400 star!并且在我们截图时,Star 数量正在疯狂飙升。项目地址:https://github.com/deepseek-ai/FlashMLA众所周知,MLA是DeepSeek大模型的重要技术创新点,主要就是减少推理过程的KV Cache,从而实现在更少的设备上推理更长的Context,极大地降低推理成本。此次 DeepSeek 直接开源了该核心技术的改进版本,可以说是诚意满满。据介绍,FlashMLA 是适用于 Hopper GPU 的高效 MLA 解码内核,针对可变长度序列服务进行了优化。其速度非常快,在 H800 SXM5 GPU 上具有 3000 GB/s 的内存速度上限以及 580 TFLOPS 的计算上限。python tests/test_flash_mla.py

使用 CUDA 12.6,在 H800 SXM5 上,在内存绑定配置下实现高达 3000 GB/s,在计算绑定配置下实现 580 TFLOPS。from flash_mla import get_mla_metadata, flash_mla_with_kvcache

tile_scheduler_metadata, num_splits = get_mla_metadata (cache_seqlens, s_q * h_q

for i in range (num_layers):...o_i, lse_i = flash_mla_with_kvcache (q_i, kvcache_i, block_table, cache_seqlens, dv,tile_scheduler_metadata, num_splits, causal=True,)...

甚至有网友打趣地表示:「听说第五天会是 AGI」。 一起“点赞”三连↓

一起“点赞”三连↓

内容中包含的图片若涉及版权问题,请及时与我们联系删除

一起“点赞”三连↓

一起“点赞”三连↓