引言:传统变分推断的瓶颈

在机器学习中,变分推断(VI)是近似复杂后验分布的经典方法,但其核心依赖的KLD正则化器存在天然缺陷——它倾向于高熵分布,导致后验分布“雨露均沾”,无法聚焦关键成分。这种特性在面对噪声数据或需要稀疏解的任务时,往往力不从心。

突破:Fenchel-Young变分学习

一篇最新论文提出Fenchel-Young变分学习(FYVL),通过替换KLD为更灵活的Fenchel-Young损失,引入Tsallis熵等正则化器,赋予模型“断舍离”的能力——自动过滤噪声,专注关键成分。

Fenchel-Young Variational Learning

https://arxiv.org/abs/2502.10295

论文核心贡献

传统变分推断(Variational Inference, VI)依赖于Kullback-Leibler散度(KLD)作为后验分布与先验分布之间的正则化器。然而,KLD隐含的高熵偏好限制了模型对稀疏后验的支持能力。为此,论文《Fenchel-Young变分学习》提出了一种新框架——Fenchel-Young变分学习(FYVL),通过引入Fenchel-Young损失替代KLD,支持更灵活的正则化器(如Tsallis熵),从而生成稀疏后验分布,并显著提升模型性能。

核心优势

稀疏后验:通过α-entmax(如sparsemax),模型在聚类任务中仅保留最相关的组件,提升抗噪能力。

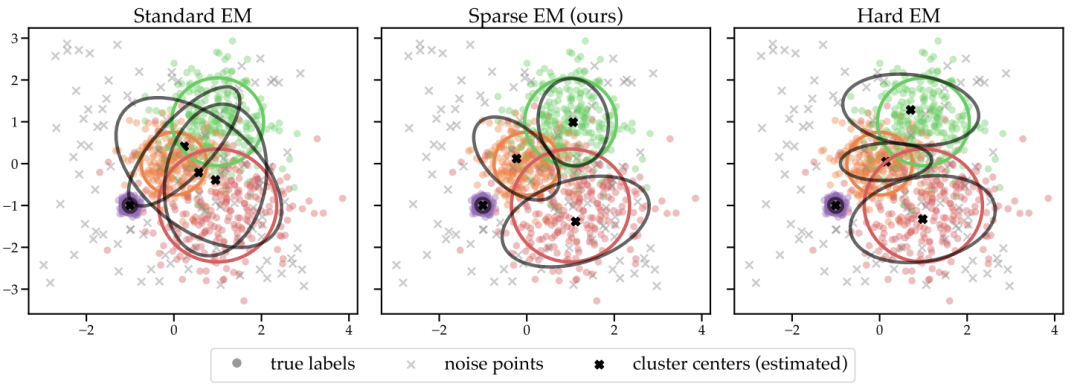

基于 GMM 的聚类的 EM 的标准、稀疏和硬版本比较。数据点按其真实标签着色,x 标记表示异常值(未标记)。黑色椭圆表示估计的聚类(GMM 组件的水平曲线),而彩色椭圆表示真实聚类。

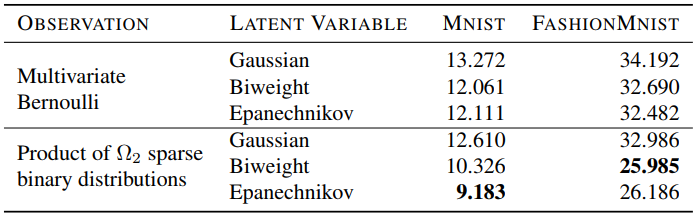

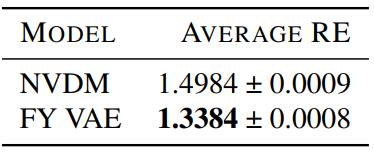

高效生成:在VAE中,稀疏解码器(如2-entmax)直接忽略无关像素或词汇,生成图像更清晰,文档重构误差更低。

MNIST 和 FashionMNIST 数据集上的 VAE ℓ1 重建误差。

关键创新点

1. 广义变分框架

FYVL的核心是将传统VI中的KLD替换为Fenchel-Young损失,允许使用不同熵函数(如Tsallis熵)作为正则化器。例如,Tsallis熵(参数为α)在α>1时能够生成稀疏后验,使得模型在聚类、生成任务中更聚焦关键成分,减少噪声干扰。

2. FYEM算法:自适应稀疏的EM变体

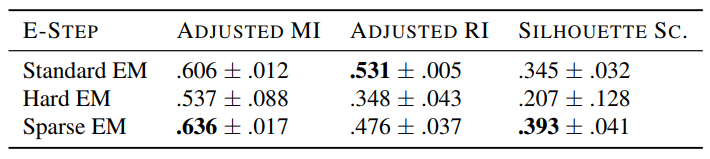

传统EM算法的E步通过softmax分配样本到所有组件,而FYEM的E步采用α-entmax(如sparsemax),支持硬分配(α→∞)或稀疏分配(α>1)。实验显示,在重叠严重的高斯混合模型(GMM)中,稀疏EM的聚类质量(调整互信息、轮廓系数)显著优于标准EM和硬EM。

使用标准、硬和稀疏(我们的)EM 版本进行基于 GMM 的聚类的聚类质量指标(越高越好);稀疏 EM 中的 α = 2。这些值是 5 个随机种子的平均值。

3. FY变分自编码器(FYVAE)

将FYVL应用于VAE,结合稀疏观测模型(如α-entmax解码器)和有限支撑的隐变量分布(如ξ-高斯分布),FYVAE在MNIST和文档数据上的重构误差低于传统VAE。例如,在文档模型中,稀疏解码器直接建模词汇的零概率,使重构误差降低10.68%。

每个模型的 5 个种子的平均重建误差按测试集中的示例数量 (6505) 进行归一化。

实验结果亮点

- 高斯混合模型(GMM):在含噪声的合成数据集中,稀疏EM的聚类质量显著优于传统方法(见表1)。其秘密在于α-entmax的E步:每个样本仅影响少数组件,避免“平均主义”导致的模糊边界。稀疏EM在重叠数据集中更鲁棒,尤其适合含噪声或离群点的场景(见图1)。

- 变分自编码器(VAE)——图像生成:FYVAE的稀疏解码器(如2-entmax)生成图像更清晰(见图3)。

- 变分自编码器(VAE)——文档建模:结合高斯隐变量和稀疏观测的FYVAE,主题一致性得分更高(见图2)。

未来研究方向建议:AI的“极简主义”

FYVL的稀疏特性为AI模型提供了“做减法”的新思路。未来,这一框架可扩展至多模态生成、自适应稀疏控制等领域,推动模型从“大而全”迈向“少而精”。

1. 多模态与跨域应用

当前FYVL主要针对单模态数据,可探索其在多模态生成(如图文联合生成)或跨域迁移任务中的潜力,利用稀疏性实现高效特征对齐。

2. 动态稀疏性控制

现有α参数需手动设定,未来可设计自适应机制,根据数据分布动态调整α,实现更智能的稀疏分配。

3. 复杂隐变量结构

当前隐变量多为高斯分布,可结合图结构(如层次化隐变量)或扩散模型,探索FYVL在更复杂生成任务中的应用。

4. 理论分析扩展

论文侧重实证,未来可深入分析FYVL的收敛性、稀疏后验的泛化误差界,以及不同熵函数对模型鲁棒性的影响。

结语

FYVL不仅是一次技术革新,更是一种方法论启示——在数据爆炸的时代,学会“舍弃”冗余,才能更高效地捕捉本质。或许,这正是AI迈向更高智能的必经之路。

内容中包含的图片若涉及版权问题,请及时与我们联系删除