index_new5.html

../../../zaker_core/zaker_tpl_static/wap/tpl_guoji1.html

![]()

本文介绍了如何在Mac电脑上本地部署DeepSeek的详细教程。首先,需要下载并安装Ollama,然后在终端输入命令验证安装是否成功。接着,从Ollama官网找到并下载DeepSeek-R1模型,考虑到Mac存储空间限制,推荐下载1.5b或7b版本。下载完成后,可以使用Chatbox AI这款可视化工具进行搭建,选择Ollama API,并选择已下载的DeepSeek-R1模型。完成以上步骤后,即可在本地进行对话,所有对话均在本地完成,回复迅速。本教程旨在帮助用户在Mac上轻松部署DeepSeek,实现高效的本地AI应用。

✅Ollama的安装与验证: 首先需要在Mac上下载并安装Ollama,安装完成后,通过在终端输入[ollama]命令来验证是否安装成功,这是本地部署DeepSeek的基础。

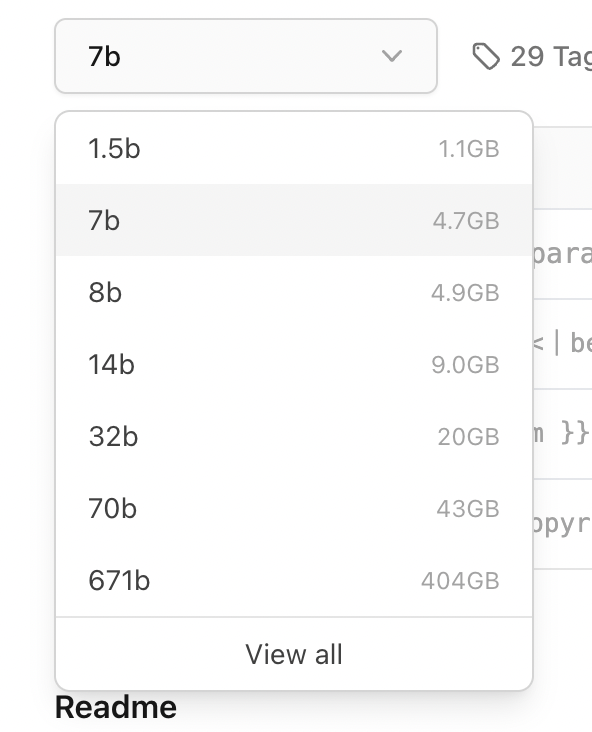

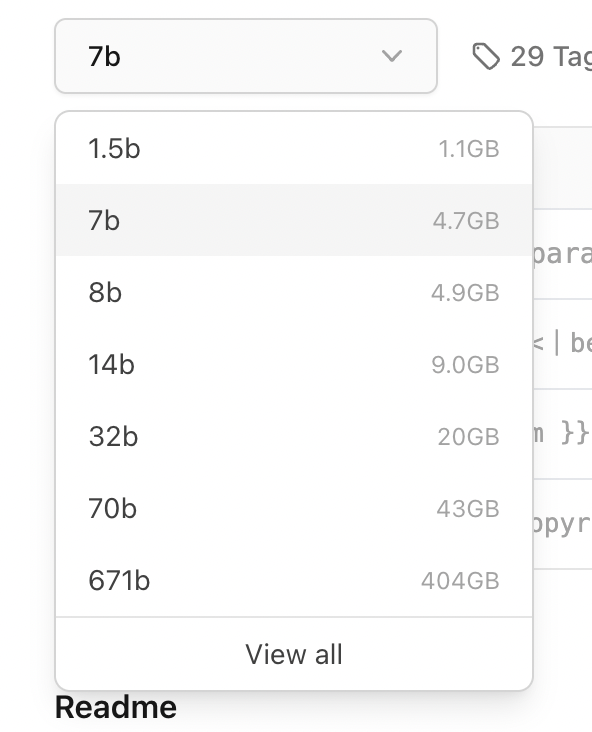

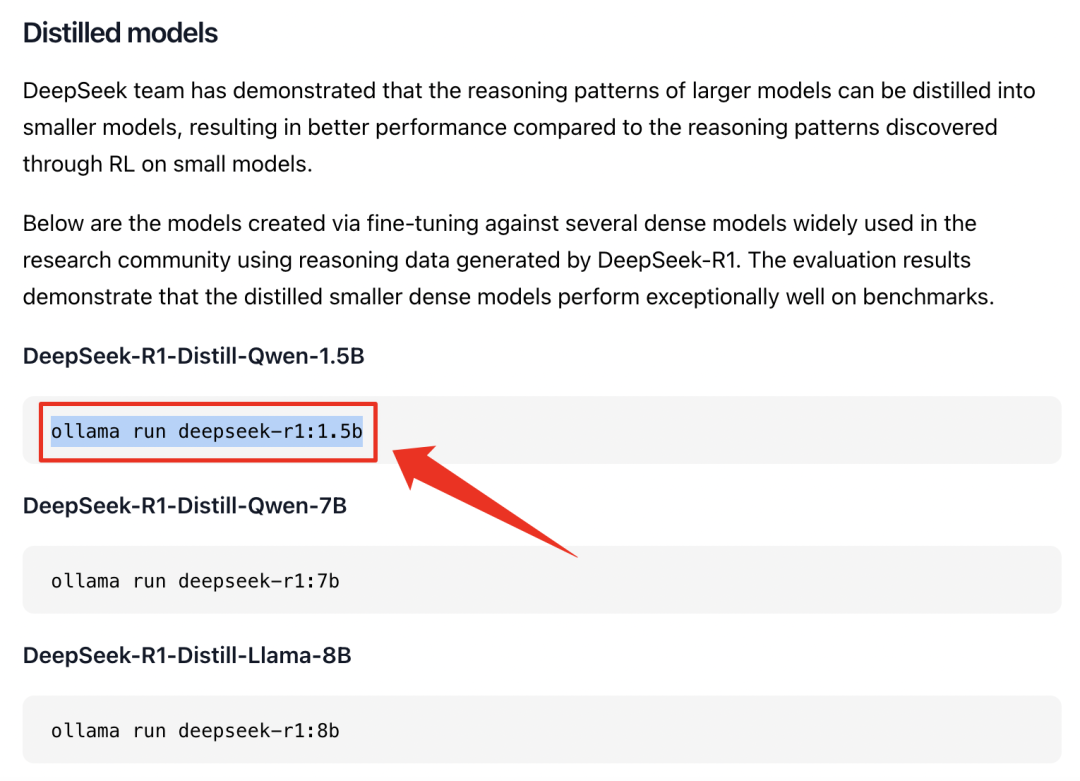

💾DeepSeek模型的选择与下载: 根据Mac的存储空间和算力情况,建议选择合适的DeepSeek-R1模型版本,如1.5b或7b。通过Ollama官网找到模型并复制下载代码到终端进行下载,完整R1模型需要404GB空间,请注意预留。

💬Chatbox AI可视化工具的搭建与使用: 通过Chatbox AI官网下载可视化工具,选择Ollama API,并在设置页面选择已下载的DeepSeek-R1模型,即可在聊天框内进行对话,实现本地AI应用。

# 如何使用DeepSeek?

有很多小伙伴留言想要 Mac 版本的教程,今天 Mac 本地可视化部署教程来了!

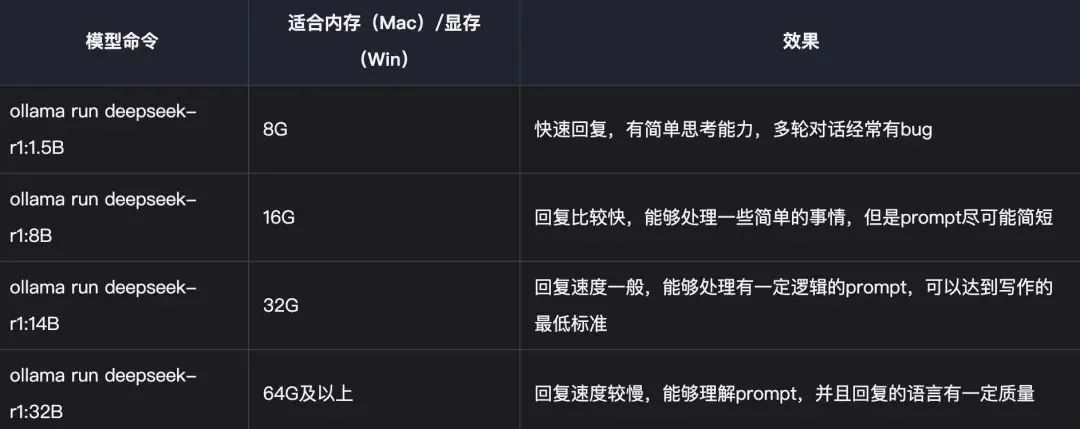

# DeepSeek内存/显存对照表

# 在Mac电脑上部署DeepSeek教程

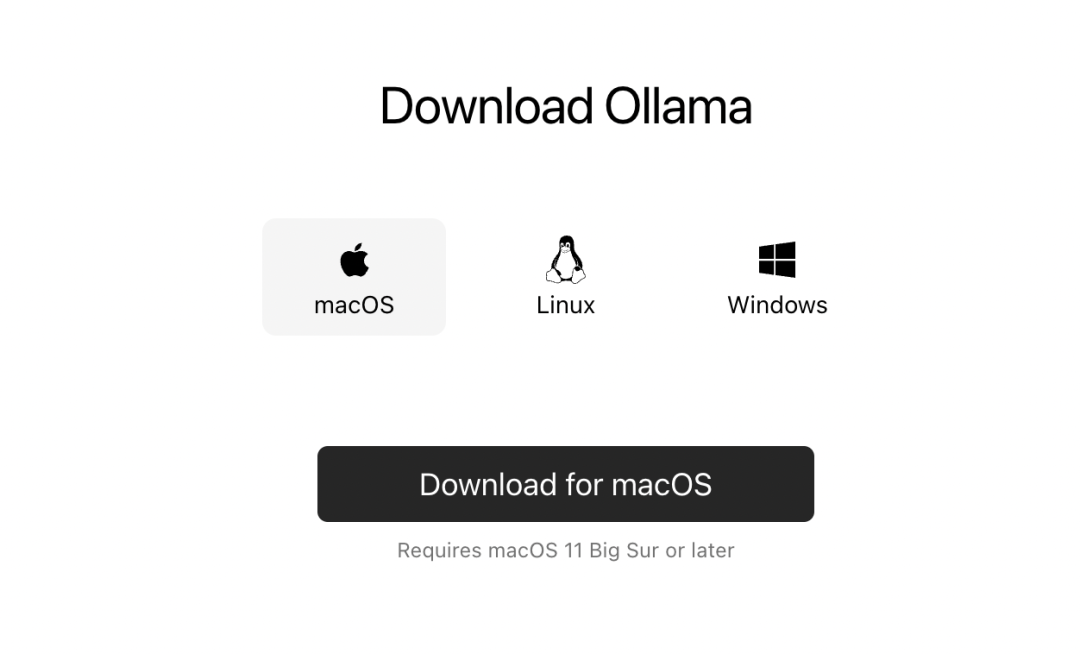

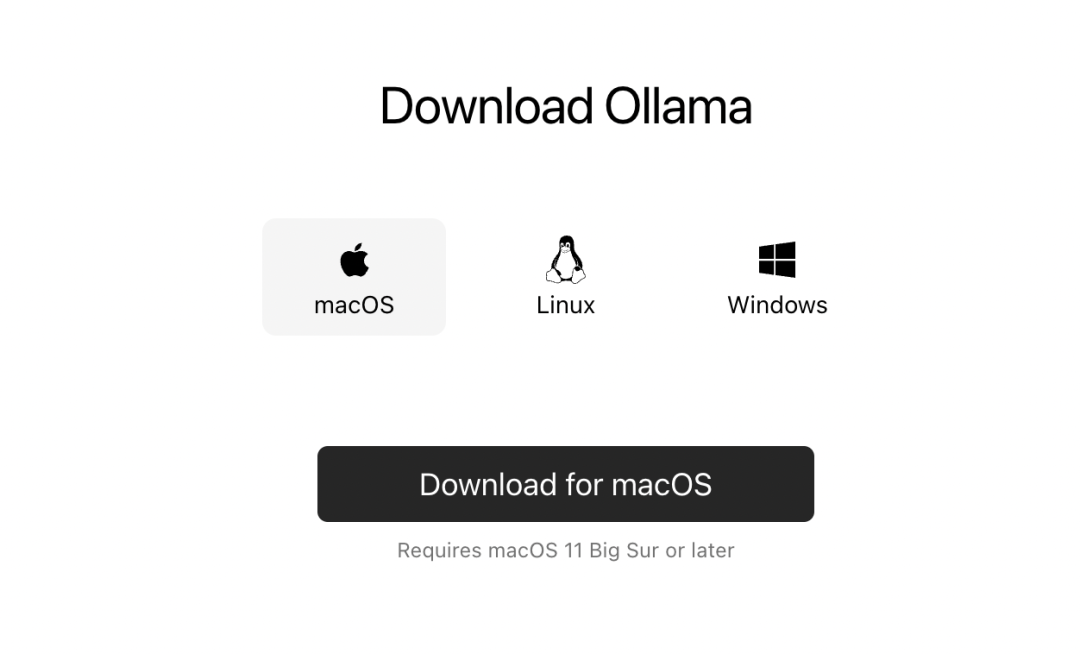

1. 首先下载Ollama,点击 [Download for macOS];官网链接:https://ollama.com/download

网盘链接:https://pan.quark.cn/s/a4fba00e300b

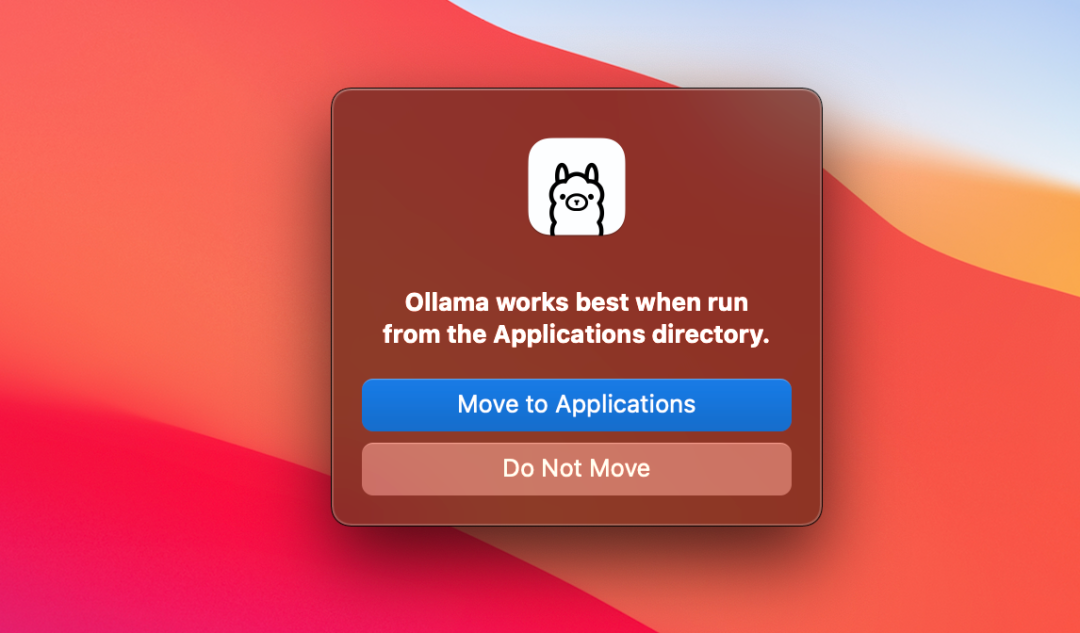

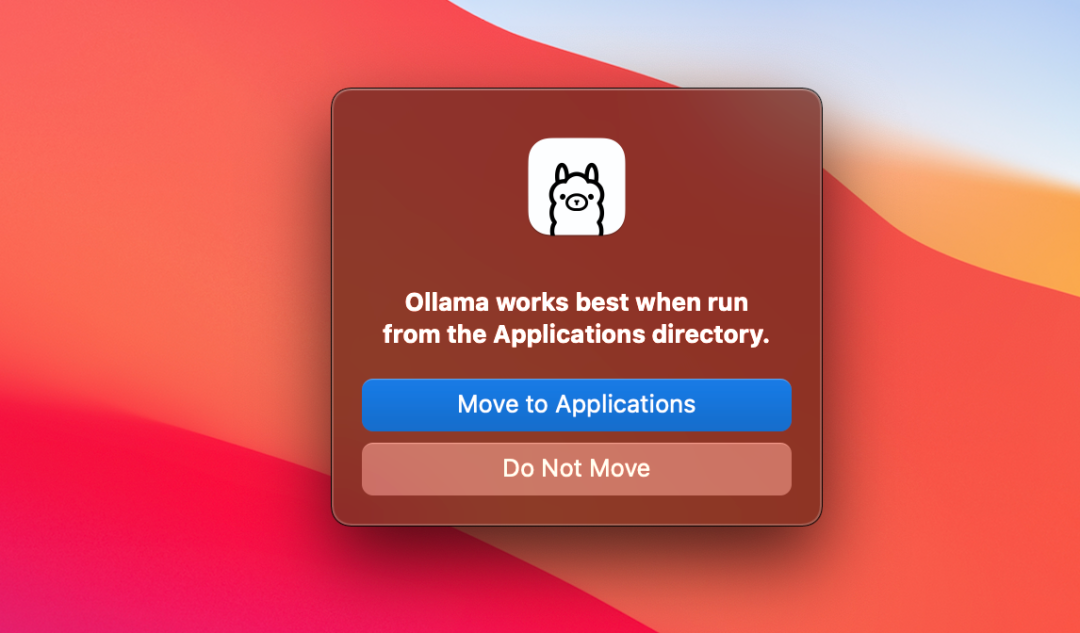

2. 下载后的直接打开需要移动到应用程序内;

3. 点击 [Next];

4. 点击 [Install];

5. Ollama安装完成,点击 [Finish];

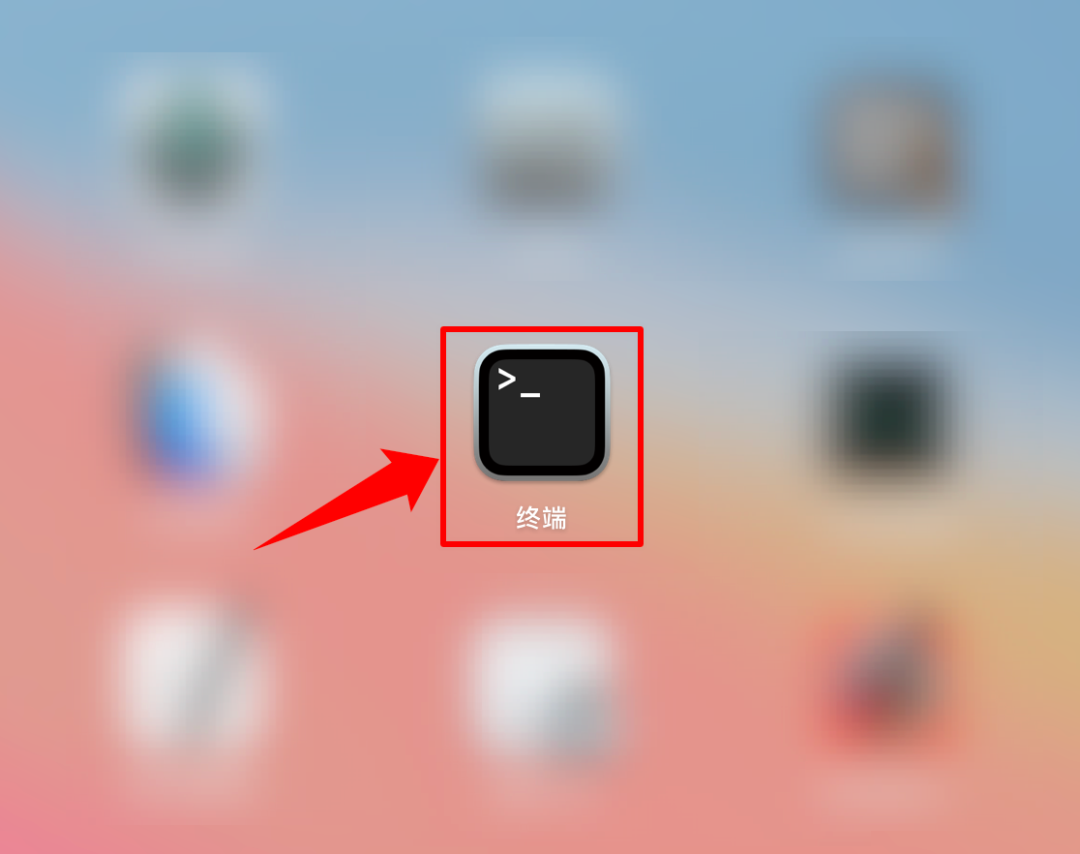

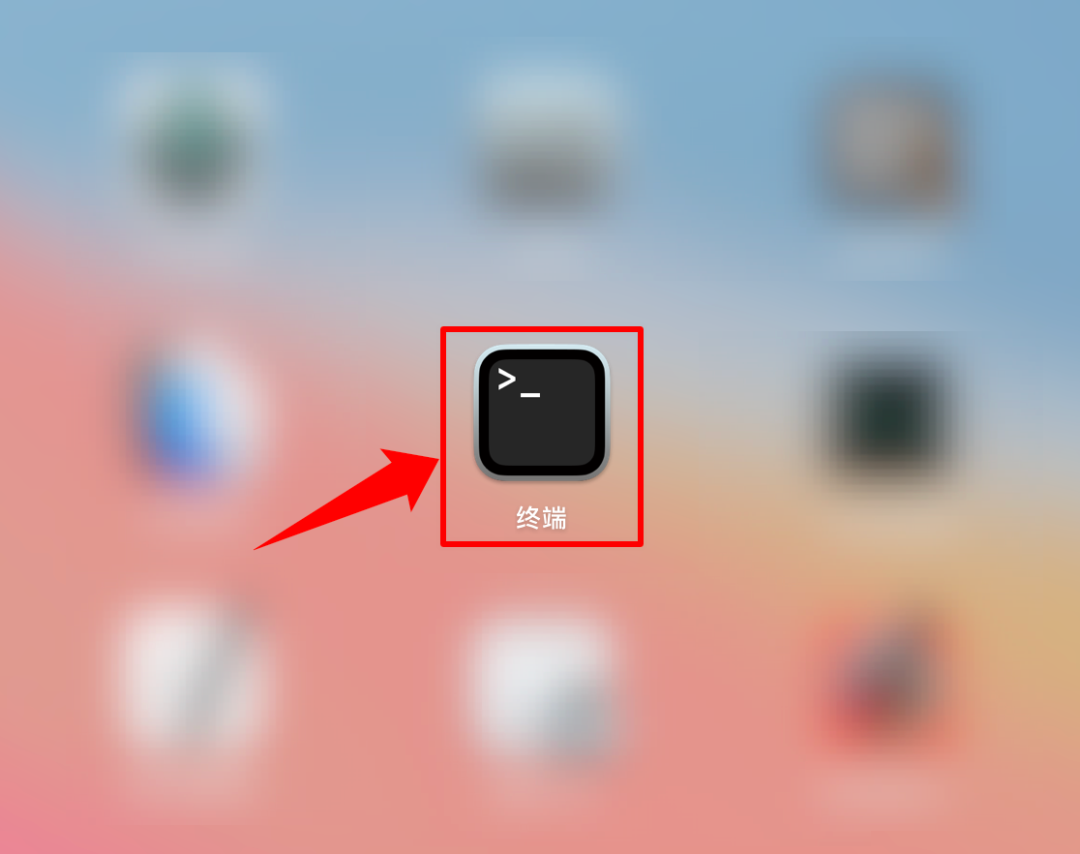

6. 在启动台内打开 [实用工具];

7. 打开终端;

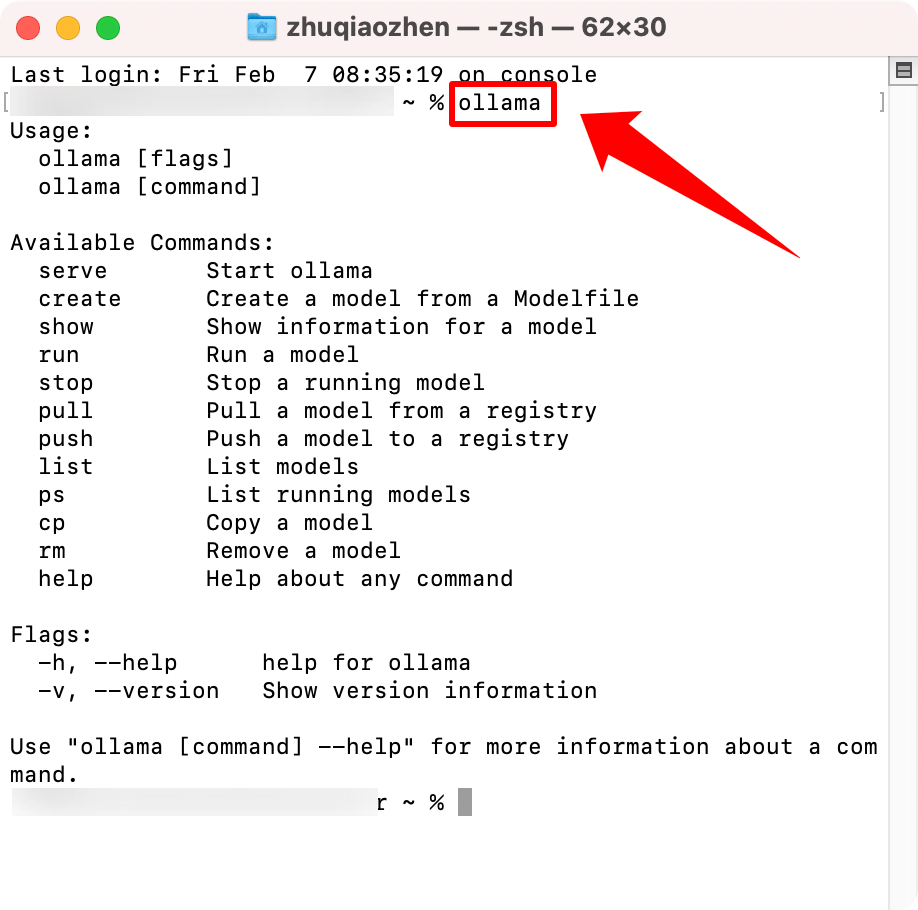

8. 在终端输入 [ollama],然后回车显示如图就表示 [ollama] 已经安装好了;

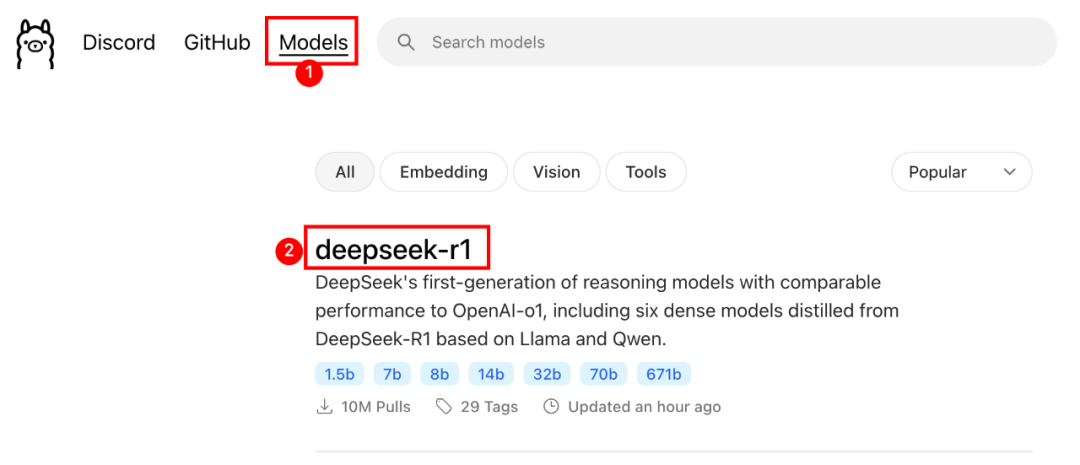

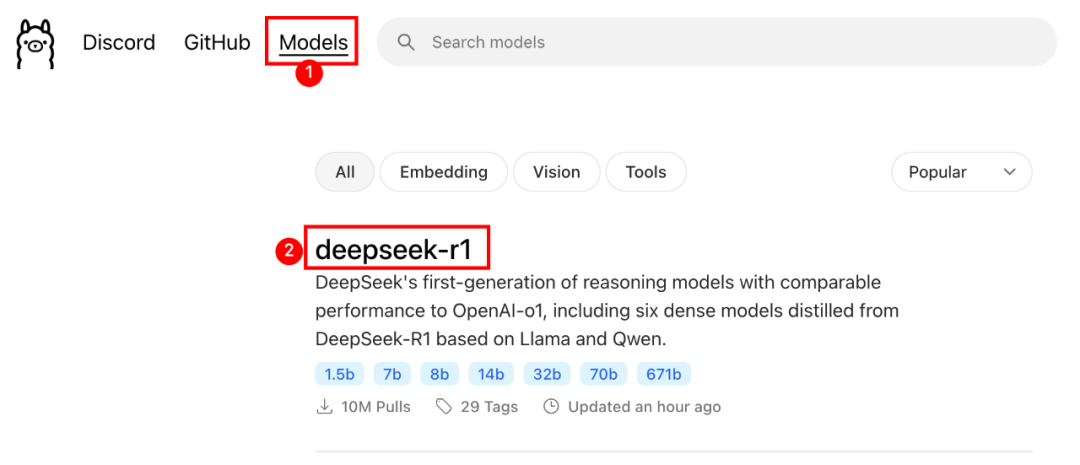

9. 打开Ollama官网,点击 [Models] ,找到deepseek-r1模型;

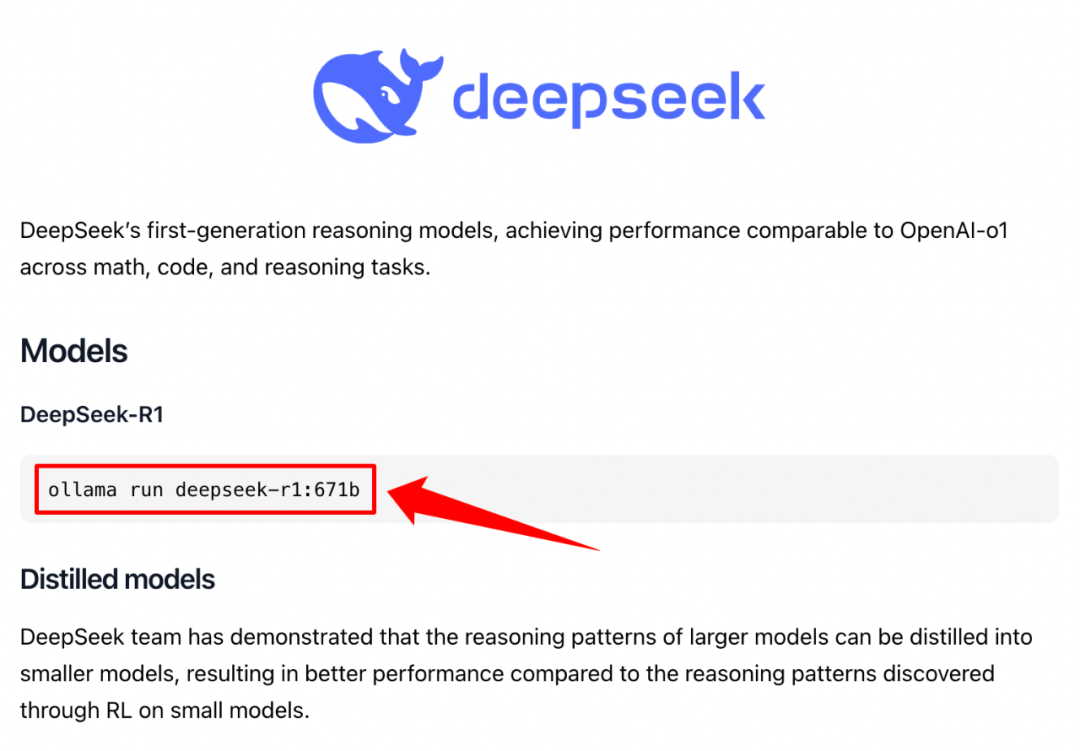

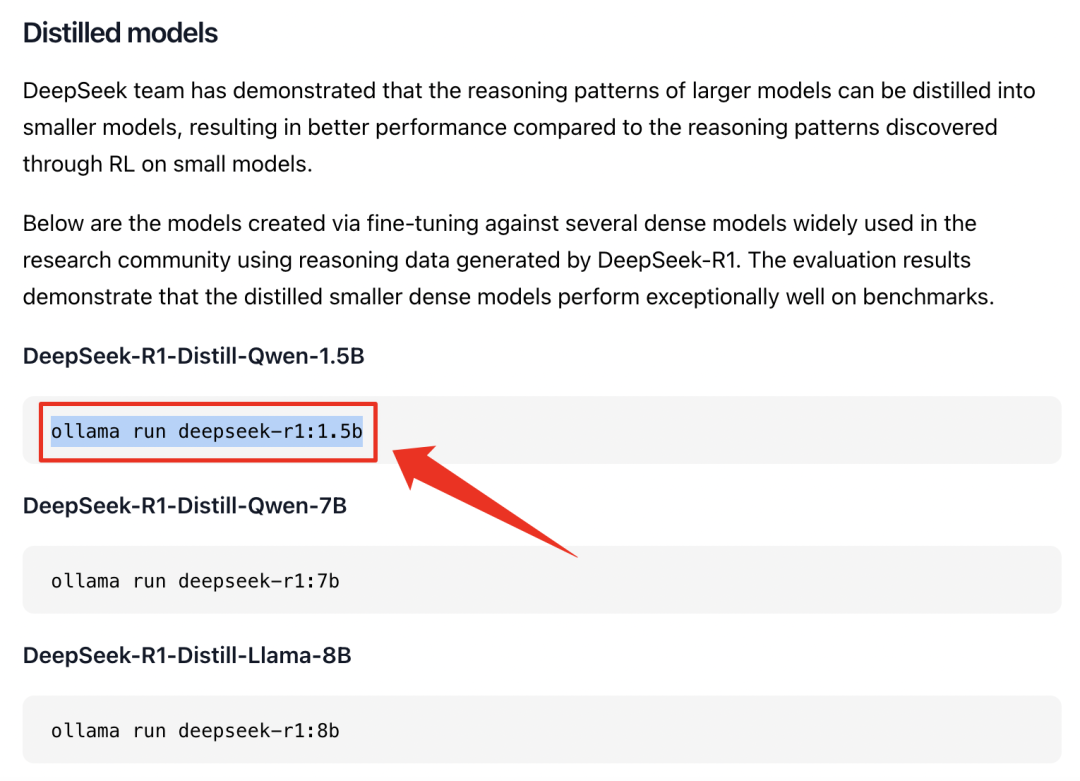

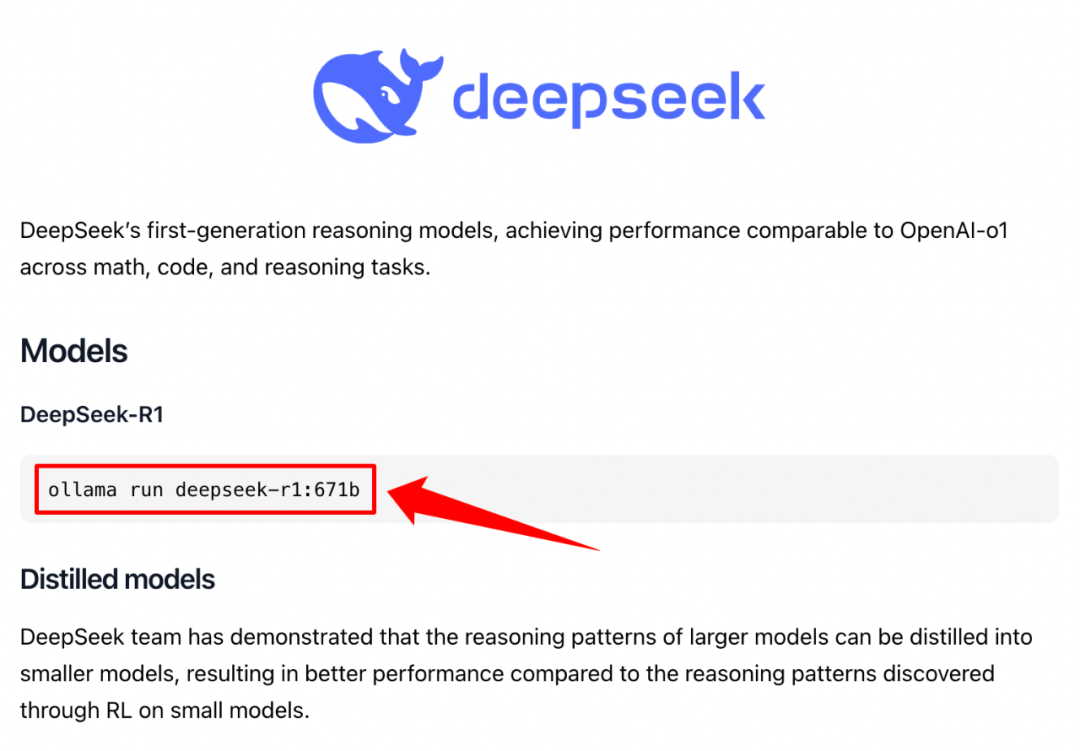

10. 复制DeepSeek-R1下载代码;

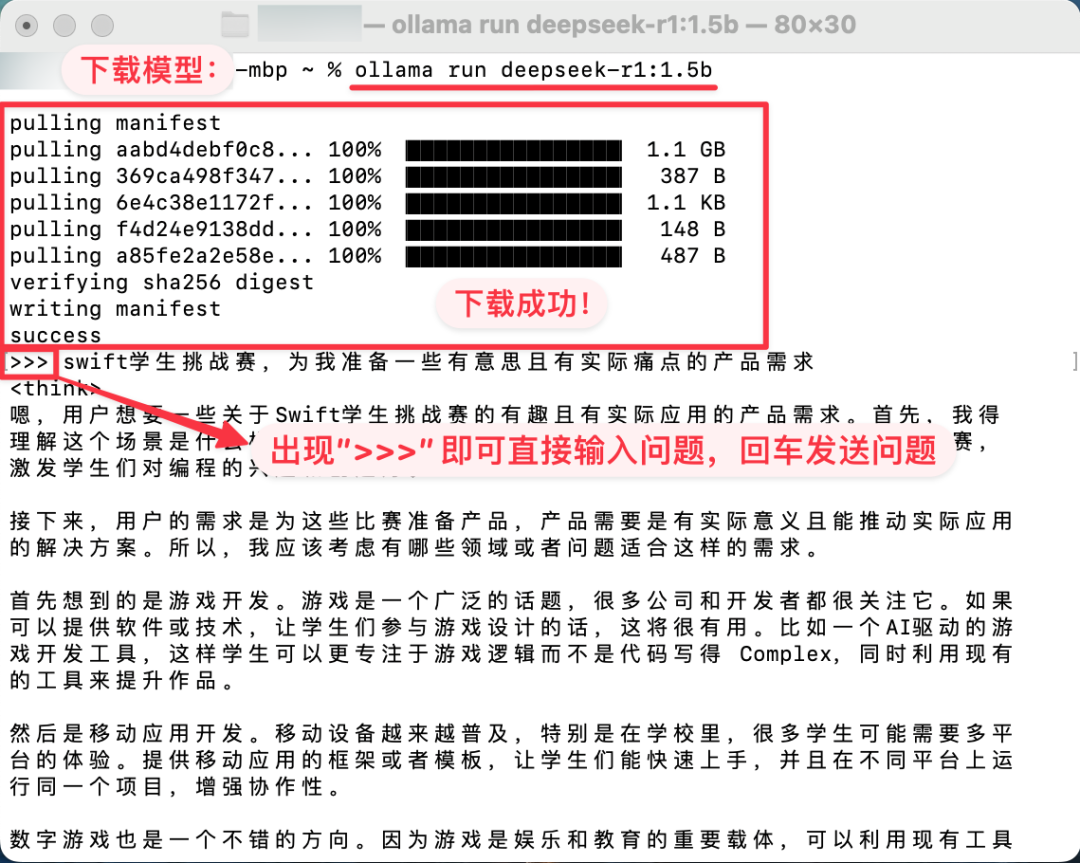

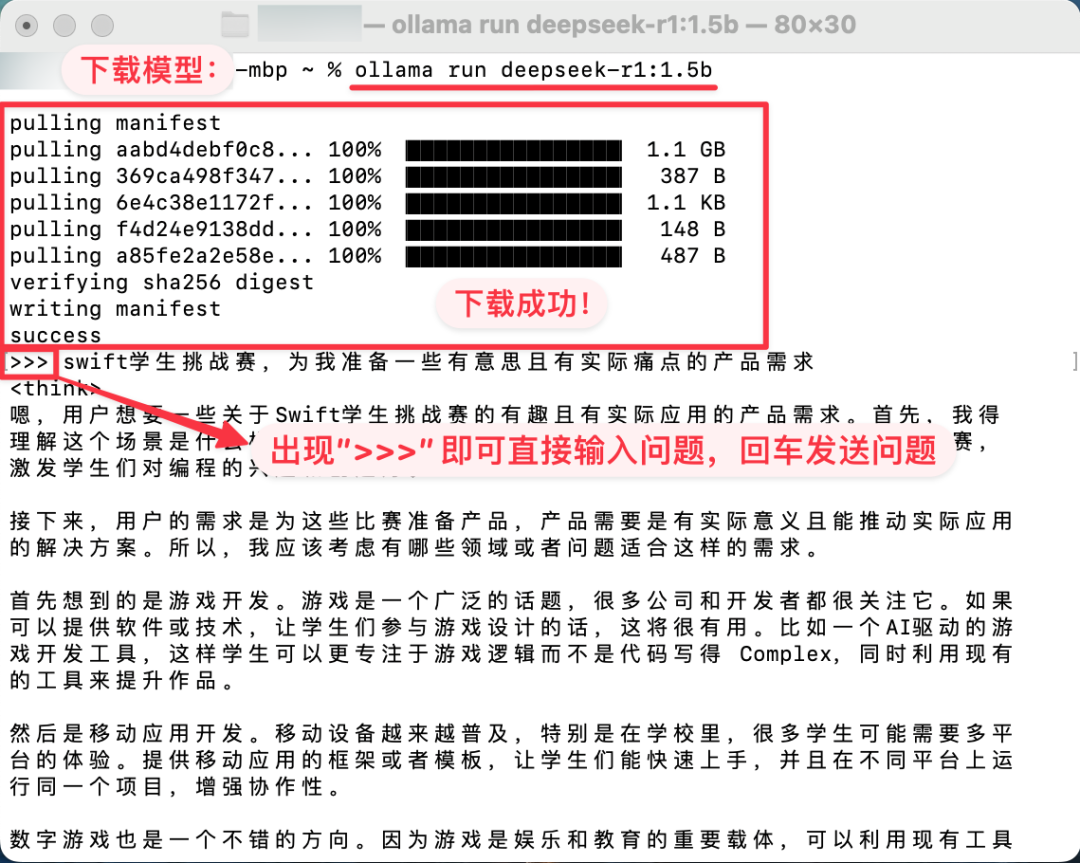

11. 注意完整的R1模型要占用404GB空间并需要强大算力,标准版M芯片推荐32b内,如果Mac存储空间焦虑,推荐下载1.5b或者7b;

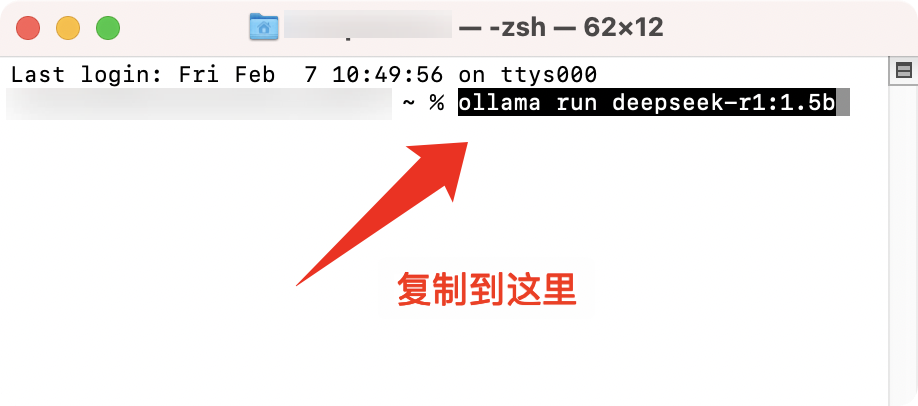

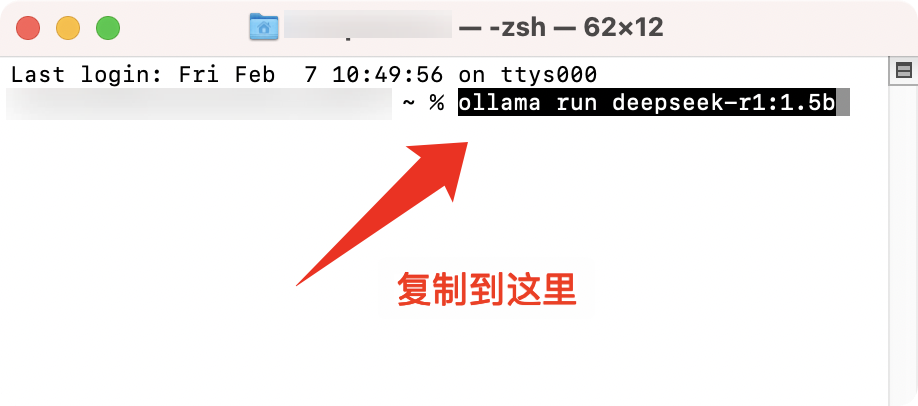

12. 将复制的下载代码复制到终端内,如图所示,然后回车;

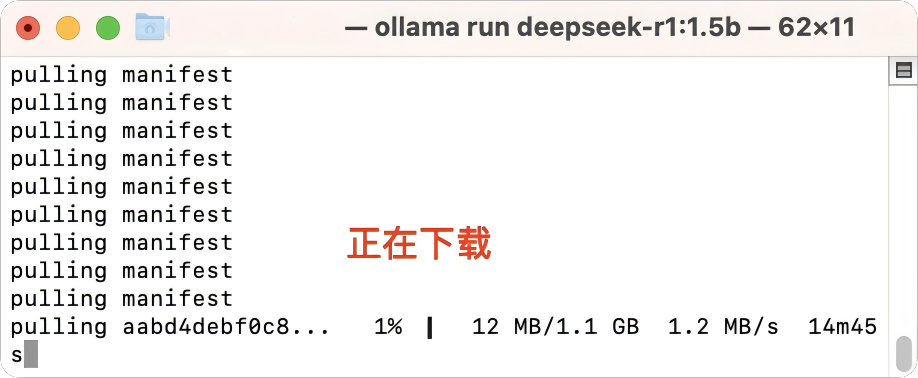

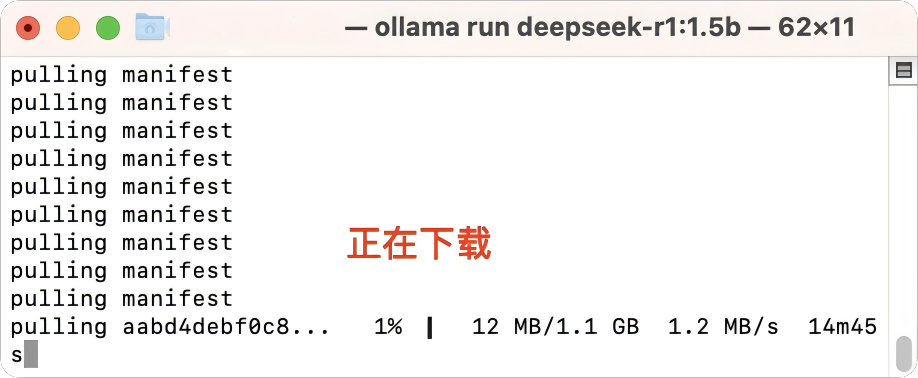

13. 回车后静静等待下载完成即可;

14. 下载完成后即可在>>>后输入问题,回车即可发送问题。

# 可视化搭建

1. 打开Chatbox AI官网进行下载可视化工具;官网链接:https://chatboxai.app/zh

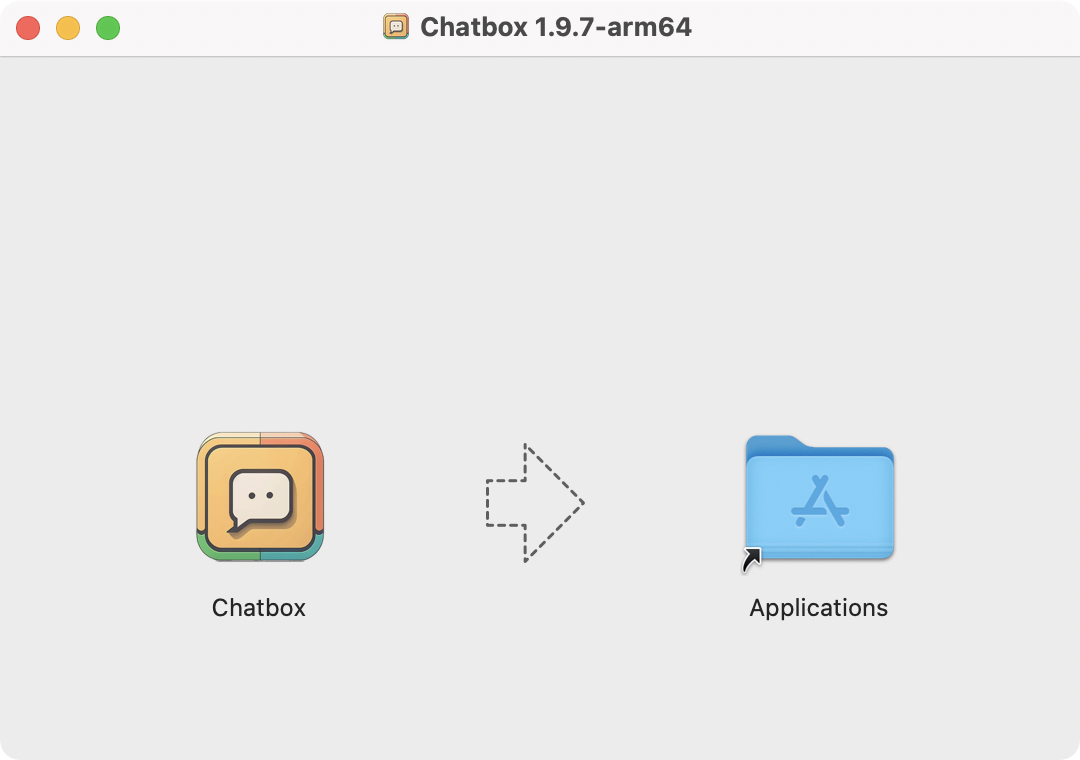

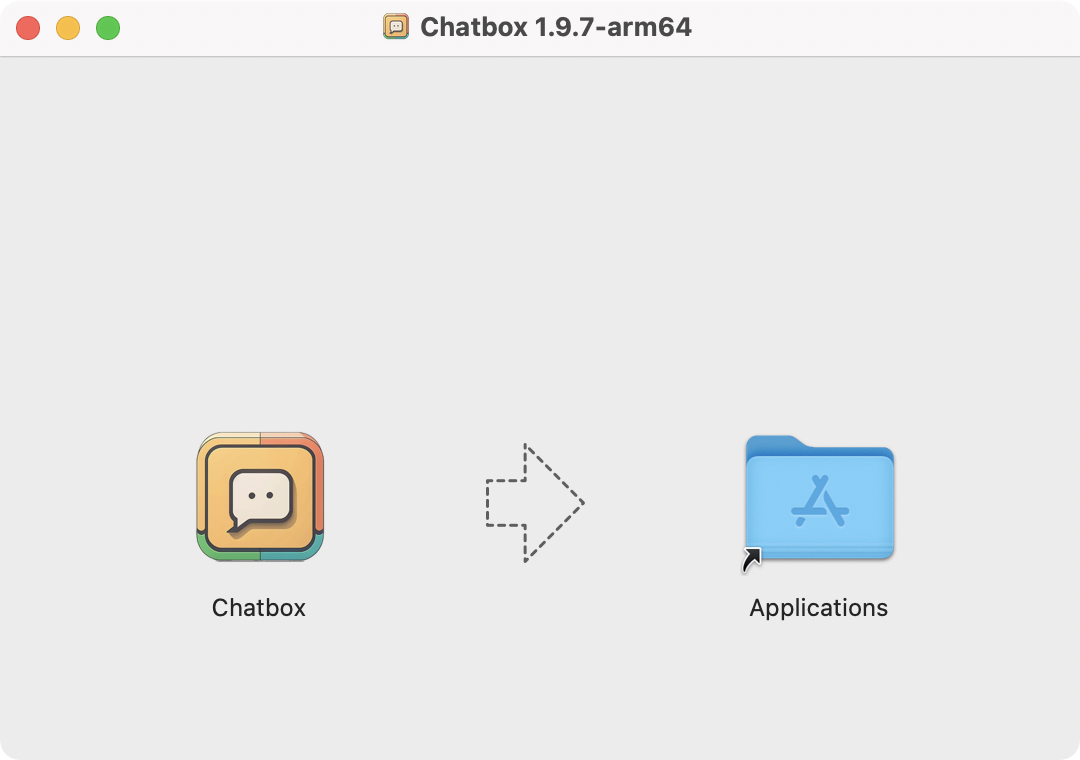

2. 下载后,将Chatbox 拖进应用程序内;

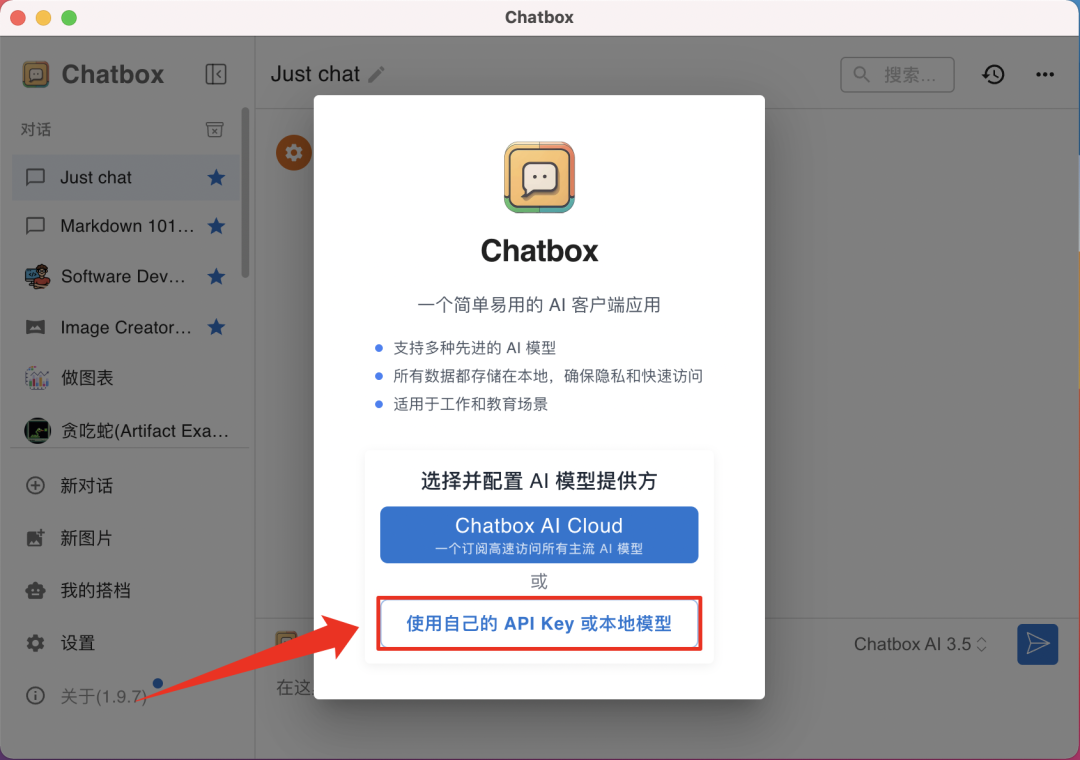

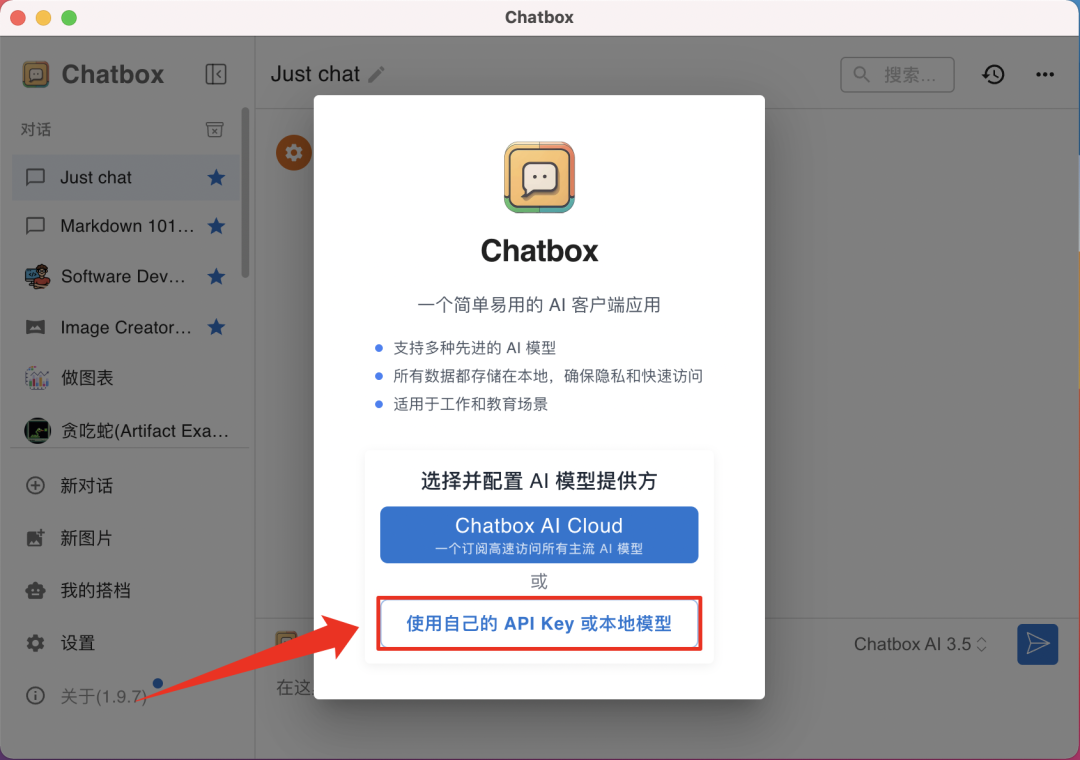

3. 选择 [使用自己的API Key 或本地模型];

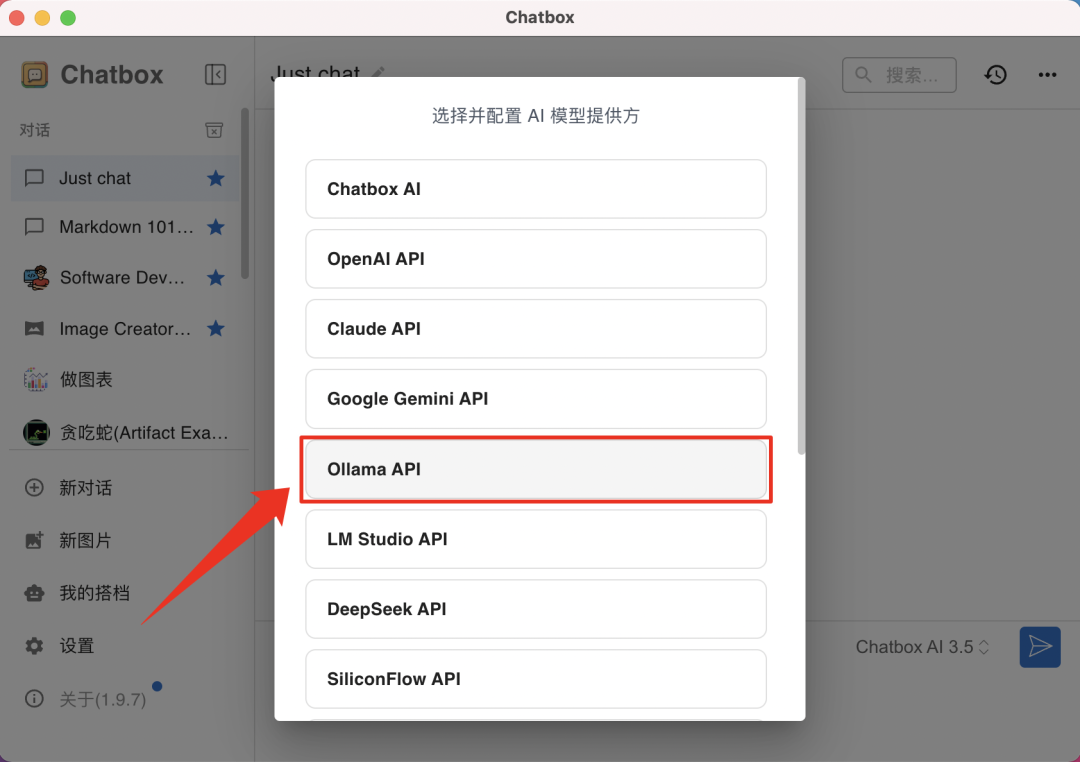

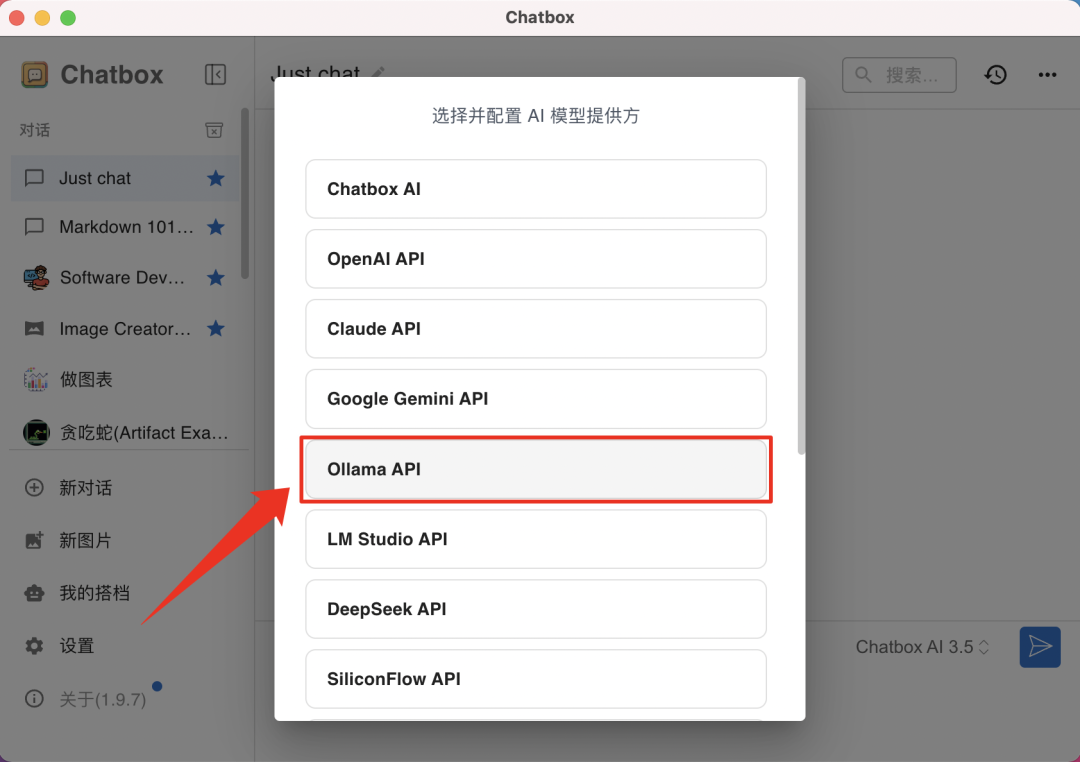

4. 选择 [Ollama API];

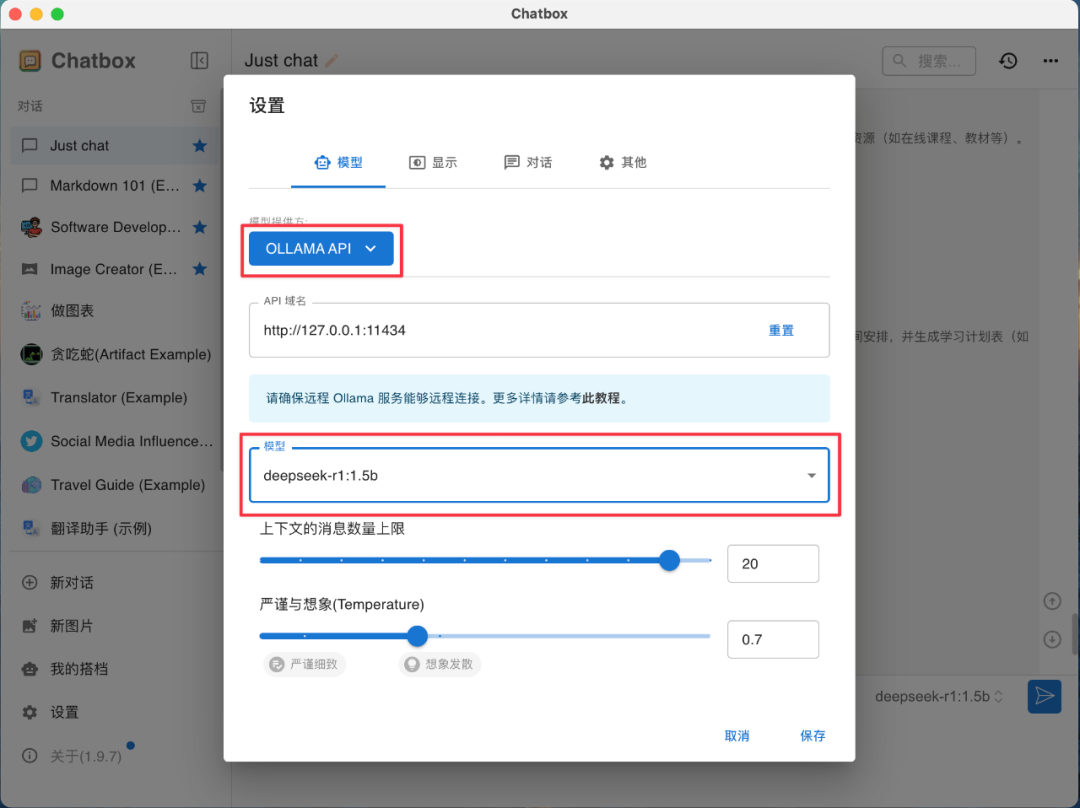

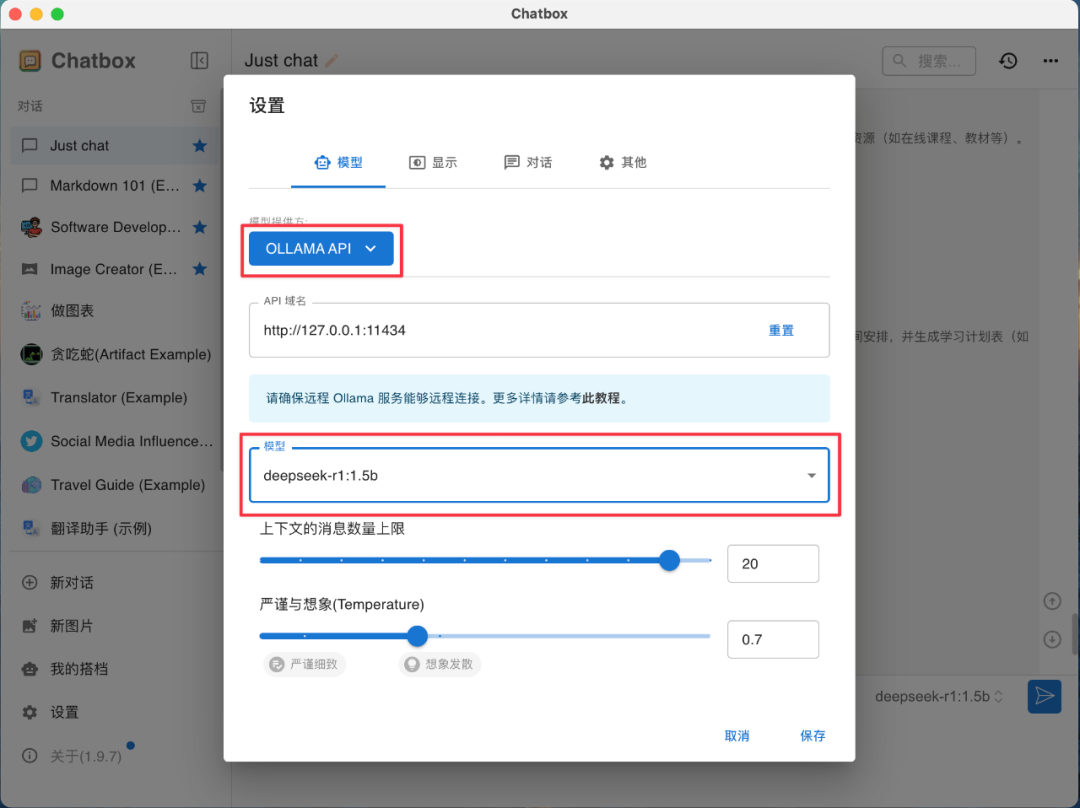

5. 在设置页面,API 域名保持默认,模型选择 [deepseek-r1:1.5b],若模型选择框为空请等待下载完成或重新下载;

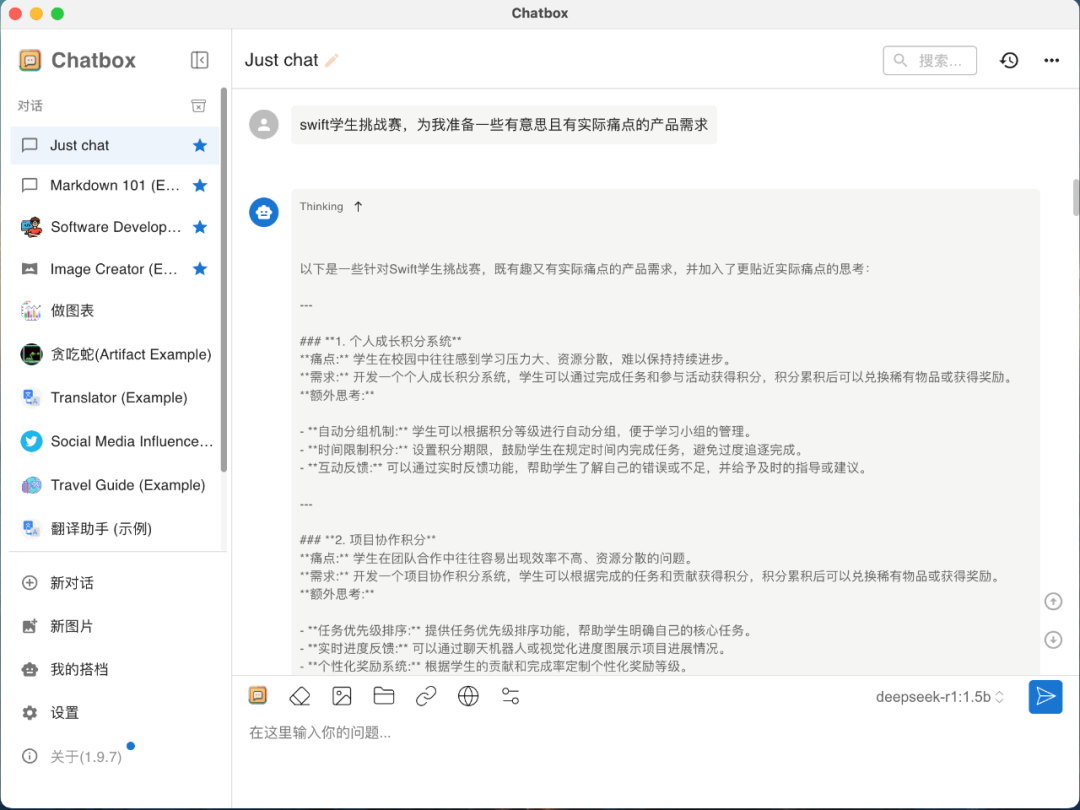

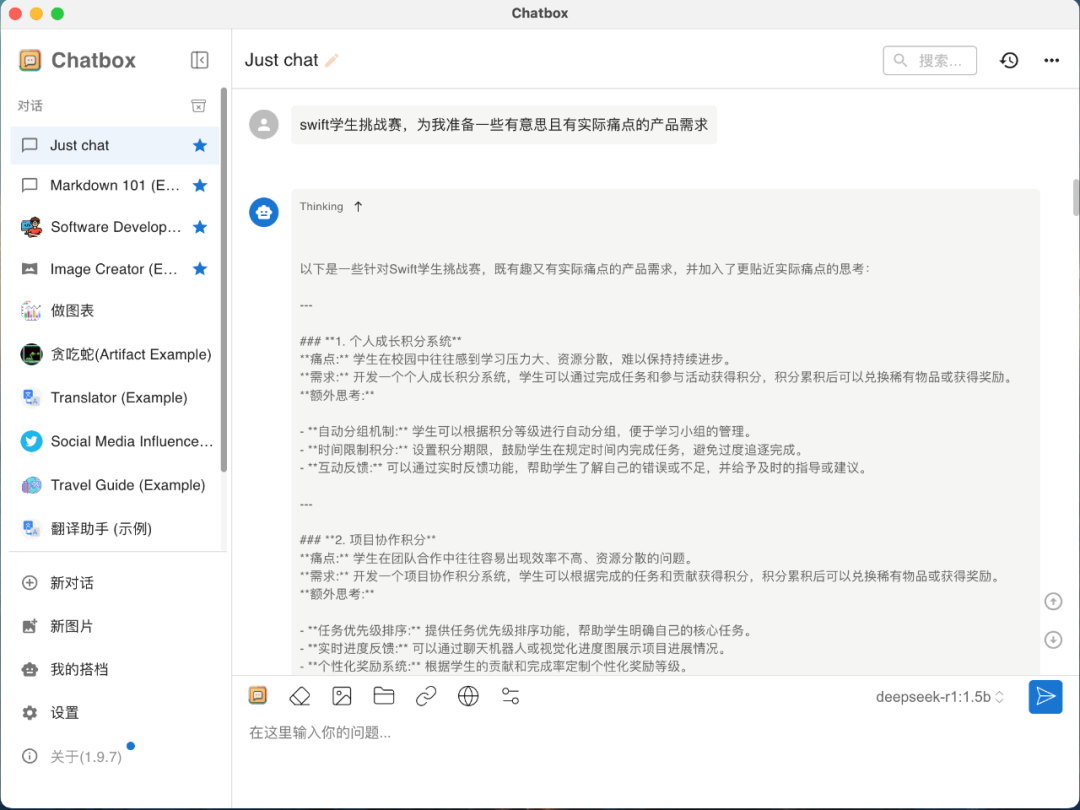

6. 可视化部署完成,可在聊天框内进行对话,所有对话均本地完成,回复迅速。

一起“点赞”三连↓

内容中包含的图片若涉及版权问题,请及时与我们联系删除