DeepSeek因服务器压力大,本地部署成为更优选择。AMD锐龙AI处理器凭借强大的NPU算力,成为体验DeepSeek的上佳之选。文章介绍了如何通过LM Studio在锐龙AI笔记本上轻松部署DeepSeek R1精简版推理模型,详细步骤包括安装显卡驱动、下载LM Studio、选择合适的DeepSeek R1 Distill模型、设置量化模式和GPU卸载等。同时,文章还根据不同的锐龙AI处理器和内存配置,给出了DeepSeek R1 Distill模型的选择建议,以及台式机AMD RX 7000系列显卡的支持情况。

💻 锐龙AI处理器拥有行业领先的NPU算力(高达50 TOPS),是本地部署和体验DeepSeek R1模型的理想选择。

⚙️ 通过LM Studio,用户可以轻松在本地部署DeepSeek R1精简版推理模型,步骤包括安装显卡驱动、下载LM Studio、选择模型、设置量化模式(Q4 K M)和GPU卸载。

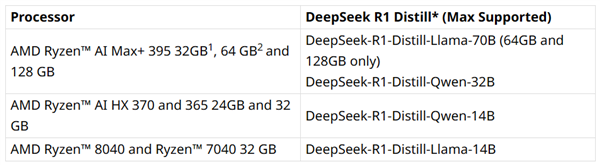

🧠 不同的锐龙AI处理器和内存配置,对应支持不同参数规模的DeepSeek R1 Distill模型。例如,顶级锐龙AI MAX+ 3950处理器搭配64GB/128GB内存,最高支持DeepSeek-R1-Distill-Llama-70B。

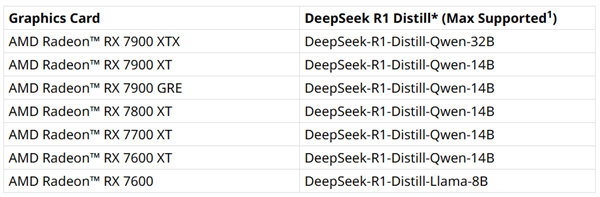

🖥️ AMD RX 7000系列显卡也支持本地部署DeepSeek R1,不同型号显卡支持的模型参数规模不同,例如RX 7900 XTX最高支持DeepSeek-R1-Distill-Qwen-32B。

快科技2月12日消息,DeepSeek持续火爆,大家都在体验,但因为服务器承受能力有限,经常会遇到无响应,因此本地部署体验就成了更好的选择,具体规模取决于硬件配置。

AMD是最早在x86处理器领域引入AI能力的,锐龙7040系列就率先集成了独立的NPU AI引擎,此后的锐龙8040系列、锐龙AI 300系列、锐龙AI MAX 300系列都越发强大。AMD锐龙AI处理器拥有目前行业最强的NPU,算力高达50 TOPS(每秒50万亿次计算),自然是体验DeepSeek的上佳选择。如果你有一台锐龙AI笔记本,现在就可以通过LM Studio,轻松在本地部署、体验DeepSeek R1精简版推理模型。

具体操作方式如下:1、安装AMD Adrenalin 25.1.1或更新版显卡驱动。2、打开lmstudio.ai/ryzenai,并下载LM Studio 0.3.8或更新版本。3、安装启动LM Studio,可以直接跳过引导屏幕。4、点击“发现”(discover)标签页。5、选择适合自己的DeepSeek R1 Distill。具体如何选择见后。6、在软件页面右侧,勾选“Q4 K M”量化模式,然后点击“下载”。7、下载完成后,返回聊天选项页,从下拉菜单中选择DeepSeek R1 distill,并确保勾选“手动选择参数”(manually select parameters)选项。8、在“GPU卸载”(GPU offload)中,将滑块移到最大值。9、点击“模型加载”(model load)。10、好了,可以在本地体验DeepSeek R1推理模型了!

不同参数规模的大模型,决定了其性能和体积,因此不同的硬件设备需要选择最适合自己的参数量。如果是顶级的锐龙AI MAX+ 395处理器,搭配64GB、128GB内存,最高可以支持DeepSeek-R1-Distill-Llama-70B,注意64GB内存的话需要将可变显存设置为高。搭配32GB内存,可变显存自定义为24GB,则能支持到DeepSeek-R1-Distill-Qwen-32B。如果是锐龙AI HX 370、AI 365处理器,搭配24GB、32GB内存,可以支持DeepSeek-R1-Distill-Qwen-14B。如果是锐龙7040/8040系列,需要搭配32GB内存,才能支持到DeepSeek-R1-Distill-Qwen-14B。

另外,AMD推荐将所有Distill运行在Q4 K M量化模式。如果你使用的是台式机,AMD RX 7000系列显卡也都已支持本地部署DeepSeek R1。其中,RX 7900 XTX旗舰显卡最高支持DeepSeek-R1-Distill-Qwen-32B,RX 7900 XT、7900 GRE、7800 XT、7700 XT、7600 XT均可以支持到DeepSeek-R1-Distill-Qwen-14B,RX 7600以及新发布的RX 7650 GRE则适合到DeepSeek-R1-Distill-Llama-8B。

【本文结束】如需转载请务必注明出处:快科技责任编辑:上方文Q文章内容举报]article_adlist-->