index_new5.html

../../../zaker_core/zaker_tpl_static/wap/tpl_guoji1.html

![]()

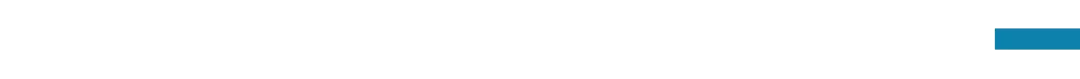

本次分享聚焦大型语言模型在组合关系推理任务中的表现与机制。彩云科技与北京邮电大学合作,提出了一个名为广义关联回忆(GAR)的新基准测试,用于评估大模型在处理复杂关系推理时的能力。研究揭示了大模型在组合推理任务中的核心缺陷,并深入探讨了Transformer模型内部的关键推理机制。通过分析模型在解决问题时的“脑回路”,旨在更深入地理解大模型如何实现和处理这种复杂的推理过程。本次分享由彩云天气联合创始人、首席科学家肖达主讲。

🚀 **核心缺陷**:大型语言模型在组合关系推理任务中存在核心缺陷,这促使研究人员开发新的基准测试来更准确地评估模型性能。

🧠 **GAR基准测试**:广义关联回忆(GAR)基准测试被设计用于评估大模型在组合推理任务中的表现,通过更细致的测试来揭示模型在处理复杂关系时的能力。

💡 **Transformer脑回路**:研究深入探索了Transformer模型内部的脑回路,旨在揭示大模型内部实现组合关系推理的关键机制,从而帮助理解模型的运作方式。

“组合关系推理”是人类拥有的一种强大能力。人类能够理解多个实体之间的复杂关系,并基于这些关系进行推理。比如说,当我们看到 “迈克想去马德里,约翰想去曼谷”,就能推理出约翰想去泰国。那么像Transformer这样的大型语言模型,是否具备这种能力?以及其内部是如何处理和实现这种推理的呢?大模型2.0系列读书会旨在深入探讨大模型推理新范式背后的核心技术和基本原理,而大模型2.0读书会的第六期分享将由彩云天气联合创始人、首席科学家肖达解读由彩云科技和北京邮电大学合作完成且被第 39 届AAAI 会议高分录取的新工作「Benchmarking and Understanding Compositional Relational Reasoning of LLMs」,探索大模型内部的关键推理机制。本次分享首先明确讨论大语言模型在组合关系推理任务中的核心缺陷,开发了一个新的基准测试,称为广义关联回忆(Generalized Associative Recall, GAR),专门用来评估大模型在组合推理任务中的表现,并研究模型在解决问题时的脑回路,揭示了模型内部的关键推理机制。

肖达,集智科学家社群成员,人工智能公司彩云天气联合创始人、首席科学家,北京邮电大学网络空间安全学院讲师,主要负责深度神经网络模型和算法的研发用于彩云天气、彩云小译、彩云小梦等产品。

研究兴趣为:机器学习、深度学习、大模型及其在自然语言处理、程序分析、软件安全等领域的应用;大语言模型的模型结构和机制可解释性;认知科学和人工智能的交叉。

直播时间:

2025年2月9日(本周日)晚上19:30-20:30

参与方式:

扫码报名

扫码参与大模型2.0读书会,加入群聊,获取系列读书会回看权限,成为人工智能社区的种子用户,与社区的一线科研工作者与企业实践者沟通交流,共同推动人工智能社区的发展。o1模型代表大语言模型融合学习与推理的新范式。集智俱乐部联合北京师范大学系统科学学院教授张江、Google DeepMind研究科学家冯熙栋、阿里巴巴强化学习研究员王维埙和中科院信工所张杰共同发起「大模型II:融合学习与推理的大模型新范式 」读书会,本次读书会将关注大模型推理范式的演进、基于搜索与蒙特卡洛树的推理优化、基于强化学习的大模型优化、思维链方法与内化机制、自我改进与推理验证。希望通过读书会探索o1具体实现的技术路径,帮助我们更好的理解机器推理和人工智能的本质。

从2024年12月7日开始,预计每周六进行一次,持续时间预计 6-8 周左右。欢迎感兴趣的朋友报名参加,激发更多的思维火花!

详情请见:大模型2.0读书会:融合学习与推理的大模型新范式!

内容中包含的图片若涉及版权问题,请及时与我们联系删除