DRUGAI

今天为大家介绍的是来自南丹麦大学的Lukas Galke团队的一篇论文。深度神经网络推动了自然语言处理的成功发展。语言的一个基本特性是其组合结构,使人类能够系统地为新的含义产生相应的语言形式。对人类而言,结构更具组合性和透明度的语言通常比结构不透明且不规则的语言更易学习。然而,这种可学习性优势在深度神经网络中尚未得到证实,这限制了它们作为人类语言学习模型的应用。在本研究中,作者直接测试了神经网络与人类在学习和泛化具有不同程度组合结构的语言时的表现对比。作者评估了大型语言模型和循环神经网络的记忆与泛化能力,结果表明这两种深度神经网络都表现出了对更具结构化语言输入的可学习性优势:接触更具组合性语言的神经网络展现出更系统的泛化能力、不同模型之间更高的一致性,以及与人类学习者更相似的特征。

组合性指复合表达式的意义是否可以从其组成部分的意义直接推导出来。这一概念长期以来受到计算机科学家和语言学家的关注。例如,英语短语“white horse”的意义可以从“white”和“horse”推导得出,因此是组合性的;而德语的“Schimmel”却无法通过其组成部分“weiß”和“Pferd”推导出完整含义。语言的组合结构对系统化泛化能力和表达力有重要影响。研究发现,组合性更强的语言通常更容易被成人学习者掌握,并能促进更高效、更一致的泛化能力。这是因为具有系统性和规则性的语言输入可以帮助学习者推导生成规则,而不只是简单记忆单个词汇。本研究旨在探讨深度神经网络是否能像人类一样,从更高组合性的语言中获益。通过对比GPT-3.5和一种定制的循环神经网络(RNN)架构,研究发现:当输入语言具有更高的组合性时,深度神经网络表现出更强的泛化能力,结果一致性更高,且与人类的学习模式更接近。

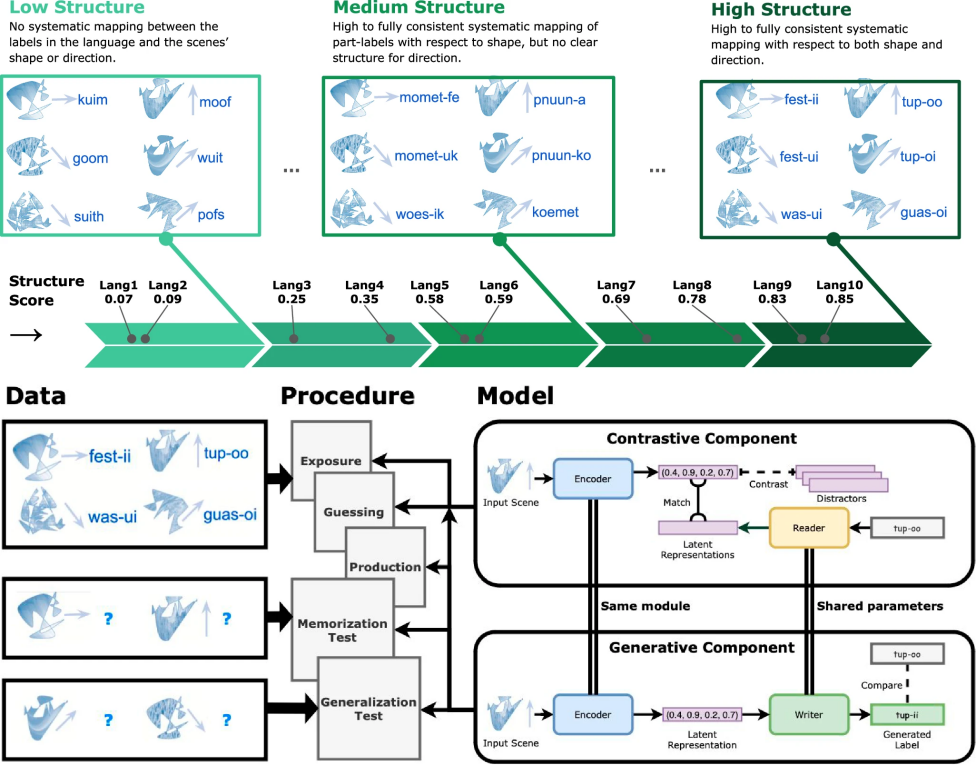

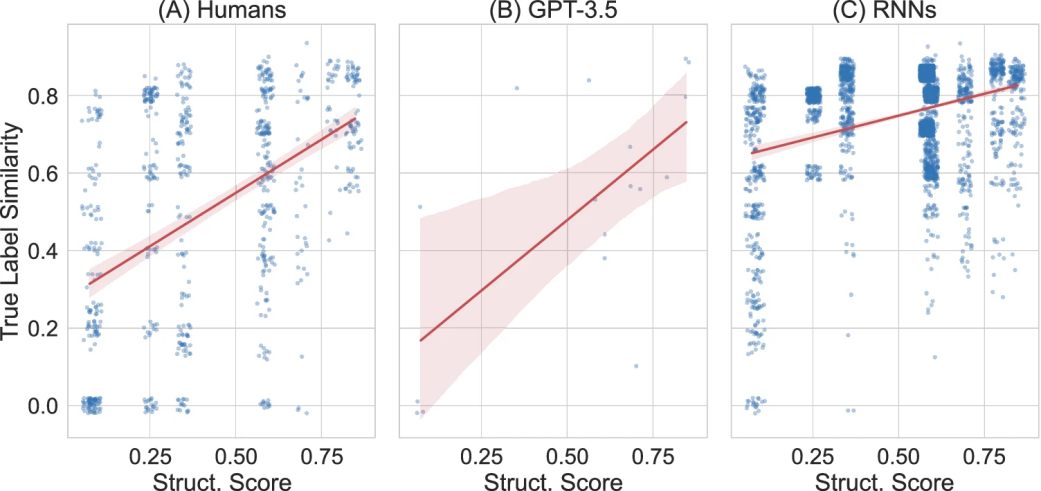

图 1

为了实现人类与机器的直接对比,图1遵循了此前一项语言学习研究的设置,共使用了10种人工语言。这些语言通过人类群体实验生成,结构从完全无规律的标签到高度系统化的标签不等(例如,同一形状向不同方向移动可以用完全不同的词描述,或使用共享部分的词描述,如“fest-ii”和“fest-ui”)。实验中,神经网络与人类接受相同的学习任务和反馈,并在记忆与泛化测试中进行对比评估。研究结果显示,高组合性的语言输入不仅使神经网络能够更有效地泛化和记忆,还使其表现出与人类更为相似的学习特征。这表明,语言的系统性对人工智能和人类语言学习都有重要意义,为进一步模拟语言结构的形成提供了新的研究方向。

语言组合性提高了模型与人类的相似性和泛化能力

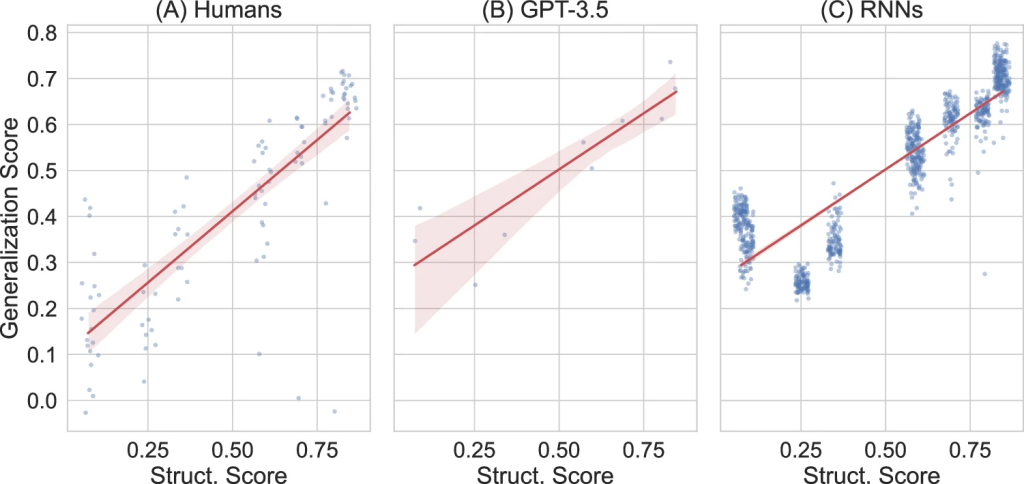

图 2

研究发现了一个有趣的现象:人工智能和人类在学习语言时表现出惊人的相似之处。如图2所示,当语言的规则越清晰,GPT-3.5就越能像人类一样举一反三。比如,如果它学习的是那种词语构造有规律的语言,在面对新场景时,它能够按照已学习的规律创造出合理的新表达。

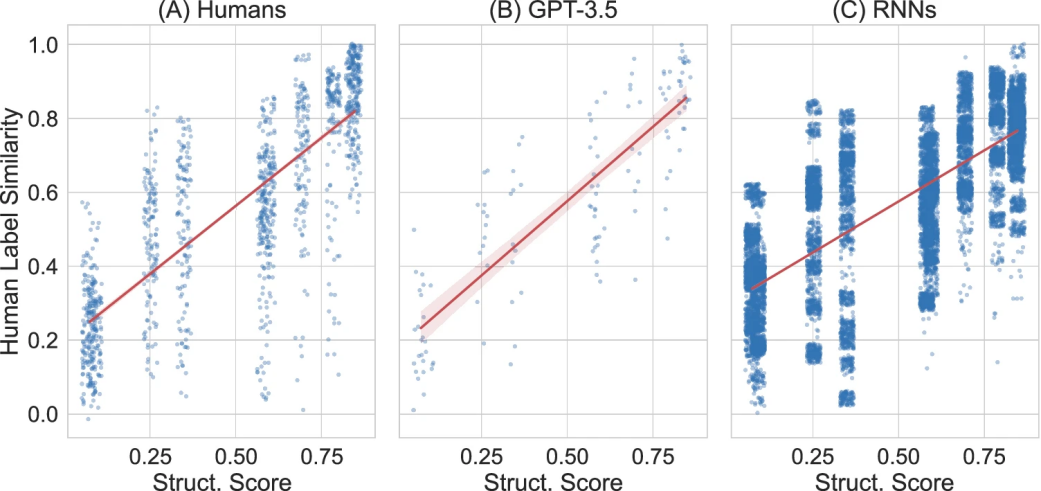

图 3

图3进一步证实,在学习结构更规范的语言时,GPT-3.5创造的表达方式与人类的思维更加接近。这就像两个学习同一门外语的人,如果这门语言的规则很清晰,他们更可能想出相似的表达方式。

图 4

更有意思的是,如图4所示,就算在记忆出现偏差时,这种规律依然存在:当语言本身更有规律性时,无论是AI还是人类,即使没能完全准确记住某个表达,他们的“错误版本”也往往更接近正确答案。这表明,规律性强的语言不仅容易学习,也更容易形成稳定的记忆。

语言组合性提高了模型与人类的相似性和系统泛化能力

作者设计了一个创新的AI系统来模拟人类学习语言的过程。这个系统就像一个由两部分组成的“大脑”:一部分负责看到场景后说出描述(就像我们看到一个物体后能说出它的名称),另一部分则负责听到描述后识别正确的场景(就像我们听到一个词后能指出它描述的是什么)。

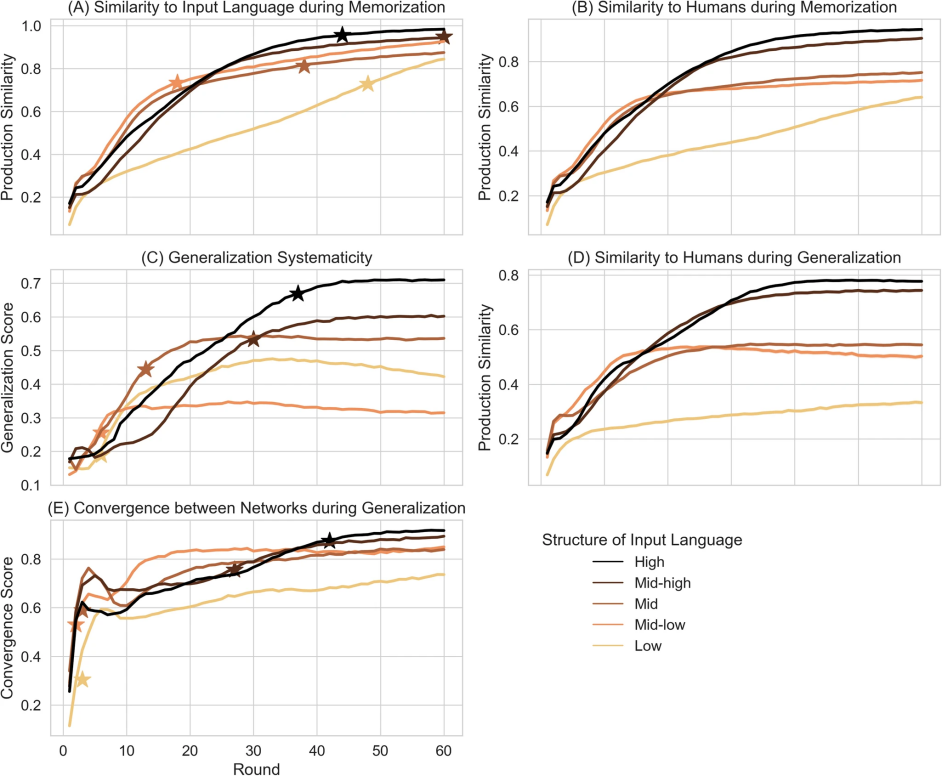

图 5

为了全面验证这个系统的可靠性,研究人员创建了1000个独立的AI模型(每种语言测试100个),就像让1000个学生分别学习10种不同的语言。他们观察了每个AI在学习过程中的表现:它们能多准确地记住已学内容,能否举一反三应对新场景,以及它们的表现是否与人类学习者相似。如图5所示,这些测试结果清晰地展示了AI是如何逐步掌握这些语言的。

记忆轨迹

作者通过生产相似性来衡量记忆效果,该指标计算原始标签与生成标签之间的相似性,方法是比较同一场景下两者的平均归一化编辑距离。作者将此指标用于两种比较:一种是比较生成标签与输入语言中的真实标签,另一种是比较机器生成的标签与人类为同一场景生成的标签。

记忆过程中与输入语言的相似性

在足够的训练轮次下,所有语言都可以被所有神经网络智能体学习,生成标签的生产相似性在第60轮时至少达到0.8(图5A)。结构化语言的学习效果显著更好,即这些语言与输入语言的相似性更高。然而,这种优势会随着训练轮次的增加而逐渐减弱。

记忆过程中与人类的相似性

作者通过比较神经网络智能体和人类在记忆阶段生成的标签,来衡量它们与人类的相似性(图5B)。更高组合性的输入语言使得神经网络智能体与人类学习者之间的相似性显著提高。这一效果随着训练轮次的增加进一步增强。

泛化轨迹

作者评估了神经网络智能体在泛化过程中生成的标签,即为未见过的新场景生成的标签。评估涵盖三个方面:系统性程度、人类相似性,以及不同智能体之间在泛化上的一致性。对于大语言模型,作者通过泛化得分进行评估。结果显示,结构化语言显著提高了泛化得分(图5C),这一效果随着时间的推移进一步增强。

泛化过程中与人类的相似性

作者衡量了神经网络智能体在泛化阶段生成的标签与人类生成的标签之间的相似性(图 5D)。更高结构性的输入语言显著提高了智能体与人类的相似性,这一趋势随着训练轮次的增加而进一步加强。

泛化过程中神经网络智能体之间的一致性

更高结构性的语言使得不同神经网络智能体之间在新场景上的标签更为一致。对于这些结构化语言,不同神经网络智能体生成的标签在相似性上显著提高(图5E)。这一效果随着训练轮次的增加而进一步增强。

循环神经网络的最终结果

为了比较自定义的循环神经网络智能体、大语言模型和人类学习者,作者在图2C中展示了输入语言的组合性结构与最终泛化性能之间的关系。三种学习系统(人类、RNN和GPT-3.5) 均表现出相同的趋势:输入语言的更高组合性结构会导致更系统化的泛化。此外,作者计算了人类参与者在相同语言和项目上的泛化结果的平均相似性。结果显示,输入语言的更高结构性导致了与人类更高的相似性。这一趋势在RNN和GPT-3.5的生成标签中同样存在,并且与人类之间的相似性也更显著(图3)。最后,作者在图4中可视化了RNN的记忆误差分析结果,以及其与人类和GPT-3.5的对比。无论是人工智能还是生物学习系统,更高组合性结构的语言输入均导致生成结果更接近真实标签。

结论

研究结果表明,神经网络和人类在语言学习上有着惊人的相似之处:当学习结构更规范的语言时,两者都表现出更好的理解和泛化能力。虽然所有语言最终都能被学习掌握,但结构化程度高的语言学习效果更好,且更接近人类的表现模式。在高度结构化的语言中,神经网络和人类产生的标签几乎完全一致,而在低结构化语言中则差异较大。这一发现不仅加深了我们对语言学习机制的理解,也为人工智能系统的开发提供了重要启示:更规范的语言结构有助于提高学习效果和泛化能力。

编译|于洲

审稿|王梓旭

参考资料

Galke L, Ram Y, Raviv L. Deep neural networks and humans both benefit from compositional language structure[J]. Nature Communications, 2024, 15(1): 10816.

内容中包含的图片若涉及版权问题,请及时与我们联系删除