本文介绍了在Macbook上本地运行Deepseek R1 32b模型的体验。作者使用M4 Pro芯片和48G内存的配置,发现32b模型基本可用,但速度比官方app慢一倍,14b模型则运行流畅。作者推测M1之后的芯片运行14b模型问题不大。本地部署的缺陷在于无法使用联网搜索功能,且性能受限。Deepseek官方默认使用70b大模型,本地部署民用级上限约为70b蒸馏版,671b超级版则需要大量GPU资源。文章建议轻度用户优先使用官方app或API,若服务不稳定可考虑本地部署14b模型。最后提到Deepseek部署流程简单,分享教学笔记后反而掉粉,令人难以理解。

💻Macbook本地运行Deepseek R1 32b模型基本可用,但速度较官方app慢一倍,14b模型运行流畅,M1之后芯片运行14b模型应该没问题。

🌐本地部署Deepseek模型无法使用联网搜索功能,且电脑配置不足可能影响智能水平,官方app默认使用70b大模型,本地部署民用级上限约为70b蒸馏版。

🚀轻度用户优先选择官方app或API,若官方服务不稳定再考虑本地部署,推荐优先尝试14b模型,未来各路大佬可能会把Deepseek玩出更多花样。

📝Deepseek部署流程简单,作者分享教学笔记后,粉丝反而下降,这一现象令人费解。

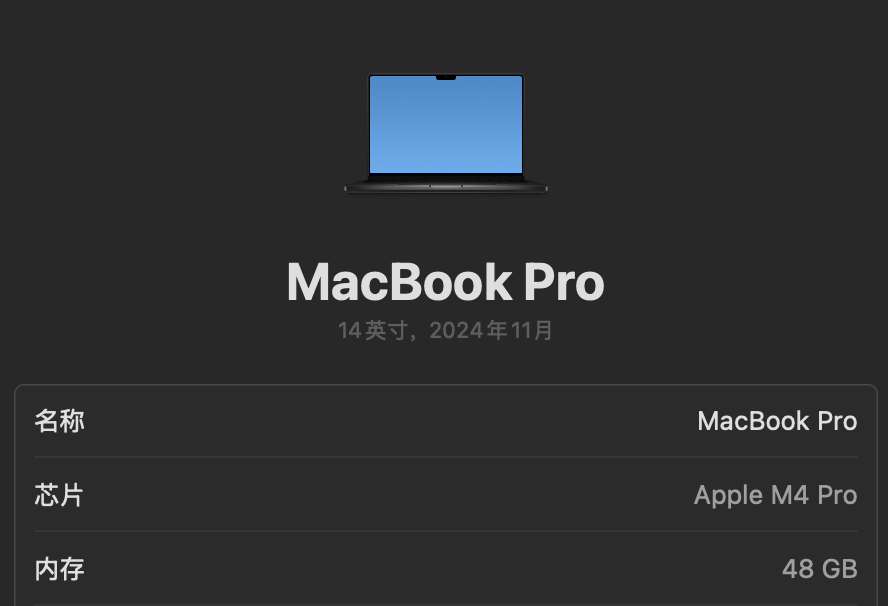

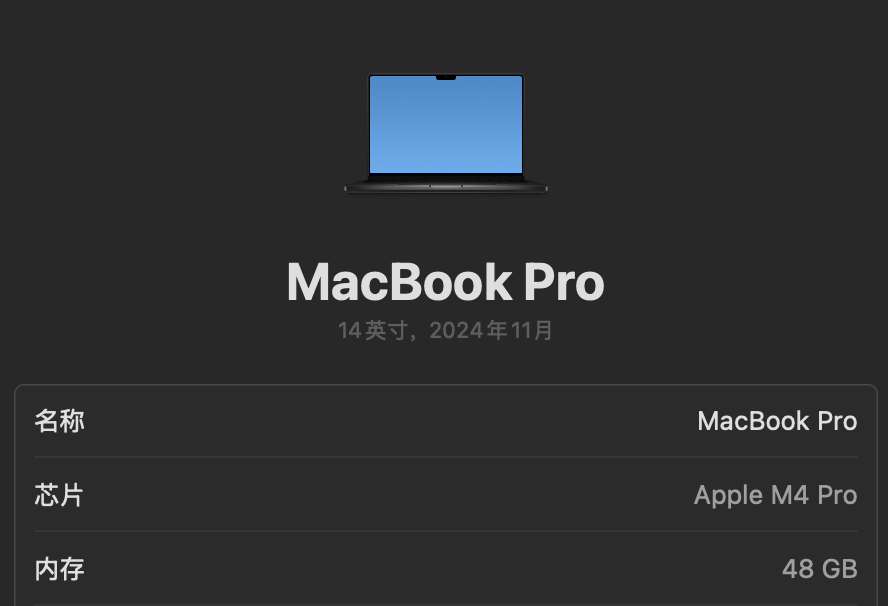

我Macbook本地跑Deepseek r1 32b模型,基本可用,AI回答速度体感上比DS官方app慢一倍(非精确测试)。我配置是M4 pro芯片(14核中央+20核图形处理器),48G内存。

跑14b很流畅。因此推测Mac M1之后的芯片跑14b没什么问题。

70b模型本来想挑战一下,但一直没有成功下载。?

回家之后打算测一下n卡的运行怎么样。

本地简单部署的缺陷是无法使用deepseek的联网搜索功能,并且电脑配置不够好的话,也达不到官方app的智能水平。deepseek官方版默认是70b大模型,本地部署民用级别上限差不多是70b(蒸馏版本),并且我推测我Mac跑70b会非常吃力。671b的超级版不知道得多少块4090才能带起来,成本太高了。

结论:轻度用户,可以优先使用deepseek官方app或者api。如果官方服务不稳定,可以考虑本地部署,推荐优先尝试14b。

相信不久之后各路大佬会把deepseek玩出花。?

deepseek的部署流程虽然很简单,我在小红书发了个教学笔记,还是有很多赞/藏。然后发完笔记就kuakua往下掉粉,很难评。???