一项由OpenAI进行的研究表明,当前最先进的语言模型在回答事实问题时的准确率并不理想。OpenAI的SimpleQA基准测试结果显示,其最好的模型o1-preview的准确率仅为42.7%,GPT-4o略低,Anthropic的Claude模型表现更差。研究强调,用户应将AI模型视为信息处理工具,而非完全依赖的知识来源,并应提供可靠数据以获得更准确的答案。此外,AI模型对自身能力的估计往往过于乐观,其信心评分与实际准确性存在偏差。研究者认为,AI系统在事实准确性方面存在明显缺口,亟需改进,并公开发布了SimpleQA基准测试资料,以推动更可靠的语言模型开发。

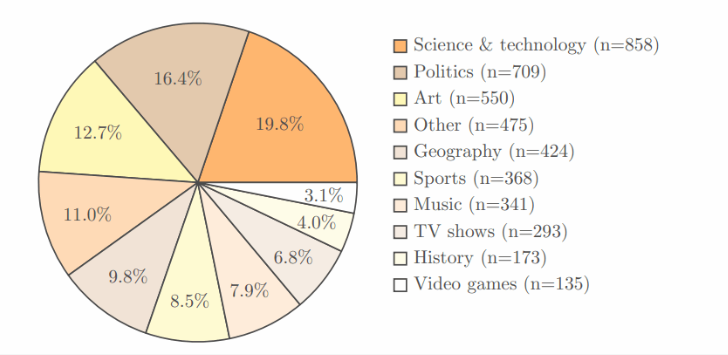

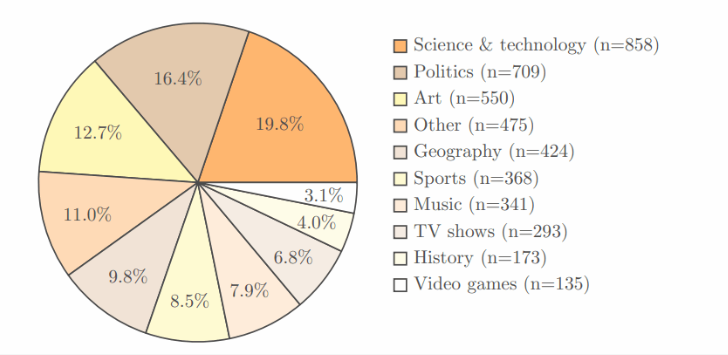

🤔**OpenAI研究发现AI语言模型在事实问题回答上的准确率偏低:** OpenAI采用了SimpleQA基准测试,涵盖科学、政治、艺术等领域,每个问题都有明确答案。结果显示,OpenAI最好的模型o1-preview的准确率仅为42.7%,GPT-4o为38.2%,GPT-4o-mini仅为8.6%,Anthropic的Claude模型表现更差,Claude-3.5-sonnet的准确率只有28.9%。这表明,即使是当前最先进的语言模型,在处理事实问题时也存在明显的局限性,其准确率远低于预期,这与我们对AI模型的期望存在差距,也提醒我们不能过度依赖AI模型提供的事实信息。

该研究不仅仅是为了测试AI模型的表现,更是为了揭示AI模型在知识获取方面的局限性。研究者认为,AI模型在处理信息时,会受到其训练数据和算法的影响,而这些因素可能会导致模型产生偏差或错误的答案。例如,如果训练数据中包含一些错误的信息,那么AI模型可能会学习并输出这些错误的信息。此外,AI模型的算法也可能会导致模型对某些问题产生错误的理解或推断。因此,用户在使用AI模型时,应该保持谨慎的态度,不要盲目相信AI模型提供的答案,而应该结合其他信息来源进行验证。

🧐**用户应将AI模型视为信息处理工具,而非完全依赖的知识来源:** 研究者强调,用户在使用AI模型时,应该将其视为信息处理工具,而不是完全依赖的知识来源。这意味着,用户不应该将AI模型视为一个完美的知识库,而是应该将其视为一个可以帮助用户处理信息的工具。用户应该根据自己的需求和判断,选择合适的信息来源,并对AI模型提供的答案进行评估和验证。为了获得更准确的回答,用户最好能为AI提供可靠的数据,而不是单纯依赖其内置的知识。例如,如果用户想要了解某个特定主题的信息,那么用户可以为AI提供一些相关的文献或资料,以便AI能够更好地理解用户的需求并提供更准确的答案。

同时,用户也应该意识到,AI模型的输出结果可能会受到多种因素的影响,例如训练数据、算法、以及用户的输入方式等。因此,用户不应该完全依赖AI模型的输出结果,而应该结合其他信息来源进行验证。例如,如果用户对AI模型提供的答案存在疑问,那么用户可以查阅其他文献或资料,或者咨询相关领域的专家,以确认AI模型提供的答案是否正确。只有这样,用户才能更好地利用AI模型提供的服务,避免被错误的信息误导。

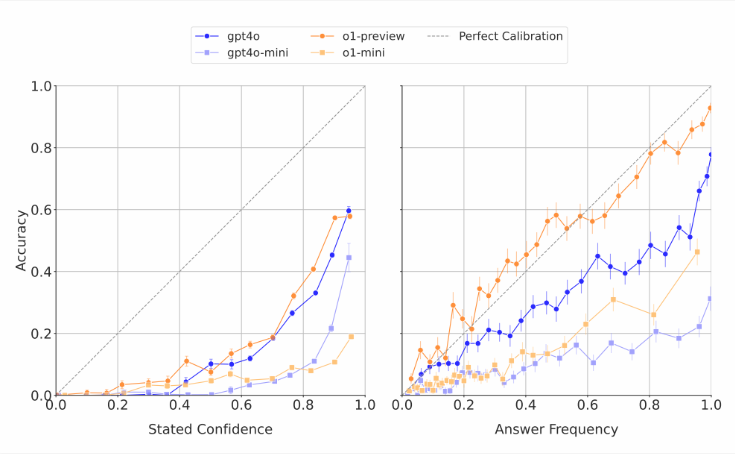

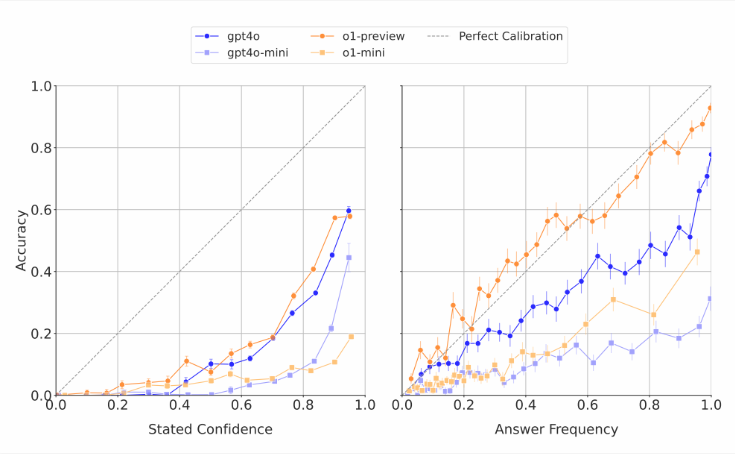

🤔**AI模型对自身能力的估计往往过于乐观,信心评分与实际准确性存在偏差:** 研究人员发现,当这些模型被要求对自己的回答进行信心评分时,它们通常会给出夸大的准确性评分。在重复回答相同问题的测试中,即使模型多次给出相同答案,它们的实际成功率也仍低于其自我评估的准确性。这与外界对语言模型常常产生荒谬回答却显得信心满满的批评一致。

这种现象表明,AI模型对自身能力的评估可能存在偏差,它们可能无法准确地评估自己回答的准确性。这可能是因为,AI模型的训练数据中包含了大量的正确答案,这使得模型对自己的能力产生了过高的估计。此外,AI模型的算法也可能导致模型对自己的能力产生错误的评估。例如,一些AI模型可能会根据自己输出答案的复杂程度来评估自己的准确性,而忽略了答案的正确性。因此,用户在使用AI模型时,不应该完全依赖模型的信心评分,而应该结合其他因素来评估模型输出结果的准确性。

这种现象也提醒我们,AI模型的开发仍然处于早期阶段,它们的能力和局限性都需要进一步的研究和探索。在未来,我们希望能够开发出更可靠的AI模型,能够准确地评估自己的能力,并提供更准确和可靠的信息。

🤔**当前AI系统在事实准确性方面存在明显缺口,亟需改进:** 研究者认为,当前的 AI 系统在事实准确性上存在明显的缺口,亟需改进。同时,他们也提出了一个开放性问题:AI 在回答简短事实问题的表现是否能预测其在处理更长、更复杂回答时的表现。为了支持更可靠的语言模型的开发,OpenAI 已经将 SimpleQA 基准测试的资料公开发布到 Github 上。

AI模型在事实准确性方面的不足,是目前AI技术发展中的一个重要挑战。为了解决这个问题,研究人员正在探索各种方法,例如改进AI模型的训练数据、开发更先进的算法、以及设计更有效的评估方法等。例如,研究人员可以通过收集更多高质量的训练数据来提高AI模型的准确性。此外,研究人员还可以开发更先进的算法,例如知识图谱、推理引擎等,来帮助AI模型更好地理解和处理信息。同时,研究人员也需要设计更有效的评估方法,例如人工评估、对比测试等,来评估AI模型的准确性和可靠性。

此外,研究人员也需要关注AI模型的伦理和社会影响。例如,AI模型可能会被用于传播虚假信息或操纵舆论,这会对社会造成负面影响。因此,研究人员需要开发出更安全的AI模型,并制定相应的伦理规范和法律法规,来确保AI模型的开发和应用能够造福人类。

🤔**AI模型的未来发展方向:** 研究者也提出了一个开放性问题:AI在回答简短事实问题的表现是否能预测其在处理更长、更复杂回答时的表现?这个问题的答案对于AI模型的未来发展至关重要。如果AI模型在回答简短事实问题上的表现能够预测其在处理更长、更复杂回答时的表现,那么研究人员就可以更加有效地评估和改进AI模型。反之,如果AI模型在回答简短事实问题上的表现并不能预测其在处理更长、更复杂回答时的表现,那么研究人员就需要开发新的评估方法来评估AI模型在处理更长、更复杂回答时的能力。

为了推动更可靠的语言模型的开发,OpenAI 已经将 SimpleQA 基准测试的资料公开发布到 Github 上。这为研究人员提供了宝贵的资源,可以帮助他们更好地理解AI模型在事实准确性方面的不足,并开发出更可靠的AI模型。相信随着研究的不断深入,AI模型在事实准确性方面将会得到显著的提升,并为人类社会带来更大的福祉。

最近,一项由 OpenAI 进行的研究显示,尽管人工智能技术飞速发展,当前最先进的语言模型在回答事实问题时的成功率却远低于预期。研究采用了 OpenAI 自家的 SimpleQA 基准测试,这个测试包含了4,326个,涵盖了科学、政治和艺术等多个领域,每个问题都有一个明确的正确答案。

经过两名独立评审员的验证,结果显示,OpenAI 最好的模型 o1-preview 的准确率仅为42.7%,而 GPT-4o 则略低,只有38.2%。至于更小的 GPT-4o-mini,准确率甚至只有8.6%。相比之下,Anthropic 的 Claude 模型表现得更差,Claude-3.5-sonnet 的正确率仅为28.9%。

这项研究的关键在于测试的设计,不仅仅是为了测试 AI 的表现,还为了让大家认识到 AI 模型在知识获取方面的局限性。研究者强调,用户在使用这些模型时,应该将其视为信息处理工具,而不是完全依赖的知识来源。为了获得更准确的回答,最好能为 AI 提供可靠的数据,而不是单纯依赖其内置的知识。

值得注意的是,AI 模型对自身能力的估计往往过于乐观。研究人员发现,当这些模型被要求对自己的回答进行信心评分时,它们通常会给出夸大的准确性评分。在重复回答相同问题的测试中,即使模型多次给出相同答案,它们的实际成功率也仍低于其自我评估的准确性。这与外界对语言模型常常产生荒谬回答却显得信心满满的批评一致。

研究者认为,当前的 AI 系统在事实准确性上存在明显的缺口,亟需改进。同时,他们也提出了一个开放性问题:AI 在回答简短事实问题的表现是否能预测其在处理更长、更复杂回答时的表现。为了支持更可靠的语言模型的开发,OpenAI 已经将 SimpleQA 基准测试的资料公开发布到 Github 上。

自 站长之家