index_new5.html

../../../zaker_core/zaker_tpl_static/wap/tpl_guoji1.html

![]()

OpenAI 收到了来自英伟达的首批工程版 DGX B200,这标志着 OpenAI 在 AI 算力方面取得了新的进展。与此同时,微软宣布 Azure 正式成为首个运行英伟达 Blackwell 系统的云服务,为 OpenAI 提供了更强大的算力支持。OpenAI 还与甲骨文洽谈租用整个 Abilene 数据中心,并与微软合作建设一个价值 1000 亿美元的超算服务器集群。此外,OpenAI 也在考虑自主开发 AI 芯片,以降低运营成本。英伟达强大的算力不仅推动了 AI 模型的训练和推理,也为工业、科学和医疗保健等领域带来了变革,并降低了能源消耗。

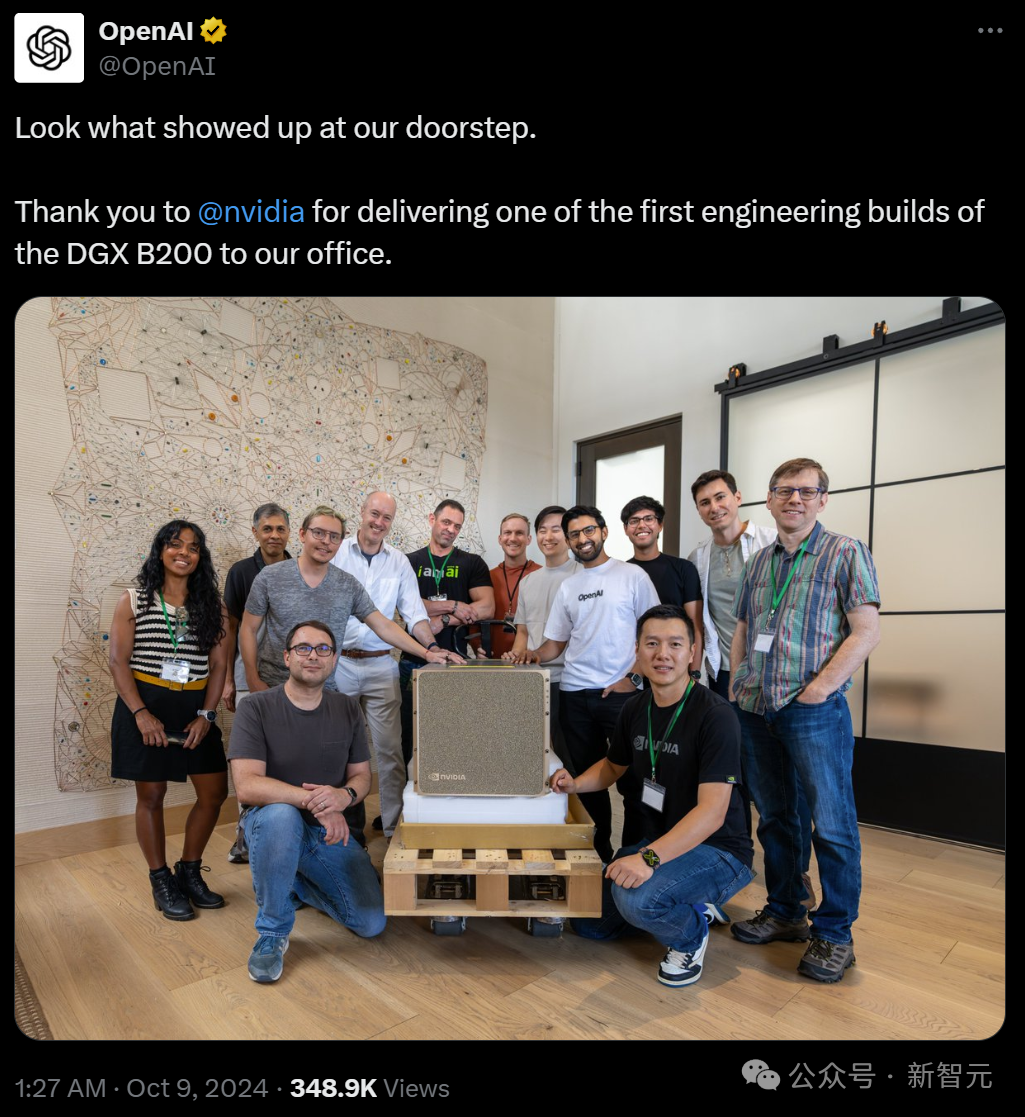

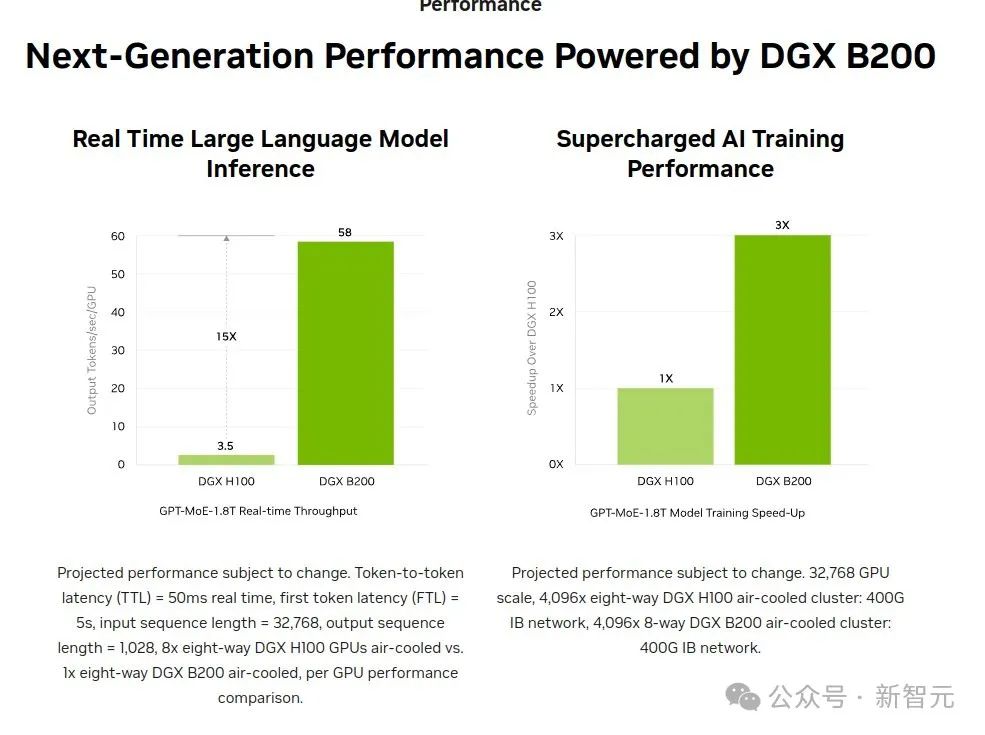

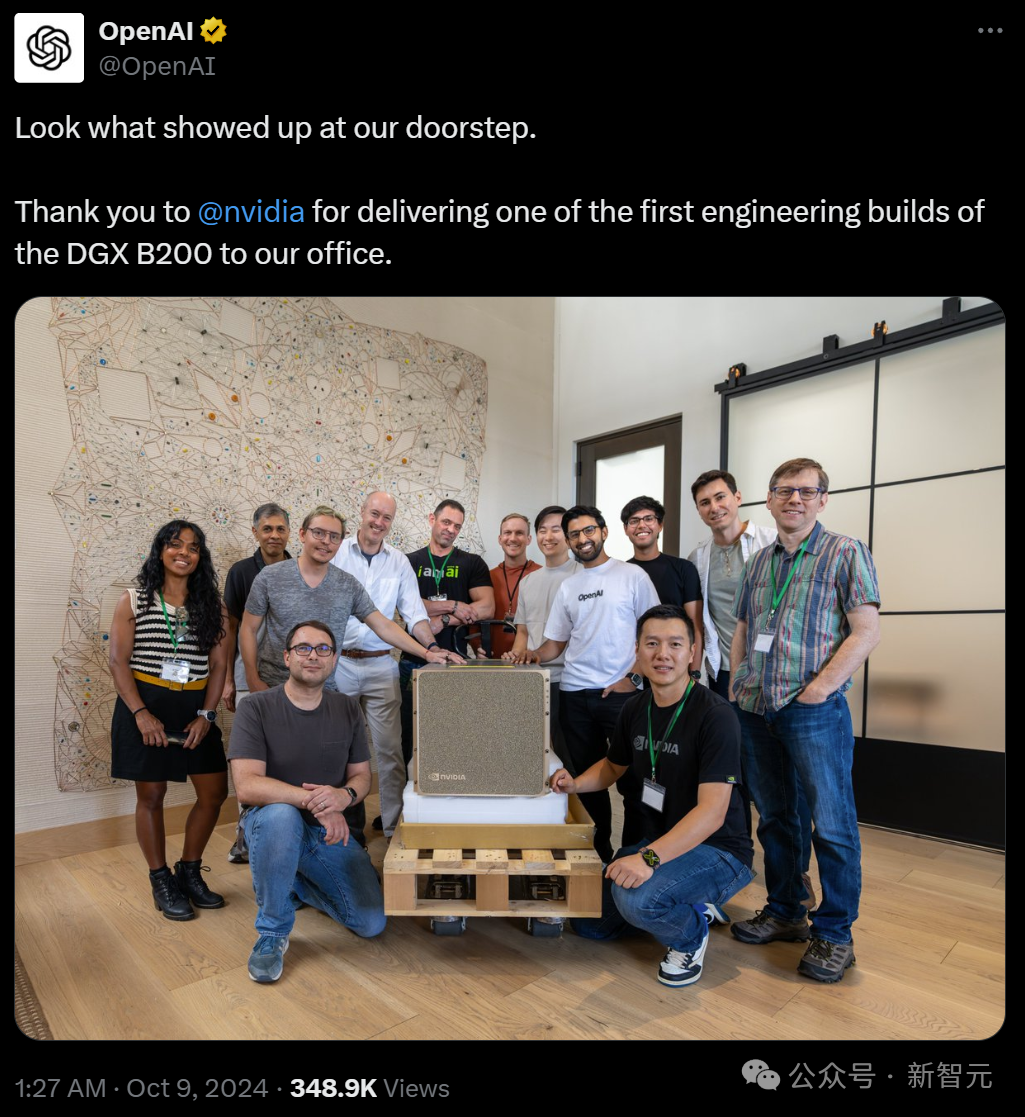

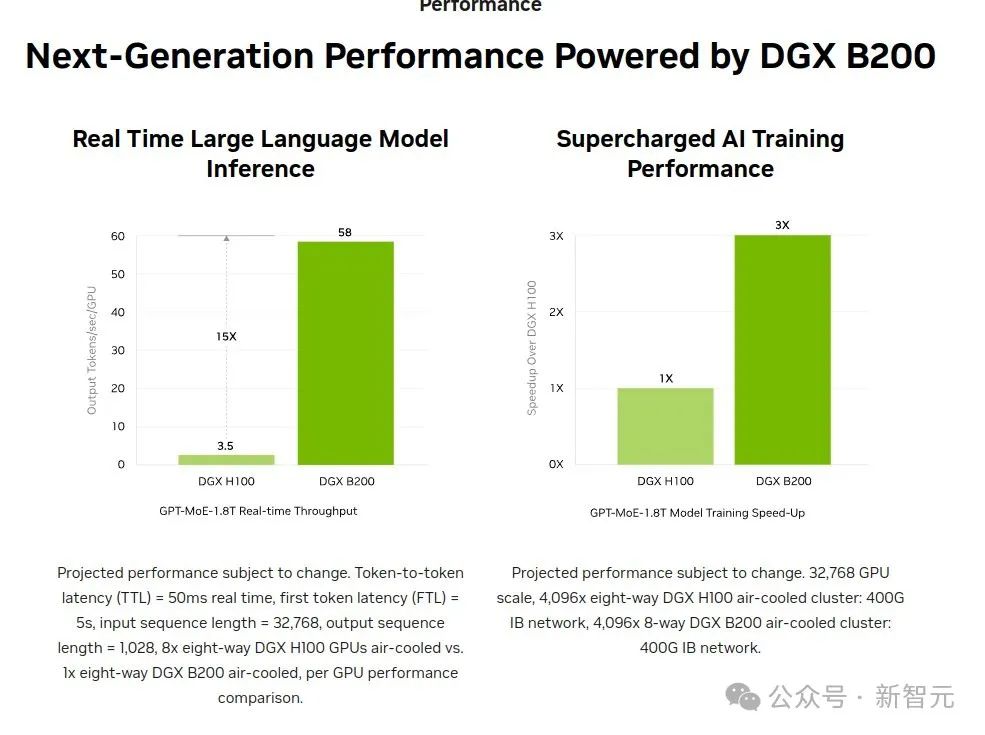

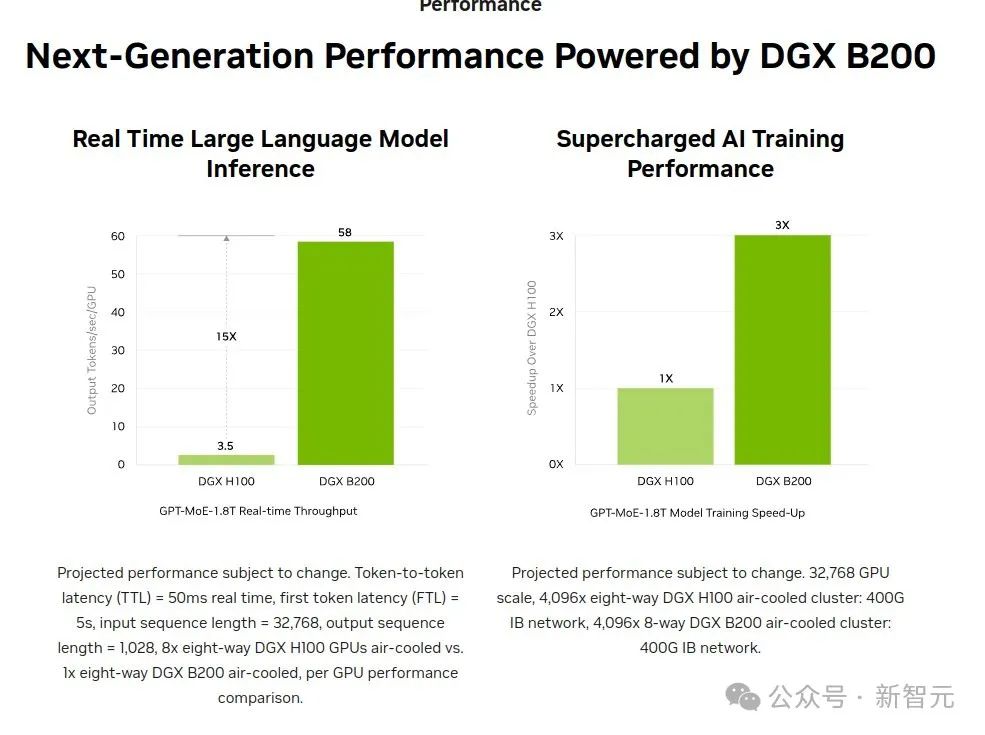

🤩 OpenAI 收获英伟达 DGX B200:OpenAI 收到了来自英伟达的首批工程版 DGX B200,这标志着 OpenAI 在 AI 算力方面取得了新的进展。DGX B200 搭载了 8 块英伟达 B200 GPU,可提供高达 144 petaflops 的 AI 算力,并拥有高达 1.4TB 的 GPU 显存容量和 64TB/s 的显存带宽。与前代产品相比,DGX B200 不仅在训练性能上提升了 3 倍,而且在实时推理万亿参数模型时速度提升了 15 倍。

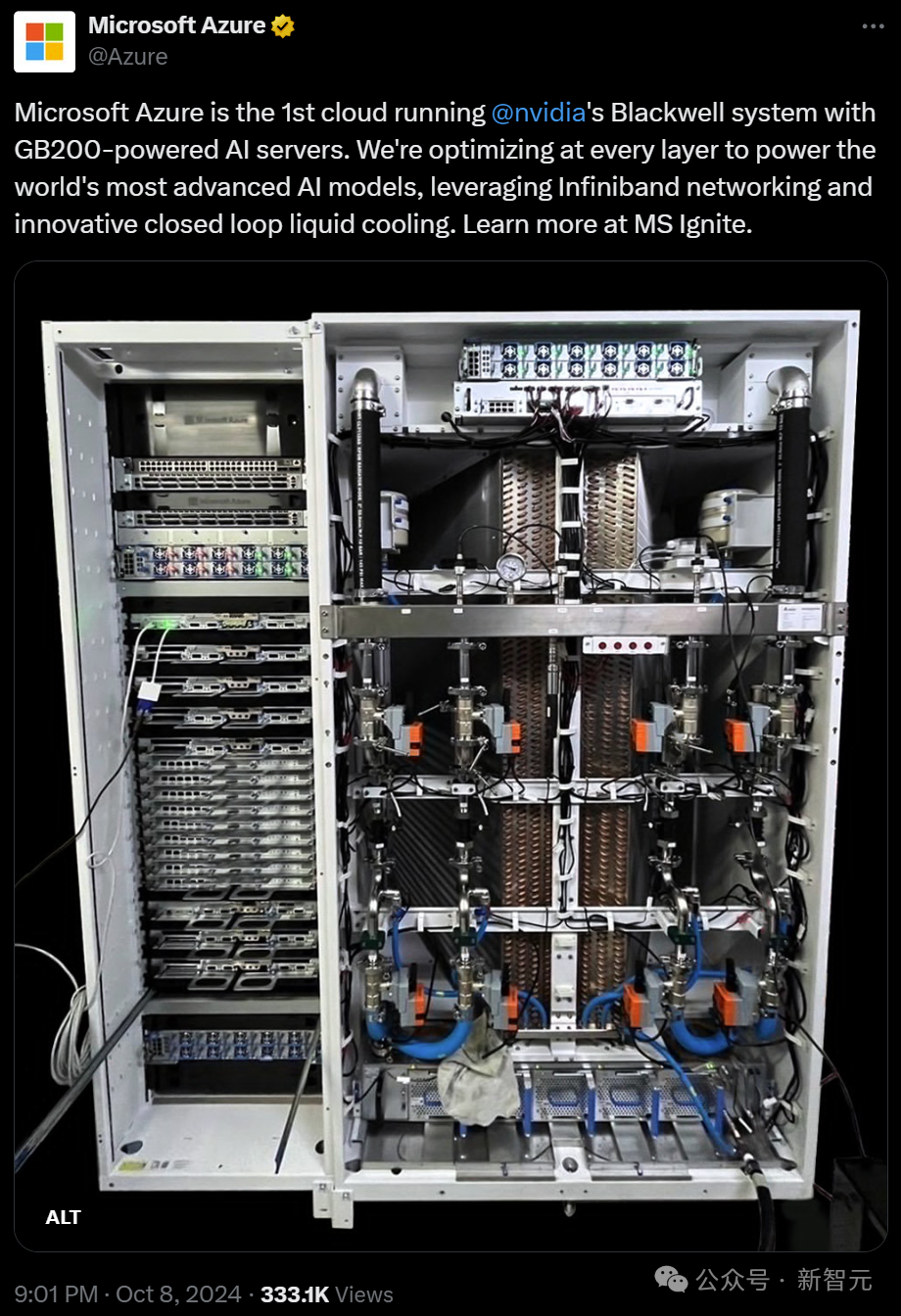

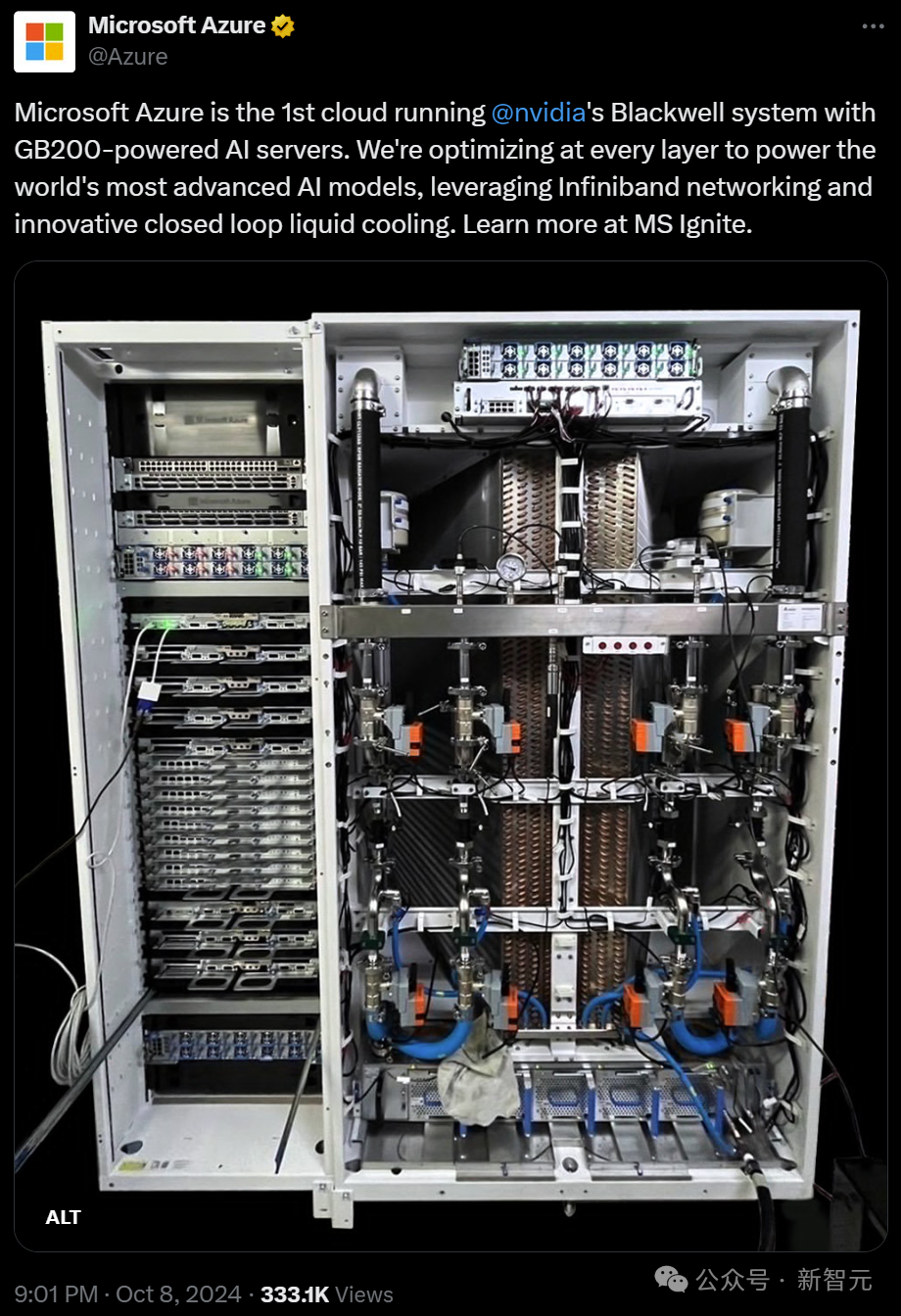

🤝 微软 Azure 成为首个运行英伟达 Blackwell 系统的云服务:微软宣布 Azure 正式成为首个运行英伟达 Blackwell 系统的云服务,为 OpenAI 提供了更强大的算力支持。Blackwell 架构强大的 FP4 性能,能够有效地降低 AI 模型训练和推理的能耗,并为工业、科学和医疗保健等领域带来变革。

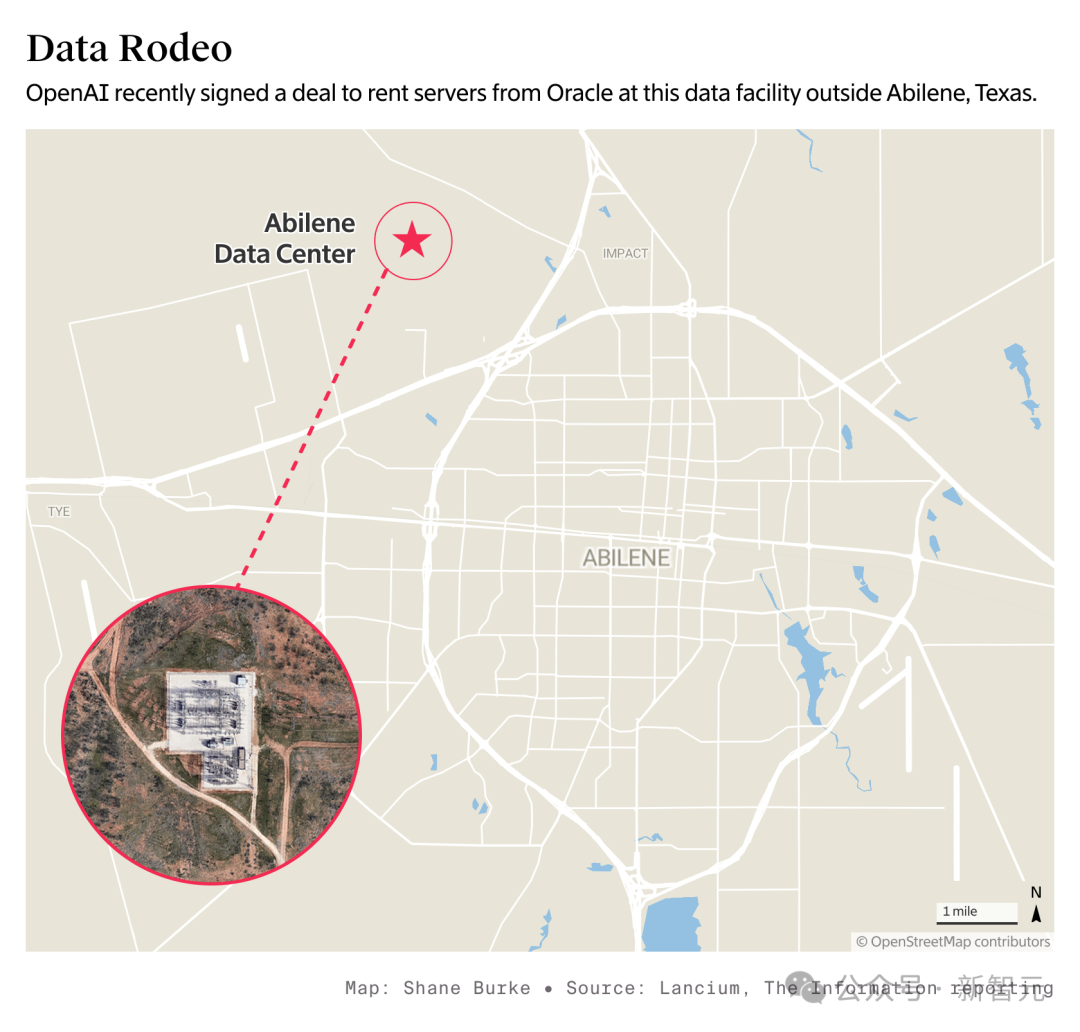

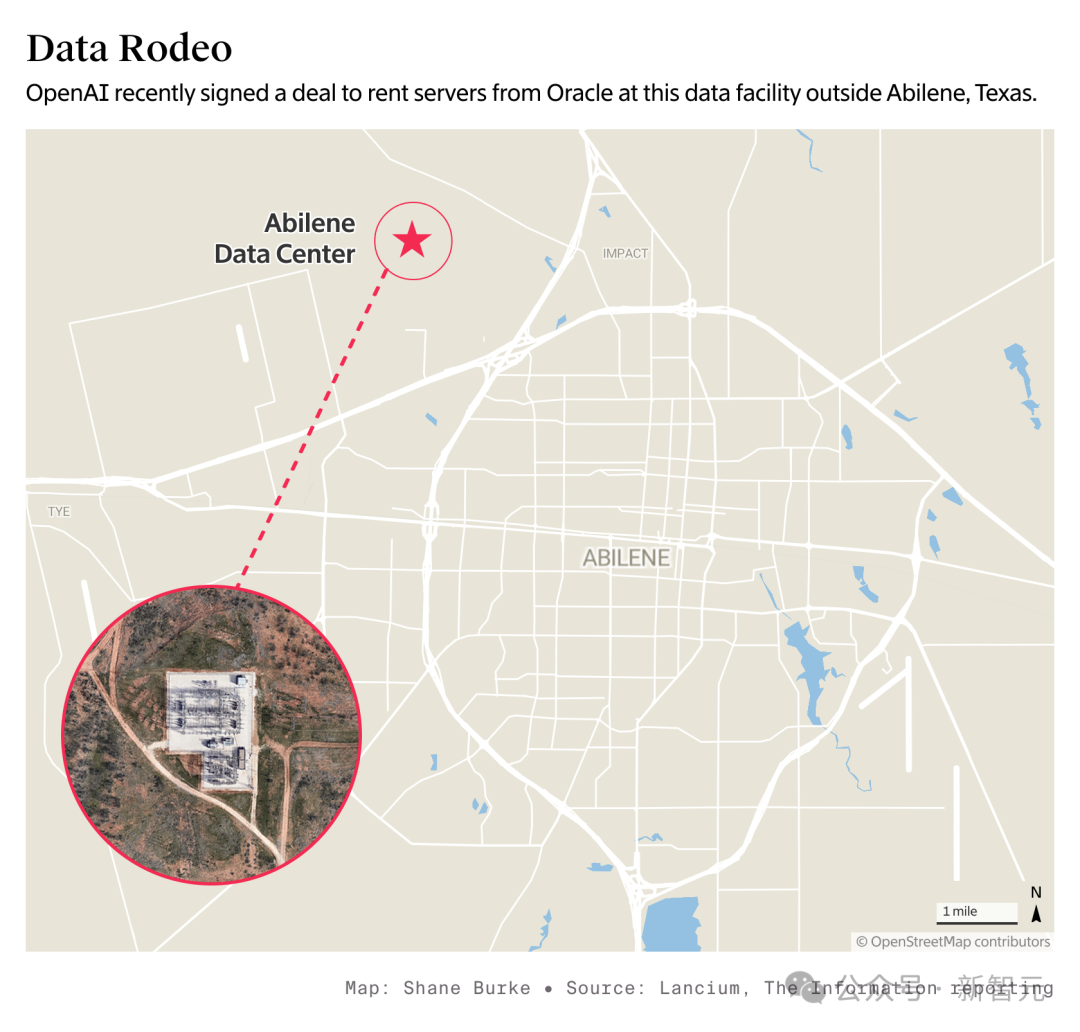

🏢 OpenAI 扩建数据中心,寻求更多算力:OpenAI 目前正在与 Oracle(甲骨文)洽谈租用整个 Abilene 数据中心,并与微软合作建设一个价值 1000 亿美元的超算服务器集群。OpenAI 正在寻求更多算力,以支持其不断增长的 AI 模型训练和推理需求。

💡 OpenAI 考虑自主开发 AI 芯片:OpenAI 首席执行官 Sam Altman 表示,自主开发 AI 芯片可能会降低大规模数据中心的运营成本。OpenAI 已与博通讨论过芯片开发的事项,并希望通过自主开发芯片来进一步降低 AI 模型训练和推理的成本。

🚀 英伟达算力推动 AI 发展:英伟达强大的算力不仅推动了 AI 模型的训练和推理,也为工业、科学和医疗保健等领域带来了变革。在医疗行业,英伟达加速了诊断、药物发现和医学影像方面的创新,帮助改变护理模式,释放医疗保健领域十万亿美元的巨大机遇。在探索太空方面,英伟达正在与 SETI(搜寻地外智能计划)合作,进行实时 AI 搜索,寻找来自遥远星系的快速射电暴。在推进气候研究方面,英伟达加速计算解决方案能够助力科学家应对环境挑战,包括监测全球温度和预测自然灾害。

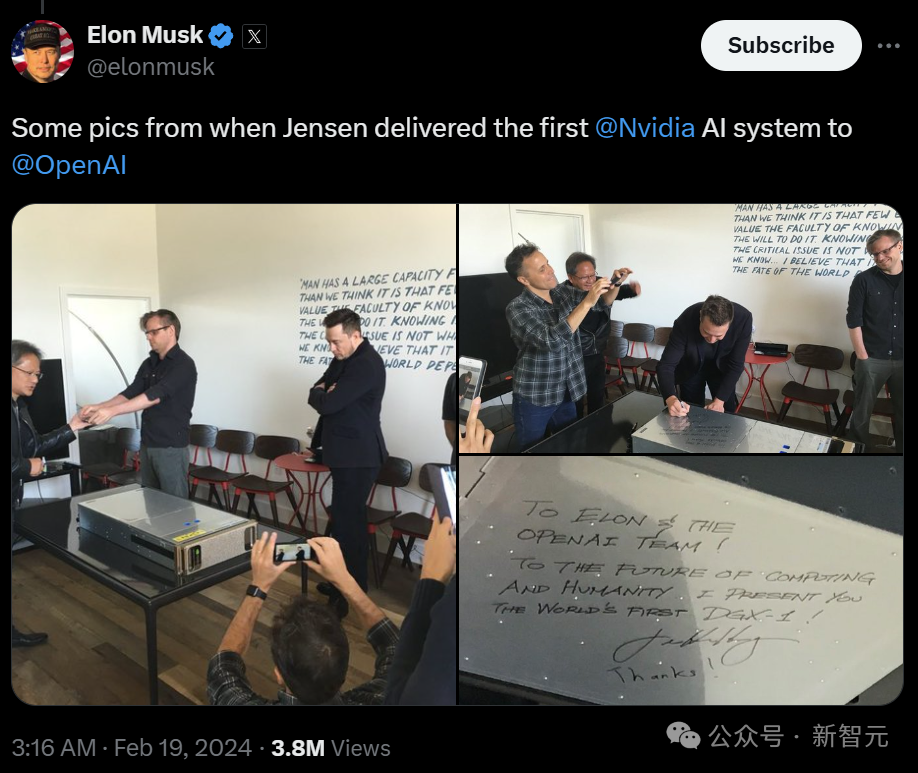

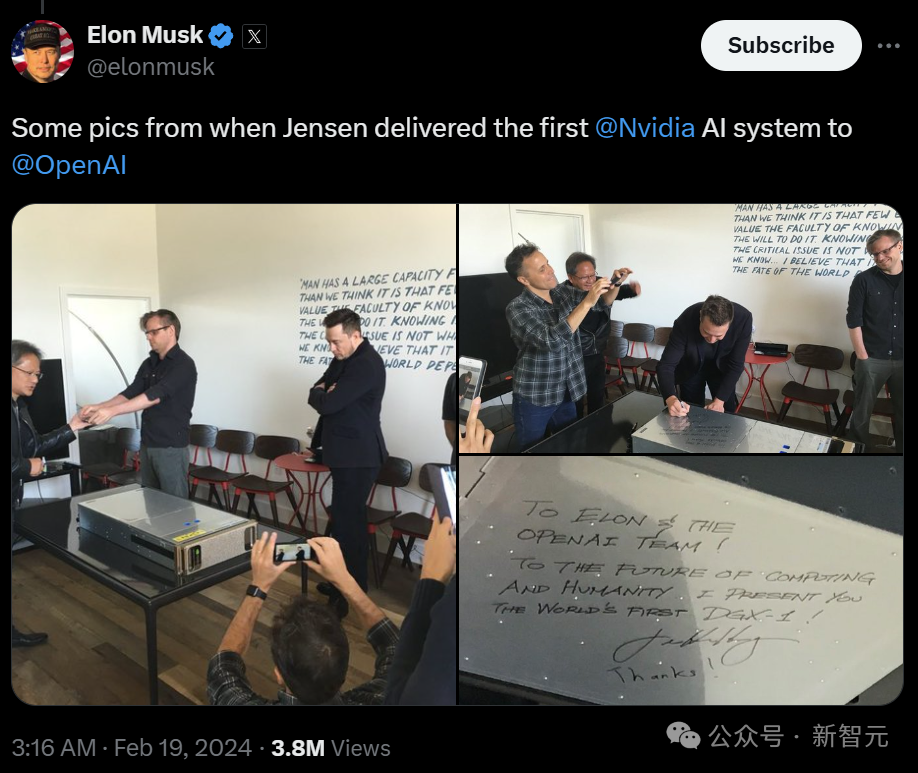

就在刚刚,OpenAI收到了来自英伟达的首批工程版DGX B200!此情此景,不得不让人联想到,刚刚成立的OpenAI在接收英伟达初代DGX时的画面。

依然在职的OpenAI员工兴奋地表示,圣诞节提前到了!而网友「Yuchen Jin」则调侃道:「3人已被GPU取代,剩下1个,AGI能即将到来!」有趣的是,在几个小时之前,微软也发推表示,Azure正式成为首个运行英伟达Blackwell系统的云服务。目前,OpenAI在凤凰城地区租用的大部分AI加速器都来自于微软。两家公司正在讨论数据中心扩张的下一阶段,即一个名为「Fairwater」的项目。微软计划到明年年底在威斯康星州和亚特兰大的两个数据中心站点为OpenAI提供约30万块英伟达最新的GPU GB200。OpenAI要求微软建立一个更先进的英伟达GPU服务器集群,调整设计,最大程度提高算力。OpenAI首席执行官Sam Altman还要求微软加快威斯康星州项目的进度。该项目原计划在明年下半年部分投入使用,届时将配备GB200芯片。

找甲骨文谈谈

据交易内部人士透露,OpenAI目前正与Oracle(甲骨文)洽谈租用整个Abilene数据中心场地。若谈判成功,Oracle能够获得的电力量估计可达2吉瓦(GW),而消耗略低于1吉瓦的,足以容纳数十万颗英伟达人工智能芯片。OpenAI和微软也一直在讨论合作建设一个价值1000亿美元的超算服务器集群。微软和OpenAI分别给它取名为「Mercury」(水星)和「Stargate」)(星际之门)。OpenAI首席财务官 Anna Friar最近表示,团队正在考虑使用债务融资的支付方式。由于「星际之门」项目成本高昂,两家是否能够合作成功尚未可知。首席执行官Sam Altman表示,自主开发AI芯片可能会降低大规模数据中心的运营成本。过去10年,生成token的能源成本已经下降了10万倍

凭借着Blackwell架构强大的FP4性能,搭载了8块英伟达B200 GPU的DGX B200可提供高达144petaflops的AI算力。同时,还有高达1.4TB的GPU显存容量和64TB/s的显存带宽。与前代产品相比,DGX B200不仅在训练性能上提升了3倍,而且在实时推理万亿参数模型时速度提升了15倍。

不难看出,英伟达强大的算力,对于亟需变革的工业、科学,以及医疗保健来说,至关重要。正如高级副总裁Dion Pette所说,新工业革命刚起步,而Blackwell平台的系统设计,便同时兼顾了性能与能源效率。相较十年之前,GPT-4等大模型的训练能耗降低了2,000倍,token生成能耗则减少了100,000倍。英伟达的CUDA库一直是各行业实现突破的基础,也是减少能源消耗最有效的方法之一,现在已经为超过4,000个加速应用程序提供支持。在医疗行业,英伟达加速了诊断、药物发现和医学影像方面的创新,帮助改变护理模式,释放医疗保健领域十万亿美元的巨大机遇。目前的进展包括NVIDIA Clara医学影像平台,Parabricks在基因组学研究方面的突破,以及MONAI AI框架在推进医学影像能力方面的努力。在探索太空方面,英伟达正在与SETI(搜寻地外智能计划)合作,进行实时AI搜索,寻找来自遥远星系的快速射电暴。PettePette还重点介绍了NVIDIA NIM Agent Blueprint,该工具通过实时威胁检测和分析,在几秒的响应时间里保护关键基础设施。在推进气候研究方面,英伟达加速计算解决方案能够助力科学家应对环境挑战,包括监测全球温度和预测自然灾害。其中,NVIDIA Earth 2平台使用使用Nvidia Omniverse融合多源数据,结合模拟、AI和可视化,赋能气候技术生态系统。https://x.com/OpenAI/status/1843704848753283356